本周发布的模型包括两个新的 NVIDIA AI 基础模型:Mistral Large 和 Mixtral 8x22B。这两个高级文本生成 AI 模型由 Mistral AI 开发,并通过 NVIDIA NIM 微服务提供预构建容器,以简化部署过程,将部署时间从数周缩短到几分钟。这两个模型可通过 NVIDIA API 目录 访问。

Mistral Large

Mistral Large 是大型语言模型 (LLM),它擅长处理复杂的多语种推理任务,包括文本理解、转换和代码生成。它因精通英语、法语、西班牙语、德语和意大利语以及对语法和文化语境的深入理解而脱颖而出。

该模型具有 32K 令牌上下文窗口,可从大量文档中调用精确信息。它在指令跟随和函数调用方面表现出色。Mistral Large 在各种基准测试中表现强劲,并展示了应对编码和数学挑战的强大推理能力。

Mixtral 8x22B

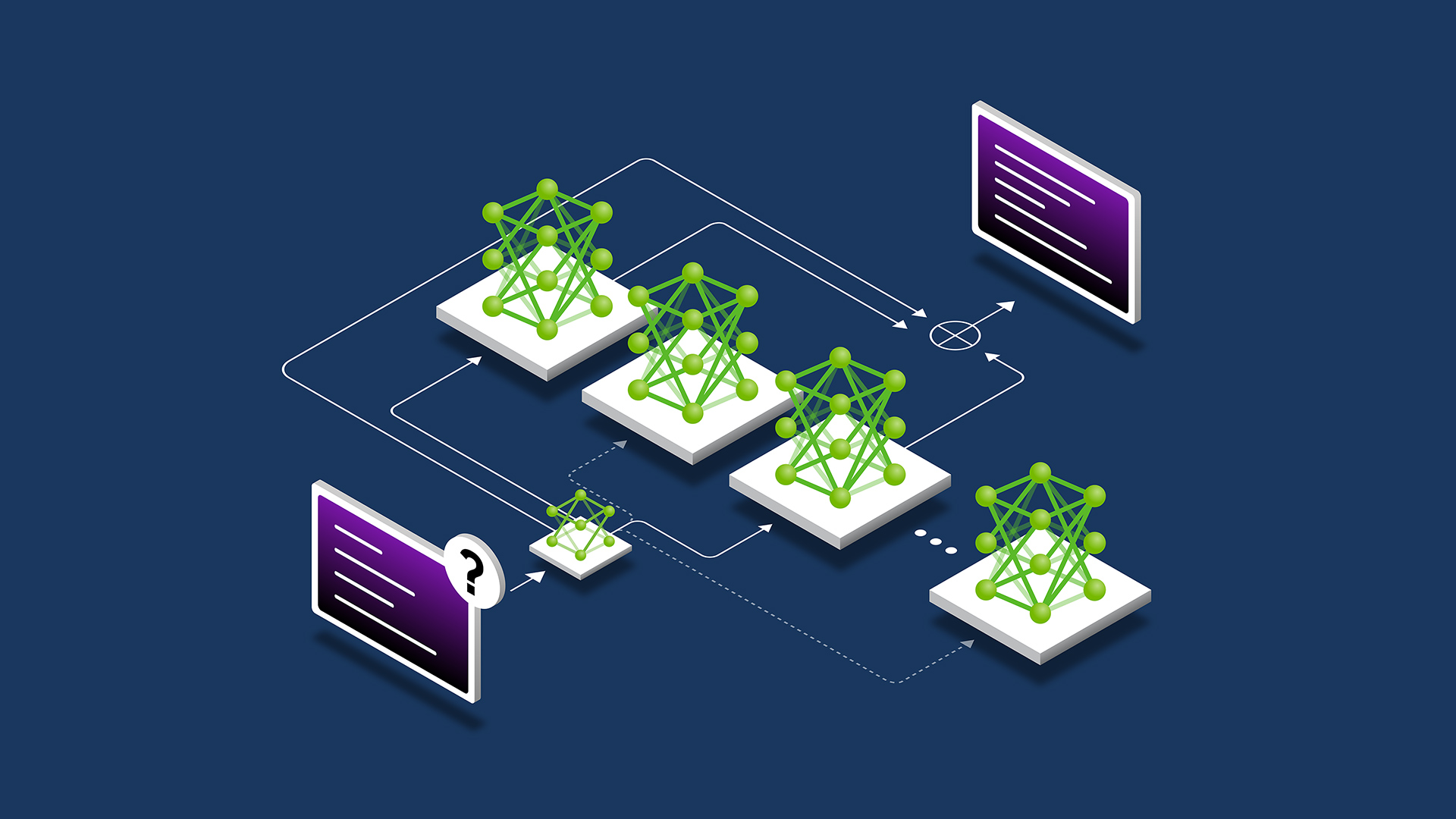

Mixtral 8x22B 是一种先进的语言模型 (LLM),其特点是使用 Sparse多专家模型 (MoE) 架构。该模型以其庞大的尺寸和先进的功能而闻名,有助于其理解和生成复杂文本的能力。这意味着它适用于各种自然语言处理任务,包括聊天机器人、内容生成以及需要更深入地理解语言的更复杂的任务。

据报道,该模型在各种基准测试中的表现优于其他模型,展示了其在文本生成和理解方面的有效性。其架构支持快速、低成本的推理,使其成为需要实时响应以用于研究和商业用途的应用程序的一个有吸引力的选择。

NVIDIA NIM 微服务

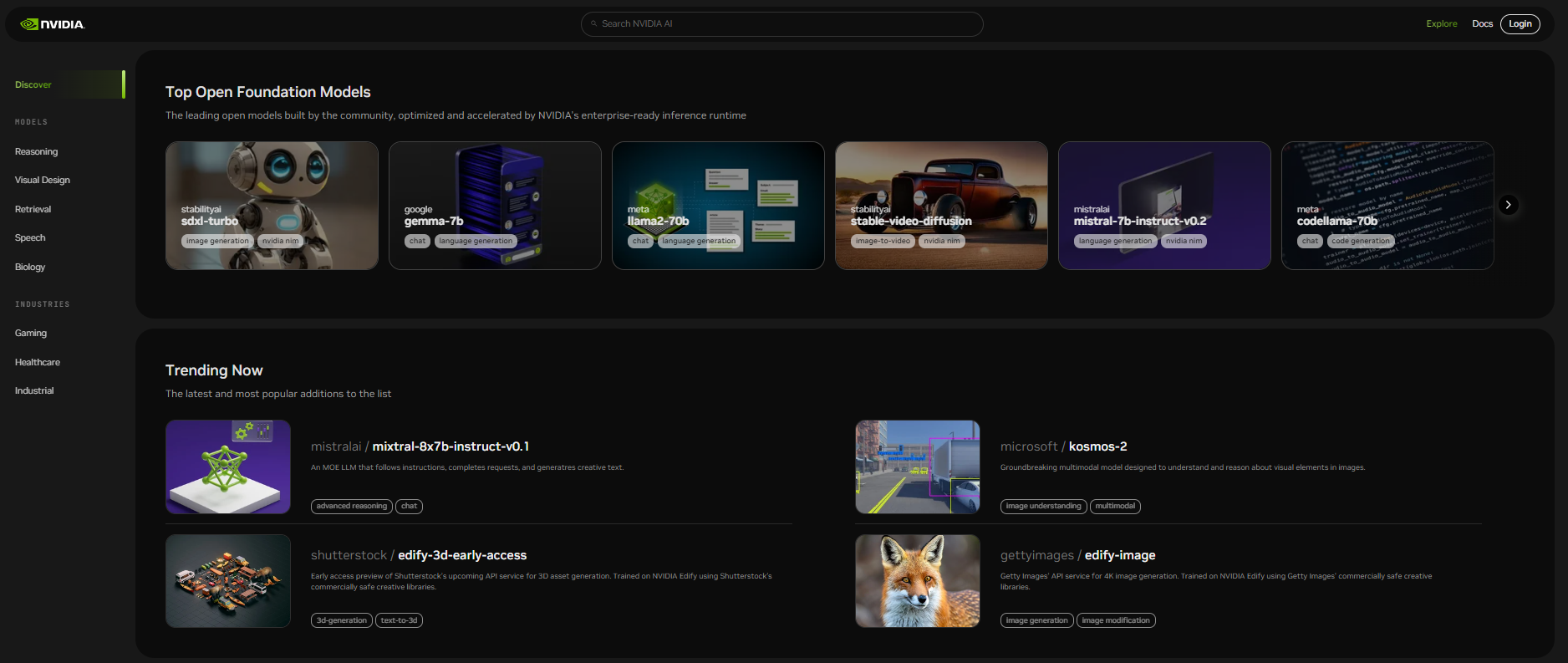

NVIDIA NIM 微服务现在支持二十多个流行的 AI 模型,包括 Mixtral 8x7B、Lama 70B、稳定视频扩散、Code Lama 70B 和 Kosmos-2。NIM 的目的是简化性能优化的部署,以使 10 倍到 100 倍的企业应用开发者能够为 AI 转型做出贡献。有关更多详细信息,请参阅 NVIDIA AI 基础模型。

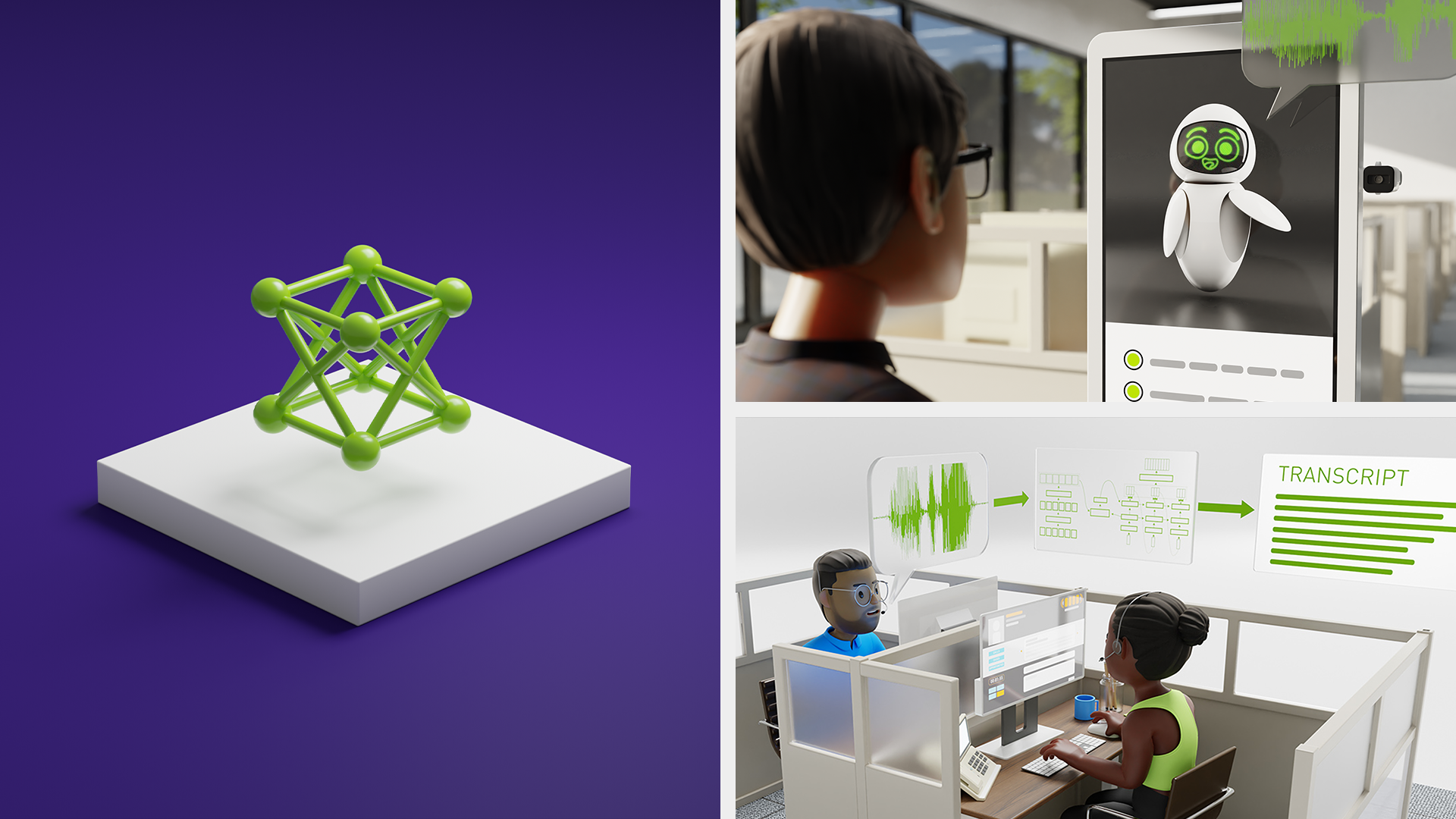

借助 NIM,开发者可以轻松地:

- 实现即时部署并保持对生成式 AI 应用和数据的控制。

- 简化 AI 应用程序开发,为企业环境量身打造的行业标准 API 和工具。

- 利用最新的生成式 AI 模型,以预构建容器形式提供各种选项和灵活性。

- 卓越性能,具有领先的延迟和吞吐量,可实现经济高效的扩展。

- 定制模型支持,开箱即用,可根据特定领域的数据训练模型。

- 自信部署具有专用的功能分支、严格的验证流程和强大的支持结构。

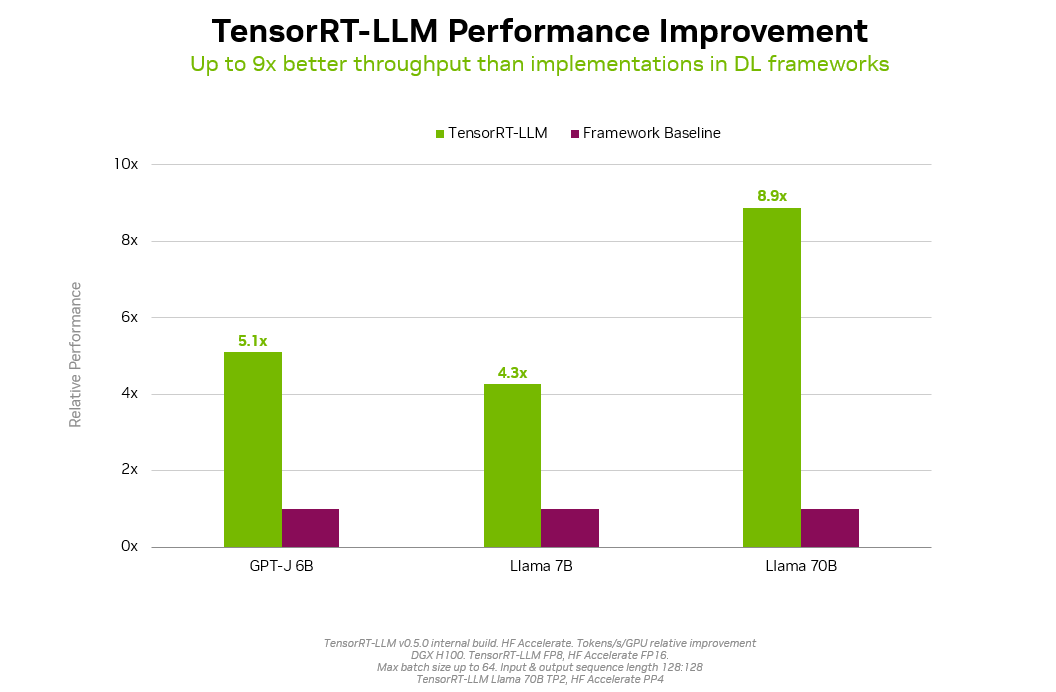

NVIDIA AI Foundation 模型旨在优化延迟和吞吐量。例如,Llama 2 利用 NVIDIA TensorRT-LLM 技术,将推理性能提高近 9 倍。

这些模型以 Nemo 格式提供,使开发者能够利用 NVIDIA NeMo 轻松利用各种定制技术,包括 SFT、LoRA、RLFH 和 SteerLM。

精心策划的基础模型集包括生成文本、代码和语言的 LLM、理解视觉效果并提供基础信息的视觉语言模型 (VLM),以及用于视觉内容生成、药物研发、基因组学、气候模拟等的模型。

NVIDIA 继续与基础模型开发者合作,优化其模型的性能,并将其与 NIM 微服务打包。

NVIDIA API 目录

NVIDIA API 目录 包含性能优化的 API 端点,以企业级运行时形式提供。您可以从浏览器中体验这些端点。

借助免费的 NVIDIA Cloud Credits,您可以开始大规模测试模型。您还可以通过将应用程序连接到运行在完全加速堆栈上的 NVIDIA 托管 API 端点来构建概念验证 (POC).这些 API 与 Langchain 和 LamaIndex 等框架集成,简化了企业应用程序开发。

在本地、云端或工作站上使用 NIM 微服务,只需几分钟即可部署模型。随时随地运行的灵活性可保持数据的安全性和隐私性,避免平台锁定,并使您能够利用现有的基础设施投资和云承诺。

请访问 ai.nvidia.com 以开始使用。