LLM

2024年 4月 23日

借助 Union.ai 和 NVIDIA DGX 云实现 AI 工作流程的大众化

GPU 最初专用于在电子游戏中渲染 3D 图形,主要用于加速线性代数计算。如今,GPU 已成为 AI 革命的关键组成部分之一。 现在,

2 MIN READ

2024年 4月 22日

借助 NVIDIA TensorRT-LLM 和 NVIDIA Triton 推理服务器提升 Meta Llama 3 性能

我们很高兴地宣布支持 Meta Llama 3 系列模型,通过 NVIDIA TensorRT LLM 加速和优化 LLM 推理性能。

2 MIN READ

2024年 4月 22日

Mistral Large 和 Mixtral 8x22B LLM 现已由 NVIDIA NIM 和 NVIDIA API 提供支持

本周发布的模型包括两个新的 NVIDIA AI 基础模型:Mistral Large 和 Mixtral 8x22B。

1 MIN READ

2024年 4月 22日

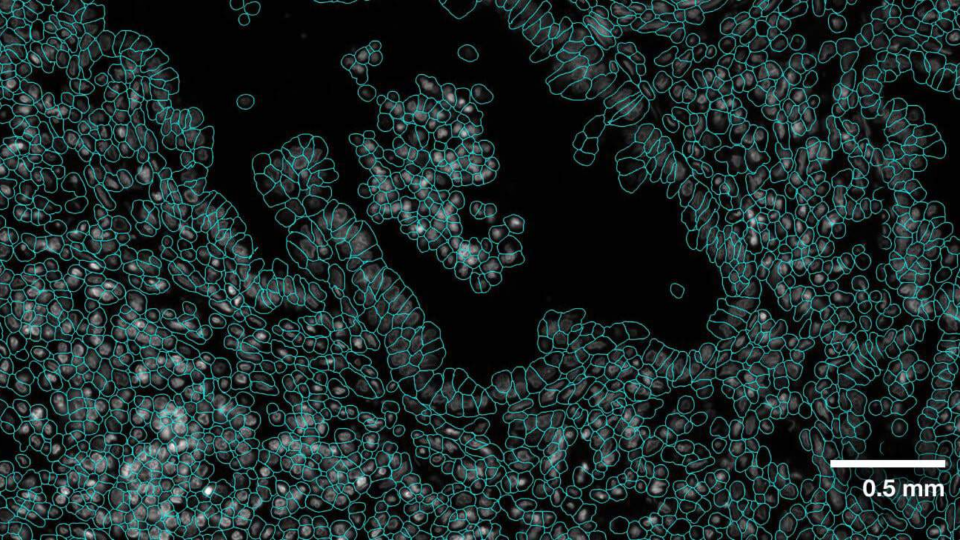

借助 NVIDIA AI 基础模型 VISTA-2D 推进细胞分割和形态分析

基因组学研究人员使用不同的测序技术来更好地理解生物系统,包括单细胞和空间组学。与从细胞层面查看数据的单细胞不同,空间组学考虑了数据的位置,

2 MIN READ

2024年 4月 2日

使用 NVIDIA TensorRT-LLM 调整和部署 LoRA LLM

大型语言模型 (LLM) 可以从大量文本中学习,并为各种任务和领域生成流畅、一致的文本,从而彻底改变自然语言处理 (NLP)。然而,

7 MIN READ

2024年 3月 27日

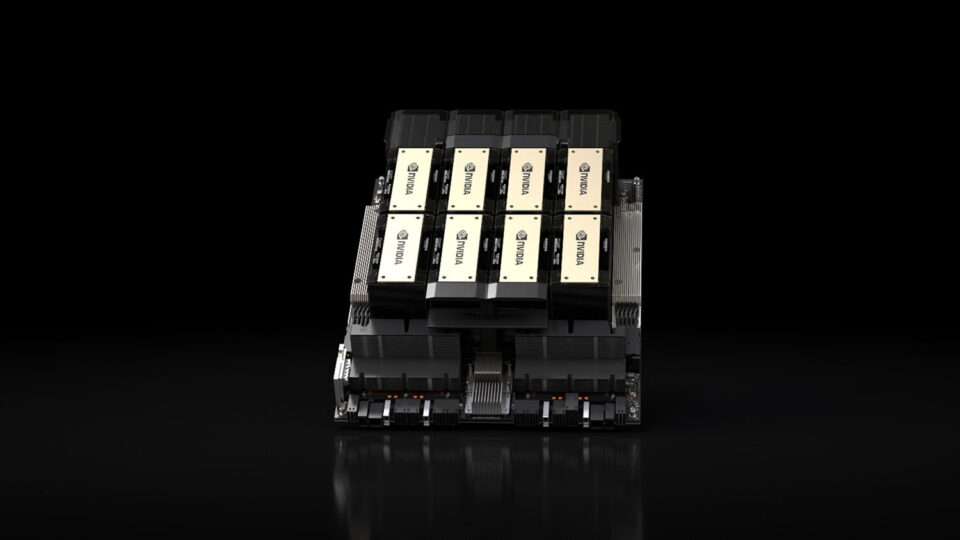

NVIDIA H200 Tensor Core GPU 和 NVIDIA TensorRT-LLM 集 MLPerf LLM 推理记录

随着生成式 AI 模型的持续创新,生成式 AI 在计算应用方面取得了巨大进步,从而大幅增强人类能力。这些模型包括 生成式 AI 模型,

3 MIN READ

2024年 3月 27日

借助 NVIDIA NeMo 开发自定义企业生成式 AI

生成式 AI 在计算领域发生了翻身,为人类以自然、直观的方式与计算机交互打开了新方式。对于企业来说,生成式 AI 的潜力巨大。

3 MIN READ

2024年 3月 20日

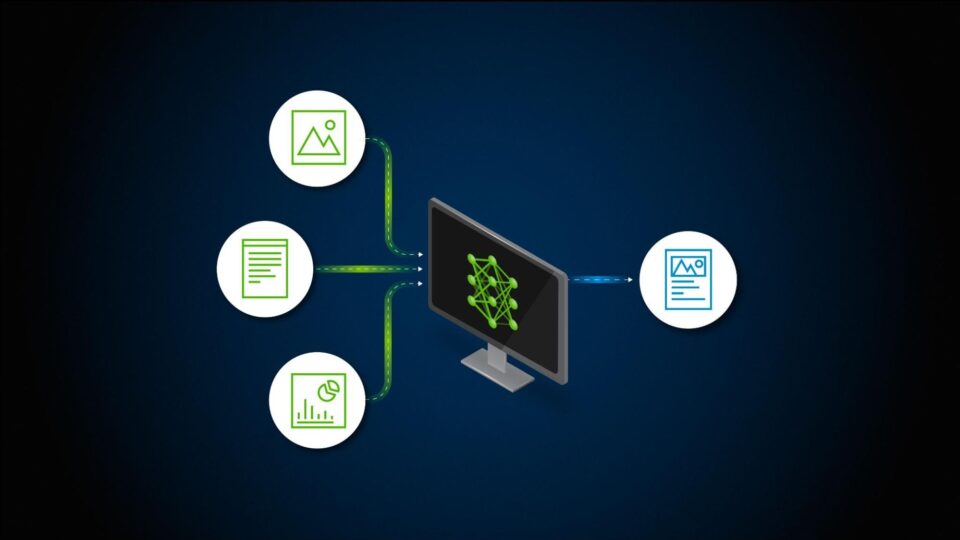

多模态检索增强生成的简单介绍

检索增强生成 (RAG) 应用程序如果能够处理各种数据类型,包括表格、图形和图表,而不仅仅是文本,其效用将会呈指数级增长。

2 MIN READ

2024年 3月 19日

FP8:前沿精度与性能的新篇章

在深度学习和人工智能的快速发展背景下,尤其是大语言模型(Large Language Model, LLM)的蓬勃发展,

3 MIN READ

2024年 3月 18日

如何通过四个步骤将 RAG 应用程序从试点阶段转变为生产阶段

生成式 AI 具有改变各个行业的巨大潜力。人类工作者已经开始使用 大型语言模型(LLM) 来解释、推理和解决复杂的认知任务。

2 MIN READ

2024年 3月 18日

借助加速以太网网络和网络存储扩展企业 RAG

在生成式人工智能中,机器不仅可以从数据中学习,还可以生成类似人类的文本、图像、视频等。检索增强生成 (RAG) 是一种突破性的方法。

2 MIN READ

2024年 3月 14日

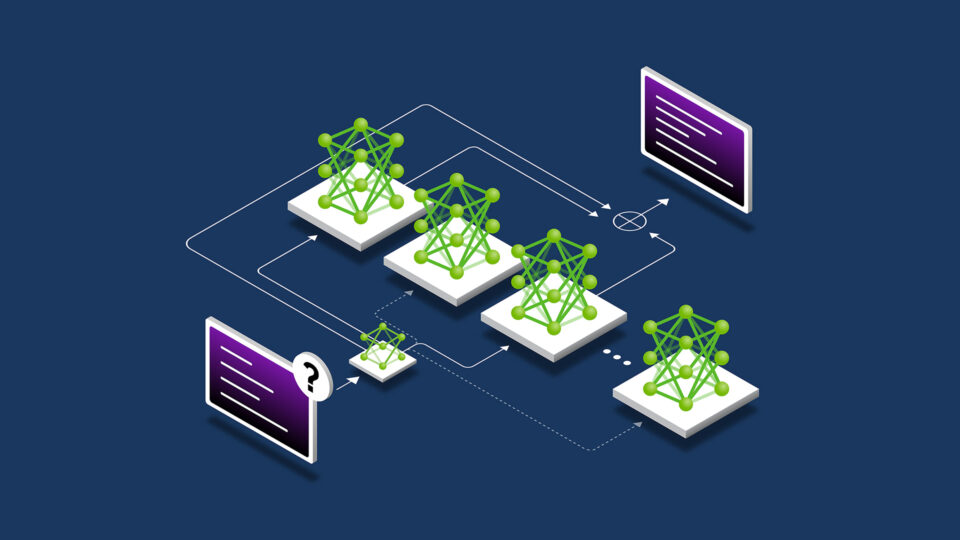

在 LLM 架构中应用多专家模型

多专家模型 (MoE) 大型语言模型 (LLM) 架构最近出现了,无论是在 GPT-4 等专有 LLM 中,还是在开源版本的社区模型中,

3 MIN READ

2024年 3月 6日

借助 NVIDIA FLARE 2.4,在几分钟内将机器学习转变为联邦学习

协同学习 (FL) 受到加速采用的原因在于其分布式、保护隐私的特性。在医疗健康和金融服务等领域,协同学习 (FL) 作为一种隐私增强技术,

4 MIN READ

2024年 2月 29日

借助 NVIDIA FLARE 实现可扩展联邦学习,提升 LLM 性能

随着人工智能技术的不断发展,大型语言模型(LLM) 的有效数据管理成为一个重要挑战。数据是模型性能的核心。

3 MIN READ

2024年 2月 27日

视频:五分钟内构建 RAG 驱动的聊天机器人

检索增强生成(RAG)作为一种提升性能的技术,其受欢迎程度呈爆炸式增长。从高度准确的问答 AI 聊天机器人到代码生成副驾驶,

1 MIN READ

2024年 2月 23日

评估适用于企业级 RAG 的 Retriever

关于设计和评估的对话 检索增强生成(RAG) 系统是一个漫长而多方面的讨论。即使我们单独研究检索,开发者也会有选择地使用许多技术,

3 MIN READ