生成式 AI 在计算领域发生了翻身,为人类以自然、直观的方式与计算机交互打开了新方式。对于企业来说,生成式 AI 的潜力巨大。他们可以利用其丰富的数据集简化耗时的任务,从文本摘要和翻译到见解预测和内容生成。然而,他们也面临着采用挑战。

例如,云服务通过使用通用型 大型语言模型 简化了探索。然而,这些功能可能并不总是与企业需求保持一致,因为模型基于广泛的数据集而不是特定领域的数据进行训练,这可能会导致安全漏洞。

因此,组织正在使用大量开源工具构建定制解决方案。从验证兼容性到提供自己的技术支持,这可以延长在企业中成功采用生成式 AI 的时间。

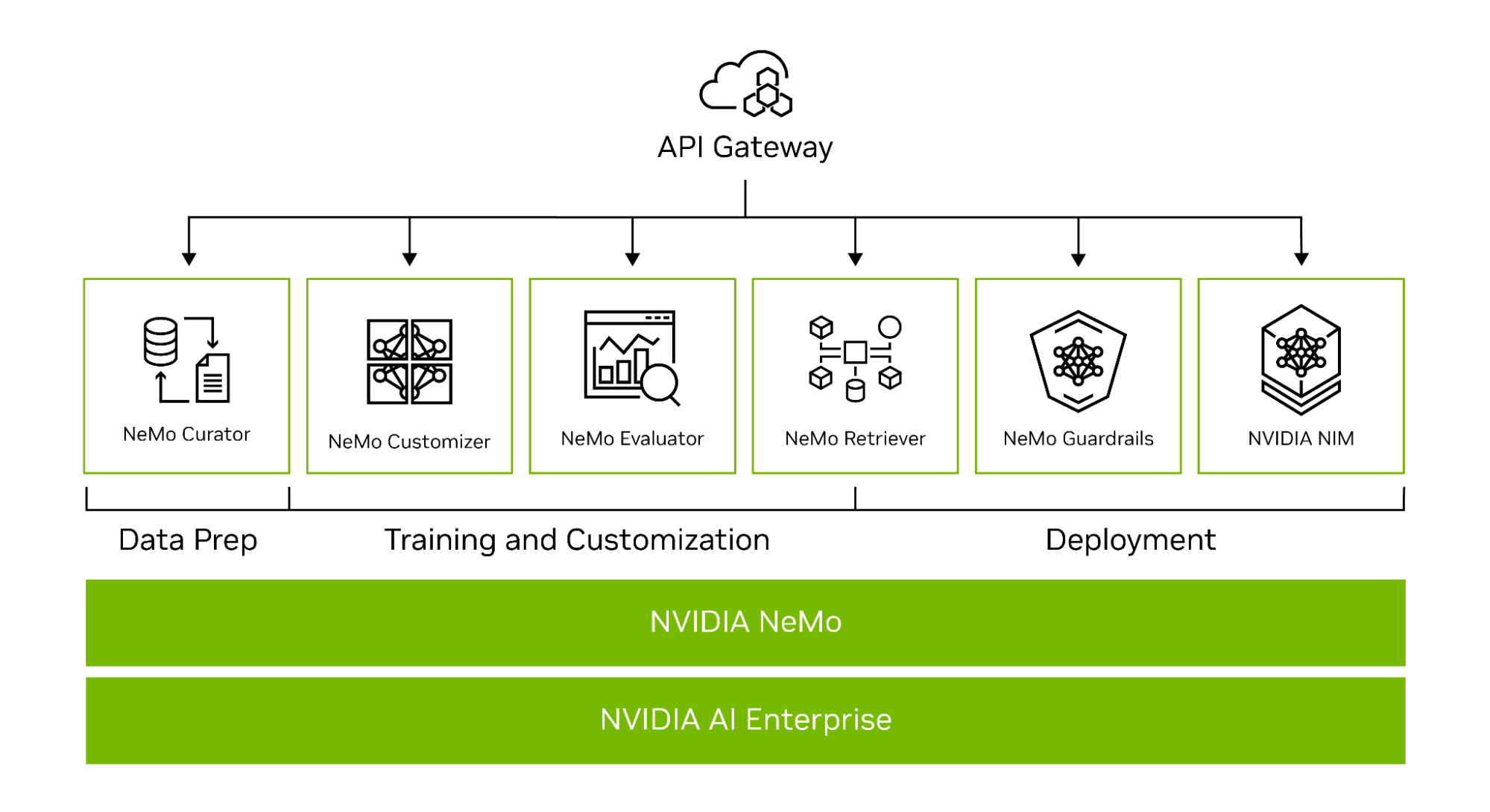

专为企业开发,NVIDIA NeMo 是一个端到端平台,可随时随地构建自定义生成式 AI 应用。它提供了一套先进的微服务,可实现完整的工作流程,从自动化分布式数据处理,到使用复杂的 3D 并行技术训练大规模定制模型,再到使用 检索增强生成(RAG) 技术。

使用 NeMo 创建的自定义生成式 AI 模型可以部署在 NVIDIA NIM 上,它是一套易于使用的微服务,旨在随时随地 (本地或云端) 加速生成式 AI 部署。NVIDIA NIM 提供优化的推理,以在微服务中部署 AI 模型。

对于在 AI 上运营业务的企业来说,NVIDIA AI Enterprise 是一款端到端软件平台,可为生成式 AI 基础模型提供更快速、更高效的运行时。它包含 NeMo 和 NIM,可简化采用流程,并提供安全性、稳定性、可管理性和企业级支持。

现在,组织可以将 AI 集成到其运营中,简化流程,增强决策能力,并推动实现更高的价值。

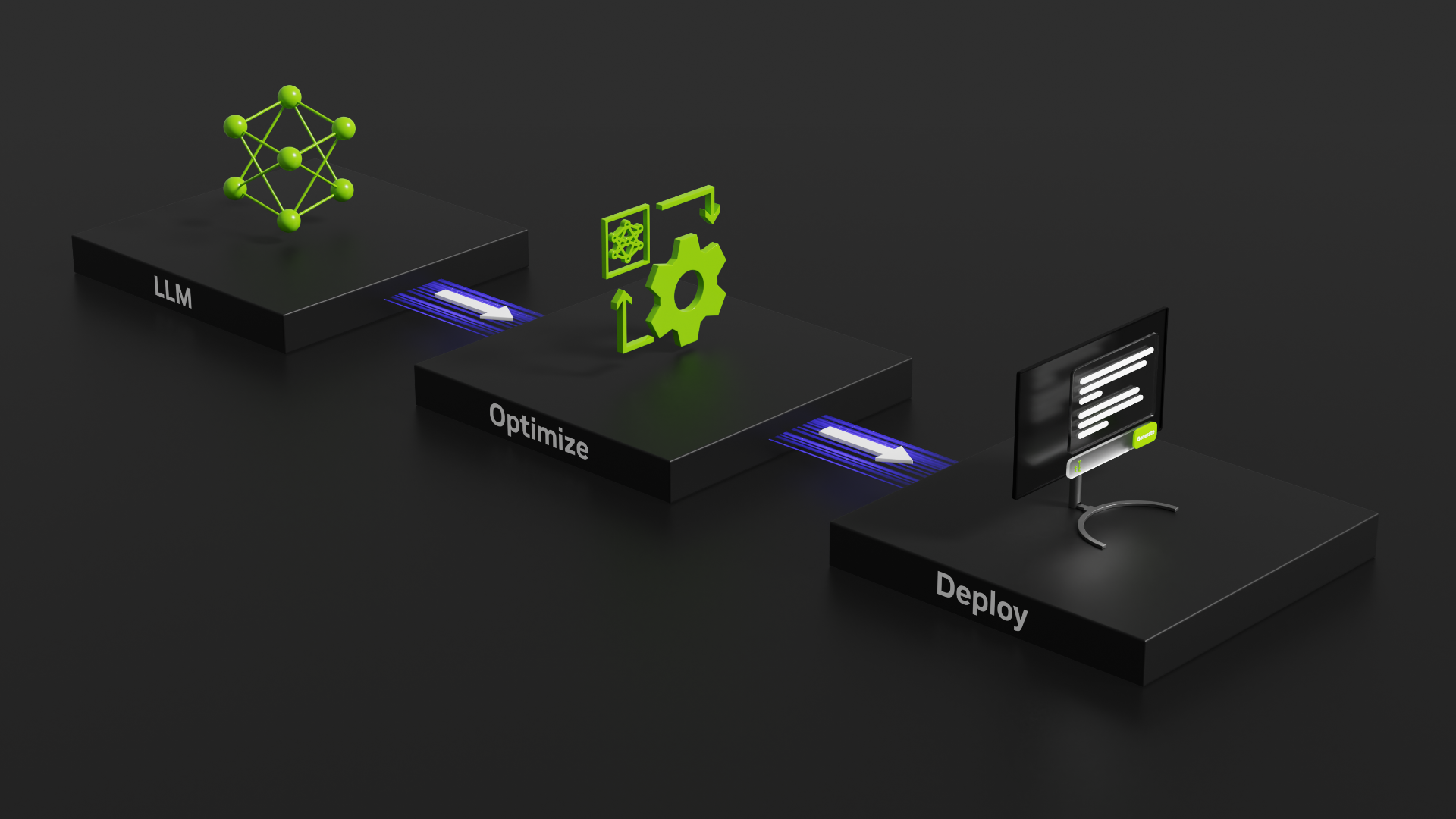

借助 NVIDIA NeMo 实现生产就绪型生成式 AI

NeMo 通过提供端到端功能 (微服务) 以及适用于各种模型架构的方法,简化了构建自定义企业级生成式 AI 模型的路径 (图 1)。

为帮助您创建自定义 LLM,NeMo 框架提供了功能强大的工具:

- NeMo Curator 提供 GPU 加速的高质量训练数据集数据管护功能。

- NVIDIA NeMo 定制器 简化了 LLM 的微调和对齐过程。

- NVIDIA NeMo Evaluator 提供了自动评估 LLM 准确性的功能。

- NeMo Retriever 利用 RAG 将自定义模型与专有业务数据联系起来。

- NeMo 护栏 可保护组织的生成式 AI 应用。

NeMo 策展人

对高质量数据集的需求已成为构建功能性 LLM 的关键因素。

NeMo 利用 NVIDIA NeMo Curator 简化了通常复杂的 datasets 管护流程。此工具可解决多语种数据集中管护数万亿令牌的挑战。它提供了可扩展性,使您能够轻松处理数据下载、文本提取、清理、过滤、精确或模糊重复数据消除以及多语种下游任务消除污染等任务。有关详细信息,请参阅 使用 NeMo Curator 扩展和整理用于 LLM 训练的高质量数据集。

利用 Dask、RAPIDS cuDF、RAPIDS cuGraph 和 PyTorch 等尖端技术的强大功能,NeMo Curator 可以跨数千个网络 GPU 扩展数据管护流程,从而显著减少手动工作并加速开发工作流程。

其中一个最显著的进步是在数据删除重复数据的过程中,事实证明 GPU 加速的性能明显优于传统的 CPU 方法。与依赖基于 CPU 的方法相比,使用 GPU 进行重复数据删除的速度提高了 26 倍,成本降低了 6.5 倍。这种显著的改进不仅降低成本,而且还提高了效率,使开发者能够以前所未有的速度处理数据。

NVIDIA 技术具有无与伦比的可扩展性,能够利用数千个 GPU.这种可扩展性对于在真实的时间框架内准备大型预训练数据集至关重要,随着 AI 模型的复杂性和规模的增长,这项任务变得越来越重要。

在性能方面,使用 NeMo Curator 准备的令牌进行训练时,LLM 受益匪浅。此工具可确保输入 LLM 的数据具有最高质量,从而生成性能更好的模型。

在不久的将来,NeMo Curator 还将支持模型自定义的数据管护,例如监督式微调 (SFT),以及包括 LoRA 和 P-tuning 在内的参数高效微调 (PEFT) 方法。

申请抢先体验 NVIDIA NeMo 微服务 获取最新的 NeMo Curator 微服务。它还包含在 NeMo 框架容器 可通过 NVIDIA NGC 目录获取。

大规模分布式训练

训练具有十亿参数的 LLM 时,存在加速和扩展的独特挑战。这项任务需要广泛的分布式计算能力、基于加速的硬件和内存集群、可靠且可扩展的机器学习 (ML) 框架和容错系统。

NeMo 框架的核心是统一分布式训练和高级并行。NeMo 熟练地跨节点使用 GPU 资源和内存,从而实现突破性的效率提升。通过除以模型和训练数据,NeMo 实现了无缝的多节点和多 GPU 训练,显著减少训练时间并提高整体生产力。

并行技术

NeMo 的一个显著特点是整合了各种并行技术:

- 数据并行

- 完全分片数据并行 (FSDP)

- 张量并行度

- 管道并行

- 序列并行

- 专家并行

- 上下文并行

节省内存技术

此外,NeMo 还支持多种节省内存的方法:

- 选择性激活重计算 (SAR)

- CPU 卸载 (激活、权重)

- Flash Attention (FA)、Grouped Query Attention (GQA)、Multi-Query Attention (MQA)、Sliding Window Attention (SWA)

NeMo 支持大规模多模态训练,包括语言和多模态模型。支持的模型包括 Lama 2、Falcon、CLIP、Stable Diffusion、LLAVA,以及各种基于文本的生成式 AI 架构,例如 GPT、T5、BERT、多专家模型 (MoE) 和复古 (RETRO)。除了 LLM 之外,NeMo 还支持多个预训练模型,包括计算机视觉、自动语音识别和自然语言处理。例如,text-to-speech 等。

NVIDIA NGC 目录中的 NeMo 框架容器 提供所有工具,供组织自行训练模型。

NVIDIA AI 基础模型

尽管一些生成式 AI 应用需要从头开始训练 LLM,但大多数组织都使用 预训练模型 来构建自定义 LLM。这种方法可以快速启动该过程,从而节省时间和资源。

跳过用于从头开始训练 LLM 的庞大数据集所需的数据收集和清理阶段,您可以专注于使用更小的数据集来根据自己的需求微调模型。这缩短了找到最终解决方案的时间。此外,预训练模型带有预先存在的知识,可随时进行定制,从而大大降低基础设施设置和模型训练的负担。

准确性是用于评估预训练模型的常见测量方法之一,但还有其他考虑因素,包括模型大小、微调成本、延迟、吞吐量和商业许可选项。

NVIDIA 帮助开发者更轻松地实现出色性能,并简化向生产级 AI 的过渡。NVIDIA AI 基础模型 提供了加速基础架构的必要工具。

NVIDIA AI Foundation 模型包括针对性能优化的领先社区模型和基于责任来源数据构建的企业级 NVIDIA 模型。

NVIDIA TensorRT-LLM 可以优化 NVIDIA AI Foundation 模型的延迟和吞吐量,以提供更高的性能。它使用负责任的来源数据进行训练,以确保模型提供与大型模型相媲美的结果。这意味着它成为企业应用的理想选择。

这些模型经过格式化,可利用 NeMo 自定义和并行技术,并利用专有数据加快调整速度。

新推出的 NVIDIA API 目录 开发者可以使用 NVIDIA 托管的 API 端点,在浏览器或原型中直接体验这些模型。准备好自我部署后,可以下载基础模型,并在任何 GPU 加速的数据中心、云或工作站上运行。

NeMo 定制器

各行各业的企业都需要独特的功能,而生成式 AI 模型定制也在不断发展,以满足其需求。NeMo 提供各种 大语言模型定制技术,以专业用例优化通用的预训练 LLM。NVIDAI NeMo Customizer 是一种新的高性能、可扩展的微服务,可帮助开发者简化 LLM 的微调和比对。

NeMo Customizer 将一系列先进功能引入机器学习模型开发的前沿。其突出的功能之一是支持先进的微调和比对技术,使用户能够根据特定需求精确调整模型,从而实现出色的模型性能。

NeMo Customizer 利用先进的并行技术,不仅提高了训练性能,而且大大缩短了训练复杂模型所需的时间。在当今速度和效率至关重要的快节奏开发环境中,这一点尤其有益。

NeMo Customizer 旨在通过跨多个 GPU 和多个节点进行扩展来支持大型模型的微调,从而解决深度学习领域的一项重大挑战。

这种可扩展性确保即使是要求非常严格的模型也能得到有效训练,从而使 NeMo Customizer 成为研究人员和从业者的宝贵工具。更多信息请参阅 NVIDIA NeMo Customizer:轻松微调和对齐 LLM。

组织可以申请抢先体验 NVIDIA NeMo 微服务,并开始使用 NeMo Customizer 微服务。开发者可以使用 NGC 目录中的 NeMo 框架容器 进行获取。

NeMo 评估器

随着组织越来越多地定制 LLM 以满足其独特的运营需求,因此出现了持续评估和优化这些模型的关键需求,以确保这些模型提供更高水平的准确性和响应速度。

这种持续的评估过程至关重要,不仅可以在最初训练的任务中保持模型的性能,而且可以确保模型有效适应新的应用程序特定要求。

NeMo Evaluator 通过自动基准测试功能简化了这项复杂任务,从而能够全面评估预训练和微调的 LLM.此工具支持各种模型,包括基础模型、对齐模型和任务特定的 LLM 等,可为各种应用提供通用的评估功能。

该微服务提供开放式可扩展的设计,并支持根据流行的学术基准测试和自定义数据集评估模型。NeMo Evaluator 的目的是确保在云或数据中心本地运行的 LLM 的效率和灵活性。有关更多详细信息,请参阅 NVIDIA NeMo Evaluator:简化 LLM 的准确性评估。

NeMo Evaluator 扩展了 NeMo Curator 和 NeMo Customizer 的功能,为组织构建自定义生成式 AI 模型提供一整套工具。申请抢先体验 NVIDIA NeMo 微服务。

NeMo Retriever

NeMo Retriever 是一个微服务集合,可加速企业数据的语义搜索。它通过检索增强提供高度准确的响应。有关更多详细信息,请参阅 使用 NVIDIA NeMo Retriever 将企业数据转换为可行见解。

这些微服务专为处理特定任务而定制,包括:

- 以 PDF 文件、Office 文档和其他富文本文件的形式提取大量文档。

- 对这些文档进行编码和存储,以进行语义搜索。

- 与现有关系数据库交互。

- 搜索相关信息以回答问题。

借助 NeMo Retriever,组织可以以更低的延迟、更高的吞吐量和更大的数据隐私来访问出色的信息检索功能,从而更好地利用专有数据实时生成业务见解。

立即开始在 NVIDIA Omniverse 中使用 NeMo Retriever 微服务,以从 NVIDIA API 目录 探索更多示例。有关更多信息,请查看 NVIDIA 生成式 AI 示例 和代码示例。

NeMo 护栏

在生成式 AI 迅速发展的格局中,实施稳健的安全措施的重要性无论怎么强调都不过分。随着这些 AI 应用程序越来越多地集成到各行各业中,确保其安全可靠的运行至关重要。

在这方面,护栏是一种重要机制,可作为调节用户与 LLM 之间交互的可编程约束或规则。与高速公路上的物理护栏防止车辆偏离轨道的方式类似,这些数字护栏旨在监控、影响和控制用户与 AI 系统的交互。

它们有助于将 AI 交互的焦点保持在预定边界内,防止产生幻觉、剧毒或误导性内容,并阻止恶意命令或未经授权访问第三方应用程序。这种制胜系统对于在各个领域维护生成式 AI 应用程序的完整性和安全性至关重要。

NeMo Guardrails 通过提供复杂的对话管理系统来应对这些挑战,该系统优先考虑由 LLM 提供支持的应用程序的准确性、适当性和安全性。它为组织提供有效执行安全和安保协议所需的工具,以确保其 AI 系统在所需参数内运行。

NeMo Guardrails 有助于轻松编程和实施这些安全措施,提供模糊可编程的护栏,从而实现灵活且可控的用户交互。其与企业就绪型解决方案 (包括 Langchain 和其他第三方应用程序) 的集成功能增强了 LLM 系统的安全性,以抵御潜在威胁。

通过与更广泛的 LLM 生态系统深度集成并支持流行框架,NeMo Guardrails 可确保生成式 AI 应用始终安全可靠,并与组织的价值观、策略和目标保持一致。有关更多详细信息,请参阅 NVIDIA 实现值得信赖、安全可靠的大型语言模型对话系统。

NeMo Guardrails 是一个开源工具包,可轻松开发与所有 LLM(包括 OpenAI 的聊天 GPT 和 NVIDIA NeMo)兼容的安全可靠的 LLM 对话系统。要开始使用,请访问 NVIDIA/NeMo-Guardrails 在 GitHub 上的发布页面。

NVIDIA NIM

为支持生产环境中的 AI 推理,基础设施和支持系统必须稳健、可扩展且高效,以促进过渡。各组织现已认识到需要投资和开发此类基础设施,以保持竞争力并充分利用生成式 AI 的全部潜力。

NVIDIA NIM 推理微服务简化了在企业环境中部署优化的生成式 AI 模型的流程。NIM 支持广泛的 AI 模型,包括开源社区模型、NVIDIA AI 基础模型和自定义 AI 模型。有关更多详细信息,请参阅 NVIDIA NIM 提供经过优化的推理微服务,以大规模部署 AI 模型。

利用行业标准 API,开发者只需几行代码即可快速构建企业级 AI 应用。基于可靠的基础构建,包括开源推理引擎,例如 NVIDIA Triton Inference Server 和 NVIDIA TensorRT-LLM,以及 PyTorch、NIM 可促进大规模 AI 推理,确保可以大规模部署 AI 应用程序,并满怀信心地投入生产。

要开始使用 NIM,请探索 NVIDIA API 目录。

实现无缝的企业级生成式 AI

作为 NVIDIA AI Enterprise 的 NeMo 提供跨多个平台的兼容性,包括云、数据中心,以及现在由 NVIDIA RTX 提供支持的工作站和 PC。这实现了真正的“一次开发”和“随处部署”体验,消除了集成的复杂性,并更大限度地提高了运营效率。

行业 AI 采用者

NeMo 在寻求构建自定义 LLM 的前瞻性组织中获得了巨大的吸引力。ServiceNow、Amdocs、Dropbox、Writer 和韩国电信等组织已采用 NeMo,以利用其功能推动其 AI 驱动的计划。

凭借出色的灵活性和支持,NeMo 开启了一个充满可能性的世界。企业可以设计、训练和部署针对特定需求和行业垂直领域定制的复杂 LLM 解决方案。通过利用 NVIDIA AI Enterprise 并将 NeMo 集成到您的工作流程中,您的组织可以开辟新的发展道路,获得宝贵的见解,并为客户、客户和员工等提供先进的 AI 应用程序。

开始使用 NVIDIA NeMo

作为一款颠覆性解决方案, NVIDIA NeMo 正在弥合生成式 AI 的巨大潜力与企业面临的实际现实之间的差距。作为用于 LLM 开发和部署的综合平台,NeMo 帮助企业以经济高效的方式采用 AI 技术。

借助 NVIDIA NeMo 的强大功能,企业可以将 AI 集成到运营中,简化流程,增强决策能力,并开辟发展和成功的新途径。

要开始使用 NVIDIA NeMo,请访问 NVIDIA NeMo 页面。要使用 NVIDIA NeMo 微服务,请 申请抢先体验。您也可以在 NVIDIA NGC 目录中获取 NeMo 框架容器。