市場への普及に立ちはだかるキャズムを越え、iPhone モーメントを迎えつつある生成 AI は、飛躍的に増大する需要を満たすために拡張する必要があります。AI をビジネスの中核に据えた企業が生成 AI を構築するには、信頼性と連続稼働時間が非常に重要となります。NVIDIA は専門知識を投入して、AI でビジネスの飛躍を目指す企業向けのソリューションを開発しています。

NVIDIA AI Enterprise 4.0 発表

NVIDIA AI Enterprise の最新バージョンは、生成 AI でイノベーションを起こそうとしている企業向けに、本番環境に対応したサポート、管理性、セキュリティ、信頼性を提供し、さまざまな側面から開発を加速します。

NVIDIA NeMo による LLM の迅速なトレーニング、カスタマイズ、大規模展開

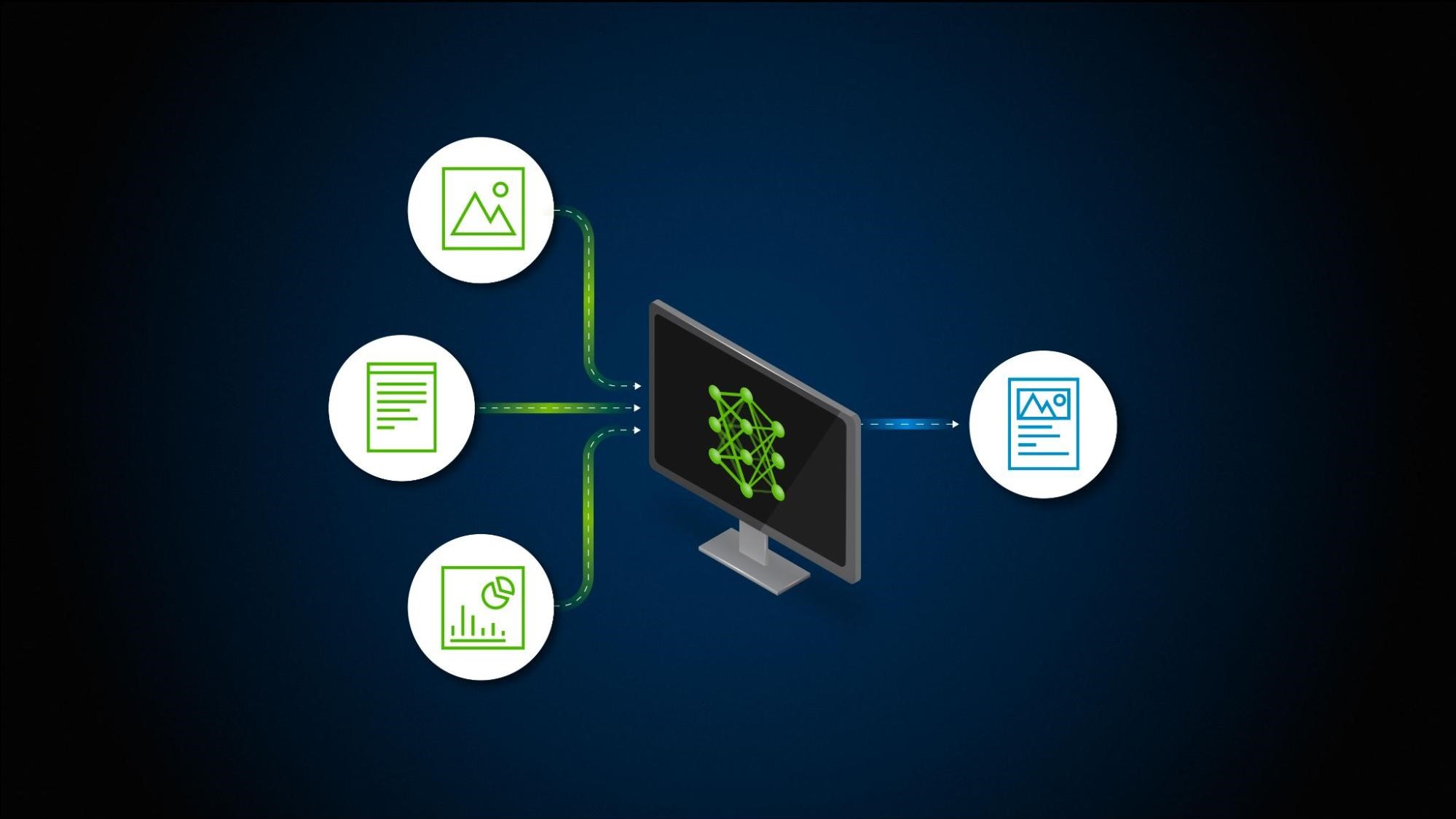

生成 AI モデルは数十億個ものパラメーターを使用し、効率的なデータ トレーニング パイプラインが必要となります。複雑なモデル トレーニング、ドメイン固有タスクのためのカスタマイズ、大規模なモデル展開には、専門知識とコンピューティング リソースが不可欠です。

NVIDIA AI Enterprise 4.0 には NVIDIA NeMo が含まれています。NVIDIA NeMo は、大規模なデータ キュレーション、大規模言語モデル (LLM) の加速されたトレーニングとカスタマイズ、ユーザーが選んだプラットフォーム上での最適化された推論を実現する、包括的でクラウドネイティブなフレームワークです。クラウドからデスクトップ ワークステーションまで、使いやすいアクセラレーテッド インフラストラクチャと最適化されたパフォーマンスを提供し、問題解決までの時間を大幅に短縮し、ROI を高めます。

AI ワークフローによる生成 AI アプリケーション構築の迅速化

NVIDIA AI Enterprise 4.0 は、生成AIアプリケーションを構築するための2 つの新しい AI ワークフローを含んでいます。

RGA(Retrieval Augmented Generation)を活用したAIチャットボットと、スピア フィッシング検知です。RGA チャットボット ワークフローは、検索拡張生成を活用し、お客様のデータに合わせて調整された生成AIチャットボットの開発と展開を加速します。これらのチャットボットは、企業のナレッジ ベースから情報を取得して自然言語を活用した回答をリアルタイムに生成することにより、ドメイン固有の質問対して正確な応答を返します。ナレッジ ベース質問応答システムのトレーニングと展開には、あらかじめトレーニングされた LLM、NeMo、NVIDIA Triton Inference Server のほか、Langchain やベクトル データベースなどのサードパーティ ツールを使用します。

スピア フィッシング検知 AI ワークフローは、NVIDIA Morpheus と NVIDIA NeMo による生成AIを使用して、受信箱に届く前にスピア フィッシング メールを最大 90% 検知できるモデルをトレーニングします。

スピア フィッシング メールを防御するのは簡単ではありません。スピア フィッシング メールは安全なメールと見分けにくく、詐欺メールと正しいメールには送信者の意図しか違いがありません。そのため、スピア フィッシングの検知には従来のメカニズムでは不十分です。

どこでも AI 開発

企業が AI を導入するには、熟練した AI 開発者やデータ サイエンティストが必要になる場合があります。

企業は生産性を最大化し、AI 開発を加速するために、最適化されたハードウェアとソフトウェアで構成される柔軟なハイ パフォーマンス インフラストラクチャを必要としています。NVIDIA AI Enterprise 4.0 は、ワークステーション向けの NVIDIA RTX 6000 Ada 世代 GPU と組み合わせることにより、AI アプリケーションの開発と本番環境への展開のための単一のプラットフォームを AI 開発者に提供します。

NVIDIA は、デスクトップ以外にも、NVIDIA H100、L40S、L4 GPU、および NVIDIA BlueField データ処理ユニットによるアクセラレーテッド ネットワークなど、AI ワークロード向けのインフラストラクチャ ポートフォリオ一式を提供しています。HPE Machine Learning Data Management、HPE Machine Learning Development Environment、Ubuntu KVM、Nutanix AHV virtualization support などを活用することで、企業はオンプレミス インフラストラクチャを使用して AI ワークロードを強化できます。

AI ワークロードとインフラストラクチャの管理

NVIDIA Triton Management Service は、NVIDIA AI Enterprise 4.0 独自の追加機能であり、GPU リソース効率に優れたモデル オーケストレーションにより、Kubernetes での複数の Triton inference Server の展開を自動化します。複数のソースからモデルを読み込み、コンピューティング リソースを割り当てることで、展開を簡素化します。NVIDIA Triton Management Service は、NVIDIA LaunchPad でラボ体験できます。

NVIDIA AI Enterprise 4.0 には、クラスターのプロビジョニング、ワークロード管理、インフラストラクチャの監視、使用状況レポートを効率化するクラスター管理ソフトウェア、NVIDIA Base Command Manager Essentials も含まれています。動的なスケーリングとポリシーベースのリソース割り当てにより、AI ワークロード管理の展開を容易にし、クラスターの整合性を提供します。

新しい AI ソフトウェア、ツール、事前学習済み基盤モデル

NVIDIA AI Enterprise 4.0 はこれ以外にも、AI 開発を推進するフレームワークとツールを提供します。NVIDIA Modulus は、シンプルな Python インターフェイスを使用して物理機械学習モデルを構築、トレーニング、ファインチューニングするためのフレームワークです。

Modulus を使用することで、ユーザーはエンジニアリング シミュレーションを AI で強化し、CFD や構造物理学から電磁気学に至るまで、複数の物理学分野にわたるエンタープライズ規模のデジタル ツイン アプリケーションのモデルを構築できます。Deep Graph Library コンテナーは、グラフ ニューラル ネットワークを実装してトレーニングするために設計されており、科学者が分子のグラフ構造を研究したり、金融サービスが不正を検出したりするのに役立ちます。

最後に、NVIDIA TAO に含まれる 3 つの独自の事前学習済み基盤モデルは、ビジョン AI、不良検出、小売店の損失防止などの産業用アプリケーションの本番活用までの時間を短縮します。

NVIDIA AI Enterprise 4.0 は、これまでのプラットフォームに対する非常に包括的なアップグレードです。エンタープライズグレードのセキュリティ、安定性、管理性、サポートにより、企業は信頼性の高い、卓越した AI を連続して稼働することができ、そのメリットを享受することが可能となります。

NVIDIA AI Enterprise を使ってみよう

以下の方法でお試しいただけます:

- NVIDIA LaunchPad に登録いただくと、ハンズオン ラボに短期間ご利用可能です。

- 既存のオンプレミスまたはクラウドインフラストラクチャを対象とした 90 日間の無料評価版にお申し込みください。

NVIDIA パートナー ネットワークまたは AWS、Microsoft Azure、Google Cloud を含む主要なクラウド サービス プロバイダーを通じてご購入いただけます。