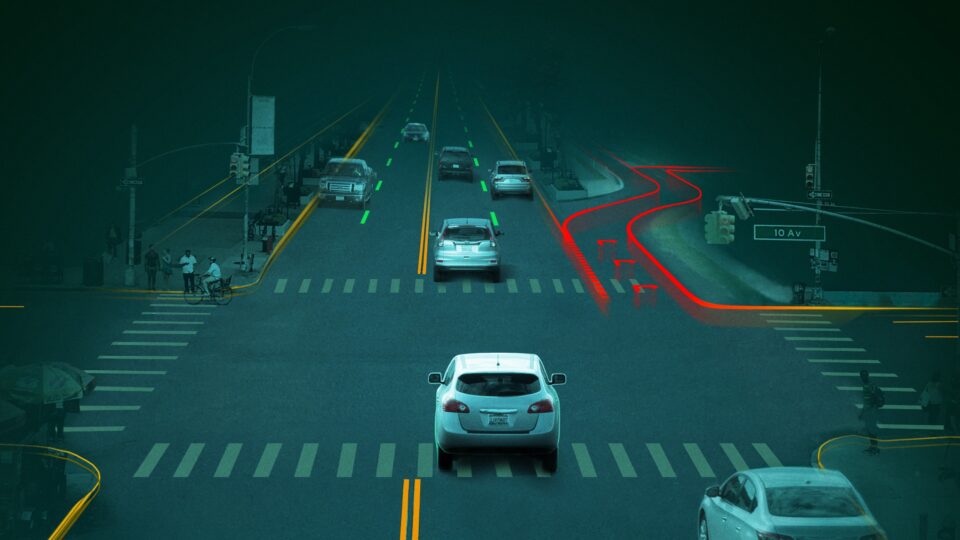

智能汽车(AV)技术是快速发展的,由于更大型、更复杂的AI模型被部署于边缘端推动。如今,现代汽车不仅需要先进的感知能力和传感器融合技术,还需具备端到端的深度学习流程,以实现全面的环境理解、多模态信息融合以及实时决策,且所有处理均在车内完成。

随着汽车应用场景的不断拓展,涵盖视觉语言动作模型(VLA)、大语言模型(LLM)、用于个性化AI助手的生成式AI以及多模态交互体验,对强大计算加速能力的需求日益迫切。这一趋势催生了对高效平台的迫切需求,以帮助开发者和OEM更便捷地在车辆内部开发、优化并部署这些资源密集型应用。

今天,我们很高兴宣布正式推出 NVIDIA DRIVE AGX Thor 开发者套件。该套件由 NVIDIA Blackwell GPU、新一代 Arm CPU 以及先进的 NVIDIA DriveOS 7 软件堆栈提供支持,专为满足 ISO 26262 ASIL-D 功能安全标准和 ISO 21434 网络安全要求而设计。完整的生产就绪型开发者工具链将助力汽车原始设备制造商(OEM)、一级软件供应商及研究人员在边缘端部署先进的 AI 应用。这一突破性进展将重塑自动驾驶与智能座舱体验,加速推动智能出行的发展进程。

NVIDIA DRIVE AGX Thor 如何开启汽车边缘智能的新时代?

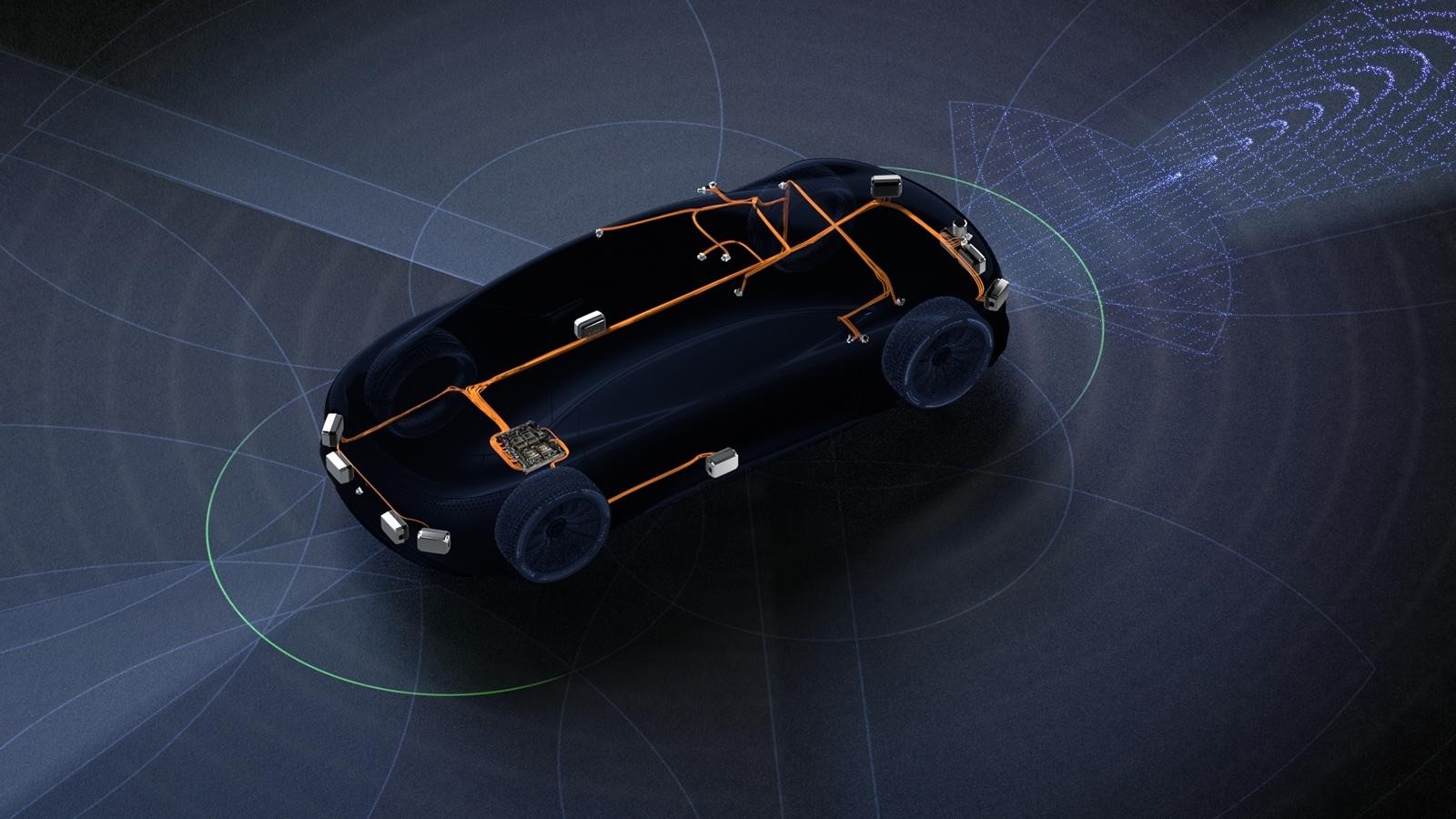

DRIVE AGX Thor 是 NVIDIA 车载边缘计算平台系列的重要突破。作为 DRIVE 系列的旗舰级 SoC,Thor 在 Orin 及前代解决方案成功的基础上,进一步提升了系统性能、能效表现与功能灵活性,迈上了一个全新的台阶。

DRIVE AGX Thor 拓展了车载边缘设备的计算能力,帮助汽车制造商更好地应对未来不断增长的需求。

| 功能 | NVIDIA DRIVE AGX Thor SoC | NVIDIA DRIVE AGX Orin SoC |

| GPU | 具有生成式 AI 引擎的 Blackwell GPU:FP32/ 16/ 8/ 4 位支持;高达 1000 INT8 TFLOPS;2000 FP4 TFLOPS | CUDA Tensor Core GPU 深度学习加速器:高达 254 INT8 TFLOPS |

| CPU | 14x Arm Neoverse V3AE 2.3 倍 SPECrate 2017_int_base (预计)与 Orin | 12x Arm Cortex-A78-AE (Hercules) 的对比 SPECrate 2017_int_base (估计值)1 个 Orin |

| 内存带宽 | 273 GB/s LPDDR5X | 205 GB/s LPDDR5 |

| 安全性 | 最高支持 ISO 26262 ASIL-D 用例 | |

NVIDIA DRIVE AGX Thor 开发者套件是如何专为开发者打造的?

DRIVE AGX Thor 开发者套件提供了一个可靠的平台,便于在迈向量产级汽车计算平台之前快速部署、测试和优化应用程序。该套件兼容完整的生态系统所支持的传感器,并适配新一代 NVIDIA DRIVE Hyperion 传感器架构。凭借多种符合汽车标准的接口,它能够支持多样化的汽车应用场景,实现顺畅的原型开发与验证。

DRIVE AGX Thor 开发者套件现已开放预订,预计将于 2025 年 9 月开始交付。该套件提供多种 SKU 选项,可满足不同开发需求,为工作台开发流程以及整车级集成提供针对性支持。

- 用于工作台开发的 DRIVE AGX Thor 开发者套件 SKU 10

- 用于车载开发的 DRIVE AGX Thor 开发者套件 SKU 12

| 方面 | 详细信息 |

| 平台 | 采用 NVIDIA Thor SoC |

| 系统 RAM | 64 GB LPDDR5X@ 4266 MHz |

| 存储 | 256 GB UFS |

| Ethernet | 4x 100MbE,16x 1GbE,6x 10GbE (全部为 H-MTD 连接器) |

| 摄像头 | 16x GMSL2 摄像头,2x GMSL3 摄像头 ( Quad Fakra 连接器) |

| USB | 1x USB 3.2 ( U1 data) ,1x USB 3.2 ( U2 刷写) ,1x USB 2.0 ( U3 data) ,1x USB 2.0 (调试) ,全部 USB-C |

| 显示器 | 5x GMSL3 链路 ( Quad Fakra) ,1x DisplayPort (最高 4K@ 60 Hz) |

| PCIe | 1x PCIe Gen5 x4 或 2x PCIe Gen5 x2 (MiniSAS HD) |

| Thor Dev Kit TDP | 350 W |

DRIVE AGX Thor 开发套件融合了高性能计算与符合汽车行业标准的开发环境,有助于加快创新进程、降低开发风险,并实现从早期研发到整车部署的顺畅过渡。

由 NVIDIA DriveOS 7 提供支持

NVIDIA DriveOS 为智能汽车提供全面的软件基础,集成了高性能 AI 计算、实时处理能力以及对安全标准的合规性,构建于统一平台之上。本节内容结合图 2,详细介绍了 NVIDIA DriveOS 7 中的关键增强功能。

与 NVIDIA TensorRT 10 集成

借助动态内核生成与融合、改进的 ModelOpt 量化支持(包括 INT4 AWQ)以及 Blackwell 架构原生的 NVFP4 加速,TensorRT 10 能够显著提升深度学习任务的性能与内存效率。通过扩展的 V3 插件支持、更快的构建速度、丰富的网络类型支持以及强大的调试工具,TensorRT 10 能够轻松应对各类复杂 AI 模型,实现广泛适用性。

NVIDIA DriveOS LLM SDK 运行时

NVIDIA DriveOS 7 采用了 DriveOS LLM SDK,这是一个基于纯 C++ 构建的 LLM 运行时环境,具备极低的依赖性和出色的低延迟性能。该运行时针对 FP16、FP8、INT4 和 FP4 量化技术进行了深度优化,支持预测解码、KV 缓存、基于 LoRA 的模型定制、动态批处理以提升吞吐量,并提供对主流大语言模型(LLM)和视觉语言模型(VLM)的开箱即用支持。LLM SDK 运行时以源代码形式提供,同时附带展示模型推理过程及 SDK 功能的示例程序。如需了解更多详情,请参阅借助 NVIDIA DriveOS LLM SDK 简化智能汽车应用的 LLM 部署。

全面的安保和安全

ISO 26262 ASIL-D 与 ISO 21434 CAL 4 均致力于实现最高程度的安全保障。

CUDA 13 功能

CUDA 13 的新功能,包括上下文暂停与恢复、批量内存复制(memcpy)以及硬件感知型张量映射,为开发者提供了优化应用程序性能的有效工具。

NVIDIA DriveWorks

NVIDIA DriveWorks 现已深度集成于 NVIDIA DriveOS,经过实际智能汽车项目部署的验证,并针对 Thor SoC 架构进行了优化,可为量产车型提供强大的感知、传感器融合以及车辆系统 SDK 套件。

升级开发生态系统

更新了 Ubuntu、Docker、GCC、C++ 和 Linux 内核以及 Yocto 的版本,有助于提升系统性能、增强安全性、扩展硬件兼容性,并带来更加简洁高效的现代开发体验。

与 NVIDIA TensorRT 10 集成

NVIDIA TensorRT 10,作为 NVIDIA DriveOS 7 的核心组件,提供了更强的 AI 性能,显著加速了智能汽车的开发进程。表 3 展示了一系列全面的基础性升级,有助于进一步提升开发人员的工作效率。

量化和性能 |

INT4 仅权重量化 | 支持更快的推理速度和更低的功耗,尤其是在内存受限的模型上 |

| 块级扩展 | 通过在每个块内本地保留动态范围,减少 INT8 和 FP8 等低精度格式的信息损失 | |

| NVFP4 精度适用于 Blackwell GPU | 允许大型模型高效运行,同时将精度降低到最低,特别是在内存和带宽受限的场景中 | |

| 平铺优化 | 允许配置优化级别(从“无”到“完全”)并设置 L2 缓存使用限制,以权衡构建时间和运行时速度 | |

| 改进的开发者体验 | V3 插件 | 允许更快的引擎构建和减少部署时间,当开发者在不同会话或硬件目标中重用插件层时 |

| 调试张量 | 在模型执行期间识别特定的中间张量,以便检查其值以进行更好的调试 | |

| NVIDIA TensorRT 模型优化器 | 量化,稀疏性,蒸馏 | 为 TensorRT 10 及更高版本提供全面的训练后和训练循环内模型优化库 |

NVIDIA DriveOS LLM SDK 运行时

NVIDIA DRIVE Thor 平台与 NVIDIA DriveOS 的核心创新之一,在于能够高效地在车辆边缘运行强大的大语言模型(LLM)和视觉语言模型(VLA)。DriveOS LLM SDK 是一款轻量级、高性能的 C++ 工具包,专为展示 TensorRT 在汽车平台上部署 LLM 与视觉语言模型(VLM)的能力而设计。

DriveOS LLM SDK 提供了一个灵活的工具包,能够将大语言模型的强大能力融入车载系统,实现丰富的对话式人工智能、多模态推理以及驾驶员与乘员监控等功能。

DriveOS LLM SDK 运行时支持哪些 LLM?

DriveOS LLM SDK 运行时原生支持多个 Llama 和 Qwen 模型,并将在未来版本中逐步扩展对更多模型的支持(见表 4)。

| 模型 | FP16 | INT4 | FP8 | NVFP4 |

| Llama 3 8B Instruct | Yes | Yes | Yes | Yes |

| Llama 3.1 8B | Yes | Yes | Yes | Yes |

| Llama 3.2 3B | Yes | Yes | Yes | Yes |

| Qwen2.5-7B-Instruct | Yes | Yes | Yes | Yes |

| Qwen2-7B-Instruct | Yes | Yes | Yes | Yes |

| Qwen2.5-0.5B | Yes | Yes | Yes | Yes |

DriveOS LLM SDK 运行时支持哪些 VLM?

DriveOS LLM SDK 运行时原生支持适用于边缘部署的 Qwen VLM,并计划在后续版本中扩展对更多模型的支持(见表 5)。

| 模型 | FP16 | INT4 | FP8 | NVFP4 |

| Qwen2-VL-2B-Instruct | 是 | 是 | 是 | 是 |

| Qwen2-VL-7B – Instruct | 是 | 是 | 是 | 是 |

随着未来版本的陆续发布,将有更多模型选项和流程工具支持无缝的汽车集成。

NVIDIA DriveOS Linux 配置文件

支持安全扩展的 NVIDIA DriveOS Linux 是基于 Ubuntu 24.04 LTS 的参考软件平台,专为自动驾驶应用的原型设计与开发而打造,内置具备调试功能的镜像。该平台使开发者能够构建面向生产的智能汽车应用,并满足高标准的汽车功能安全要求。DriveOS Linux 提供三种配置模式:开发、生产和测试 (见表 6)。

| 方面 | 开发配置文件 | 安全扩展程序生产配置文件 | 安全扩展程序 测试配置文件 |

| 打算使用 | 主动开发 | 生产部署 | 测试/ 验证 (预生产) |

| 安全扩展程序 | 不包括 | 默认启用 | 默认启用 |

| 调试功能 | 可用 | 禁用 | 禁用 (UART 已恢复) |

| 日志记录和分析 | 可用 | 禁用 | 禁用 |

| 控制台访问 | 启用 | 已禁用 | UART 访问已恢复 |

| SSH/NFS 访问 | 启用 | 已禁用 | SSH 已恢复 |

| 安全加固 | 最小 | 完全加固 | 完全加固 |

| Boot KPI 优化 | 无 | 已启用 | 已启用 |

| 生产建议 | 需要文档 | 即插即用 | 仅用于测试,不用于最终部署 |

开始使用 NVIDIA DRIVE AGX Thor 开发者套件

准备好使用 NVIDIA DRIVE AGX Thor 开发者套件加速您的自动驾驶开发了吗?首先,请注册 NVIDIA 开发者账户 并加入 NVIDIA DRIVE AGX SDK 开发者计划。 您还可以 下载 NVIDIA DriveOS 7.0.3 Linux,这是适用于自动驾驶系统的最新版本操作系统。

DRIVE AGX Thor 开发者套件现已开启预订。

使用 NGC DriveOS Docker 容器可简化开发环境,加快配置速度。如有疑问,欢迎前往 DRIVE AGX Thor 开发者论坛提问并加入社区交流。