近年来,大型语言模型(LLM)彻底改变了自然语言处理(NLP),实现了文本摘要、问答和自然语言生成等广泛的应用。

由 Snowflake 开发的 Arctic 是一种新的开放 LLM,旨在实现高推理性能,同时在各种 NLP 任务上保持低成本。

Arctic

Arctic 基于一种新的密集 MoE(专家混合物)混合变压器架构,该架构将 10B 参数密集变压器模型与残差 128×3.66B MoE 多层感知器(MLP)相结合,从而有效地隐藏普通 MoE 模型在计算过程中施加的额外全对全通信开销。这样,该体系结构能够在训练和推理过程中更有效地使用资源。

由此产生的网络具有 480B 的总参数,并使用前 2 个门控让专家选择 17B 的活动参数。通过利用大量专家和总参数,该体系结构允许顶级智能,同时从许多但精简的专家中进行选择,仅使用适量的活动参数进行训练和具有成本效益的推理。

LLM 在企业中的应用案例

Arctic 的主要用例是 SQL、编码和企业应用程序的指令遵循。

SQL 和代码生成具有挑战性,因为它需要理解自然语言和编程语言的语义和语法,并生成符合用户意图的有效和准确的输出。

该模型击败了其他最先进的开放模型,在 Spider 基准测试中实现了 79%的准确率,Spider 基准是一个大规模、复杂和跨领域的语义解析和文本到 SQL 数据集,旨在评估模型将自然语言问题翻译成 SQL 查询的能力。

此外,它在用于代码生成的 HumanEval+和 MBPP+基准测试中处于领先地位,并在 IFEval 基准测试中提供了优于其他模型的性能——用于评估 LLM 的指令遵循能力的性能。

NVIDIA NIM 微服务平台

Arctic 针对延迟和吞吐量进行了优化,现在加入了二十多个受支持的流行人工智能模型,包括 NVIDIA NIM 微服务,旨在简化性能优化部署,以及 NVIDIA AI Foundation 模型 和自定义模型,使更多的企业应用程序开发人员能够为人工智能转型做出贡献。

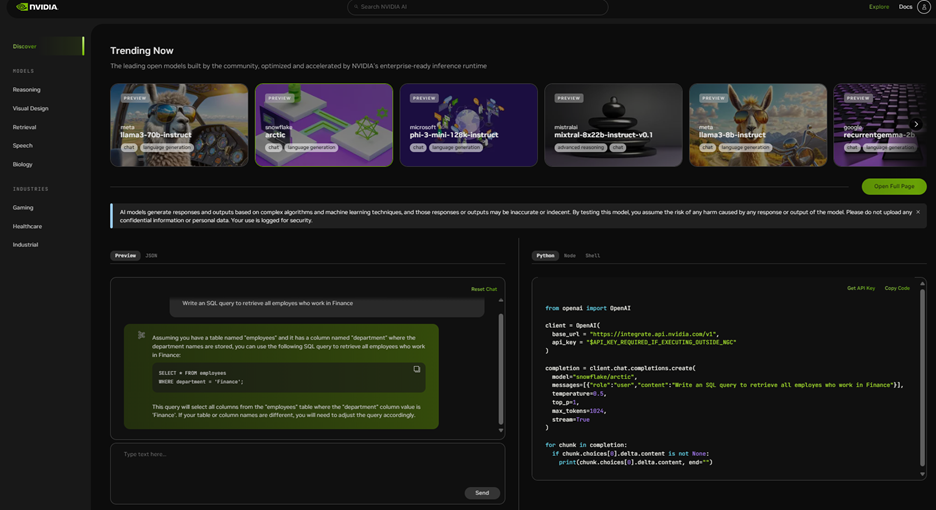

体验模型 Demo

NVIDIA API 产品目录 是一组性能优化的 API 端点,打包为企业级运行时,允许您在浏览器中进行体验和探索。

有了免费的 NVIDIA 云积分,您可以开始大规模测试该模型。您还可以通过将应用程序连接到运行在完全加速堆栈上的 NVIDIA 托管 API 端点上来构建概念验证(POC)。API 与 Langchain 和 LlamaIndex 等框架集成,简化了企业应用程序开发。

当您准备将其投入生产时,可以在几分钟内将模型部署到本地、云中或工作站上的 NIM 微服务中。随时随地运行的灵活性使您的数据保持安全和隐私,避免平台锁定,并使您能够利用现有的基础设施投资和云承诺。

要开始,请访问 build.NVIDIA.com,立即开始您的开发之旅。