NVIDIA Spectrum-X はハイパースケール クラウド インフラの AI 向けに作られた最先端のネットワーキング プラットフォームとして脚光を浴びています。Spectrum-X ネットワーキング テクノロジは、企業のお客様が生成 AI ワークロードを高速化するのに役立ちます。NVIDIA は 2023 年 11 月のプレス リリースで、このプラットフォームの大幅な OEM 採用と、Spectrum-X を搭載した NVIDIA Israel-1 スーパーコンピューターのアップデートを発表しました。

NVIDIA は今回、Supermicro が Spectrum-X プラットフォームの OEM パートナーとして参加したことを発表しました。Spectrum-X は、4U、5U、8U フォーム ファクターの Supermicro GPU SuperServer に組み込まれ、NVIDIA HGX H100、NVIDIA H100、NVIDIA L40S PCIe フォーム ファクターの NVIDIA GPU をサポートします。

これらの Supermicro システムは、大変優れたネットワーク パフォーマンスを備え、マルチテナントのパフォーマンス分離を可能にし、電力効率を高め、大規模な Transformer ベースの生成 AI モデルにおけるトレーニング時間や推論時間を大幅に短縮します。この性能向上は、Ethernet ネットワーク標準に準拠し、NVIDIA Spectrum-4 Ethernet スイッチと NVIDIA BlueField-3 SuperNIC を活用しながら達成されています。

NVIDIA は、Supermicro との連携により、AI クラウドとハイパースケール インフラのお客様にさらなる価値を提供できることを楽しみにしております。

NVIDIA Spectrum-X パフォーマンス ベンチマーク

NVIDIA Israel-1 データ センターの開発を続ける中で、NVIDIA は Spectrum-X のパフォーマンス上の利点を明らかにするさまざまなベンチマークを実施しました。以下に詳述するように、初期の結果はすばらしいものになっています。

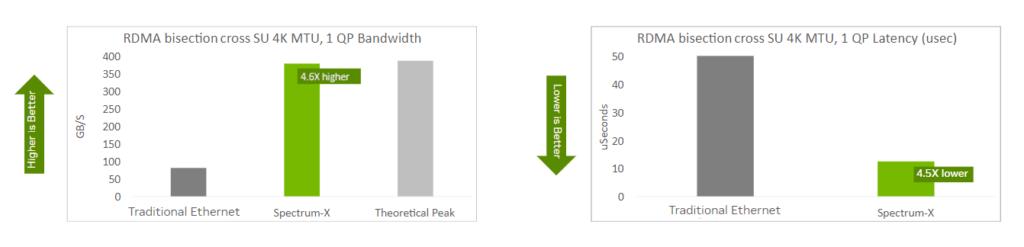

基本的なネットワークの健全性 (RDMA)

この最初のベンチマークは、システムの基本的なネットワークの健全性を示しています。AI ワークロードの中心は GPU の活用であり、高帯域幅、GPU (や、そのオンボード メモリ) 間の低遅延通信、ファブリックにサーバーを接続するネットワーク アダプターを必要とします。

RDMA バイセクションは、ネットワークが AI に対応していることを示す重要な指標であり、Spectrum-X はこのカテゴリで優れています。従来の Ethernet と比べ、有効な帯域幅が 4 倍超、遅延が 4 分の 1 以下になります。従来の Ethernet でも RDMA を使用し、輻輳通知やフロー制御などの最適化を行っています。

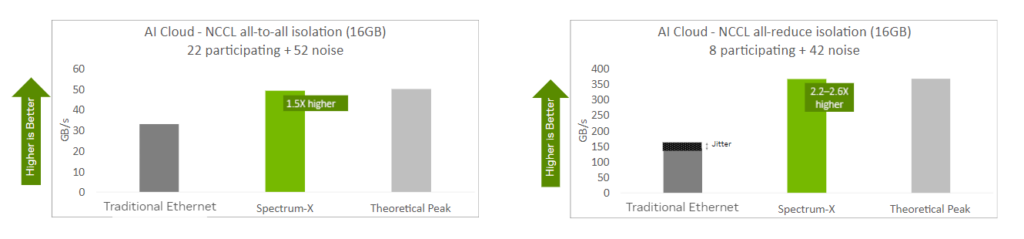

AI の包括的パフォーマンス

RDMA パフォーマンス以外に、NVIDIA Collective Communications Library (NCCL) の AI プリミティブのパフォーマンスもテストしました。複数のシステムをまたいで実行される AI ワークロードでは、all-to-all や all-reduce などの NCCL 演算を活用し、個々の GPU をまたいでモデル パラメーターを更新し、スケールアウトされたトレーニングや推論において、同期を維持します。

NCCL 演算では、Spectrum-X を使用することで、従来の Ethernet に比べて大きな性能向上が確認されました。複数のワークロードがネットワーク全体で同時に通信する、ノイズの多い AI クラウド シナリオでも、一貫性があり、予測可能なパフォーマンスが示されました。

実際、Spectrum-X はノイズのないシナリオとノイズの多いシナリオの両方で一貫して高いパフォーマンスを示しました。対照的に、従来の Ethernet では、実行ごとに最大 20% のパフォーマンス変動が見られました。

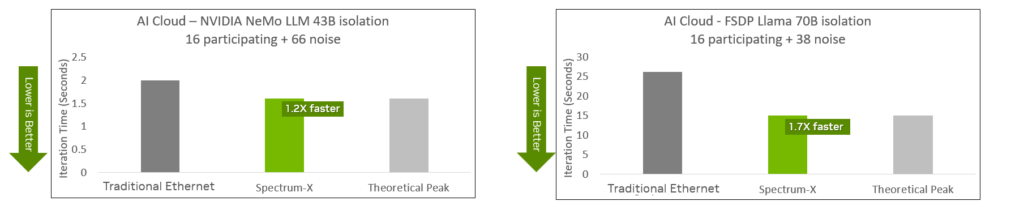

大規模言語モデルのパフォーマンス

RDMA バイセクションと AI 集合演算は重要ですが、最も重要な結果はアプリケーション レベルの結果でしょう。Spectrum-X は大規模言語モデル (LLM) のトレーニング ワークロードを高速化するのでしょうか? 実際、そうなんです。NVIDIA NeMo LLM と FSDP Llama LLM の両方に対して、Spectrum-X は大幅なパフォーマンス向上をもたらします。ステップのイテレーションの回数を減らし、トレーニング時間とインサイトを得るまでの時間を短縮します。

ネットワークの復元力

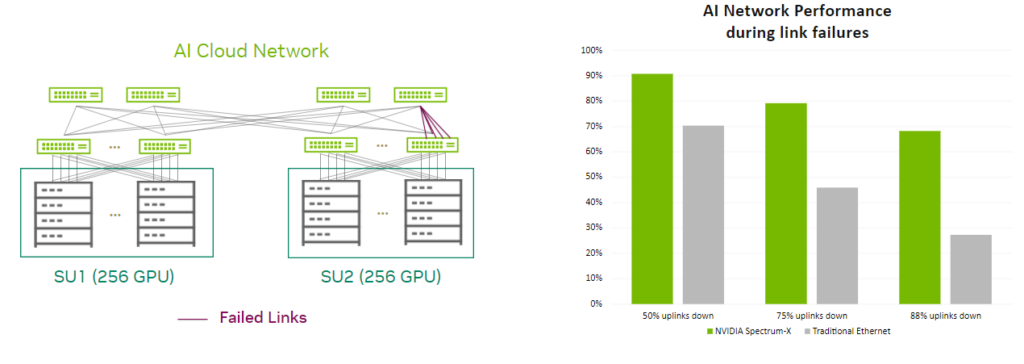

Spectrum-X はネットワーク最適化によって AI を高速化しますが、ネットワークの復元力を考慮することも重要です。AI ワークロードは緊密に結合されており、最適なパフォーマンスのためには、すべてのノードに高い有効帯域幅が必要になります。

ネットワークのリンクやスイッチに障害が発生すると、AI トレーニングに大きな影響が出ることがあります。ネットワーク通信は速やかに再ルーティングする必要があります。そうしないと、GPU インフラの大部分がアイドル状態になり、時間と費用もかかり、以前のチェックポイントからジョブを再開する必要が生じる可能性があります。

Spectrum-X ルーティング メカニズムでは、ダウンしたリンクからフローが外れ、正常なリンクに効率的に割り当てられるため、パフォーマンスの低下が最小限に抑えられます。一方で、従来の Ethernet では、ネットワークの問題が原因で大幅かつ不均衡な速度低下の影響を受けやすく、GPU インフラが効率的ではなくなります。

まとめ

以上の初期ベンチマークで示されているように、Spectrum-X は Ethernet を使用してマルチテナントのハイパースケール AI クラウドを構築する画期的なアプローチです。このソリューションにより、組織は AI クラウドのパフォーマンスとエネルギー効率を向上させながら、予測可能性と一貫性を高めることができます。その結果、TTM が加速し、競争上の優位性が強化されます。

詳細情報

より詳細をご覧になりたいですか? NVIDIA GTC 2024 (※ 2024 年 3 月に終了) に現地参加またはバーチャル参加し、NVIDIA の一連のネットワーキング プラットフォームを直接ご体験ください。業界の著名人、開発者、研究者、ビジネス戦略家と交流し、AI とアクセラレーテッド コンピューティングの未来を形作りましょう。AI カンファレンスでは、NVIDIA ネットワーキングの進歩に関するエキサイティングな発表、デモンストレーション、教育セッションが行われます。

おすすめのネットワーキング セッションのご紹介:

- Best Practices in Networking for AI: Perspectives from Cloud Service Providers – Panel [S62447]

- Getting the Storage Right for AI Applications – パネル ディスカッション [S62476]

- Entering A New Frontier of Innovation with InfiniBand [S62293]

- Enabling Enterprise Generative AI with Optimized Ethernet AI Networking [S62521]

- Accelerating HPC and AI Applications with Offloading to BlueField DPUs: Strategies and Benefits [S61956]