生成 AI は、あらゆる産業において、データを活用して生産性を向上させ、パーソナライズされた顧客エンゲージメントを進め、イノベーションを促進する方法を革新しています。その価値が非常に高いため、企業は、この新しい技術を自社の事業運営や戦略に効果的かつ信頼性の高い方法で統合するのに役立つツールと専門知識を求めています。

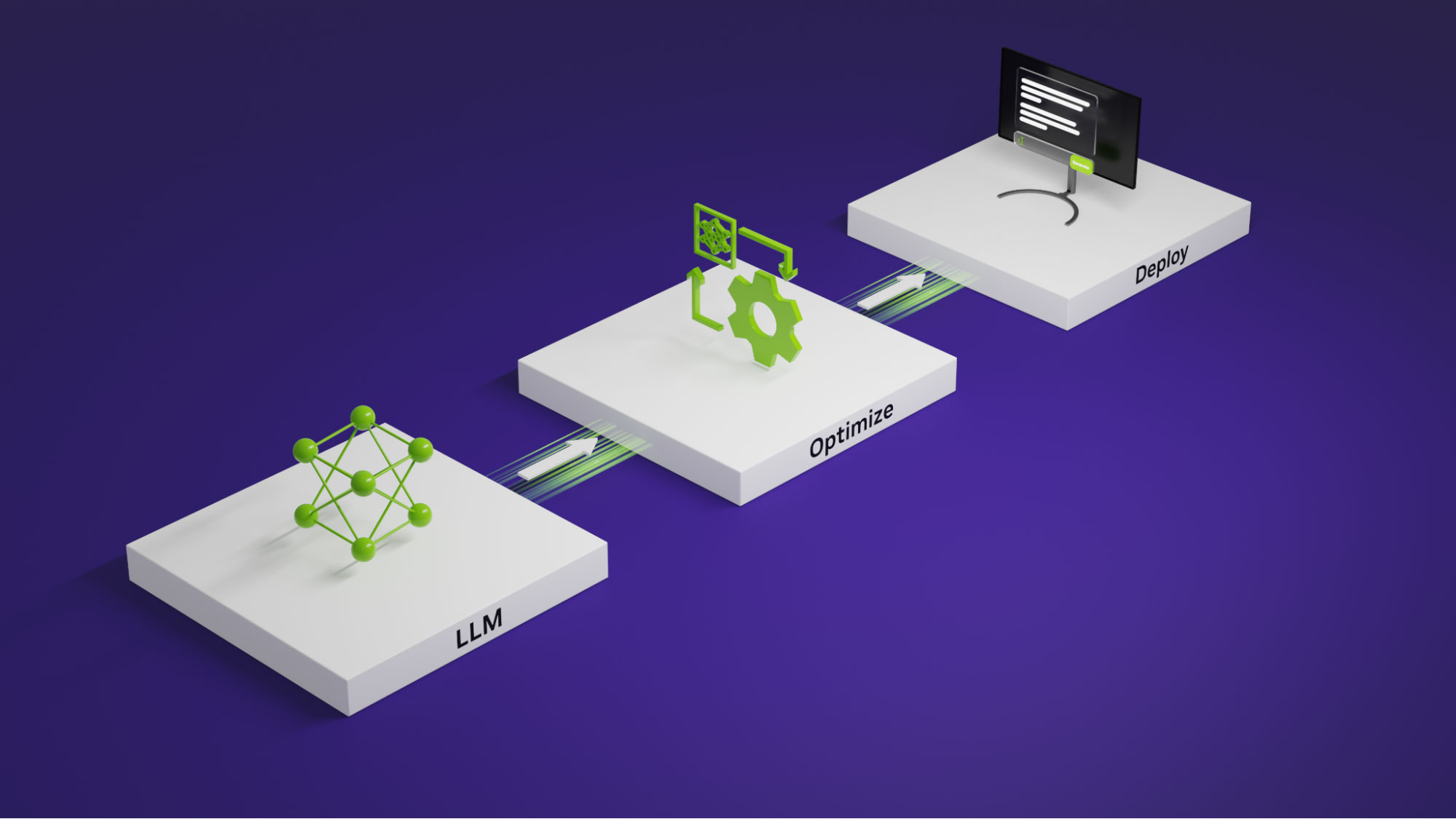

NVIDIA と Microsoft は、Azure Machine Learning (Azure ML) 上の NVIDIA AI を使用して、生成 AI を含む AI アプリケーションを構築、最適化、展開するための包括的なソリューションを企業に提供するために協力しています。

今週開催された Microsoft Ignite で、NVIDIA と Microsoft は新たに 2 つのマイルストーンを発表しました。これにより、本番環境でのAI の管理と生成 AI アプリケーションの開発が可能になる新機能が Azure ML にもたらされます。

- 生成 AI モデルを構築およびカスタマイズするためのフレームワークである NVIDIA NeMo および新しい NVIDIA Nemotron-3 8B ファミリのモデルを含む NVIDIA AI Foundation モデルが、Azure Machine Learning モデル カタログで提供開始されます。

- 運用環境で AI を拡張する NVIDIA Triton Inference Server が、Azure ML マネージド エンドポイントで一般提供されます。

6 月には、NVIDIA AI Enterprise ソフトウェアと Azure Machine Learning の統合とその開始方法を説明するブログ記事を公開しました。この記事では、NVIDIA チームと Azure チームによる進捗状況と、2 つの新しい統合の利点、およびそれらにアクセスする手順について説明しています。

NeMo フームワークを Azure Machine Learning モデル カタログに統合

LLM は、テキストの要約、言語翻訳、テキスト生成などのさまざまなタスクを実行できるため、大きな注目を集めています。モデルの重みまたは API として利用可能なオープンソースの LLM や専有 LLM は、さまざまな生成 AI フレームワークを使用して大規模なデータ コーパスで事前トレーニングされます。

生成 AI フレームワークを使用してドメイン固有の洞察を獲得するために調整されたカスタム LLM も、エンタープライズ分野での注目度が高まっています。

NeMo は、開発者が数十億のパラメーターを持つ生成 AI モデルを構築、カスタマイズ、展開するためのエンドツーエンドのクラウドネイティブなエンタープライズ フレームワークです。トレーニングや推論のフレームワーク、ガードレール ツールキット、データ キュレーション ツール、事前トレーニング済みモデルが用意されており、企業は生成 AI を容易で費用対効果に優れた方法により迅速に導入することができます。

企業がサポート、セキュリティ、API の安定性を加速するように設計された、安全で最適化されたフルスタック ソリューションである NeMo は、NVIDIA AI Enterprise の一部として利用できます。Azure ML のユーザーは、ノーコードのフローでユーザー インターフェイスを介してカスタマイズ、最適化、展開できるようになりました。また、パフォーマンスや精度を高めるベスト プラクティスなど、生成 AI プロジェクトに関するサポートを NVIDIA から直接受けることもできます。

Azure Machine Learning モデル カタログ内で基盤モデルの NVIDIA Nemotron-3 8B ファミリと NeMo フレームワークが利用できるようになったことで、ユーザーはこれらのモデルをすぐに利用、カスタマイズ、デプロイできるようになりました。このフレームワークでは選択できるカスタマイズ手法が複数あり、言語や画像アプリケーションのモデルを大規模に推論できるように最適化されています。

Triton Inference Server を Azure ML マネージド エンドポイントに統合

Triton Inference Server は、リアルタイム、バッチ、ストリーミングなど、複数のクエリ タイプの推論を最適化するマルチフレームワークのオープンソース ソフトウェアです。モデル アンサンブルもサポートしている Triton Inference Server は、NVIDIA AI Enterprise の一部として利用できます。Triton は、TensorFlow、ONNX Runtime、PyTorch、NVIDIA TensorRT などのさまざまな機械学習フレームワークと互換性があり、CPU や GPU のワークロードに使用できます。

Triton は Azure ML で利用可能で、動的バッチ処理、同時実行、最適なモデル構成を提供します。さらに、Azure ML 内の NVIDIA AI Enterprise を介して、エンタープライズグレードのセキュリティ、管理可能性、API の安定性を提供します。

Azure ML マネージド エンドポイントを使用すると、企業は AI モデルの監視、デプロイ、拡張を容易にできるようになり、独自の AI インフラストラクチャの設定や管理の複雑さが軽減されます。

GA リリースはプロダクション ブランチに基づいており、NVIDIA AI Enterprise でのみ利用可能です。プロダクション ブランチによって、NVIDIA AI 上に構築されたアプリケーションの安定性とセキュリティが確保され、9 か月のサポートや API の安定性がもたらされるほか、ソフトウェアの脆弱性に対する修正が毎月提供されます。プロダクション ブランチについて詳しくは、こちらをご覧ください。

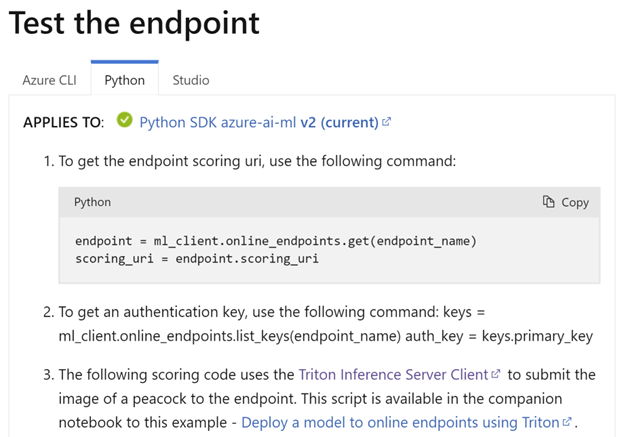

Triton Inference Server をすぐ利用してみましょう

Azure ML マネージド エンドポイント上の Triton Inference Server にモデルをデプロイするのは容易です。以下の動画をご覧になり、次の 5 つの手順に従ってください。

- Azure Machine Learning で [モデル] にアクセスし、モデルを Triton 形式で登録します。タイプが「Triton」であることを確認してください。

- [エンドポイント] に移動し、[作成] ボタンをクリックして、リアルタイム オンライン エンドポイントを作成します。デプロイでは「Triton」サーバーを選択します。

- デプロイ パラメーターを設定し、[次へ] をクリックします。[環境] セクションでは、環境とスコアリング スクリプトが予め選択されています。[次へ] をクリックします。

- モデルと環境を確認し、[作成] ボタンをクリックしてモデル推論用にデプロイします。

- テスト ページを確認します。

Azure Machine Learning で NVIDIA を使ってみましょう

NVIDIA AI Enterprise と Azure Machine Learning を組み合わせることで、強力な GPU アクセラレーション コンピューティングと包括的なクラウドベースの機械学習プラットフォームが構築され、企業は AI モデルをさらに効率的に開発、展開できるようになります。この相乗効果により、企業はクラウド リソースと NVIDIA GPU やソフトウェアのパフォーマンス上の利点を活用できます。

AI とクラウド コンピューティングを未来に向けて推進させる最新のイノベーションとコラボレーションについて詳しくは、Microsoft Ignite の NVIDIA セクションにアクセスしてください。

スポンサー セッションに参加するか、EMU デモ スペース #311 にお立ち寄りいただければ、画期的な NVIDIA ソリューションに関する洞察を獲得することができます。詳細については、NVIDIA ショーケース ページをご覧ください。

Azure Machine Learning モデル カタログの NVIDIA AI Foundation モデルと NeMo フレームワーク、および Azure ML エンドポイントの NVIDIA Triton Inference サーバーをぜひチェックしてください。