现代 AI 工作负载已远超单 GPU 推理服务的能力范围。模型并行技术通过在多个 GPU 之间高效划分计算任务,已成为实现可扩展性先进部署的基础。当前性能较强的模型越来越多地采用多专家模型(MoE)架构,该架构相比密集模型更具效率,因为每个 token 仅激活一组经过训练的参数。然而,扩展 MoE 架构带来了更复杂的并行处理、通信机制与调度需求,必须进行精细优化。

专家并行(EP)通过将专家模型战略性地分布到多个 GPU 上,在应对大规模模型挑战、实现可扩展性能方面发挥着关键作用。随着 DeepSeek-R1 等模型规模的持续扩大(包含 256 个专家、6710 亿参数),我们亟需新的工具支持,例如 NVIDIA TensorRT-LLM 提供的 Wide Expert Parallelism(Wide-EP)。该技术显著提升了大模型部署的效率,同时优化了性能表现和总体拥有成本。

在本博客中,我们将深入探讨大规模 EP 对性能的影响,并重新审视 NVL72 机架级扩展域中推理任务的经济效益。

如何实现大规模的专家并行

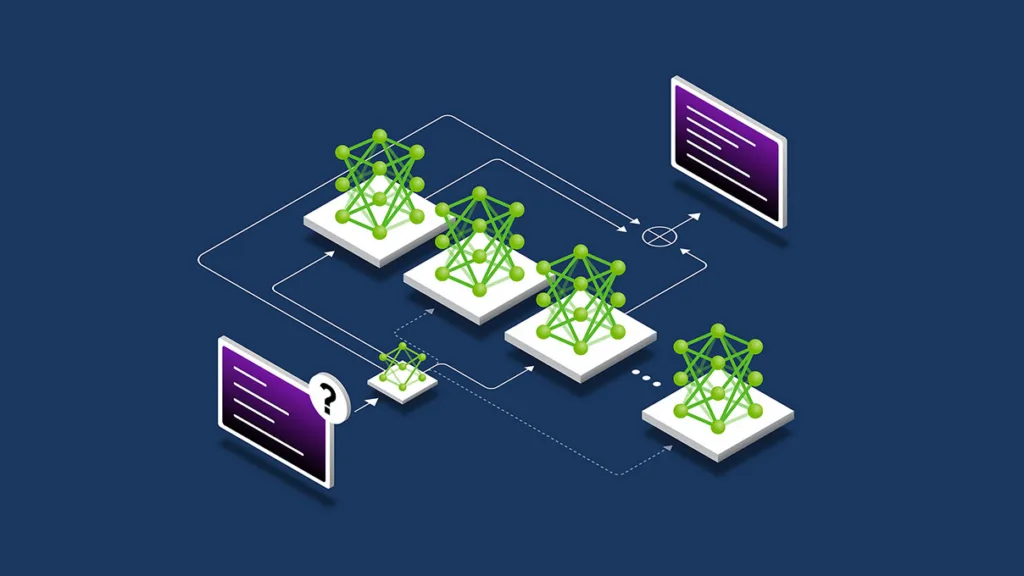

专家并行(EP)是一种模型并行技术,能够将MoE模型中的专家分配到多个GPU上,从而利用各设备的综合计算能力和内存带宽。在较小规模下,EP通过在设备间均衡分配任务,有效缓解内存压力并维持较高的计算资源利用率。

随着像 DeepSeek-R1 这类模型的参数规模达到数千亿,并有数百名专家参与,相关技术的应用范围需要进一步拓展,从而形成所谓的大规模 EP。在本篇博客的语境中,大规模 EP 指的是将专家分布在八个或更多 GPU 上的实现方式。这种方式能够提升聚合带宽,加快权重加载速度,同时支持更大的有效批量大小,从而提高 GPU 的整体利用率。

大规模EP在内存和计算方面面临哪些挑战?

MoE 模型的一个额外优势在于,推理过程中仅需激活少量专家,从而显著降低每个 token 的计算开销。为此,MoE 会根据每层的 token 动态加载对应专家的权重。然而,在高吞吐量且对延迟敏感的场景中,一种称为 MoE GroupGEMM 的特定计算过程可能会因权重加载开销过大而迅速成为性能瓶颈。

MoE GroupGEMM 类似于将所有 token 同时送入同一个处理通道,以实现高效的批量处理。在实际操作中,这些 token 会按专家进行分组,并组织成矩阵乘法,将每个专家对应的 token 批量整合为一次大规模计算。这种方式提升了算术强度,但要求在执行矩阵乘法之前,将各个专家的权重预先加载到片上内存或寄存器中。

大规模 EP 通过在专家并行配置中引入更多 GPU,缓解了 MoE GroupGEMM 的部分瓶颈,有效减少了每个 GPU 负责的专家数量。这种扩展方式将带来以下影响:

- 减轻 GPU 负载压力(每个 GPU 上的专家权重集更少)

- GroupGEMM 内核能够更高效地复用权重(运算强度更高,即每字节权重加载可支持更多的 FLOPS)

- 在内核层面实现更优的计算与内存平衡

尽管大规模专家并行(EP)有助于缓解小规模 EP 的局限性,但它也带来了新的系统级限制,使得扩展大型混合专家(MoE)模型变得困难。TensorRT-LLM 的 Wide-EP 通过算法层面识别计算与内存瓶颈,有效应对这些挑战,同时在系统和架构层面优化工作负载管理,提升整体扩展能力。

我们来看看 Wide-EP 与 GB200 NVL72 结合使用时,如何为可扩展且高效的 MoE 推理奠定基础。

系统的架构与设计是怎样的?

扩展专家并行不仅需要增加 GPU,更依赖于高效的系统设计与架构,以确保内存访问和通信的效率。互连带宽与拓扑结构构成了基础,使激活值和权重能够在设备间顺畅传输。

此外,经过优化的软件与内核可通过通信原语、带宽感知调度以及负载均衡来有效管理专家间的通信流量。这些技术的结合使得大规模专家并行(EP)变得切实可行且高效。

借助 NVLink 降低分布式专家系统中的通信开销

大规模EP的主要瓶颈之一是通信开销。在推理的解码阶段,分布式专家需要交换信息,以整合分布在多个GPU上的输出结果。例如,当将DeepSeek-R1的256个专家分配到64个GPU上(每个token激活8个专家)时,通信成本取决于当前层中被激活的专家及其权重所在的位置。

尽管大规模专家并行(EP)能够降低激活专家的权重负载开销,但这一优势可能被 token-gather 群集带来的通信开销所抵消。这些群集需要整合来自分布式专家的输出,并对 token 进行重新排序,然后才能将其传递至下一个 Transformer 块或最终的 softmax 层。若缺乏 NVL72 所提供的 130 TB/s 聚合带宽,此类通信模式的复杂性和资源消耗将使得大规模 EP 难以实际应用。

使用 NCCL 优化内核以提升专家路由性能

MoE 通过路由机制为每个 token 动态选择合适的专家,这意味着每个 Transformer 模块在经过专家层后都需要对 token 进行调度与聚合。其中涉及的全连接通信操作容易加剧数据传输负担,进而在原本就受内存限制的解码阶段迅速引发性能瓶颈。

为应对这些挑战,采用自定义的 EP 通信内核至关重要。针对 GB200 NVL72 系统,我们实现了定制化内核,以解决 CUDA 图在多机架规模部署场景下的兼容性问题。特别地,该定制的高性能 NCCL 内核专为大规模 EP 部署设计,能够处理动态变化的数据规模。这些自定义 EP 内核可直接从 GPU 显存中获取通信数据大小,并充分利用 NVL72 的聚合显存能力。

广泛的专家负载均衡

负载均衡是一种典型的分布式系统技术,能够根据资源的可用性动态分配任务,从而提升资源利用率,同时避免系统中任何单一组件过载。在大规模专家并行(EP)工作负载中,负载均衡可用于在可用 GPU 之间合理分配专家。例如,在 GB200 NVL72 机架上运行 Wide-EP DeepSeek-R1 且 EP = 64(用于除法)时,每层将为每个 GPU 分配 4 名专家,使得每个 GPU 总共承担 232 名专家。

在负载均衡场景中,若一组高热度的“热门专家”集中运行在同一块 GPU 上,而其他搭载较低热度“冷专家”的 GPU 却处于空闲状态,便可能导致资源利用不均。为避免这一问题,Wide-EP 的专家并行负载均衡器(EPLB)采用一种策略,将热门专家与冷专家进行重新分配。该过程会触发权重更新,通过容器化架构实现专家在容器间的动态分配,确保在不破坏 CUDA 图执行的前提下完成专家的迁移。这些权重更新被安排在前向传播之间进行,以非阻塞方式执行,从而提升整体效率与系统灵活性。

EPLB 可以在两种不同模式下运行:

- 静态 EPLB:基于历史数据模式,预先计算专家到 GPU 的映射关系,以优化专家的分配策略。

- 在线 EPLB:在运行时动态调整专家与 GPU 的分配,实时响应工作负载的变化。

尽管静态 EPLB 相较于非 EPLB 方法已展现出显著的基准提升,但在线 EPLB 在实现高效实时负载均衡方面具有更大的潜力。在我们对在线 EPLB 的初步实现中,识别并解决了与实时权重更新过程相关的若干关键挑战。

使用 TensorRT-LLM 与 NVIDIA Dynamo 实现高效的 Wide-EP 方案

在大规模部署 DeepSeek R1 或 Llama 4 等 MoE 模型时,推理性能主要依赖于两个关键因素:模型细分服务与 Wide-EP。NVIDIA Dynamo 与 TensorRT-LLM 构成了实现这两项技术的软件基础,能够将传统性能瓶颈转化为提升吞吐量和优化 GPU 利用率的重要机遇。下表总结了 Dynamo 与 Wide-EP 之间的差异及其协同效应。

| 组件 | NVIDIA Dynamo | TensorRT-LLM Wide-EP |

| Role | 用于分解推理的编排层 | 支持专家并行解码的执行引擎 |

| Optimization Scope | 在 GPU 池中对预填充和解码阶段的调度 | 为每个 GPU 分配少量专家,提升每 token 的内存与计算资源利用率 |

| SLA Awareness | SLA 感知的自动扩缩容与动态速率匹配机制(涵盖 TTFT 与 ITL) | 增强批处理效率,实现低延迟 |

| Traffic Adaption | 通过 Dynamo Planner 实时响应 ISL/OSL 波动 | 优化计算资源利用率的专家分配负载平衡 |

| Hardware Synergy | 通过 Kubernetes + Planner 逻辑在分解 GPU 域中扩展 | 利用高带宽域(如 NVL72)实现高效的专家间通信 |

如需深入了解 NVIDIA Dynamo 与 TensorRT-LLM Wide-EP 之间的关系,建议阅读我们的博客,了解如何借助 NVIDIA Dynamo 实现高效的大规模专家并行。

性能和工作负载的经济效益表现如何?

当您能够访问 GB200 NVL72 机架中通过 NVLink 纵向扩展形成的一致性显存域时,优化大规模 EP 主要取决于以下几个关键因素:

- 模型规模与专家数量:规模较小且专家数量较少的模型从 Wide-EP 中获得的收益相对有限,因为通信开销可能抵消了权重负载分担和分布式计算所带来的优势。

- 系统延迟与并发需求:在吞吐量受限于延迟的场景下,大规模的专家并行更为有效,能够在保持相同延迟水平的同时提升每块 GPU 的吞吐能力。

- 硬件能力:系统的聚合内存带宽、GPU 间通信带宽以及可实现的计算性能共同决定了其能否达到理想的并行效率。

在实践中,像 DeepSeek-R1 这样的模型非常适用于大规模专家并行(EP)场景。在 GB200 NVL72 机架级扩展系统上,TensorRT-LLM 的 Wide-EP 方案在效率与吞吐量之间实现了良好的平衡。以下 Parito 前沿研究展示了不同 EP 配置下的性能表现。

与小型 EP 配置(EP8)相比,大型 EP 配置(EP32)可将每个 GPU 的吞吐量提升 1.8 倍,充分体现了通过扩展 EP 规模和采用 Wide-EP 来优化性能的潜力。此外,结合预测性解码与多 token 预测(MTP)技术,还能进一步提升每位用户的 token 吞吐量,该功能目前已支持与 Wide-EP 协同工作。

总结

基于 GB200 NVL72 的 Wide-EP 为扩展大规模 MoE 模型提供了一条切实可行的路径。通过将专家分配到更多的 GPU,能够有效缓解重载压力,提升 GroupGEMM 的计算效率,并充分利用 GB200 NVL72 高达 130 TB/s 的一致性 NVLink 带宽,从而抵消通信开销。测试结果显示,大型 EP 配置下的每 GPU 吞吐量较小型 EP 设置提升了 1.8 倍。这一改进优化了吞吐量、延迟与资源利用率之间的权衡,显著提升了大规模推理的整体效率。

更广泛的影响体现在系统经济学层面。通过提升并发性与GPU效率,NVL72上的Wide-EP能够增强每秒每GPU生成的token数量,从而降低大规模模型服务的总体成本。对开发者而言,这意味着可在TensorRT-LLM中探索Wide-EP,以寻找更优配置;对研究人员而言,它为优化调度策略、负载均衡以及解码方法提供了新的研究空间;对基础设施团队而言,它凸显了GB200 NVL72在部署万亿参数模型时对总拥有成本(TCO)结构的深远影响。

如需了解更多信息,可查看采用 GB200 NVL72 的大规模 EP 在最新的 InferenceMAX 基准测试中,如何实现优于其他系统架构的总拥有成本表现。

有关性能的最新洞察,请参阅 NVIDIA 推理性能控制面板。