TensorRT-LLM

2024年 5月 8日

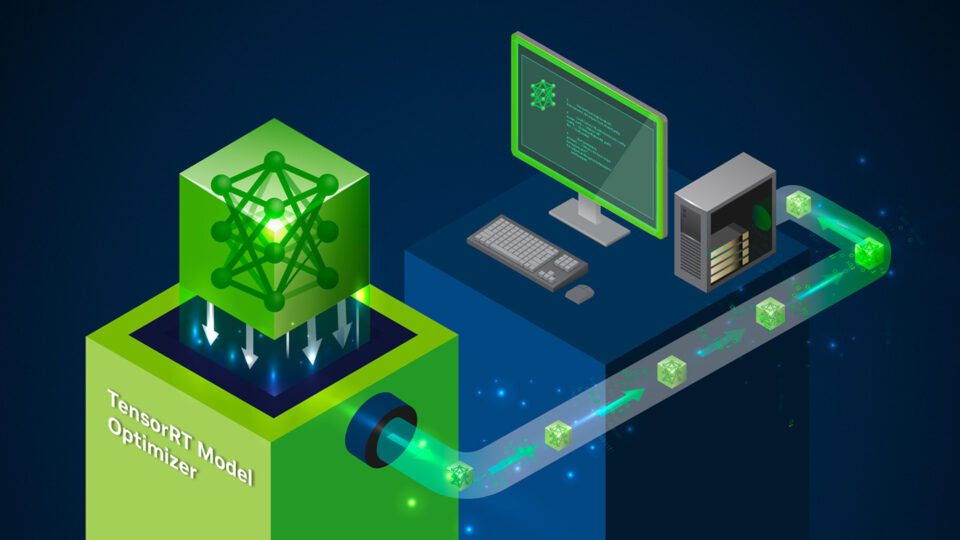

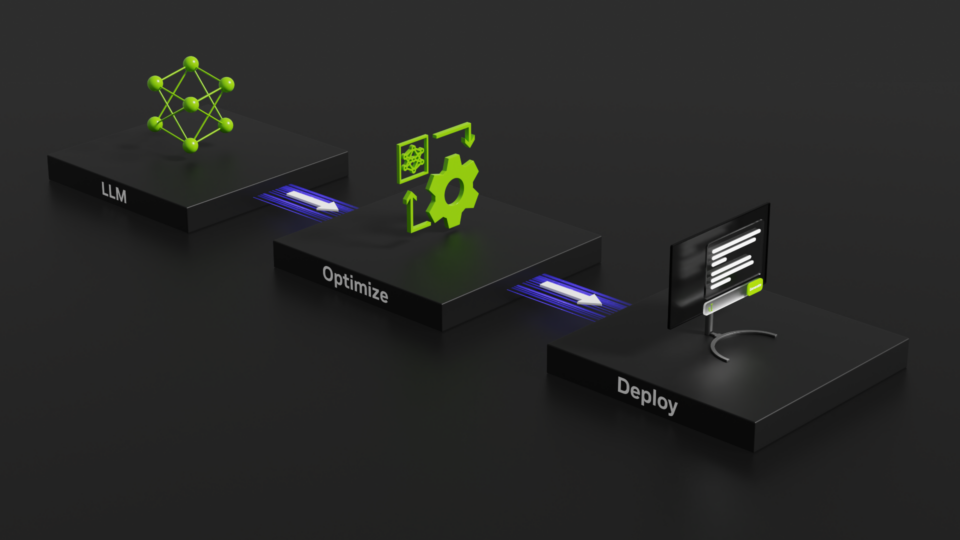

NVIDIA TensorRT 模型优化器加速生成人工智能推理性能,现已公开

在快速发展的环境中,生成人工智能的发展对加速推理速度的需求仍然是一个紧迫的问题。随着模型规模和复杂性的指数级增长,

3 MIN READ

2024年 4月 25日

NVIDIA GPU 架构下的 FP8 训练与推理

本文聚焦 NVIDIA FP8 训练与推理的实践应用,该内容来源于 2023 云栖大会 NVIDIA 专场演讲。 FP8 训练利用 E5M2/

5 MIN READ

2024年 3月 19日

FP8:前沿精度与性能的新篇章

在深度学习和人工智能的快速发展背景下,尤其是大语言模型(Large Language Model, LLM)的蓬勃发展,

3 MIN READ

2024年 1月 15日

使用 NVIDIA TensorRT-LLM 支持 CodeFuse-CodeLlama-34B 上的 int4 量化和推理优化实践

Codefuse(https://github.com/codefuse-ai)是由蚂蚁集团开发的代码语言大模型,

3 MIN READ

2023年 12月 19日

2023 年最热门的 NVIDIA 技术博客文章:生成式 AI、LLM、机器人开发和虚拟世界的突破

在 NVIDIA 激动人心的又一年即将结束之际,是时候回顾 2023 年 NVIDIA 技术博客中最热门的案例了。 生成式 AI、

2 MIN READ