随着 AI 模型规模不断扩大且处理的文本序列越来越长,效率变得与规模同样重要。

为展示未来趋势,阿里巴巴发布了两款新开源模型 —— Qwen3-Next 80B-A3B-Thinking 与 Qwen3-Next 80B-A3B-Instruct,为研究者和开发者社区提供对新型混合专家模型 (MoE) 架构的预览。

Qwen3-Next-80B-A3B-Thinking 现已在 nvidia.cn/ai 平台上线,开发者可通过用户界面直接测试其先进的推理能力。

这两个 Qwen3-Next 模型所采用的新架构针对长上下文长度(输入 Token 达到 26 万以上)和大规模参数的效率进行了优化。每个模型总参数规模达 800 亿,但凭借其稀疏 MoE 结构,每个 Token 仅激活 30 亿参数,从而以小模型的效率实现了大模型的强大性能。MoE 模块包含 512 个路由专家和 1 个共享专家,每个 Token 激活 10 个专家。

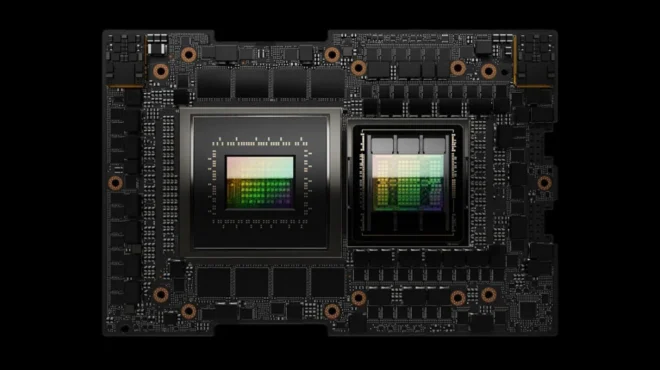

像 Qwen3-Next 这类需在 512 个专家间传送请求的 MoE 模型,其性能高度依赖 GPU 间通信。Blackwell 第五代 NVLink 提供 1.8TB/s 的 GPU 直连带宽,这种高速网络架构能大幅降低专家传送过程中的延迟,直接提高 AI 工厂的推理速度和 Token 吞吐量。

该模型分为 48 层,每 4 层 Transformer Layer 采用一次分组查询注意力机制 (GQA),其余三层则使用新型线性注意力机制。大语言模型 (LLM) 通过注意力层解析输入序列中的每个 Token 并赋予权重。当前的软件栈没有针对 Mamba2 等新型架构的预优化基础组件,也没有实现针对不同注意力机制以固定频率切换的融合技术。

为实现处理长上下文输入的能力,模型采用了 NVIDIA Research 与 MIT 研发的 Gated Delta Networks。该技术通过优化序列处理,使模型能够高效处理超长文本而不偏离或遗忘关键信息。这使模型能够高效处理极长序列,且内存与计算资源消耗几乎与序列长度呈线性增长关系。

除上述架构创新外,该模型还可在 NVIDIA Hopper 和 Blackwell 平台上运行以提高推理性能。NVIDIA 灵活的 CUDA 编程架构既支持传统 Transformer 模型的全注意力层和 Mamba2 模型中的线性注意力层,又便于探索新方法。在 NVIDIA 平台上运行时,Qwen3-Next 模型采用的混合方法可显著提升效率,为 AI 工厂提高 Token 生成量与收入创造条件。

NVIDIA 与开源框架 SGLang 和 vLLM 合作,共同帮助社区部署模型并将这两个模型打包为 NVIDIA NIM。开发者可以根据需要,通过企业级软件容器来使用先进的开源模型。

使用 SGLang 部署

使用 SGLang 服务框架部署模型的用户可参考以下指令。更多信息和配置选项详见 SGLang 文档。

python3 -m sglang.launch_server --model Qwen/Qwen3-Next-80B-A3B-Instruct --tp 4

使用 vLLM 部署

使用 vLLM 服务框架部署模型的用户可参考以下多 GPU 启动的基础指令。更多信息详见 vLLM Qwen3-Next 使用指南。

uv venv

source .venv/bin/activate

uv pip install vllm --extra-index-url https://wheels.vllm.ai/nightly

vllm serve Qwen/Qwen3-Next-80B-A3B-Instruct \

--tensor-parallel-size 4 \

--served-model-name qwen3-next

使用 NVIDIA NIM 进行生产就绪部署

企业开发者可通过 nvidia.cn/ai 中 NVIDIA 托管的 NIM 端点,体验 Qwen3-Next-80B-A3B 及其他 Qwen 模型。

基于开源 AI 的强大力量

新的混合 MoE 架构 Qwen3-Next 推动了效率和推理能力的边界,标志着社区的重要进步。将这些模型开源,赋予全球的研究人员和开发者以此尝试、构建和加速创新的能力。在 NVIDIA,我们通过分享如用于 AI 生命周期管理的 NeMo、Nemotron 大语言模型 (LLM) 以及 Cosmos 世界基础模型 (WFMs),践行对开源的承诺。我们与社区共同协作,推动 AI 的发展。通过这些努力,确保未来的 AI 模型不仅更加强大,同时也更加开放、透明和协作。

立即开始

在 Open Router 上体验:Qwen3-Next-80B-A3B-Thinking 和 Qwen3-Next-80B-A3B-Instruct,或者从 Hugging Face 下载:Qwen3-Next-80B-A3B-Thinking 和 Qwen3-Next-80B-A3B-Instruct。