人工智能正在改变计算方式,推动AI在全球范围内的应用部署。智能聊天机器人、图像和视频合成的简单文本提示、个性化内容推荐以及医学成像只是人工智能应用的几个例子。

推理工作负载对计算要求很高,而且多种多样,要求平台能够快速处理从未见过的数据上的许多预测,并在各种人工智能模型上运行推理。希望部署人工智能的组织需要一种方法,在各种工作负载、环境和部署场景中客观评估基础设施的性能。人工智能训练和推理都是如此。

MLPerf 推理 v3.1 是由 MLCommons 联盟开发的最新版本,它是行业标准的人工智能推理基准套件。这个版本补充了 MLPerf 培训和 MLPerf HPC。MLPerf 推理 v3.1 能够衡量各种重要工作负载的推理性能,包括图像分类、对象检测、自然语言处理、语音识别和推荐系统,以及常见的数据中心和边缘部署场景。

MLPerf 推理 v3.1 包括两个重要的更新,以更好地反映现代人工智能用例:

- 添加大语言模型(LLM)测试,基于 GPT-J——一种开源的 6B 参数 LLM——来表示文本摘要的生成式人工智能。

- 更新的 DLRM 测试具有新的模型架构和更大的数据集,这些都反映了在 MLPerf Training v3.0 中引入的 DLRM 更新,更好地反映了现代推荐系统的规模和复杂性。

由完整的NVIDIA AI Inference software stack,包括最新的 TensorRT 9.0,NVIDIA 在 MLPerf 推理 v3.1 中使用了广泛的产品进行提交。其中包括首次提交的NVIDIA GH200 Grace Hopper Superchip,扩展了NVIDIA H100 Tensor Core GPU。NVIDIA 还提交了NVIDIA L4 Tensor Core GPU对于主流服务器,以及NVIDIA Jetson AGX Orin 和 Jetson Orin NX边缘人工智能和机器人平台。

这篇文章的其余部分提供了 NVIDIA 提交的精彩内容,以及这些非凡成果是如何实现的。

Grace Hopper 超级芯片扩展 NVIDIA Hopper 推理性能

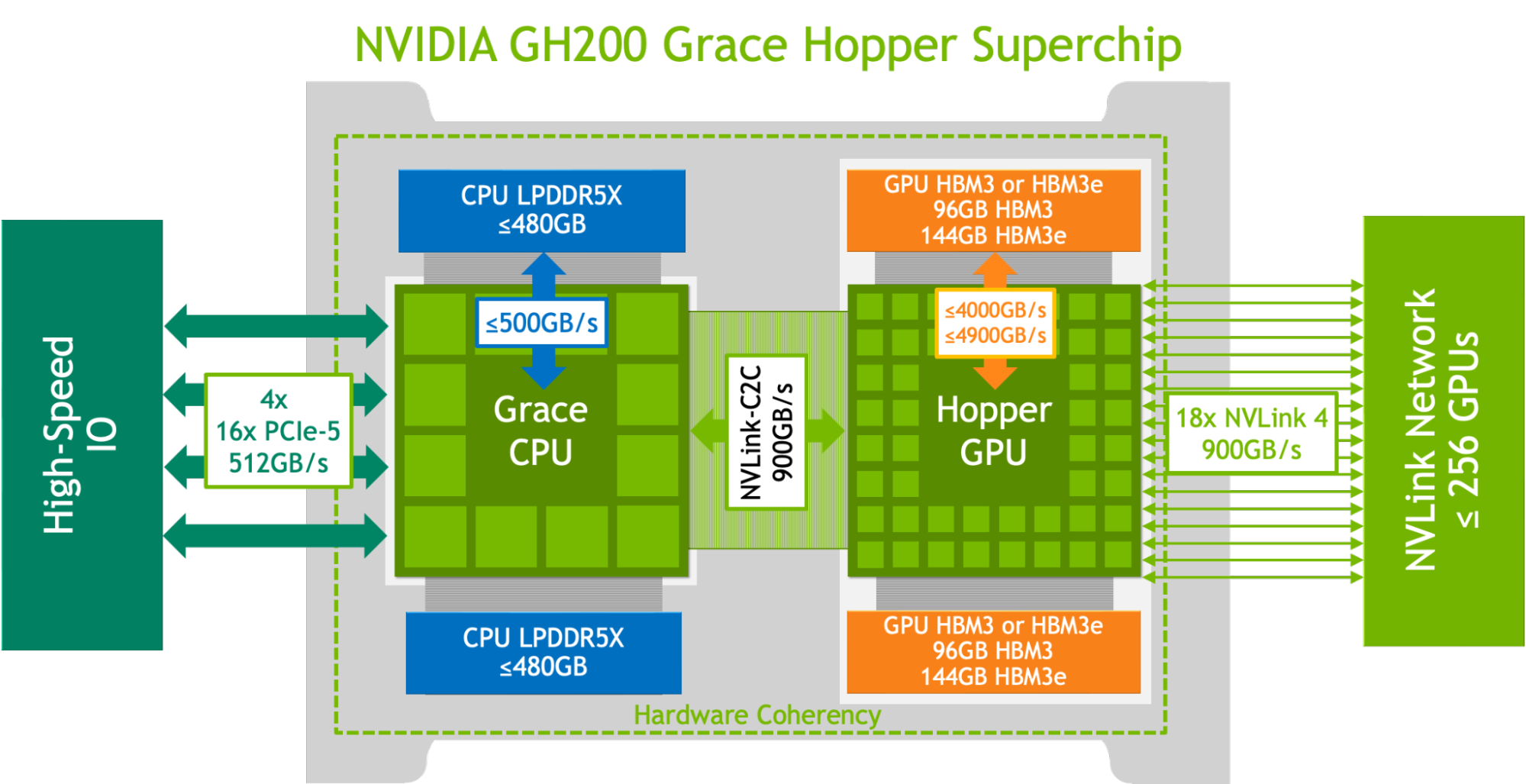

NVIDIA GH200 Grace〔Hopper〕超级芯片通过相干 NVLink-C2C 结合了 NVIDIA Hopper GPU 和 NVIDIA Grace CPU,以 900 GB/s 的速率创建单个超级芯片。这比 PCIe Gen5 高 7 倍,功耗降低 5 倍。此外,它还通过 96 GB HBM3 GPU 内存和 480 GB 低功耗、高带宽 LPDDR5X 内存的组合,集成了高达 576 GB 的快速访问内存。

GH200 Grace Hopper 超级芯片具有集成电源管理功能,使 GH200 能够利用 能源效率 的 Grace CPU,以平衡效率和性能。有关详细信息,请参阅 NVIDIA Grace Hopper 超级芯片架构深度解析 以及 NVIDIA Grace Hopper 超级芯片架构 白皮书。

这个 NVIDIA GH200 Grace Hopper Superchip 是专为在计算和内存密集型工作负载中提供领先性能所需的多功能性而设计的。它还在最苛刻的前沿工作负载上提供了更高的性能,例如基于 transformer 的大型模型(具有数千亿或数万亿参数)、具有数万亿字节嵌入表的推荐系统和矢量数据库。

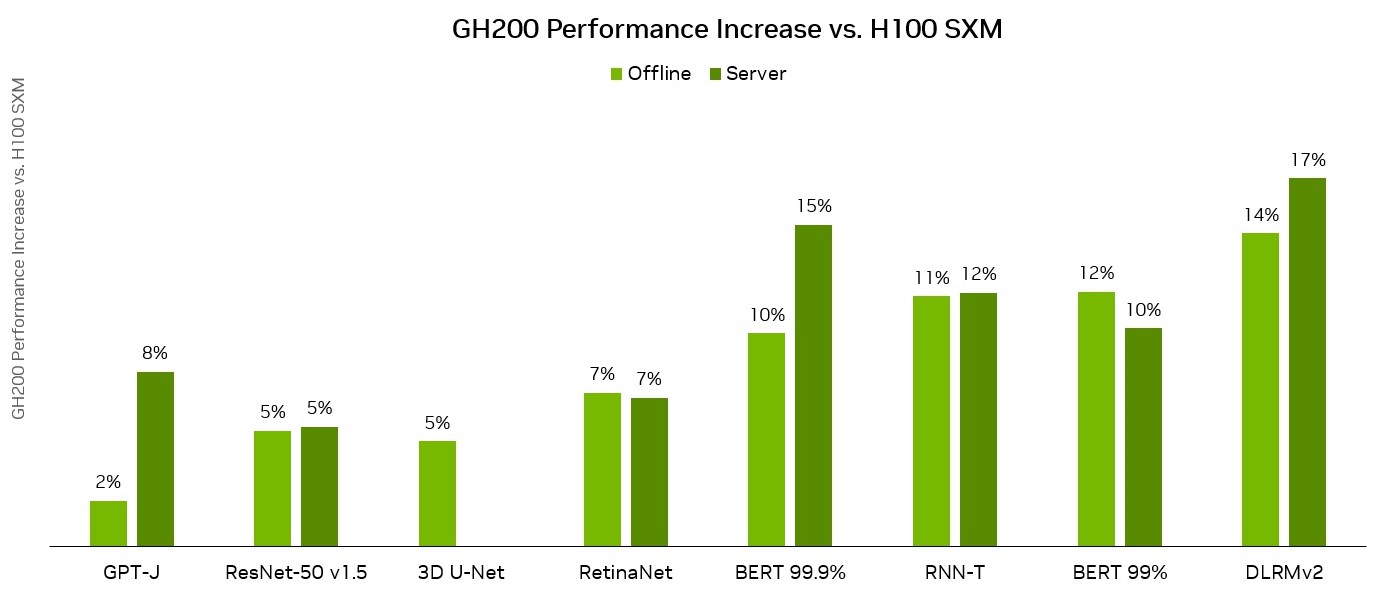

GH200 Grace Hopper 超级芯片除了针对最密集的人工智能工作负载而构建外,还针对 MLPerf 推理测试的流行主流工作负载而大放异彩。它运行了每一次测试,展示了它对完整 NVIDIA 软件堆栈的无缝支持。它扩展了 NVIDIA 在每个工作负载上提交的单个 H100 SXM 所实现的卓越性能。

MLPerf 推断:Datacenter v3.1,已关闭。提交 ID: NVIDIA 3.1-0107(1xH100 SXM),3.1-0110(1xGH200 Grace Hopper 超级芯片)

MLPerf 的名称和标志是 MLCommons 协会在美国和其他国家的商标。保留所有权利。未经授权,严禁使用。更多详细信息,请访问www.mlcommons.org。

GH200 Grace Hopper 超级芯片包含 96 GB 的 HBM3,并提供高达 4 TB/s 的 HBM3 内存带宽,而 H100 SXM 分别为 80 GB 和 3.35 TB/s。与 NVIDIA H100 SXM 相比, NVIDIA GH200 Grace Hopper 超级芯片的更大内存容量和更大的内存带宽使其能够为工作负载使用更大的批量。例如,在服务器场景中,RetinaNet 和 DLRMv2 的批处理大小都增加了一倍,在离线场景中,批处理大小增加了 50%。

GH200 Grace Hopper 超级芯片 NVIDIA Hopper GPU 和 Grace CPU 之间的高带宽通过 NVLink-C2C 链路实现了 CPU GPU 之间的快速通信,这有助于提高性能。

例如,在 MLPerf DLRMv2 工作负载中,通过 PCIe 传输一批张量占用 H100 SXM 上大约 22%的批推断时间。然而,由于 NVLink-C2C,GH200 Grace Hopper 超级芯片仅使用 3%的推理时间进行了相同的传输。

由于具有更高的内存带宽和更大的内存容量,与 MLPerf 推理 v3.1 工作负载上的 H100 GPU 相比,Grace Hopper 超级芯片的每芯片性能优势高出 17%。这些结果展示了 GH200 Grace Hopper 超级芯片和 NVIDIA 软件堆栈的性能和多功能性。

优化 GPT-J 6B 用于 LLM 推理

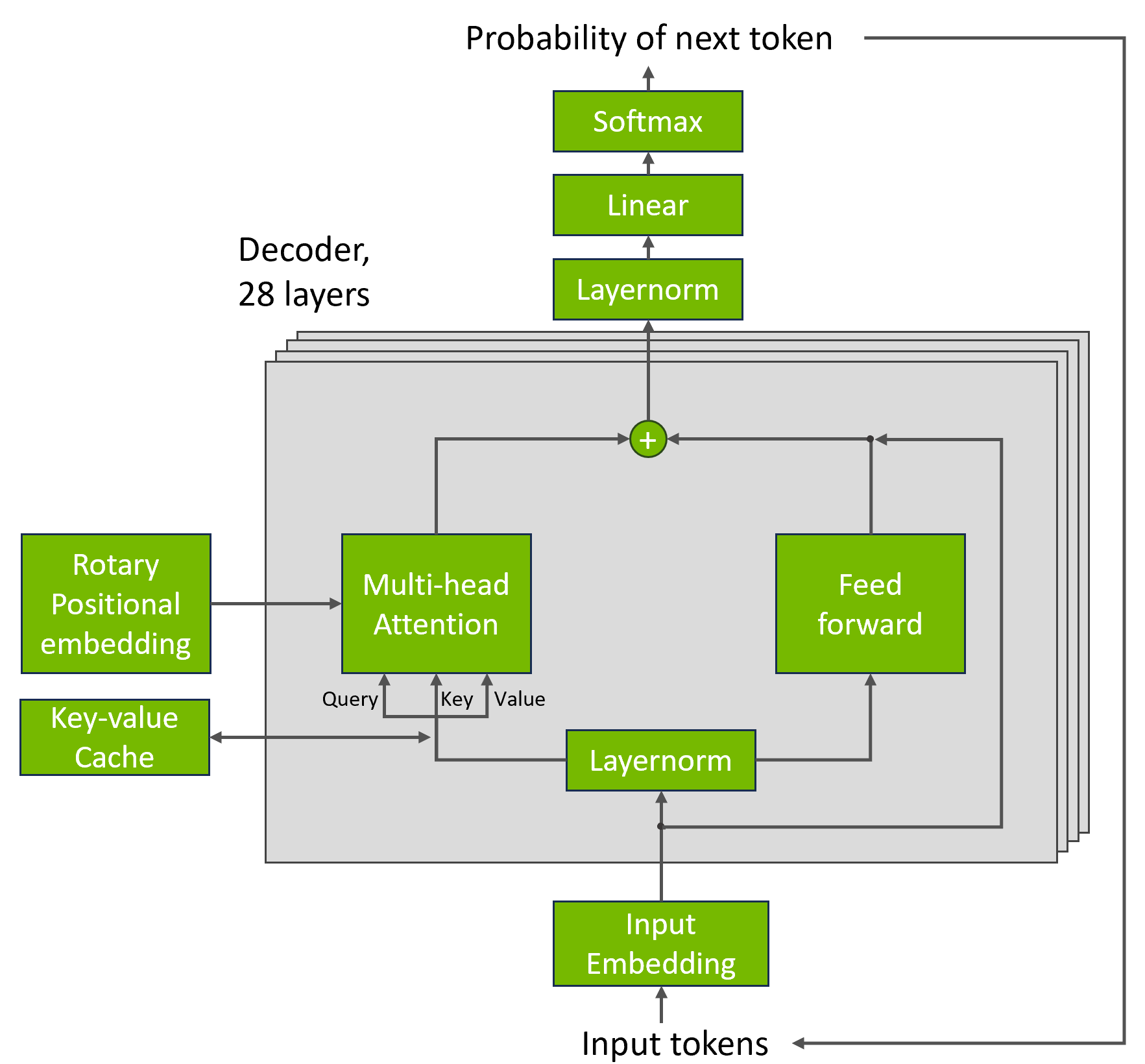

为了表示 LLM 的推理工作负载,MLPerf 推理 v3.1 引入了一种基于 GPT-J 6B 模型的新测试:具有 6B 参数的 LLM。新基准测试的任务是使用CNN / DailyMail 数据集。

NVIDIA 平台在 GPT-J 工作负载方面取得了优异的成绩,GH200 Grace Hopper Superchip 在离线和服务器场景中的每加速器性能都达到了最高水平。 NVIDIA L4 GPU 还提供了强大的性能,超过了最好的 CPU ——在热设计功率(TDP)仅为 72 瓦的 1 插槽 PCIe 卡中,仅获得 6 倍的性能。

为了实现这些结果,用于 LLM 推理的 NVIDIA 软件智能地应用 FP8 和 FP16 精度,以提高性能,同时满足目标精度要求。

执行 GPT-J 推断的关键挑战是 transformer 块中的键值(KV)高速缓存的高内存消耗。通过以 FP8 数据格式存储 KV 缓存, NVIDIA 提交显著增加了所使用的批处理大小。这提高了 GPU 内存利用率,并能够更好地利用 NVIDIA GPU 巨大的计算性能。

启用 DLRM-DCNv2 提交

MLPerf 推理 v3.1 引入了对基准测试先前版本中使用的 DLRMv1 模型的更新。这个 DLRMv2 模型采用了三层DCNv2 cross network。DLRMv2 还使用多个 hot 分类输入,而不是一个 hot,这些输入来自Criteo Terabyte Click Logs Dataset。

推荐推理的挑战之一来自于在系统上拟合嵌入表。通过将模型转换为 FP16 精度,包括嵌入表,我们既可以提高性能,又可以将嵌入表的内存占用减半,将其减少到 49GB。这使得整个嵌入表能够适应单个 H100 GPU 。

为了使我们能够在具有 24GB 内存的 L4 GPU 上提交, NVIDIA 软件使用通过分析训练数据集获得的行频率数据,智能地在 GPU 和主机内存之间分割嵌入表。使用这些数据, NVIDIA 软件可以通过在 GPU 上存储最常用的嵌入表行,最大限度地减少主机 CPU 和 GPU 之间的内存传输。

NVIDIA 平台在 DLRMv2 上展示了非凡的性能,GH200 与 H100 SXM 相比,性能提升了 17%。

使用可编程视觉加速器最大限度地提高 NVIDIA Jetson Orin 的并行性

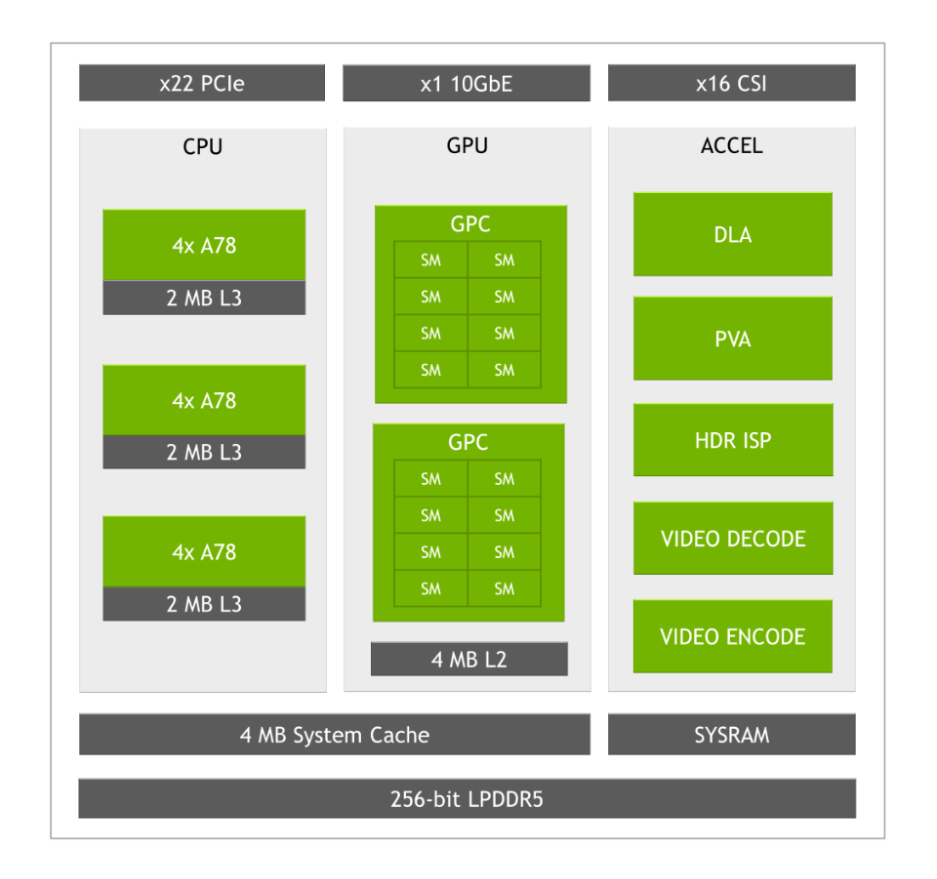

Jetson AGX Orin series and Jetson Orin NX series 是基于 NVIDIA Orin 片上系统(SoC)的边缘人工智能和机器人的嵌入式模块。为了在一系列用例中提供卓越的人工智能性能和效率,Jetson Orin 集成了许多计算引擎:

- A GPU 基于 NVIDIA Ampere Architecture,具有第三代张量核心。

- 两个第二代,固定功能的 NVIDIA Deep Learning Accelerators(NVDLA v2.0)

- 一个第二代可编程视觉加速器(PVA v2.0)。

这些加速器可用于卸载 GPU ,并在 Jetson Orin 模块上实现额外的 AI 推理性能。

NVDLA 是一款针对深度学习操作进行优化的固定函数加速器,旨在实现卷积神经网络推理的全硬件加速。

在 MLPerf 推理 v3.1 中,我们首次证明了 PVA 与 GPU 和 DLA 同时用于推理。第二代 PVA 为各种计算机视觉内核提供了专用硬件,如滤波、扭曲和快速傅立叶变换(FFT)。它还支持高级编程内核,可以作为 TensorRT 自定义插件的后端运行时。

在 23.08 Jetson CUDA -X AI 开发者预览版中,我们包含了一个示例 PVA SDK。此包为非最大值抑制(NMS)层提供运行时支持。这表明 PVA 可以作为一种高效的加速器,补充强大的 Jetson Orin GPU 。

NVIDIA 开发了一个 TensorRT 自定义 NMS-PVA 插件,作为 Jetson Orin 用户的参考,并将其作为 NVIDIA MLPerf 推理 v3.1 提交的一部分。

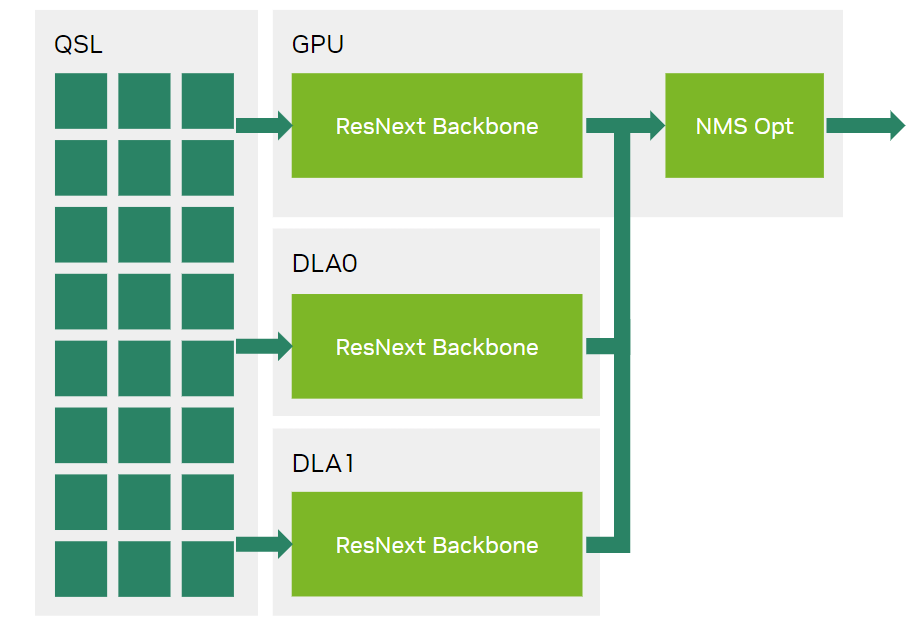

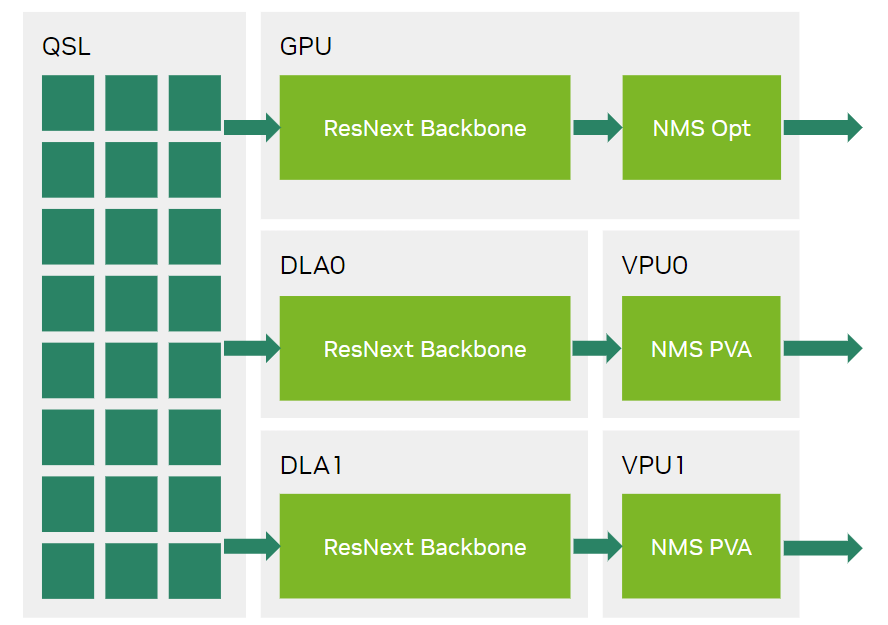

在 NVIDIA Orin 平台上提交的 NVIDIA MLPerf 推理 v3.0 RetinaNet 中, GPU 处理了来自 GPU ResNext+FPN 骨干网以及两个 DLA 的所有输出。

图 5 显示了在 MLPerf 推理 v3.0 提交中, GPU 是如何负责 GPU 和 DLA 的 ResNext+FPN 主干的输出的。

通过使用 NMS-PVA 插件,NMS 操作员现在可以从 GPU 卸载到 PVA,从而在 Jetson Orin AGX 和 Jetson Orin NX 上实现三个完全并行的推理流。在两个 DLA 上运行的 ResNext 和 FPN 骨干网的输出现在由在端到端 RetinaNet TensorRT 引擎内运行 NMS-PVA 插件的两个 PVA 消耗。

在图 6 中, NVIDIA MLPerf 推理 v3.1 提交通过优化使用 Jetson Orin PVA,使计算能够完全并行运行。

PVA 与 GPU 和 DLA 的精心使用将 Jetson AGX Orin 64GB 和 Jetson Orin NX 16GB 模块的性能提高了 30%。当 PVA 的这种使用与新优化的 NMS-Opt GPU 插件相结合时, Jetson AGX-Orin 在 RetinaNet 工作负载上的性能提高了 61%,功率效率提高了 38%。 Jetson Orin NX 16GB 显示出更大的增益,在同一测试中性能提升了 84%。

算法优化进一步提高 BERT 性能

在 MLPerf 推理 v3.1 中, NVIDIA 使用 OmniML 团队开发的技术,在开放部门中使用 L4 GPU 提交了关于 BERT 大型工作负载的报告。OmniML 是 NVIDIA 于 2023 年初收购的一家初创公司,为从云平台到边缘设备的用例带来了机器学习算法模型优化方面的专业知识。

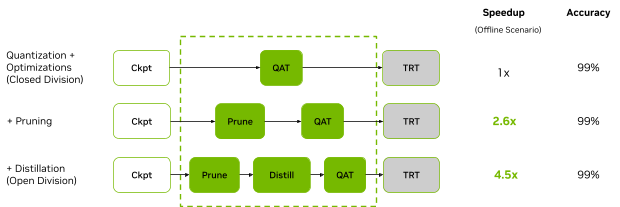

BERT 上的开放划分提交应用了结构化修剪和蒸馏技术,在保持 99%准确率的同时,将性能提高了 4.7 倍。本次提交展示了算法优化的潜力,可以显著增强 NVIDIA 平台本已卓越的性能。

NVIDIA 部署了一种专有的自动结构化修剪工具,该工具使用基于梯度的灵敏度分析将模型修剪为给定的目标 FLOP,并通过蒸馏对其进行微调,以恢复大部分精度。在保持嵌入维度不变的情况下,在模型中的所有 transformer 层中修剪 transformer 层的数量、注意力头和线性层维度。

与原始的 MLPerf 推理 BERT INT8 模型相比,我们的修剪模型将参数数量减少了 4 倍,FLOP 数量减少了 5.6 倍。该模型在每层中具有不同数量的头部和线性层尺寸。根据修剪后的模型构建的 TensorRT 发动机比 607 MB 小 3.4 倍,177 MB。

使用 NVIDIA 闭除法提交中使用的相同技术,将微调模型量化为 INT8 精度。提交的文件还采用了量化感知训练(QAT)期间的蒸馏,以实现 99%或更高的准确性。

| 脚本 | 封闭式分部 | 开放式部门 | 加速 |

| 脱机采样/秒 | 1029 | 4609 | 4.5 倍 |

| 服务器采样数/秒 | 899 | 4265 | 4.7 倍 |

| 单流 p90 延迟(ms) | 2.58 | 0.82 | 3.1 倍 |

为了更好地了解每个模型优化如何影响性能, NVIDIA 进行了堆叠分析,并分别应用了不同的模型优化方法(图 8)。

图 7 显示,通过模型修剪和蒸馏,与在离线场景中运行相同的 GPU 相比,使用 L4 的 NVIDIA 对 BERT 工作负载的开放划分提交提供了 4.5 倍的加速。

应用的每种模型优化方法都可以很容易地相互集成。与基线模型相比,它们共同带来了显著的性能改进。

NVIDIA 加速计算提升推理和 AI 训练工作负载的性能

在其 MLPerf 首秀中,GH200 Grace Hopper 超级芯片在数据中心类别的封闭部门的所有工作负载和场景中都表现出色,在 NVIDIA 单芯片 H100 SXM 提交的产品中,性能提高了 17%。 NVIDIA 软件堆栈目前完全支持 GH200 Grace Hopper 超级芯片。

对于主流服务器,L4 GPU 在紧凑、低功耗的 PCIe 附加卡中实现了对 CPU 的巨大性能飞跃。

对于边缘 AI 和机器人应用, Jetson AGX-Orin 和 Jetson Orin-NX 模块实现了出色的性能。软件优化有助于进一步释放为这些模块提供动力的强大 NVIDIA Orin SoC 的潜力。它将广受欢迎的物体检测人工智能网络 RetinaNet 的性能提高了 84%。

在这一轮中, NVIDIA 还提交了开放部门的结果,首次展示了模型优化的潜力,以显著提高推理性能,同时仍能实现卓越的准确性。

最新的 MLPerf 推理 v3.1 基准测试表明, NVIDIA 加速计算平台继续提供领先的性能和多功能性。技术堆栈的每一层都有创新,从云到边缘,以光速。