生成式 AI 正在彻底改变各行各业的组织利用数据来提高生产力、推进个性化客户互动并促进创新的方式。鉴于其巨大的价值,企业正在寻找工具和专业知识,以帮助他们有效、可靠地将这项新技术集成到其业务运营和战略中。

NVIDIA 和 Microsoft 携手合作,利用 NVIDIA AI on Azure Machine Learning (Azure ML),为企业提供用于构建、优化和部署 AI 应用程序(包括生成式 AI)的全面解决方案。

在本周的 Microsoft Ignite 上, NVIDIA 和 Microsoft 宣布了另外两个里程碑,为 Azure ML 带来管理生产级 AI 和开发生成式 AI 应用的新功能。

- NVIDIA NeMo 是一个用于构建和自定义生成式 AI 模型的框架,而 NVIDIA AI 基础模型 则包括了新的 NVIDIA Megatron-3 8B 系列,这些模型在 Azure 机器学习模型目录中均可获取。

- NVIDIA Triton 推理服务器 用于在生产环境中扩展 AI 应用,通常可在 Azure ML 管理的端点中使用。

6 月,我们发布了一篇博文,解释了 NVIDIA AI Enterprise 软件与 Azure 机器学习集成 的详情及入门指南。本文介绍了 NVIDIA 和 Azure 团队所取得的进展,阐述了两种新集成的优势,以及如何访问这些集成的步骤。

Azure 机器学习模型目录中的 NeMo 框架集成

由于 LLM 能够执行文本摘要、语言翻译和文本生成等各种任务,因此备受关注。作为模型权重或 API 提供的开源和专有 LLM 使用不同的生成式 AI 框架在大型数据语料库上进行预训练。

使用生成式 AI 框架为特定领域的见解量身定制的自定义 LLM 在企业领域的吸引力也越来越大。

NeMo 是一个端到端的云原生企业框架,供开发者构建、自定义和部署具有数十亿参数的生成式 AI 模型。它包括训练和推理框架、护栏工具包、数据管护工具和预训练模型,为企业提供了一种简单、经济高效且快速的采用生成式 AI 的方法。

对于安全、优化的全栈解决方案,该解决方案旨在通过支持、安全性和 API 稳定性来加速企业发展,NeMo 可作为 NVIDIA AI Enterprise 的一部分提供。Azure ML 客户现在可以通过无代码流中的用户界面进行自定义、优化和部署。客户还可以直接从 NVIDIA 获得有关其生成式 AI 项目的支持,包括性能和准确性的最佳实践。

随着 NVIDIA Nemotron-3 8B 系列基础模型和 Azure 机器学习模型目录中的 NeMo 框架的推出,用户现在可以访问、自定义和部署这些开箱即用的模型。该框架提供了多种自定义技术选择,并针对语言和图像应用的模型大规模推理进行了优化。

Azure ML 管理端点中的 Triton 推理服务器集成

Triton 推理服务器是一款多框架开源软件,可针对实时、批量和流式传输等多种查询类型优化推理。Triton 还支持模型集成,并包含在 NVIDIA AI Enterprise 中。Triton 与各种机器学习框架兼容,例如 TensorFlow、ONNX Runtime、PyTorch 和 NVIDIA TensorRT.它可用于 CPU 和 GPU 工作负载。

Triton 适用于 Azure ML,可提供动态批处理、并发执行和优化模型配置。此外,它还通过 Azure ML 中的 NVIDIA AI Enterprise 提供企业级安全性、可管理性和 API 稳定性。

借助 Azure ML 管理端点,企业可以轻松监控、部署和扩展 AI 模型,降低设置和管理自己的 AI 基础设施的复杂性。

通用版本基于生产分支,由 NVIDIA AI Enterprise 独家提供。生产分支为基于 NVIDIA AI 构建的应用程序提供稳定性和安全性,提供 9 个月的支持、API 稳定性以及针对软件漏洞的每月修复。了解更多详情,请访问生产分支。

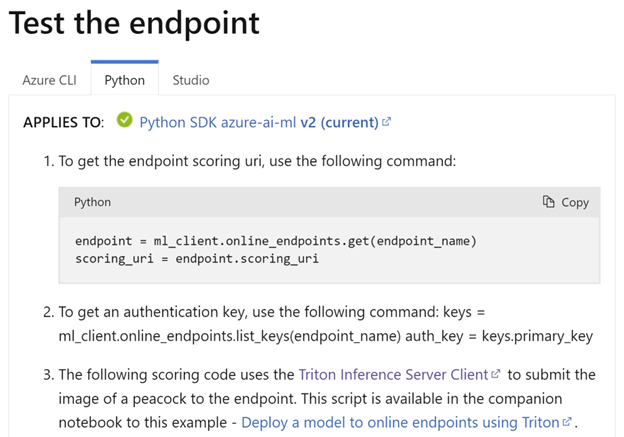

开始使用 Triton 推理服务器

在 Azure ML 管理的端点上,在 Triton 推理服务器中部署模型非常简单。观看以下视频,并按照列出的 5 个步骤获取指导。

- 在 Azure Machine Learning 中,转到“Models”(模型)并以 Triton 格式注册您的模型。确认类型为“Triton”。

- 转到 Endpoints 并点击“Create”(创建)按钮以创建实时在线端点。选择“Triton”服务器进行部署。

- 配置您的部署参数,然后单击“Next”(下一步)按钮。在“Environment”(环境)部分中,预先选择了环境和评分脚本。继续并单击“Next”(下一步)按钮。

- 确认模型和环境,然后单击“Create”(创建)按钮以部署模型推理。

- 查看测试页面。

开始使用 NVIDIA Azure 机器学习

将 NVIDIA AI Enterprise 和 Azure 机器学习相结合,可创建强大的 GPU 加速计算和基于云的全面机器学习平台,使企业能够更高效地开发和部署 AI 模型。企业可以通过这种协同作用利用云资源以及 NVIDIA GPU 和软件的性能优势。

欢迎访问 NVIDIA 在 Microsoft Ignite 的页面,详细了解推动 AI 和云计算未来发展的新创新和合作。

参加我们的赞助商会议,深入了解突破性的 NVIDIA 解决方案,或驻足参观我们的动车组演示空间 #311。查看 NVIDIA 展示页面 了解更多信息。

准备好立即开始使用了吗?查看 NVIDIA AI 基础模型、Azure 机器学习模型目录和 NVIDIA Triton 推理服务器中的 NeMo 框架,以及 Azure ML 端点。