AI 智能体现在已经能够解决多步骤问题、编写生产级代码并在多个领域担任通用助手。但要充分发挥其潜力,还需要在控制成本的前提下加入先进的逻辑推理模型。

NVIDIA Nemotron 系列在生态系统中强大的开放模型基础上,通过使用 NVIDIA 开源合成数据集、先进的技术以及工具,进一步提升了模型的准确性、效率和透明度。使得创建实用、适配、高性能的 AI 智能体成为了可能。

该系列最新发布的 Llama Nemotron Super 48B v1.5 版本在保持高吞吐量和计算效率的情况下,显著提升了在数学、科学、编码、函数调用、指令跟随、对话等核心逻辑推理与代理任务中的性能。

该模型现已位居 Artificial Analysis Intelligence Index 排行榜榜首。

本文将详细介绍这一最新 NVIDIA Nemotron 模型的准确性与推理性能、训练方法、数据透明度、架构优化及部署选项。

Llama Nemotron Super v1.5 领跑 Artificial Analysis 排行榜

新模型采用与原 Llama Nemotron Ultra v1 相同的方法构建而成,但使用了更多高质量的逻辑推理数据来进一步进行优化和训练后微调。

该模型凭借在多项逻辑推理和代理任务中展现出的领先性能,问鼎 Artificial Analysis Intelligence Index 排行榜。排行榜汇集 MMLU-Pro、GPQA Diamond、Humanity’s Last Exam、LiveCodeBench、SciCode、AIME 和 MATH-500 等基准测试的准确率数据。

图 1. Artificial Analysis Intelligence Index 排行榜

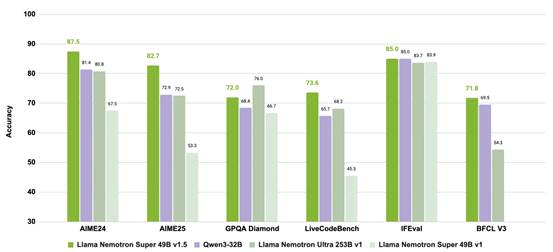

根据第三方在一系列行业标准逻辑推理及指令和函数调用任务基准测试中的评估,Llama Nemotron Super v1.5 在高等数学、编码、逻辑推理和对话指标上的表现优于其他开放模型,使其稳居 700 亿参数级模型榜首。

图 2. Llama Nemotron Super v1.5 为逻辑推理和代理任务提供更高的准确性

除了在逻辑推理和代理能力上领先外,该模型还使用能够提高吞吐量性能 (Neural Architecture Search, 神经架构搜索) 的后训练方法,大幅提升了吞吐量。

图 3. Llama Nemotron Super v1.5 为代理任务提供更高的准确性和吞吐量,降低了推理成本

最终得到了一个适合在单个 NVIDIA Hopper 架构 GPU 上运行的高性能模型,使开发者能够开发出更加有效和高效的代理系统。

专为逻辑推理和代理工作负载开发

Llama Nemotron Super v1.5 使用多项 NVIDIA 核心技术开发而成:

Llama Nemotron 后训练开源数据集

该数据集完全通过合成数据生成技术创建而成,其使用了 Qwen3 235B 和 DeepSeek R1 671B 0528 等先进的逻辑推理模型。它使团队能够生成超过 2,600 万行高质量的函数调用、指令跟随、逻辑推理、对话、数学和代码数据。

发布该数据集使我们能公开透明地展示模型训练的具体内容,让开发者和企业更加放心地选择 Llama Nemotron Super v1.5 作为其代理系统的引擎。

除了公开透明外,发布该数据集还使开发者在自行开发模型时无需投入大量的时间和精力去生成高质量数据集,降低了开发新型高性能模型的门槛。

该数据集即将在 Hugging Face 上发布,可通过数据集卡片获得更详细的信息。

后训练流程

如此前文章所述,后训练流程如下:

图 4. Llama Nemotron Super v1.5 后训练流程

团队利用强化学习将该模型性能提高到极限,以此实现了上述逻辑推理能力。该模型经过了多道后训练流程,所有流程均针对需要提升的能力定制,包括监督式微调 (SFT) 以及:

1. 奖励感知偏好优化 (RPO):使用 NVIDIA 先进的奖励模型提升对话能力

2. 直接偏好优化 (DPO):用于提升工具调用的能力

3. 可验证奖励强化学习 (RLVR):用于提升指令执行、数学、科学等能力

这套全面的后训练流程确保模型的每项能力都得到了训练,将逻辑推理准确性推向了新高度。

团队还使用了 NeMo Skills 评估和验证模型检查点,加快了迭代速度和研究周期,并实现可复现性。

以 NIM 形式提供 Llama Nemotron Super v1.5

Llama Nemotron Super v1.5 很快将作为 NVIDIA NIM 提供,以便快速、可靠地将其部署到首选的 NVIDIA 加速基础设施上。用户只需使用几行简单命令就能完成部署,并且能够直接集成兼容 OpenAI API 的私有端点,以提升 AI 智能体和逻辑推理应用的性能。此外,Llama Nemotron Super 的强大推理性能可根据需求自动扩展。

开始使用 Llama Nemotron Super v1.5

Llama Nemotron Super v1.5 模型在保持计算效率的同时,还提供强大的逻辑推理能力。它能够驱动从个人开发者到大型企业的各类代理应用。

现可先在 NVIDIA 官网上试用模型。如要对模型进行测试,可通过 Hugging Face 下载检查点,或按照模型卡片通过所提供的指令运行模型。

本文最初发布于 7 月 25 日,于 7 月 29 日更新了排行榜信息。