NVIDIA Spectrum-X는 하이퍼스케일 클라우드 인프라에서 AI에 맞춤화된 선도적인 네트워킹 플랫폼으로 빠르게 주목받고 있습니다. Spectrum-X 네트워킹 기술은 엔터프라이즈 고객이 생성형 AI 워크로드를 가속화할 수 있도록 지원합니다. 앞서 NVIDIA는 2023년 11월 보도자료를 통해 Spectrum-X 기반 NVIDIA 이스라엘-1 슈퍼컴퓨터에 대한 업데이트와 함께 이 플랫폼의 대규모 OEM 채택을 발표했습니다.

NVIDIA는 이제 Supermicro가 Spectrum-X 플랫폼의 OEM 파트너로 합류했음을 발표합니다. Spectrum-X는 4U, 5U 및 8U 폼 팩터로 제공되는 슈퍼마이크로 GPU 슈퍼서버에 통합되며, NVIDIA HGX H100, NVIDIA H100 및 NVIDIA L40S PCIe 폼 팩터에서 NVIDIA GPU를 지원하게 될 것입니다.

이러한 Supermicro 시스템은 뛰어난 네트워크 성능을 제공하고, 멀티테넌트 성능 격리를 보장하며, 에너지 효율성을 향상시킴으로써 대규모 트랜스포머 기반 생성형 AI 모델의 트레이닝 및 추론 시간을 크게 단축합니다. 이러한 발전은 이더넷 네트워킹 표준을 준수하고 NVIDIA Spectrum-4 Ethernet 스위치와 NVIDIA BlueField-3 SuperNIC를 활용하면서 이루어집니다.

NVIDIA는 Supermicro와 협력하여 공동의 AI 클라우드 및 하이퍼스케일 인프라 고객에게 향상된 가치를 제공할 수 있기를 기대합니다.

NVIDIA Spectrum-X 성능 벤치마크

NVIDIA Israel-1 데이터센터의 지속적인 개발과 함께, 저희는 Spectrum-X의 성능 이점을 강조하는 다양한 벤치마크를 수행했습니다. 초기 결과는 아래에 자세히 설명된 대로 매우 우수합니다.

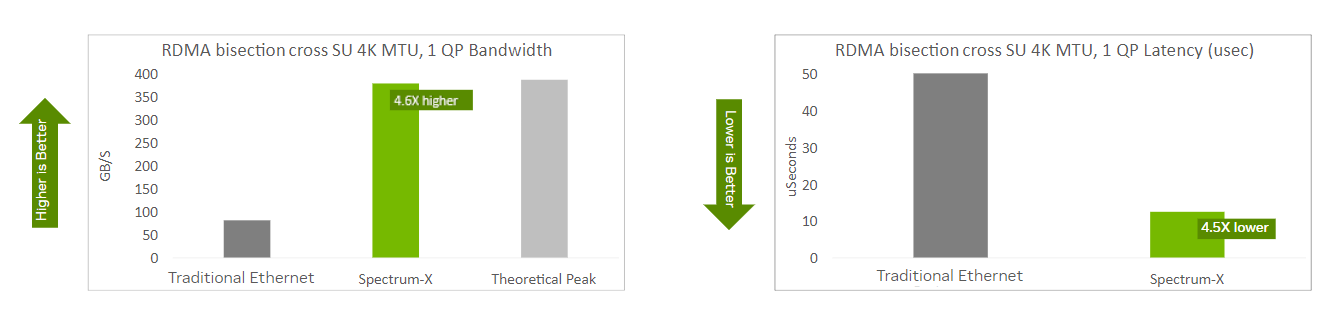

기본 네트워크 상태(RDMA)

이 첫 번째 벤치마크는 시스템의 기본 네트워크 상태를 보여줍니다. AI 워크로드는 GPU 활용을 중심으로 구축되며, GPU(및 온보드 메모리)와 서버를 패브릭에 연결하는 네트워크 어댑터 간에 고대역폭, 저지연 통신이 필요합니다.

RDMA 이분화는 네트워크가 AI를 지원할 준비가 되었음을 나타내는 핵심 지표이며, Spectrum-X는 이 범주에서 탁월한 성능을 발휘합니다. 기존 이더넷에 비해 4배 이상 높은 유효 대역폭과 4배 이상 낮은 지연 시간을 제공합니다. 기존 이더넷에는 RDMA와 혼잡 알림 및 흐름 제어와 같은 최적화가 포함되어 있습니다.

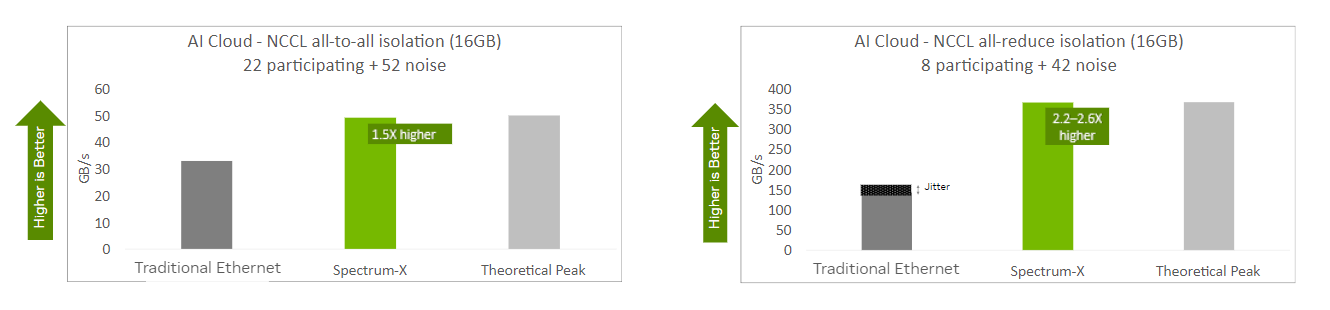

AI 집단 성능

NVIDIA는 RDMA 성능 외에도 NCCL(NVIDIA Collective Communications Library)의 AI 프리미티브 성능도 테스트했습니다. 여러 시스템에서 실행되는 AI 워크로드는 올투올 및 올리듀스와 같은 NCCL 작업을 활용하여 개별 GPU에서 모델 파라미터를 업데이트하고 스케일아웃 트레이닝 및 추론을 위한 동기화를 보장합니다.

Spectrum-X를 통해 NCCL 작업은 기존 이더넷에 비해 상당한 이점을 보여주었습니다. 또한 여러 워크로드가 동시에 네트워크를 통해 통신하는 노이즈가 많은 AI 클라우드 시나리오에서 일관되고 예측 가능한 성능을 보여주었습니다.

실제로 Spectrum-X는 노이즈가 없는 시나리오와 노이즈가 있는 시나리오 모두에서 일관되게 높은 성능을 보여주었습니다. 이에 비해 기존 이더넷은 실행마다 최대 20%의 성능 편차를 보였습니다.

대규모 언어 모델 성능

RDMA 분할과 AI 집단 작업도 중요하지만, 가장 중요한 결과는 애플리케이션 수준에서 이루어집니다. Spectrum-X는 거대 언어 모델(LLM) 학습 워크로드를 가속화하나요? 네, 그렇습니다. NVIDIA NeMo 및 FSDP Llama LLM 모두에서 Spectrum-X는 상당한 성능 향상을 제공하여 단계 반복 시간을 단축하는 동시에 트레이닝 시간을 단축하고 인사이트를 얻는 시간을 단축합니다.

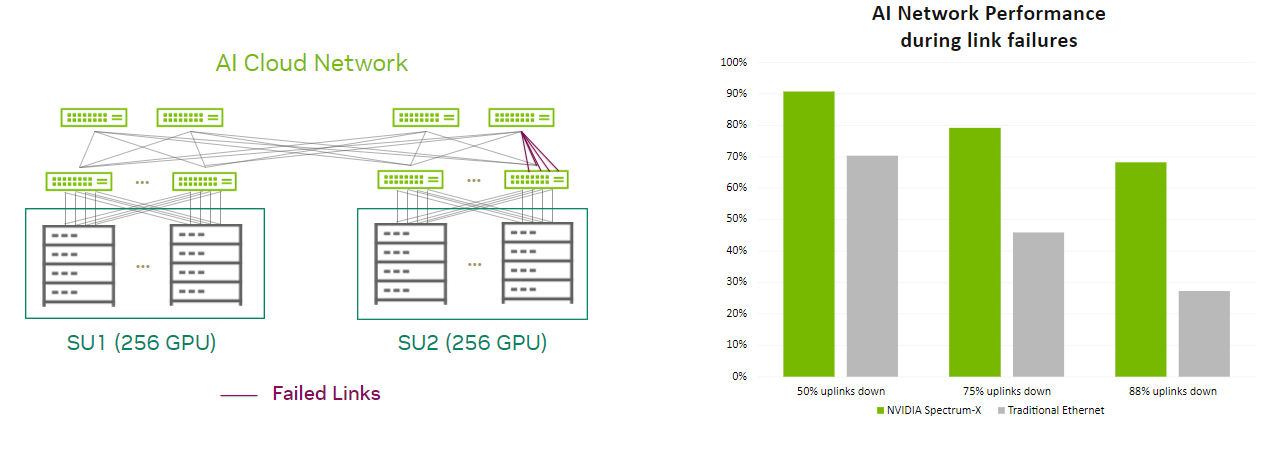

네트워크 복원력

Spectrum-X는 네트워크 최적화를 통해 AI를 가속화하지만 네트워크의 복원력을 고려하는 것도 중요합니다. AI 워크로드는 긴밀하게 결합되어 있으며 최적의 성능을 위해 모든 노드에 높은 유효 대역폭이 필요합니다.

네트워크 링크나 스위치에 장애가 발생하면 AI 학습에 상당한 지장을 초래할 수 있습니다. 네트워크 통신을 신속하게 다시 라우팅해야 하며, 그렇지 않으면 GPU 인프라의 상당 부분이 유휴 상태가 되어 시간과 비용이 낭비되고 이전 체크포인트에서 작업을 다시 시작해야 할 수도 있습니다.

Spectrum-X 라우팅 메커니즘을 사용하면 다운된 링크에서 흐름을 우회하여 정상 링크에 효율적으로 할당하므로 성능 저하를 최소화할 수 있습니다. 반면, 기존 이더넷은 네트워크 문제로 인해 속도가 심각하고 불균형적으로 느려지기 쉬우며, 이는 GPU 인프라의 비효율로 이어집니다.

요약

이러한 초기 벤치마크에서 볼 수 있듯이 Spectrum-X는 이더넷을 사용하여 멀티 테넌트 하이퍼스케일 AI 클라우드를 구축하는 획기적인 접근 방식을 나타냅니다. 이 솔루션을 통해 조직은 AI 클라우드의 성능과 에너지 효율성을 향상하는 동시에 예측 가능성과 일관성을 높일 수 있습니다. 이는 결국 TTM을 가속화하고 경쟁 우위를 강화하는 결과로 이어집니다.

자세히 알아보기

자세히 알아보고 싶으신가요? NVIDIA GTC 2024에 직접 또는 가상으로 참여하여 NVIDIA 네트워킹 플랫폼 제품군을 직접 경험해 보세요. 업계 저명인사, 개발자, 연구원, 비즈니스 전략가들과 교류하며 AI 및 가속 컴퓨팅의 다음 단계를 만들어가는 데 도움을 받으세요. AI 컨퍼런스에서는 NVIDIA 네트워킹의 발전에 대한 흥미로운 발표, 데모, 교육 세션이 진행될 예정입니다.

추천 네트워킹 세션을 확인해 보세요:

- AI를 위한 네트워킹 모범 사례: 클라우드 서비스 제공업체의 관점 – Panel [S62447]

- AI 애플리케이션에 적합한 스토리지 확보하기 – Panel [S62476]

- InfiniBand를 통한 혁신의 새로운 영역 진입 [S62293]

- 최적화된 이더넷 AI 네트워킹을 통한 엔터프라이즈 생성형 AI 구현 [S62521]

- BlueField DPU로의 오프로딩을 통한 HPC 및 AI 애플리케이션 가속화: 전략 및 이점 [S61956]

- 전문가와 소통하세요: AI 시대에 적합한 네트워크 선택: 네트워크가 데이터센터를 정의하다 [CWE61202]

관련 리소스

GTC 세션: AI 네트워킹 혁신의 새로운 영역으로 진입하기

GTC 세션: AI를 위한 네트워킹 모범 사례: 클라우드 서비스 제공업체의 관점

GTC 세션: Connect With the Experts: AI 시대에 적합한 네트워크 선택하기: 네트워크가 데이터센터를 정의합니다.

NGC 컨테이너: NVIDIA MLPerf 추론

SDK: Spectrum Switch SDK

웨비나: AI 시대를 위한 네트워킹