推論は機械学習のライフサイクルの重要な部分で 、モデルを学習させた後に発生します。それは、ビジネスが AI 投資からの価値を実現するときです。AI の一般的な用途としては、画像分類 (「これは腫瘍の画像です」)、レコメンデーション (「あなたが好きな映画はこちらです」)、音声の文字起こし、判断 (「車を左に回してください」) などが挙げられます。

ディープラーニング学習用システム は多くの演算能力を必要としますが、AI モデルの学習が完了した後は、本番でそれを実行するために必要なリソースは少なくなります。推論ワークロードのシステム要件を決定する上で最も重要な要素は、実行されるモデルとデプロイ先です。この記事では、これらの領域について、特にエッジでの AI 推論に焦点を当てながら説明します。

AI モデル推論の要件

最適な推論のデプロイ構成を決定するための支援として、NVIDIA Triton Model Analyzer のようなツールは、実行中の特定の AI モデルに基づき推奨構成を提案します。NVIDIA TensorRT のような推論コンパイラは、精度を保ちつつ、最高のスループットと最低のレイテンシーで実行できるようにモデルを最適化することで、推論に必要なリソースを削減することができます。

これらの最適化を行ったとしても、 GPU は、推論ワークロードのビジネス サービス レベル目標 SLA と要件を達成するために不可欠です。 MLPerf 2.0 Inference ベンチマークの結果は、 NVIDIA GPU が CPU のみのシステムよりも 100 倍以上高速であることを実証しています。また、 GPU は、リアルタイム応答を必要とするワークロードに必要な低レイテンシーを提供することができます。

推論ワークロードのデプロイ先

AI の推論ワークロードは、データ センターとエッジの両方に存在します。データ センターで実行される推論ワークロードの例としては、レコメンダー システムや自然言語処理などが挙げられます。

これらのワークロードの実行方法は非常に多様です。例えば、同じサーバーから多くの異なるモデルを同時に提供することができ、数百、数千、あるいは数万もの同時推論要求が発生していることもあります。さらに、データ センターのサーバーでは、しばしば AI 推論以外のワークロードも実行されることがあります。

データ センターの推論を行うためのシステム設計には、「一長一短」の解決策はありません。

エッジに配置され実行される推論アプリケーションは、重要かつ成長中のワークロードの 1 つです。 エッジ コンピューティングは、低レイテンシーでリアルタイムの結果に対する要求と、コストとセキュリティの両方の理由からデータ転送を削減したいという要望によって推進されています。エッジ システムは、小売店、工場のフロア、携帯電話の基地局など、データが収集または処理される場所に物理的に近い場所で実行されます。

データ センターでの推論と比較すると、エッジでの AI 推論のシステム要件は、通常、狭い範囲の推論ワークロードに焦点を当てるように設計されているため、明確にしやすくなっています。

エッジ推論では、通常、カメラやその他のセンサーがデータを収集し、それに基づいて処理する必要があります。例えば、化学工場に設置されたセンサー付きビデオ カメラが、配管の腐食を検知し、被害が発生する前にスタッフに警告を発するために使用されています。

エッジ推論システムの要件

AI 学習のためのサーバーは、モデル パラメーターの正しい値を学習するために、大量の過去データを処理する設計が必要です。これに対し、エッジ推論のためのサーバーは、エッジの配置場所でリアルタイムに収集されるストリーミング データを処理する必要があり、その量は少量です。

その結果、システム メモリはそれほど大きくする必要がなく、 CPU コアの数も少なくて済みます。また、学習データセットをキャッシュしないため、ネットワーク アダプターもそれほど広い帯域幅を必要とせず、サーバーのローカル ストレージも小さくて済みます。

しかし、できるだけ早く対応することが重要であるため、ネットワークとストレージの両方が最小のレイテンシーを可能にするように構成する必要があります。

| Resource | AI training in the data center | AI inferencing at the edge |

| CPU | Fastest CPUs with high core count | Lower-power CPUs |

| GPU | Fastest GPUs with most memory, more GPUs per system | Lower-power GPU, or larger GPU with MIG, one or two GPUs per system |

| Memory | Large memory size | Average memory size |

| Storage | High bandwidth NVMe flash drive, one per CPU | Average bandwidth, lowest-latency NVMe flash drive, one per system |

| Network | Highest bandwidth network adapter, Ethernet or InfiniBand, one per GPU pair | Average bandwidth network adapter, Ethernet, one per system |

| PCIe System | Devices balanced across PCIe topology; PCIe switch for multi-GPU, multi-NIC deployments | Devices balanced across PCIe topology; PCIe switch not required |

エッジ システムは、従来のデータ センターの外、つまり遠隔地に配置されることが多いのが特徴です。このような環境では、スペースと電力の面で制約を受けることがよくありま す。これらの制約は、 NVIDIA A2 のような低電力 GPU と組み合わせて、より小型のシステムを使用することで満たすことができます。

推論ワークロードの負荷が高く、電力が許すなら、 NVIDIA A30 や NVIDIA A100 のような大型 GPU を使用することができます。マルチインスタンス GPU (MIG) 機能により、これらの GPU で複数の推論ストリームを同時に処理し、システム全体で非常に効率的なパフォーマンスを提供することができます。

エッジ推論に必要なその他の要素

システム要件以外にも、エッジならではの考慮すべき要素があります。

ホストのセキュリティ

セキュリティは、エッジ システムにとって重要な側面です。データ センターは、その性質上、情報窃取やサーバー制御権奪取の試みを防止または軽減することができる集中管理だけでなく、物理的な制御のレベルを提供することができます。

エッジ システムは、配置場所が物理的に安全でないこと、データ センターの IT 管理システムに見られるような多くのアクセス制御メカニズムが適用できないことを前提に設計する必要があります。

Trusted Platform Module (TPM) は、ホストのセキュリティに大きく貢献する技術の 1 つです。適切に設定することで、TPM は、デジタル署名され、変更されていないファームウェアとソフトウェアのみを使用してシステムを起動できるよう、担保することができます。また、署名入りコンテナーなどの追加のセキュリティ チェックにより、アプリケーションが改ざんされていないことを確認し、TPM に安全に格納されている鍵でディスク ボリュームを暗号化することができます。

暗号化

もう 1 つの重要な考慮点は、エッジ システムとの間で行われるすべてのネットワーク トラフィックの暗号化です。NVIDIA ConnectX 製品に見られるように、暗号化アクセラレーション ハードウェアを備えた署名入りネットワーク アダプターは、この保護がデータ転送速度の低下という犠牲を伴わないことを保証しています。

堅牢なシステム

工場の自動制御現場や通信アンテナ塔の横の筐体など、特定のユースケースにおいては、高温、大きな衝撃や振動、埃など、過酷な条件下でもエッジ システムが正常に動作することが求められます。

このような用途のために設計された堅牢なサーバーは、GPU を搭載したものが増えており、過酷なユースケースでも、大幅な性能向上の恩恵を受けることができるようになりました。

推論のためのエンドツーエンド プラットフォームの選択

NVIDIA は、 NVIDIA-Certified Systems プログラムを拡張し、従来のデータ センターの外で動作するエッジ展開用のカテゴリを含めるようにしました。これらのシステムの設計基準には、以下のすべてが含まれます。

- NVIDIA GPU

- 最適なパフォーマンスを提供する CPU、メモリ、ネットワーク構成

- セキュリティおよびリモート管理機能

認定システム カタログには、 NVIDIA パートナーからの NVIDIA Certified Systems のリストが掲載されています。このリストは、推論ワークロードに理想的な以下のようなシステムのカテゴリでフィルタリングすることができます。

- データセンター サーバーは、さまざまなデータ サイエンス ワークロードで性能とスケールアウト能力が検証されており、データ センターの推論に理想的な製品です。

- エンタープライズ エッジ システムは、小売店のバック オフィスなど、管理された環境で展開されることを想定しています。このカテゴリのシステムは、データ センターのような環境でテストされます。

- 産業用エッジ システムは、工場のフロアや携帯電話タワーの基地局など、産業用または過酷な環境向けに設計されています。この認証を取得したシステムは、一般的なデータ センターの範囲外の高温環境など、システムが設計された環境下で動作している間、すべてのテストに合格しなければなりません。

NVIDIA は、エッジ向けのシステムの認証に加え、推論ワークロードを実行し管理するための企業向けソフトウェアも開発しています。

NVIDIA Triton Inference Server は、GPU または CPU ベースのインフラストラクチャ上で、あらゆるフレームワークの学習済み AI モデルをデプロイ、実行、拡張できるようにすることで、AI 推論を効率化します。クラウド、オンプレミス、エッジ、組み込みデバイスにまたがる高性能な推論を実現することができます。

NVIDIA AI Enterprise は、AI とデータ分析ソフトウェアのエンドツーエンド、クラウドネイティブなスイートで、すべての組織が AI に慣れ親しむように最適化されており、データ センターとエッジの両方の場所での展開が認定されています。AI プロジェクトが軌道に乗るように、グローバルな企業向けサポートも含まれています。

NVIDIA Fleet Command は、エッジが配置された場所のシステムを一元的に接続し、1 つのダッシュボードから AI アプリケーションを安全にデプロイ、管理、拡張するクラウド サービスです。何重ものセキュリティ プロトコルを備え、すぐに利用でき、数時間で完全に機能させることができます。

認定されたシステムとインフラストラクチャ ソフトウェアで構成されるエンドツーエンドのプラットフォームを選択することで、個々のコンポーネントからソリューションを組み立てるよりもはるかに迅速に、本番環境への AI のデプロイを開始し、推論アプリケーションをデプロイし実行することができます。

NVIDIA AI Inference プラットフォームの詳細

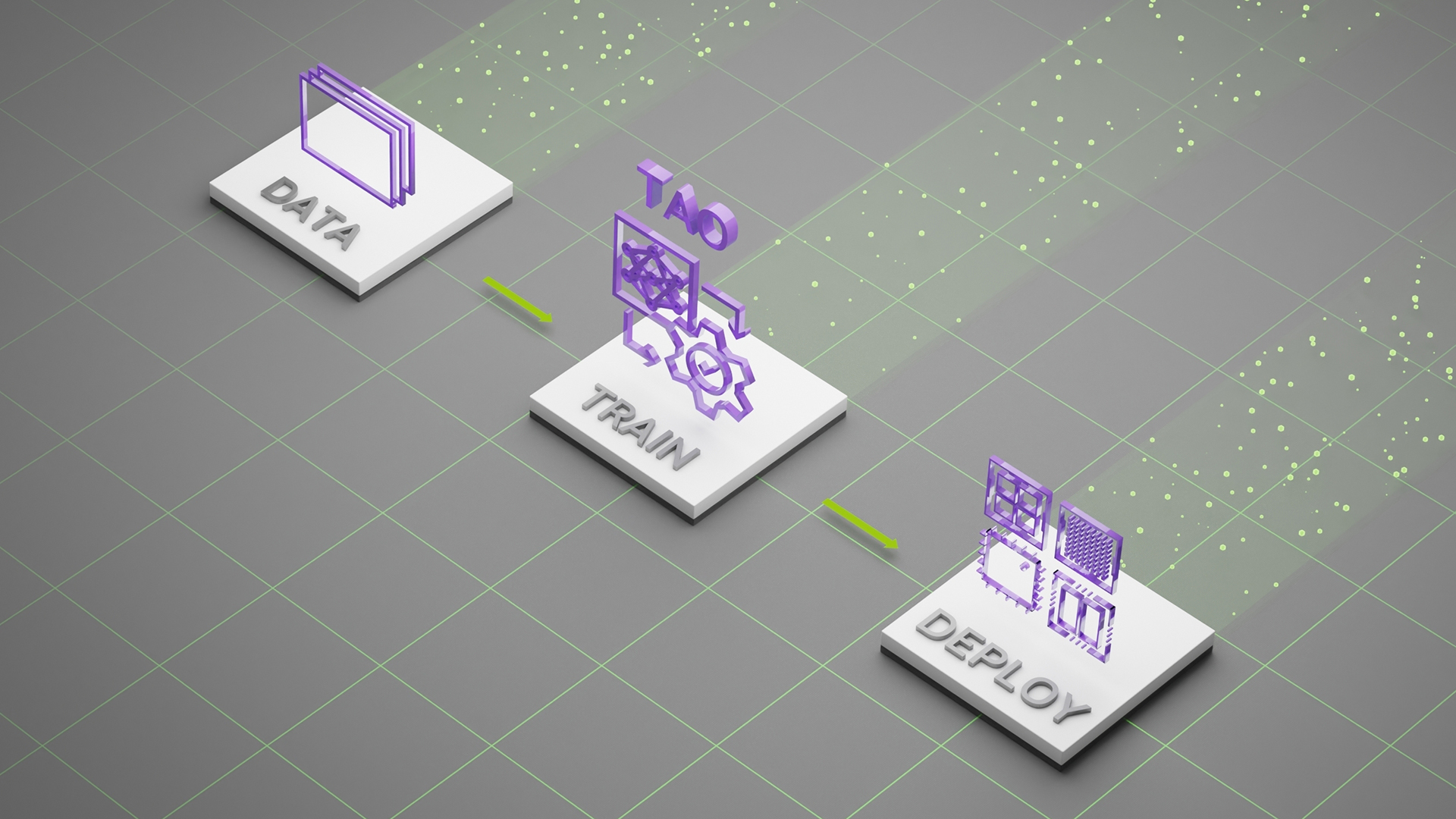

ディープラーニングの推論に関しては、さらに多くのことが関係しています。「NVIDIA AI Inference Platform Technical Overview (NVIDIA AI 推論プラットフォームの技術概要)」では、エンドツーエンドのディープラーニング ワークフローの見方、AI 対応アプリケーションをプロトタイプから本番へデプロイする際の詳細、AI 推論アプリケーションを構築し実行するためのソフトウェア フレームワークなど、このテーマに関する詳細な考察が掲載されています。

Edge AI News に登録すると、最新のトレンド、お客様の導入事例、技術的な手順などを常に把握することができます。

翻訳に関する免責事項

この記事は、「Choosing a Server for Deep Learning Inference」の抄訳で、お客様の利便性のために機械翻訳によって翻訳されたものです。NVIDIA では、翻訳の正確さを期すために注意を払っておりますが、翻訳の正確性については保証いたしません。翻訳された記事の内容の正確性に関して疑問が生じた場合は、原典である英語の記事を参照してください。