Transformers

2024年 1月 29日

使用全卷积网络在 Transformer 模型中模拟注意力机制

在过去十年中,深度学习技术在计算机视觉 (CV) 任务中的应用大幅增加。卷积神经网络 (CNN) 一直是这场革命的基石,展示了卓越的性能,

3 MIN READ

2023年 11月 17日

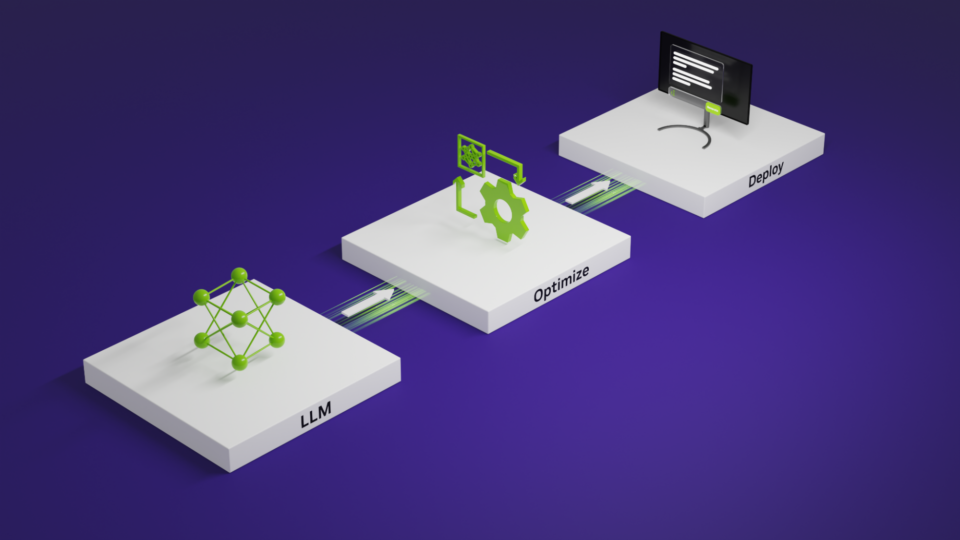

掌握 LLM 技术:推理优化

通过堆叠 Transformer 层来创建大型模型,可以提高准确性、实现少量学习功能,并且在各种语言任务中实现近乎人类的性能。

4 MIN READ

2023年 7月 25日

使用 Vision Transformers 和 NVIDIA TAO 提高视觉 AI 应用程序的准确性和稳健性

视觉转换器( ViT )正在掀起计算机视觉的风暴,为具有挑战性的现实世界场景提供了令人难以置信的准确性、强大的解决方案,并提高了可推广性。

2 MIN READ

2023年 5月 15日

使用 Alpa 和 Ray 在大型 GPU 集群中高效扩展 LLM 训练

近年来,大型语言模型( LLM )的数量激增,它们超越了传统的语言任务,扩展到生成式人工智能这包括像 ChatGPT 和 Stable…

4 MIN READ

2023年 2月 1日

NVIDIA Hopper GPU 上的新 cuBLAS 12.0 功能和矩阵乘法性能

NVIDIA H100 TensorCore GPU 基于 NVIDIA Hopper 架构 和第四代 NVIDIA Tensor…

5 MIN READ

2022年 9月 12日

结合卷积和注意机制改进日语 ASR

自动语音识别( ASR )研究通常侧重于高资源语言,如英语,它由数十万小时的语音支持。最近的文献重新关注更复杂的语言,如日语。

1 MIN READ

2022年 8月 3日

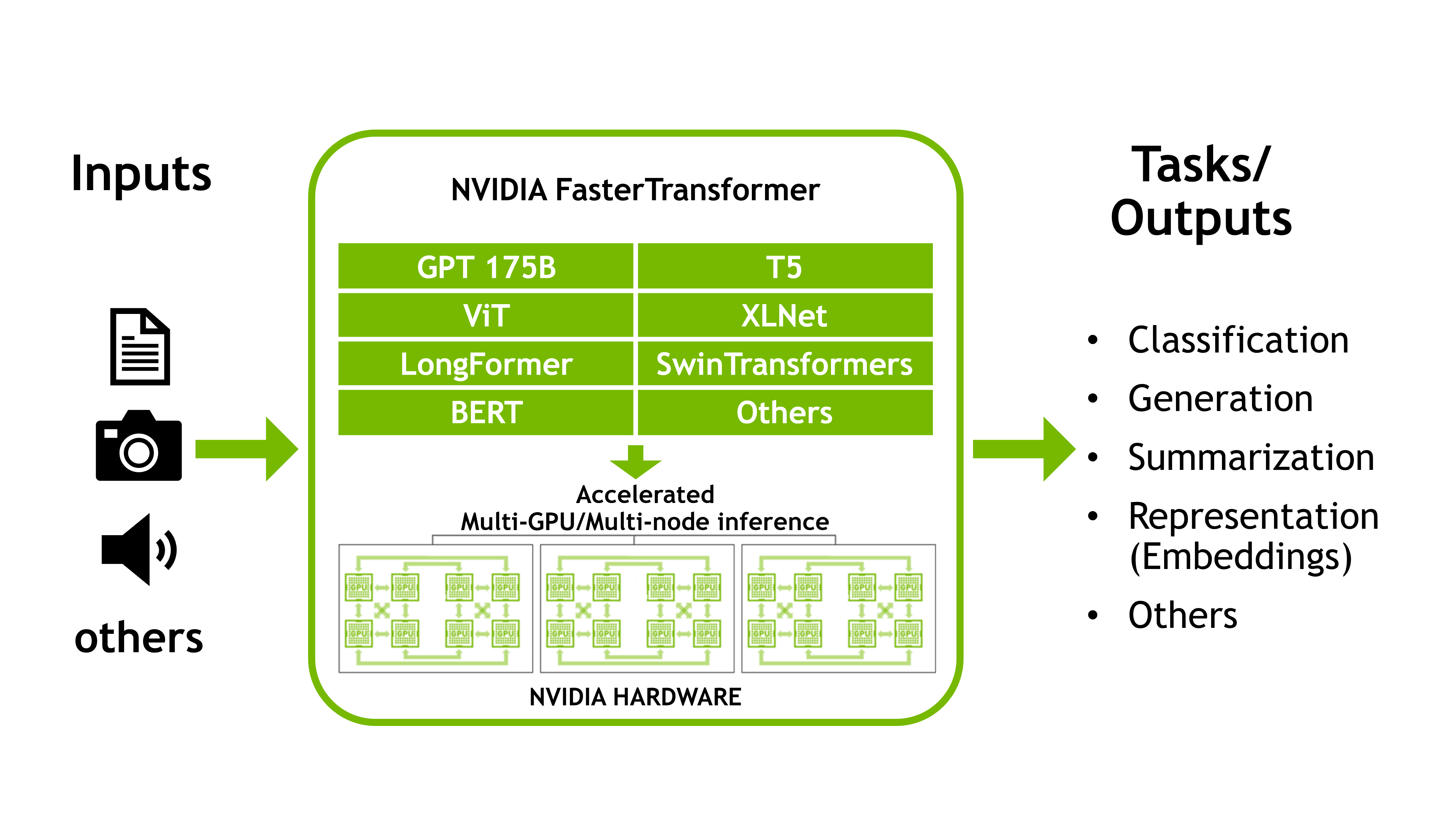

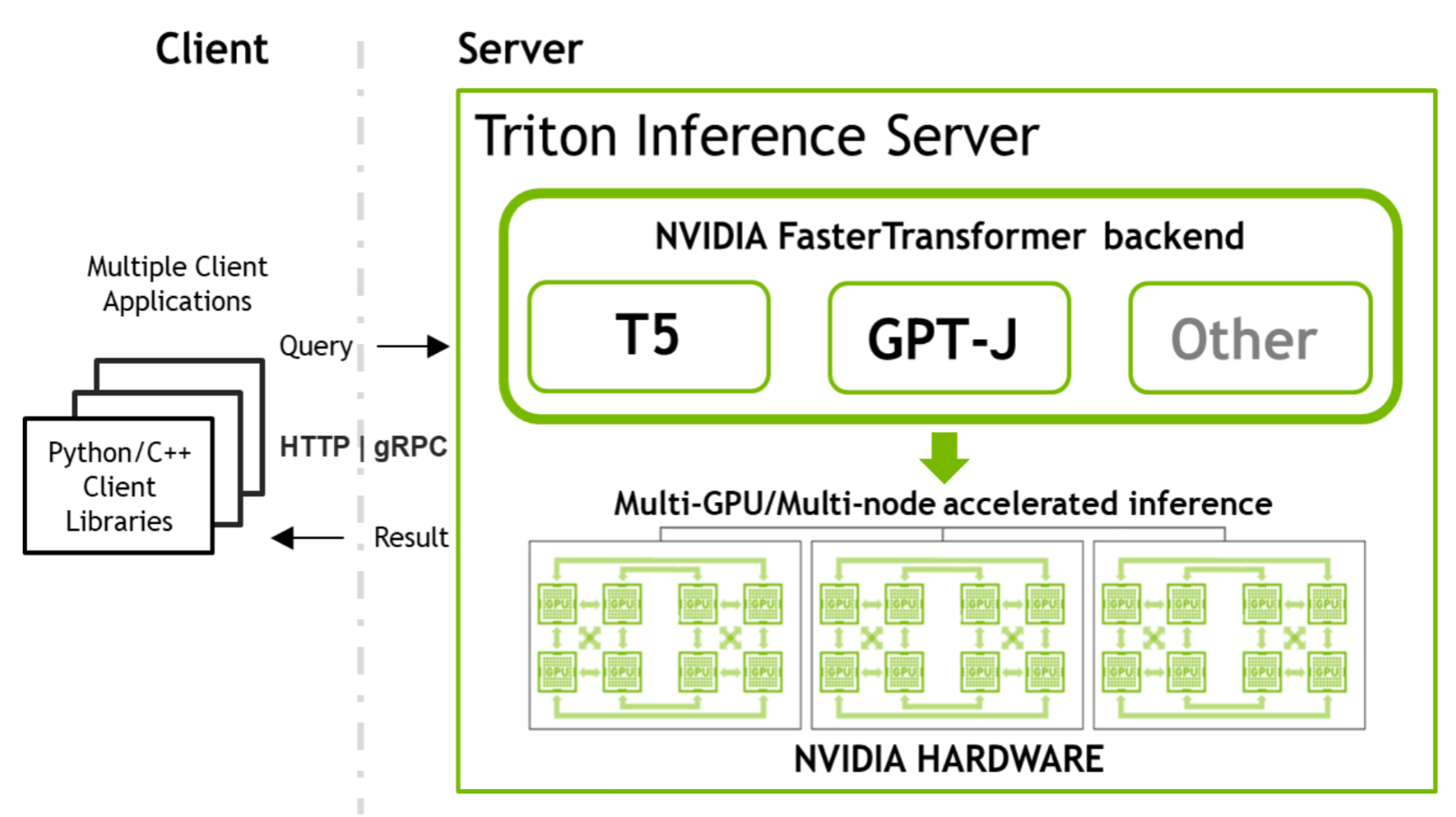

使用 FasterTransformer 和 Triton 推理服务器加速大型 Transformer 模型的推理

这是讨论 NVIDIA FasterTransformer 库的两部分系列的第一部分,

3 MIN READ

2022年 8月 3日

使用 FasterTransformer 和 Triton 推理服务器部署 GPT-J 和 T5

这是关于 NVIDIA 工具的两部分系列的第二部分,这些工具允许您运行大型Transformer模型以加速推理。

5 MIN READ

2022年 7月 27日

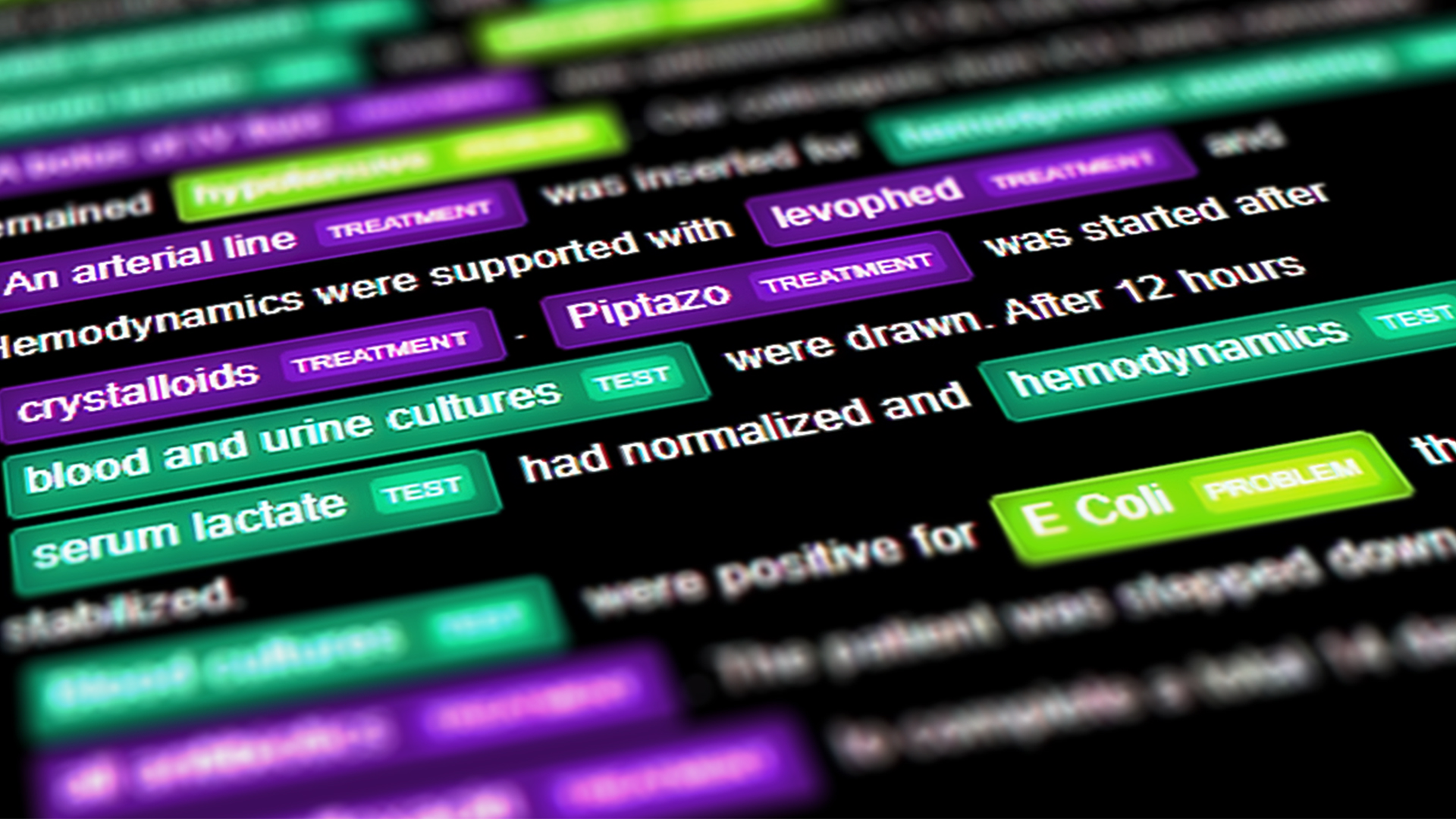

为医疗保健开发 NLP 应用程序

自然语言处理( NLP )可以定义为人工智能( AI )、计算机科学和计算语言学的结合,以理解人类交流并从非结构化口语或书面材料中提取意义。

1 MIN READ

2022年 7月 12日

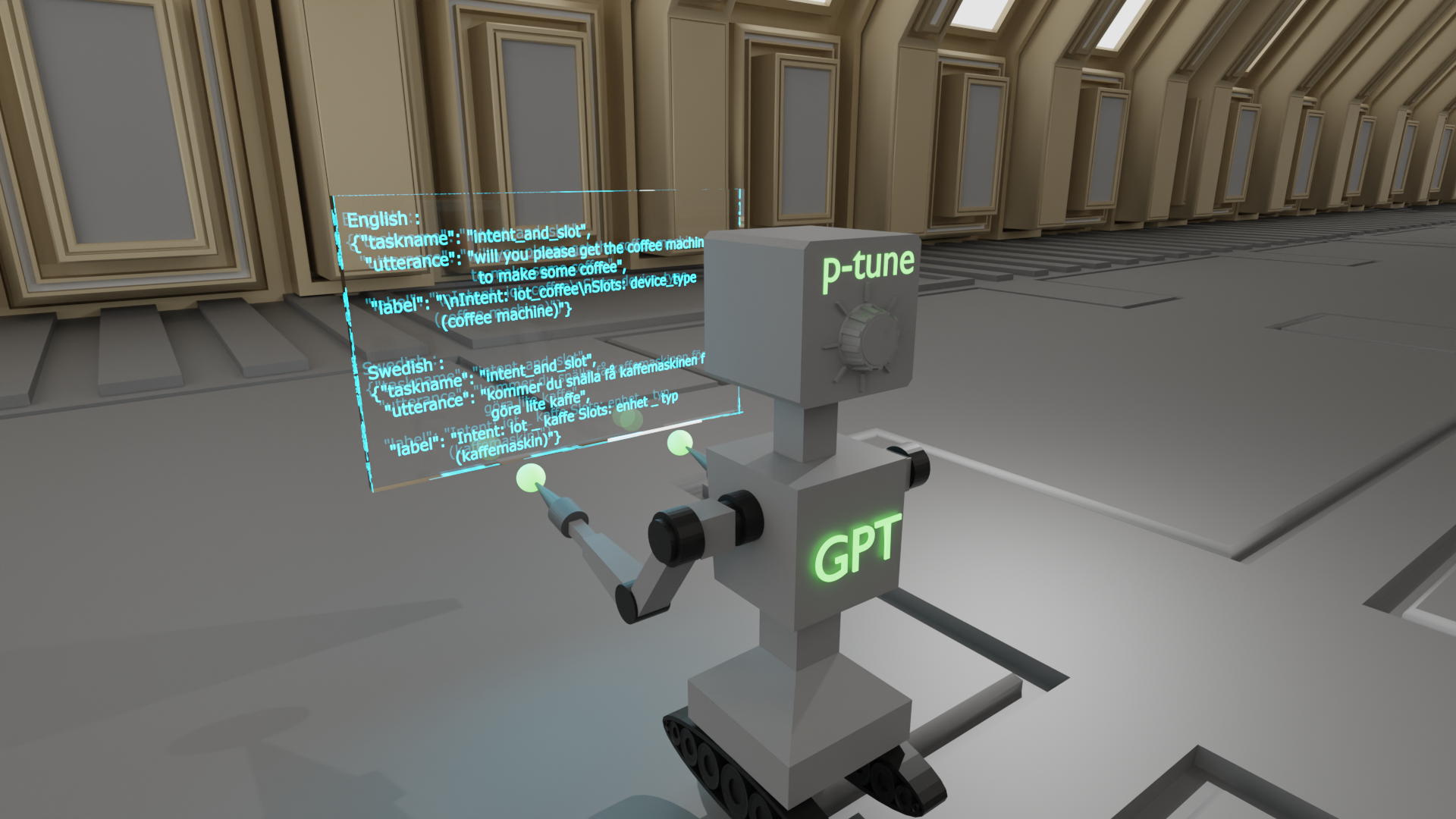

采用 P-Tuning 解决非英语下游任务

随着对预训练大型语言模型( LLM )权重访问需求的增加,围绕 LLM 共享的环境正在发生变化。最近,

3 MIN READ

2022年 6月 28日

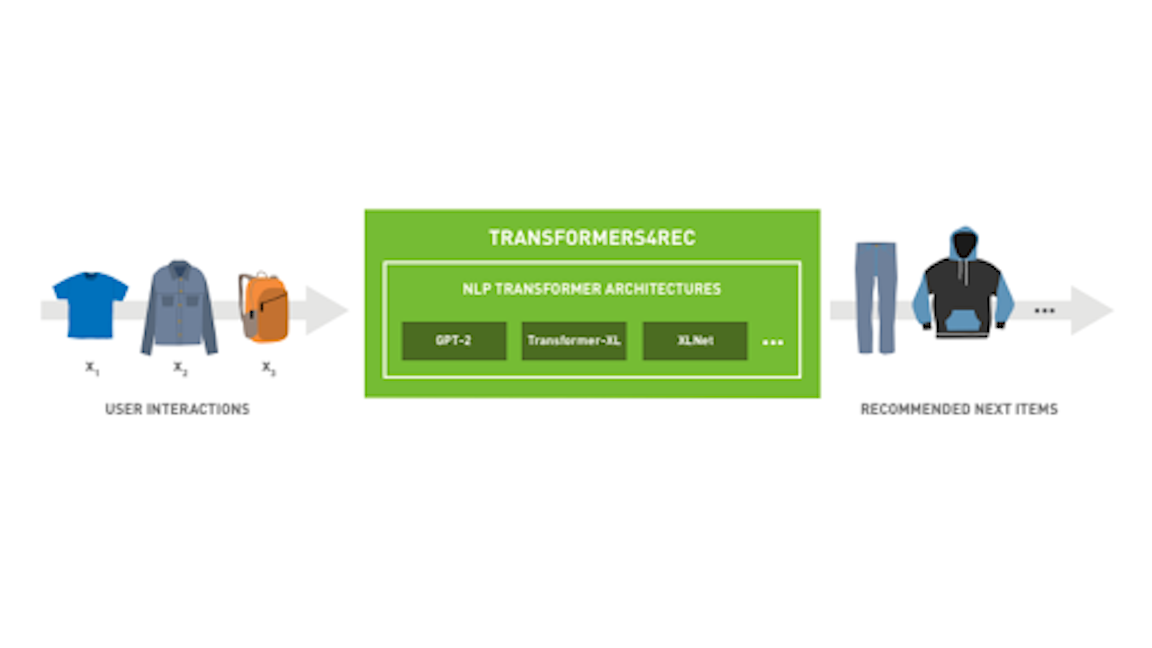

Transformers4Rec :使用 NVIDIA Merlin 库构建基于会话的建议

推荐系统可以帮助您发现新产品并做出明智的决策。然而,在许多依赖于推荐的领域,如电子商务、新闻和流媒体服务,用户可能无法跟踪,

3 MIN READ

2022年 6月 22日

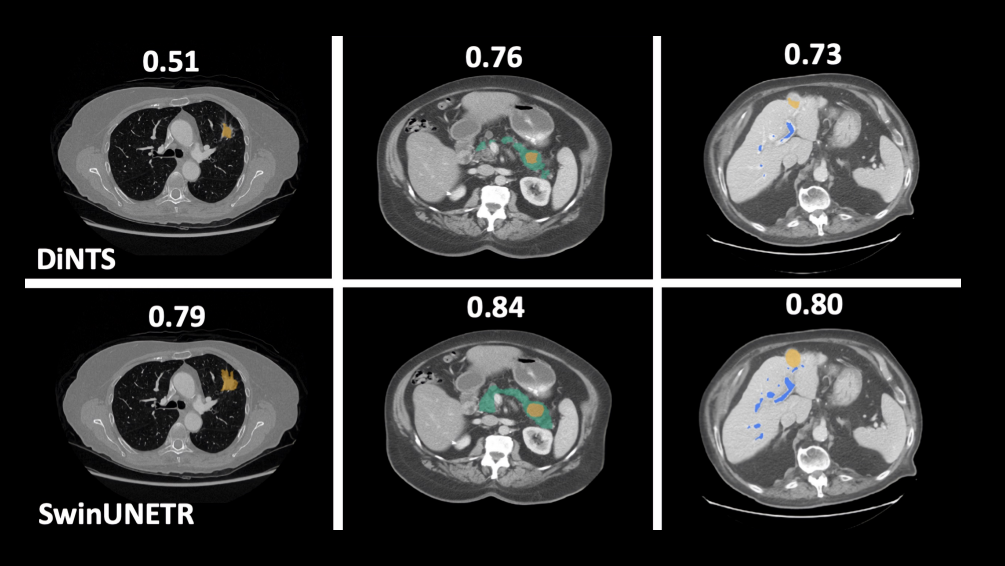

新型 transformer 模型实现了 3D 医学图像分析的最新基准

在计算机视觉和模式识别会议( CVPR )上, NVIDIA 研究人员发表了 35 多篇论文。

2 MIN READ

2022年 5月 12日

使用 Transformers 生成合成数据:企业数据挑战的解决方案

大数据、新算法和快速计算是使现代 AI 革命成为可能的三个主要因素。然而,数据给企业带来了许多挑战:数据标记困难、数据治理效率低下、

2 MIN READ

2021年 11月 9日

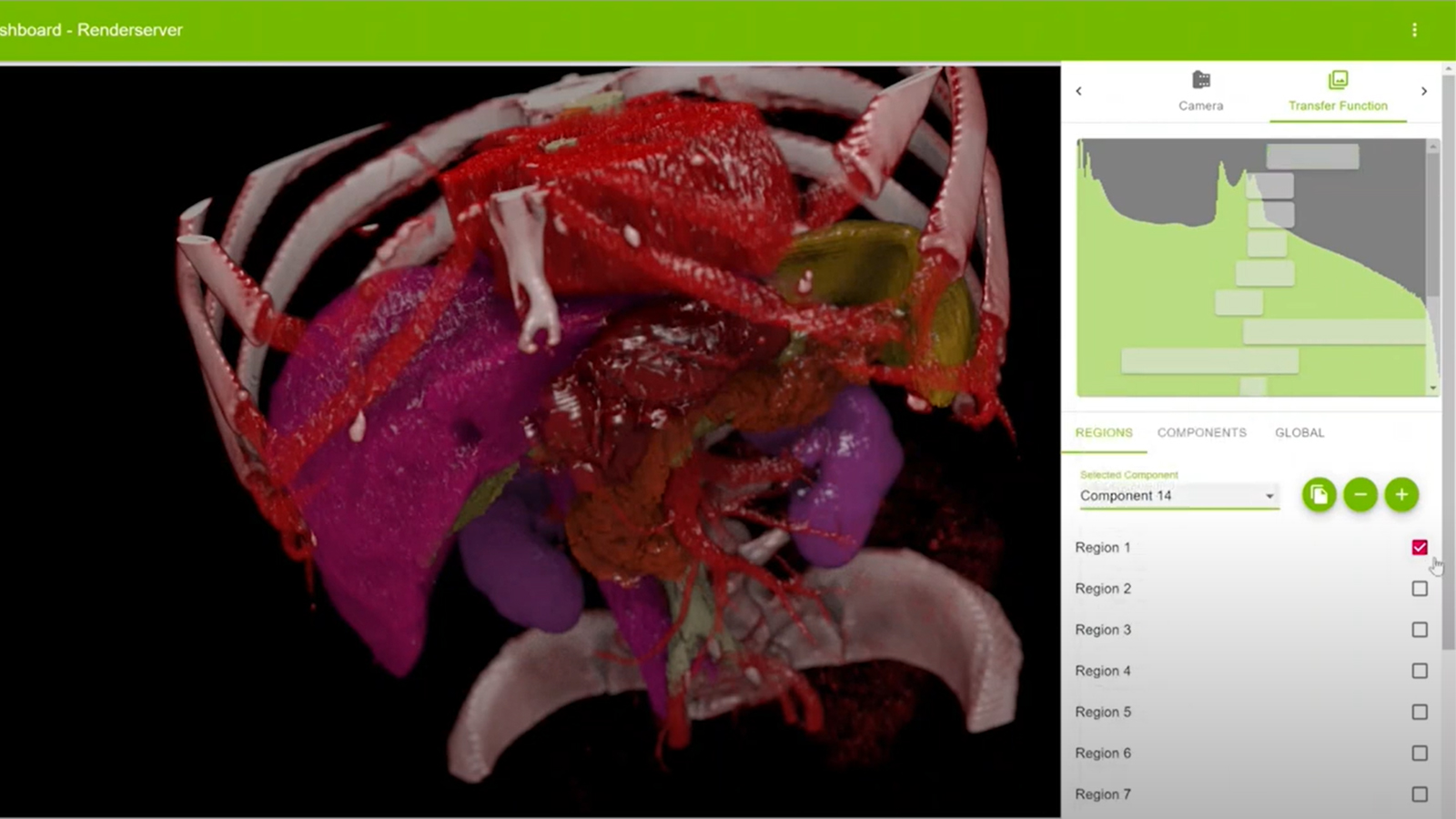

使用 NVIDIA Clara Holoscan 加速放射和放射治疗的多器官渲染

观看 NVIDIA 创始人兼首席执行官 Jensen Huang’s GTC keynote address11 月 9 日和重播时播放。

5 MIN READ