视觉转换器( ViT )正在掀起计算机视觉的风暴,为具有挑战性的现实世界场景提供了令人难以置信的准确性、强大的解决方案,并提高了可推广性。这些算法在提升计算机视觉应用程序方面发挥着关键作用, NVIDIA 使用 NVIDIA TAO Toolkit 和 NVIDIA L4 GPU 可以轻松地将 ViT 集成到您的应用程序中。

ViT 的不同之处

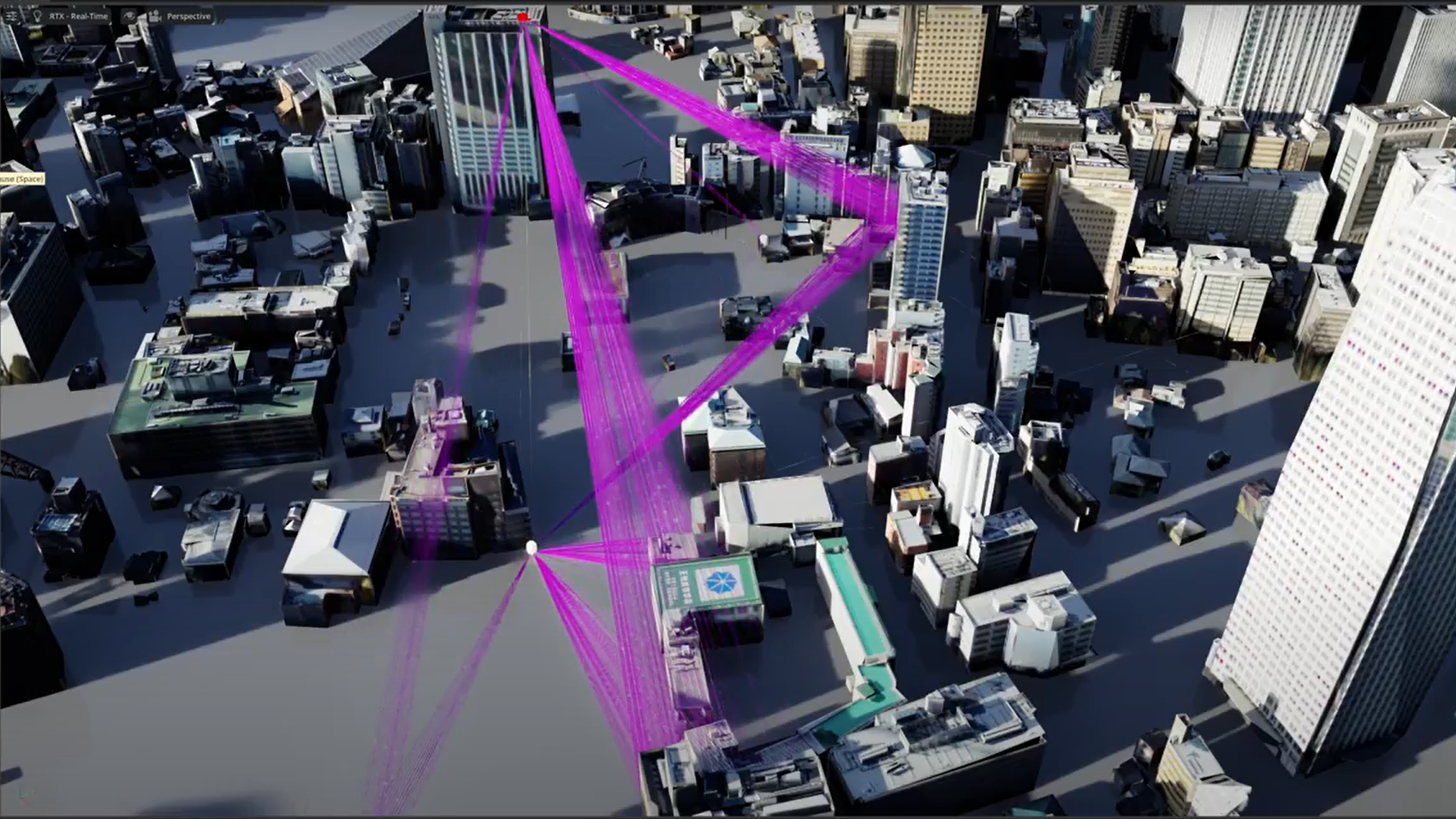

ViT 是一种机器学习模型,它将最初为自然语言处理设计的 transformer 架构应用于视觉数据。与基于 CNN 的同类产品相比,它们有几个优势,并且能够对大规模输入进行并行处理。虽然 CNNs 使用的本地操作缺乏对图像的全局理解,但 ViT 提供了长期依赖性和全局上下文。他们通过以并行和基于自我关注的方式处理图像,实现所有图像补丁之间的交互,从而有效地做到了这一点。

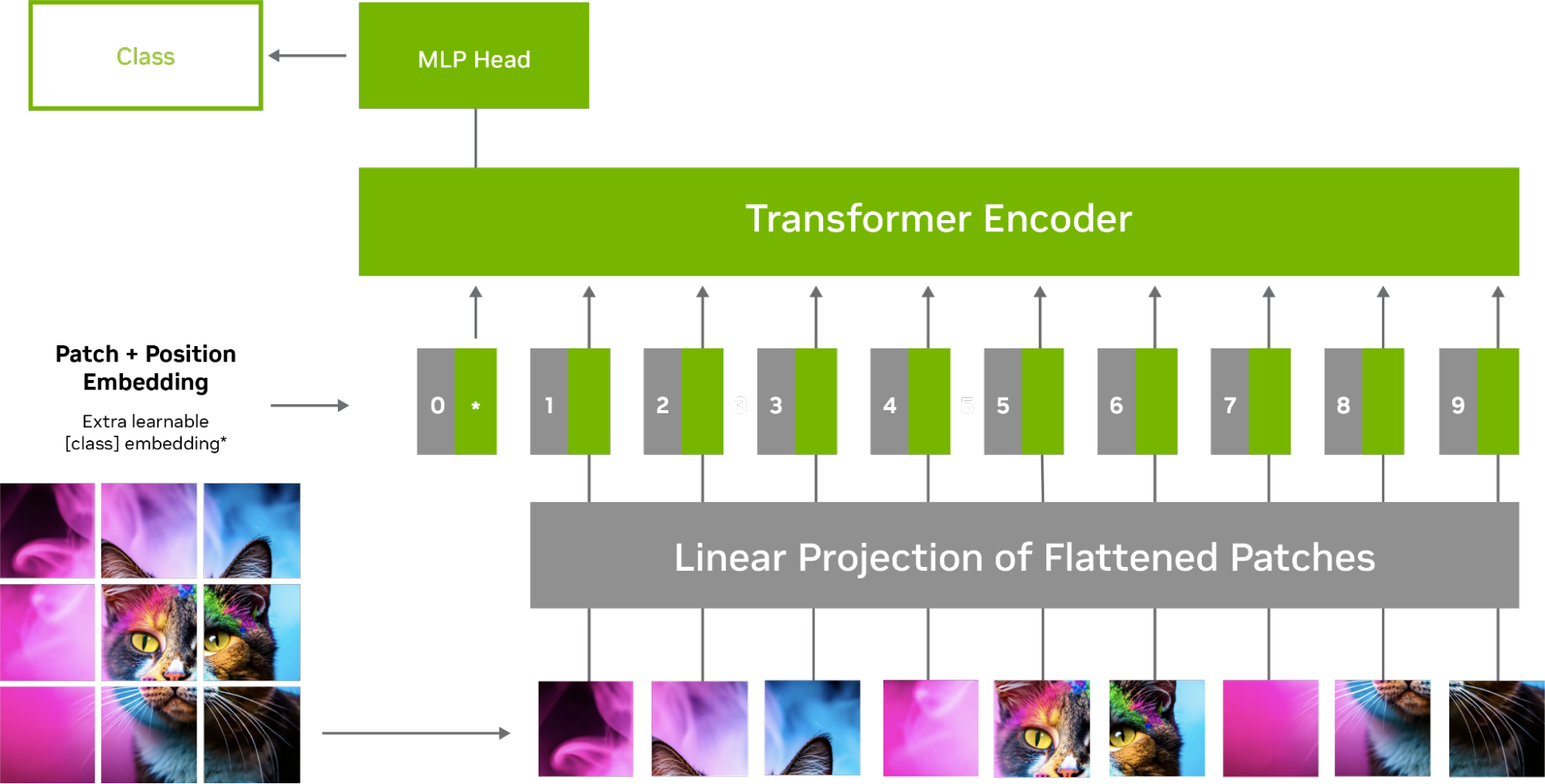

图 1 显示了 ViT 模型中图像的处理,其中输入图像被划分为较小的固定大小的补丁,这些补丁被展平并转换为令牌序列。然后,这些标记与位置编码一起被馈送到 transformer 编码器中,该编码器由多层自注意和前馈神经网络组成。

通过自关注机制,图像的每个令牌或补丁与其他令牌交互,以决定哪些令牌是重要的。这有助于模型捕获令牌之间的关系和依赖关系,并了解哪些令牌被认为比其他令牌重要。

例如,对于鸟的图像,模型更关注重要特征,如眼睛、喙和羽毛,而不是背景。这转化为提高了训练效率,增强了对图像损坏和噪声的鲁棒性,以及对看不见的对象的卓越泛化能力。

为什么 ViT 对计算机视觉应用至关重要

现实世界的环境具有多样而复杂的视觉模式。 ViT 的可扩展性和适应性使其能够处理各种各样的任务,而无需对特定任务的架构进行调整,这与 CNN 不同。

在下面的视频中,我们比较了在基于 CNN 的模型和基于 ViT 的模型上运行的嘈杂视频。在任何情况下, ViT 都优于基于 CNN 的模型。

将 ViTs 与 TAO Toolkit 5.0 集成

TAO 是一个用于构建和加速视觉人工智能模型的低代码人工智能工具包,现在您可以轻松地构建 ViT 并将其集成到您的应用程序和人工智能工作流中。用户可以通过简单的界面和配置文件快速开始训练 ViT ,而无需深入了解模型架构。

TAO Toolkit 5.0 为流行的计算机视觉任务提供了几个高级 ViT ,包括以下内容。

全注意力网络( FAN )

作为 NVIDIA Research 的一个基于 transformer 的主干系列, FAN 实现了 SOTA 对各种损坏的鲁棒性,如表 1 所示。这个主干族可以很容易地推广到新的领域,对抗噪声和模糊。表 1 显示了 ImageNet-1K 数据集上所有 FAN 模型对于干净版本和损坏版本的准确性。

| 模 | #第页,共页 | 精度(清洁/损坏) |

| FAN 微型混合动力 | 740 万 | 80 . 1 / 57 . 4 |

| FAN 小型混合动力 | 2630 万 | 83 . 5 / 64 . 7 |

| FAN Base Hybrid | 5040 万 | 83 . 9 / 66 . 4 |

| FAN 大型混合动力 | 76 . 8 米 | 84 . 3 / 68 . 3 |

全球语境视野 transformer ( GC ViT )

GC ViT 是 NVIDIA Research 的一种新颖架构,可实现非常高的精度和计算效率。它解决了视觉转换器中缺乏感应偏置的问题。它还通过使用局部自注意在 ImageNet 上使用较少的参数获得了更好的结果,局部自注意与全局自注意相结合可以提供更好的局部和全局空间交互。

| 模 | #第页,共页 | 精确 |

| GC ViT xxTiny | 12 米 | 79 . 9 |

| GC ViT xTiny | 20 米 | 82 |

| GC ViT Tiny | 2800 万 | 83 . 5 |

| GC ViT 小型 | 5100 万 | 84 . 3 |

| GC ViT 基础 | 90 米 | 85 |

| GC ViT 大型 | 2 . 01 亿 | 85 . 7 |

用改进的去噪锚( DINO )进行检测 transformer

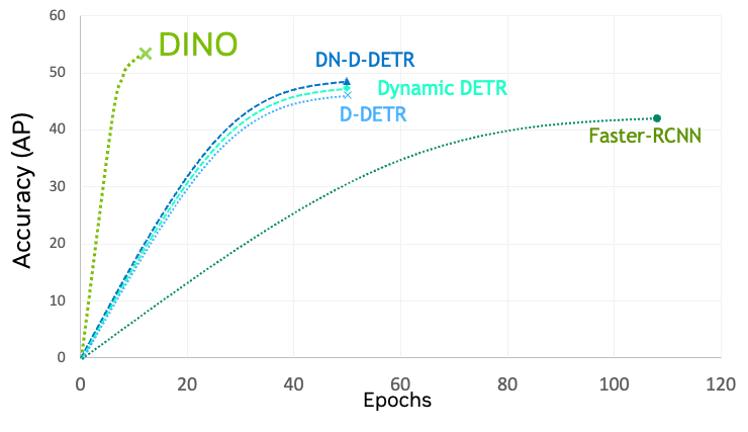

DINO 是最新一代的检测 transformers( DETR ),与其他 ViT 和 CNNs 相比,具有更快的训练收敛性。 TAO 工具包中的 DINO 是灵活的,可以与传统 CNN 的各种骨干(如 ResNets )和基于 transformer 的骨干(如 FAN 和 GC ViT )相结合。

Segformer

Segformer 是一种基于 transformer 的轻量级、健壮的语义分割方法。解码器由轻量级的多头感知层组成。它避免了使用位置编码(主要由 transformer s 使用),这使得推理在不同分辨率下高效。

使用 NVIDIA L4 GPU 为高效变压器供电

NVIDIA L4 GPUs 是专为下一代视觉 AI 工作负载而设计的。它们由旨在加速变革性人工智能技术的 NVIDIA Ada Lovelace 架构驱动。

L4 GPU 适用于运行 ViT 工作负载,具有 FP8 485 TFLOP 的高计算能力和稀疏性。与更高的精度相比, FP8 降低了内存压力,并显著加快了 AI 吞吐量。

L4 具有多功能性和节能性,具有单插槽、低外形,是视觉 AI 部署(包括边缘位置)的理想选择。

观看这个Metropolis Developer Meetup,按需了解有关 ViTs、NVIDIA TAO Toolkit 5.0 和 L4 GPU 的更多信息。