ONNX

2023年 4月 27日

基于 NVIDIA 的 PC 端到端人工智能:从 FP32 过渡到 FP16 优化人工智能

这篇文章是关于人工智能端到端优化。 人工智能模型的性能在很大程度上受到所使用计算资源的精度的影响。较低的精度可以提高处理速度和减少内存使用,

2 MIN READ

2023年 4月 25日

适用于基于 NVIDIA 的 PC 的端到端 AI : ONNX 和 DirectML

这篇文章是关于优化端到端人工智能. 虽然 NVIDIA 硬件可以以难以置信的速度处理构成神经网络的单个操作,

3 MIN READ

2023年 3月 15日

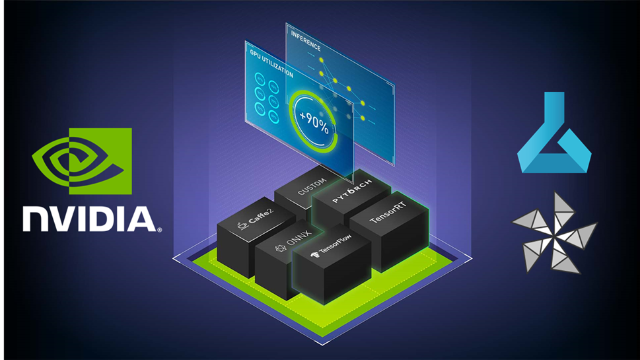

适用于基于 NVIDIA 的 PC 的端到端人工智能: NVIDIA TensorRT 部署

这篇文章是关于 优化端到人工智能 的系列文章中的第五篇。 NVIDIA TensorRT 是一种在 NVIDIA…

2 MIN READ

2023年 2月 8日

基于 NVIDIA 的 PC 的端到端 AI : ONNX Runtime 中的 CUDA 和 TensorRT 执行提供程序

这篇文章是 optimizing end-to-end AI 系列文章的第四篇。 有关更多信息,请参阅以下帖子:

2 MIN READ

2022年 12月 15日

工作站端到端 AI :优化简介

这篇文章是优化工作站端到端人工智能系列文章的第一篇。有关更多信息,请参见第 2 部分, 工作站端到端 AI : 使用 ONNX 转换 AI…

2 MIN READ

2022年 12月 15日

工作站端到端 AI :使用 ONNX 转换 AI 模型

这篇文章是优化工作站端到端人工智能系列文章的第二篇。有关更多信息,请参见第 1 部分, 工作站端到端 AI : 优化简介 和第 3 部分,

3 MIN READ

2022年 12月 15日

工作站端到端 AI : ONNX 运行时和优化

这篇文章是优化工作站端到端人工智能系列文章的第三篇。有关更多信息,请参见第 1 部分, 工作站端到端 AI :优化简介 和第 2 部分,

2 MIN READ

2022年 8月 29日

在 Azure 机器学习上提高人工智能模型推理性能

每个 AI 应用程序都需要强大的推理引擎。无论您是部署图像识别服务、智能虚拟助理还是欺诈检测应用程序,可靠的推理服务器都能提供快速、

4 MIN READ