本周发布的内容使用了 NVIDIA 优化过的 Mamba 聊天模型,您现在就可以在浏览器中体验。

本文是 Model Mondays 计划的一部分,该计划致力于让用户轻松访问先进的社区和 NVIDIA 构建的模型。 NVIDIA 使用 TensorRT-LLM 对这些模型进行优化,并以 。nemo 文件的形式提供,以便轻松进行自定义和部署。

NVIDIA AI 基础模型和端点 提供对社区和 NVIDIA 构建的一系列精心策划的生成式 AI 模型的访问权限,以便在企业应用程序中体验、自定义和部署。如果您尚未尝试使用领先的模型,例如 Nemotron-3, Mixtral 8X7B, Lama 70B 以及 稳定扩散,请在 NVIDIA AI Playground 中进行训练。

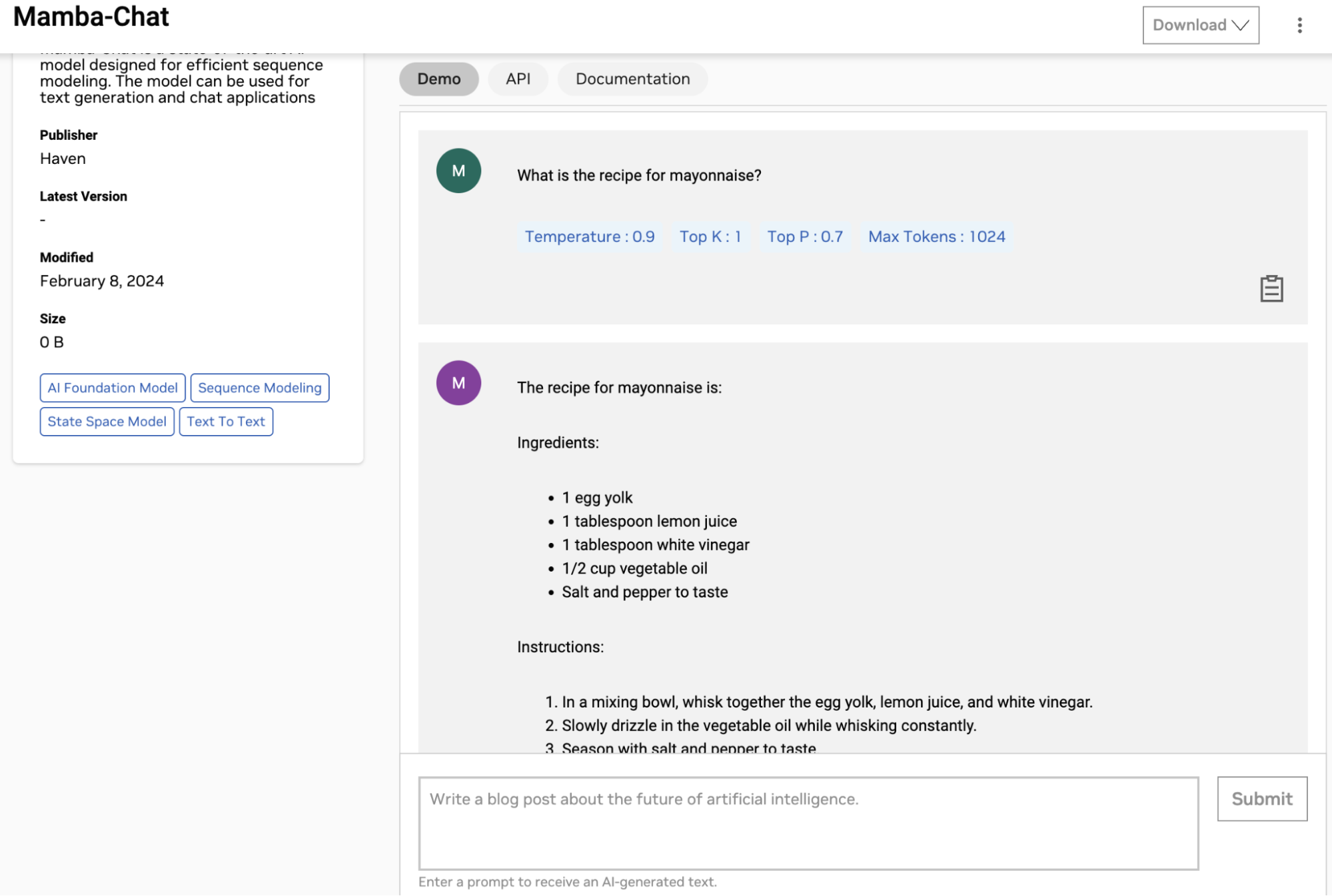

Mamba-Chat

Mamba-Chat 生成式 AI 模型由 Haven 发布,是一种先进的语言模型,它使用状态空间模型架构,将其与之前主导该领域的传统基于 Transformer 的模型区分开来。这种创新方法使 Mamba-Chat 能够更高效地处理更长的序列,而无需处理随输入长度二次扩展的计算复杂性。

相反,其架构支持序列长度的线性扩展,并集成了选择性聚焦机制。这显著增强了其以前所未有的效率处理大规模复杂数据集的能力。

2.8 B 模型在各种任务中表现出色。Mamba-Chat 通过针对特定应用程序(例如网络安全)的微调突出了其通用性,展示了其在专业知识领域的适应性和潜力。

该模型的效率使其特别适合各种应用,从聊天机器人交互到基因组学和时间序列数据分析等领域的复杂数据分析。

体验模型

NVIDIA 优化了 Mamba-Chat,现在您可以通过 NGC 目录上的简单用户界面直接在浏览器中进行体验。在Mamba-Chat Playground 输入您的提示,然后查看在完全加速的堆栈上运行的模型生成的结果。

您还可以使用 API 测试模型。登录 NGC 目录,然后访问 NVIDIA Cloud Credits,通过将应用程序连接到 API 端点来大规模体验模型。

开始使用

NVIDIA AI Enterprise 提供安全性、支持、稳定性和可管理性,以提高 AI 团队的生产力,降低 AI 基础架构的总成本,并确保从 POC 到生产的平稳过渡。当 AI 模型准备好部署以用于业务运营时,安全性、可靠性和企业级支持至关重要。

试用 Mamba-Chat 通过用户界面或 NGC 目录中的 API。