生成式 AI 为分析现有视频流开辟了全新可能。视频分析正从统计物体演进为将原始视频片段转化为实时理解,从而提供更具价值的可行见解。

NVIDIA AI Blueprint 针对视频搜索与摘要(VSS)需求,将视觉语言模型(VLM)、大语言模型(LLM)以及检索增强生成(RAG)技术相融合,并结合优化的视频内容提取、检索与存储工作流。作为 NVIDIA Metropolis 的组成部分,该方案支持高效的视频数据存储与实时视频理解能力。

在之前的版本中,VSS Blueprint 引入了高效视频提取、上下文感知 RAG、计算机视觉(CV)工作流和音频转录等功能。如需详细了解这些基础功能,请参阅使用 NVIDIA AI Blueprint 进行视频搜索和摘要的高级视频分析 AI 智能体和使用 NVIDIA AI Blueprint 构建视频搜索和摘要智能体。

本文将介绍 VSS Blueprint 2.4 版本中的新功能,该版本包含四大升级,使开发者能够:

- 增强对物理世界的理解:VSS 现已与 NVIDIA Cosmos Reason 集成,后者是一种先进的推理 VLM,可提供先进的物理 AI 推理和场景理解,从而实现更丰富的视频分析和见解。

- 增强问答:新的知识图功能和跨摄像头支持包括多流问答、改进的知识图生成、基于代理的图遍历、Neo4J 和具有 cuGraph 加速的 ArangoDB。

- 借助事件审查器在边缘解锁生成式 AI:审查 CV 流程中发现的感兴趣的事件,并利用生成式 AI 提供上下文见解。新端点支持将 VSS 配置为 CV 工作流的智能附加组件。这非常适合低延迟边缘部署。

- 借助扩展的硬件支持进行部署:VSS 现已在多个使用 NVIDIA Blackwell 构建的平台上提供,包括 NVIDIA Jetson Thor、NVIDIA DGX Spark 以及 NVIDIA RTX Pro 6000 工作站和服务器版本。

借助 Cosmos Reason 提高对物理世界的理解

Cosmos 推理是一个开放、可定制、包含 70 亿个参数的先进推理 VLM,适用于物理 AI。它使视觉 AI 智能体能够像人类一样,运用先前的知识、物理理解与常识进行推理,从而理解现实世界并采取行动。Cosmos 推理使开发者能够构建 AI 智能体,通过分析 PB 级的录制视频或数百万个实时视频流,在物理世界中观察、分析并采取行动。Cosmos 推理 NIM 现已推出,提供生产就绪的 VLM 端点,支持通过快速、可扩展的推理构建智能视觉 AI 智能体。

视频分析 AI 智能体 使用 VSS Blueprint 2.4 构建,可以通过 Cosmos Reason 提取准确且丰富的密集描述,利用 token 提示集列举感兴趣的对象,提供有价值的见解,并对来自多个行业(包括生产线、物流仓库、零售商店和运输网络)的视频片段进行根本原因分析。

VSS 2.4 支持与 Cosmos Reason 的原生集成。该功能将视频提取流程与视觉语言模型(VLM)深度结合,实现远超基于 REST API 的 VLM 接口的批处理效率与处理速度。Cosmos Reason 仅需 70 亿 token 的模型规模,便于在边缘端和云端灵活部署。该模型具备完整可定制性,并支持使用专有数据进行微调,为特定应用场景提供高效、可扩展的解决方案 blueprint。

借助知识图谱和交叉摄像头支持增强问答功能

提取大量视频内容具有挑战性,因为视频数据具有高度非结构化、连续性强且数据量巨大的特点,这使得搜索、索引或高效总结变得极为困难。单个视频可能包含数小时的片段,涵盖多个同时发生的事件,同时需要大量计算资源进行解码和分析。传统的计算机视觉工作流往往难以应对大规模数据处理的需求,常常在缺乏理解实际场景所需的全局上下文的情况下,产生孤立的检测结果。

VSS 通过采用 GPU 加速的视频摄取工作流解决了这一问题。当视频文件或直播流输入系统后,内容会被分解为较小的数据块,随后由 Cosmos Reason VLM 为每个数据块生成详细的描述。接着,大语言模型(LLM)从这些由 VLM 生成的描述中提取关键信息,构建出能够捕捉视频核心细节的知识图谱。知识图谱构建完成后,大语言模型将遍历该图谱,以准确回答用户针对视频内容提出的问题。

VSS 2.4 通过以下方式提升问答准确性和跨摄像头理解能力:

- 知识图谱中的实体重复

- 基于智能体的图遍历

- CUDA 加速的图形数据库

在之前的 VSS blueprint 版本中,构建知识图谱可能导致节点和边的重复。在 VSS blueprint 2.4 中,新增了知识图谱后处理功能,可自动删除重复条目,并合并视频中常见的节点与边。这意味着,像同一辆汽车在多个摄像头中移动这类常见实体,现在能够被合并为单一实体,从而提升 VSS 在跨视频和跨摄像头场景下对独立物体的理解能力。

生成知识图谱并完成后期处理后,系统将调用大语言模型(LLM)遍历该图谱,收集必要信息,以回答用户关于视频的问题。

在 VSS 2.4 中,引入了基于代理的推理,以实现高级知识图谱检索。启用后,基于 LLM 的智能体将智能地分解问题,然后利用一组工具搜索图谱、查找相关元数据、重新检查视频中的采样帧,并在必要时进行迭代,从而准确回答用户的问题。

| 基准测试 | VSS 2.3.1 准确率 | VSS 2.4 准确率 | VSS 准确率变化 |

| LongVideoBench | 48.16 | 64.32 | +16.16 |

| MLVU | 61.24 | 71.44 | +10.20 |

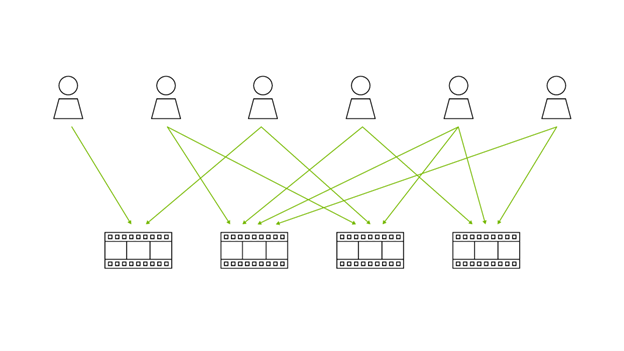

现在,可以利用知识图谱后处理来合并实体与关系,并通过基于智能体的高级检索来回答涉及多个摄像头流的问题。

为向开发者提供前沿工具,我们已将支持的 Graph 数据库后端扩展至包括 ArangoDB。用户现在可将 VSS 配置为使用 Neo4j 或 ArangoDB 作为图形数据库后端。ArangoDB 带来了一系列增强功能,包括支持 CUDA 加速的图形函数,可显著加快知识图谱的生成速度。

这些支持知识图谱生成和代理式问答的新功能非常适合处理大规模 LLM 和多个并发 VLM 请求的多 GPU 部署。

使用 VSS Event Reviewer 增强 CV 工作流

对于小规模和边缘部署,新的 VSS Event Reviewer 功能引入了 API 端点,可轻松将 VSS 集成到现有的计算机视觉工作流中,实现低延迟警报以及针对视频片段的直接 VLM 问答。

尽管标准的计算机视觉(CV)流程在检测物体、人员或通过分析识别事件(例如可能发生的车辆碰撞)方面表现出色,但通常会产生误报,并且缺乏对场景的更深层次理解。

VSS 可用于分析由 CV 系统标记的短视频片段,审查检测到的事件,并挖掘传统方法可能忽略的其他洞察,从而增强这些 CV 流程。

图 4 展示了 VSS 如何增强现有工作流。计算机视觉工作流指能够接收视频文件或流媒体,并输出感兴趣短片段的任何专有系统。随后,可调用 Event Reviewer 端点,将这些短视频片段传递给 VSS,以生成警报,并利用 VLM 追踪问答问题。

为演示此功能,我们使用 GroundingDINO,在 VSS GitHub 仓库中提供了 DeepStream 检测管道示例。该示例管道接收视频,执行检测,并在检测到的物体数量超过预设阈值时输出视频片段。此工作流旨在识别视频中需由 VSS 结合 VLM 进行审查的关键事件。

然后,VSS 将利用 VLM 针对用户定义的一组“是”/“否”问题对每个小片段进行处理。这些回答将被转换为每个问题的真/假状态,并可用于向用户生成低延迟警报。在 VSS 完成对短片的处理后,您可以提出更详细的后续问题。

该方法通过轻量级检测工作流识别出相关片段,并选择性地仅对这些片段使用 VLM。这种方式可减少 VLM 调用次数,释放 GPU 资源以支持其他工作负载,从而显著降低计算成本。

通过扩展的硬件支持灵活部署

VSS Blueprint 2.4 完全支持多个 NVIDIA Blackwell 平台,包括 NVIDIA RTX Pro 6000 服务器和工作站版本,以及用于边缘部署的 NVIDIA Jetson Thor。我们即将推出对 NVIDIA DGX Spark 的支持。

| 1 NVIDIA Jetson Thor | 1-2 NVIDIA RTX PRO 6000 Blackwell WS/SE | 4-8 NVIDIA RTX PRO 6000 Blackwell WS/SE | |

| LLM | N/A | Llama 3.1 8B | Llama 3.1 70B |

| VLM | Cosmos 原因 1 | Cosmos 原因 1 | Cosmos 原因 1 |

| 推荐使用方法 | 活动回顾 | 活动回顾 视频摘要 视频问答 (Vector RAG) | 活动回顾 文件摘要 视频问答 (Graph RAG) |

有关受支持平台的完整列表,请参阅 VSS 文档中的 Supported Platforms 部分。

开始使用视觉代理式 AI

新的 VSS Blueprint 2.4 版本将先进的视觉代理式 AI 功能引入边缘端,通过多项改进提升了问答准确性、跨摄像头理解能力,并扩展了平台支持。知识图谱的创建与遍历功能得到增强,进一步提高了问答的精准度,同时支持跨摄像头查询。

针对边缘部署和告警用例,Event Reviewer 功能可将 VSS 作为 CV 工作流的智能附加组件,实现低延迟告警。平台支持进一步扩展,包括 NVIDIA RTX PRO 和 NVIDIA THOR。

要快速开始使用 VSS blueprint,请通过 NVIDIA Brev Launchable 进行部署。Launchable 内容提供一键式快速部署功能,并包含 Jupyter Notebook,用于指导您如何启动 VSS、访问 Web UI 以及使用 VSS REST API。更多技术资源,例如训练用 Notebook 和参考代码,请访问 NVIDIA-AI-Blueprints/视频搜索和摘要 GitHub 仓库。如需解答技术问题,欢迎前往 NVIDIA 开发者论坛。

有关生产部署和 CSP 的详细信息,请参阅 VSS 文档的云服务部分。