AI 모델이 점점 더 대형화되고 아키텍처가 복잡해지면서, 연구자들과 엔지니어들은 AI 시스템을 실제 환경에 적용하기 위한 성능 최적화 및 비용 절감 기법을 끊임없이 개발하고 있습니다.

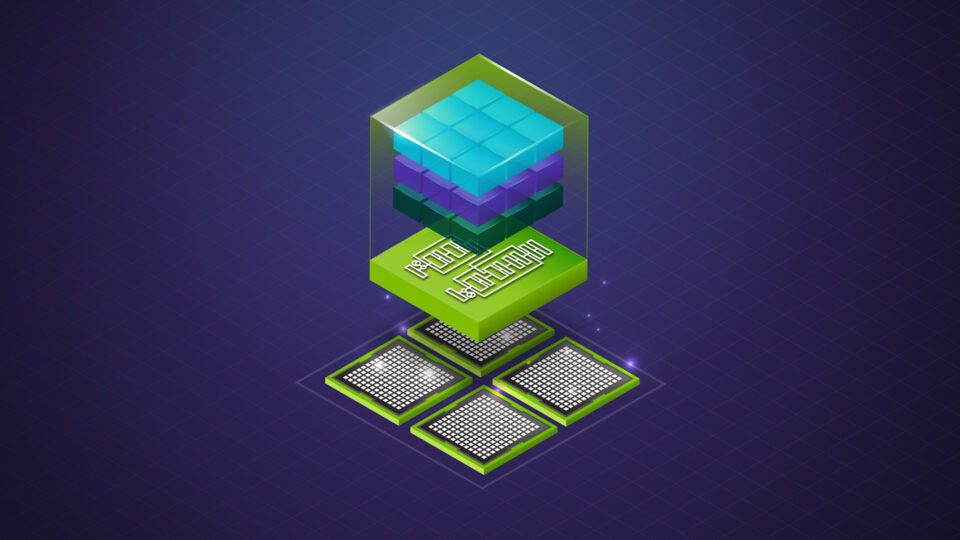

모델 최적화는 AI 추론 서비스의 성능과 효율을 높이기 위한 기술입니다. 이러한 기법은 비용을 절감하고 사용자 경험을 개선하며, 시스템 확장성을 높이는 데 가장 효과적인 방법으로 활용되고 있습니다. 간단하게 적용할 수 있는 양자화부터 프루닝이나 지식 증류처럼 여러 단계로 구성된 고급 최적화 방식까지 다양한 접근 방식이 존재합니다.

이 글에서는 NVIDIA Model Optimizer를 통해 활용할 수 있는 대표적인 모델 최적화 기법 5가지를 소개하고, 각 기법이 성능을 어떻게 향상시키고 총소유비용(TCO)을 줄이며, NVIDIA GPU 기반 시스템의 확장성을 높이는 데 어떤 역할을 하는지 살펴봅니다.

이러한 기법들은 현재 Model Optimizer에서 제공하는 가장 강력하고 확장성 높은 수단으로, AI 팀이 토큰당 비용을 절감하고 처리량을 높이며 대규모 추론을 가속화하는 데 즉시 활용할 수 있는 핵심 전략입니다.

1. 사후 학습 양자화 (Post-training Quantization)

사후 학습 양자화(PTQ)는 모델 최적화에 있어 가장 빠르고 간단한 접근법입니다. 기존에 학습된 모델(FP16, BF16, FP8 등)을 활용해, 별도의 학습 과정 수정 없이 FP8, NVFP4, INT8, INT4 등 더 낮은 정밀도의 형식으로 압축할 수 있습니다. 이를 위해 소량의 보정(calibration) 데이터셋만 사용하면 되며, 기존의 학습 루프는 건드릴 필요가 없습니다. 대부분의 팀이 이 단계부터 시작하는 것이 좋습니다. Model Optimizer를 통해 손쉽게 적용할 수 있으며, 대규모 파운데이션 모델에도 즉각적인 지연 시간 감소와 처리량 향상 효과를 제공합니다.

| 장점 | 단점 |

| – 가장 빠르게 효과를 얻을 수 있음 – 메모리 절감, 지연 시간 단축, 처리량 향상 등의 이점이 다른 최적화와 결합 가능 – NVFP4 기반 KV 캐시 등 맞춤형 양자화 레시피 활용 가능 | – 품질이 SLA 기준 이하로 떨어질 경우 QAT 또는 QAD 같은 다른 기법이 필요할 수 있음 |

표 1. PTQ 장단점

자세한 내용은 Optimizing LLMs for Performance and Accuracy with Post-Training Quantization를 참고하세요.

2. 양자화 인지 학습 (Quantization-Aware Training, QAT)

양자화 인지 학습(QAT)은 낮은 정밀도에 따른 오차를 보정하기 위해 짧고 집중적인 파인튜닝 단계를 추가하는 방식입니다. 순전파(forward pass) 과정에서 양자화 노이즈를 시뮬레이션하고, 역전파(backward pass)에서는 고정밀도로 그래디언트를 계산합니다. PTQ로는 정확도가 부족할 때, 추가적인 성능 향상이 필요한 경우 QAT가 그 다음 단계로 권장됩니다.

| 장점 | 단점 |

| –낮은 정밀도에서도 손실된 정확도를 대부분 또는 완전히 회복 가능 – NVFP4과 완전히 호환되며, 특히 FP4 정밀도에서 안정성 확보에 유리함 | – 학습을 위한 자원과 데이터가 필요함 – PTQ보다 구현에 시간이 더 걸림 |

표 2. QAT 장단점

자세한 내용은 How Quantization-Aware Training Enables Low-Precision Accuracy Recovery를 참고하세요.

3. 양자화 인지 증류 (Quantization-Aware Distillation, QAD)

양자화 인지 증류(QAD)는 QAT보다 한 단계 더 발전된 방식입니다. 이 기법에서는 학생 모델(student model)이 양자화 오차를 학습하는 동시에, 고정밀도 교사 모델(teacher model)에 정렬되도록 증류 손실(distillation loss)을 활용합니다. QAD는 QAT에 증류 원리를 결합해, 초저정밀도 추론 환경에서도 가능한 최고의 정확도를 유지할 수 있도록 도와줍니다. 특히, 양자화 이후 성능 저하가 심한 다운스트림 작업에 매우 효과적인 최적화 방식입니다.

| 장점 | 단점 |

| – 정확도 회복 효과가 가장 뛰어남 – 셋업이 간편하고 수렴이 안정적인 멀티스테이지 사후 학습 파이프라인에 적합 | – 프리트레이닝 이후 추가 학습 사이클 필요 – 더 큰 메모리 사용량 요구 – 구현 파이프라인이 다소 복잡함 |

표 3. QAD 장단점

자세한 내용은 How Quantization-Aware Training Enables Low-Precision Accuracy Recovery를 참고하세요.

4. Speculative Decoding

AI 모델 추론 단계의 디코딩 과정은 토큰을 하나씩 순차적으로 생성하기 때문에 처리 속도에 병목이 자주 발생하는 구간입니다. Speculative decoding은 이 문제를 해결하기 위해, EAGLE-3처럼 작고 빠른 드래프트 모델을 사용해 앞으로 나올 여러 토큰을 미리 예측하고, 이를 대상 모델이 병렬로 검증하는 방식으로 작동합니다. 이 기법은 모델 가중치를 변경하지 않고도, 긴 시퀀스 처리에서 필요한 순전파 횟수를 크게 줄일 수 있어 지연 시간을 효과적으로 단축할 수 있습니다.

Speculative decoding은 재학습이나 양자화 없이도 즉각적인 생성 속도 향상이 필요한 경우에 특히 유용하며, 이 글에서 소개하는 다른 최적화 기법들과도 자연스럽게 결합되어 지연 시간과 처리량을 더욱 개선할 수 있습니다.

| 장점 | 단점 |

| – 디코딩 지연 시간을 획기적으로 줄일 수 있음 – PTQ, QAT, QAD, NVFP4와 완벽하게 결합 가능 | – 튜닝이 필요하며, 수용률(acceptance rate)이 성능에 큰 영향을 미침 – 방식에 따라 두 번째 모델이나 별도 헤드가 필요할 수 있음 |

표 4. speculative decoding 장단점

자세한 내용은 An Introduction to Speculative Decoding for Reducing Latency in AI Inference를 참고하세요.

5. 프루닝 + 지식 증류 (Pruning plus Knowledge Distillation)

프루닝은 모델 구조 자체를 간소화하는 최적화 기법입니다. 이 방식은 가중치, 레이어, 또는 어텐션 헤드 등을 제거해 모델을 더 작게 만듭니다. 이후 지식 증류(distillation)를 통해, 작아진 모델이 더 큰 교사 모델처럼 사고할 수 있도록 학습시키는 과정을 거칩니다. 이러한 다단계 최적화 전략은 모델의 연산량과 메모리 사용량을 영구적으로 줄이기 때문에, 모델의 기본 성능 특성 자체를 바꾸는 효과가 있습니다.

프루닝과 지식 증류는 이 글에 소개된 다른 최적화 기법들로는 메모리나 연산량 절감이 부족할 때 고려할 수 있는 방법입니다. 또한, 기존 모델을 특정한 다운스트림 작업에 맞게 과감하게 수정할 준비가 되어 있는 팀이라면 적극적으로 활용할 수 있는 전략입니다.

| 장점 | 단점 |

| – 파라미터 수 감소 → 구조적이고 지속적인 비용 절감 효과 – 작지만 큰 모델처럼 동작하는 모델 구현 가능 | – 증류 없이 과도하게 프루닝하면 정확도가 급격히 하락할 – PTQ에 비해 파이프라인 구성과 구현에 더 많은 작업 필요 |

표 5. 프루닝 + 지식 증류 장단점

자세한 내용은 Pruning and Distilling LLMs Using NVIDIA TensorRT Model Optimizer를 참고하세요.

AI 모델 최적화 시작하기

모델 최적화 기법은 적용 방식도 다양하고, 그 효과 역시 서로 다릅니다. 이 글에서는 NVIDIA Model Optimizer를 통해 활용할 수 있는 대표적인 모델 최적화 기법 5가지를 소개했습니다.

- PTQ, QAT, QAD, 프루닝 + 증류는 모델 자체를 더 작고, 더 저렴하며, 메모리 효율적으로 만드는 구조적인 최적화 방식입니다.

- 반면, Speculative Decoding은 순차적 지연을 줄여 생성 속도를 근본적으로 향상시키는 방법입니다.

각 기법에 대한 자세한 기술 설명, 성능 분석, Jupyter Notebook 예제 등을 확인하려면 각 항목별 심화 게시물을 참고해 더 깊이 있게 살펴보세요.