몇 년 전, NVIDIA의 창립자 겸 CEO인 젠슨 황은 세계 최초의 NVIDIA DGX AI 시스템을 OpenAI에 선보였습니다. 그리고 현재 OpenAI의 ChatGPT는 전 세계를 강타하며 인공지능(AI)의 이점과 기능, 그리고 이를 중소기업이든 대기업이든 모든 산업과 비즈니스에 어떻게 적용할 수 있는지를 강조하고 있습니다.

그렇다면 ChatGPT를 호스팅하고 지원하는 데 필요한 기술과 인프라에 대해 생각해 본 적이 있나요?

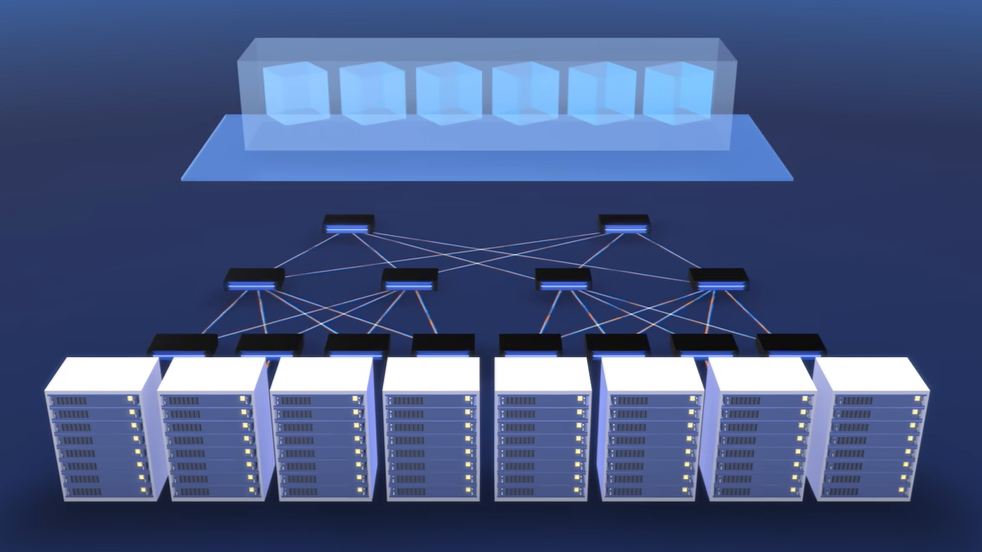

이 비디오에서는 Microsoft Azure CTO인 Mark Russinovich가 특수 목적으로 구축된 AI 슈퍼컴퓨터 인프라의 기술 스택에 대해 설명합니다. 이 인프라는 어떤 규모에서든 ChatGPT 및 기타 대규모 언어 모델(LLM)을 호스팅하기 위해 NVIDIA와 Microsoft Azure가 OpenAI와 협력하여 개발했습니다.

주요 내용

- 데이터 병렬 처리 접근 방식을 통해 추론 성능은 30배, 모델 트레이닝 성능은 4배 더 높은 NVIDIA H100 Tensor 코어 GPU를 사용했습니다.

- LLM의 더 높은 처리 요구 사항을 충족하기 위해 NVIDIA Quantum-2 InfiniBand 네트워킹으로 VM을 확장했습니다.

- 대규모 트레이닝에서는 서버 장애와 네트워크 플랩이 불가피합니다. Microsoft의 Project Forge는 투명한 체크포인팅을 도입하여 작업을 신속하게 재개하고 전 세계적으로 높은 수준의 활용도를 유지했습니다.

- 로우랭크 적응형(LoRA) 미세 조정은 수십억 개의 매개변수 모델을 대규모로 처리할 때 GPU 사용량과 체크포인트 크기를 줄여줍니다.

- Wayve와 같은 업계 선구자들은 컴퓨팅 집약적인 워크로드를 위해 AI 슈퍼컴퓨터 인프라를 활용하고 있습니다.

- 곧 출시될 Azure의 NVIDIA H100 GPU를 통한 컨피덴셜 컴퓨팅 지원은 민감한 데이터를 보호하고 사용 중인 귀중한 AI 모델을 보호하여 AI를 위한 안전한 다자간 협업 사용 사례를 가능하게 합니다.

요약

수천억 개의 매개 변수로 AI 모델을 학습할 때는 처리량을 늘리고 서버 장애를 최소화하는 것부터 컴퓨팅 집약적인 워크로드를 위한 멀티 GPU 클러스터를 활용하는 것까지 효율적인 데이터 센터 인프라가 핵심입니다.

대규모 모델을 안정적으로 배포하기 위해 데이터센터 인프라를 최적화하는 방법에 대한 자세한 내용은 다음 리소스를 참조하세요:

- NVIDIA AI 플랫폼: 컴퓨팅 및 소프트웨어에서 AI 모델 및 서비스에 이르는 풀스택 혁신으로 AI 개발을 더 쉽게 만드세요.

- 최신 데이터센터: IT 리더들이 어떻게 데이터센터를 확장하고 관리하여 NVIDIA AI를 쉽게 채택하고 있는지 알아보세요.

- H100 Tensor 코어 GPU: 결합된 기술 혁신으로 이전 세대보다 LLM 속도를 30배 높입니다.

- NVIDIA NeMo: 기업에서 LLM을 구축, 커스터마이징 및 배포하여 생성형 AI 애플리케이션을 구동할 수 있도록 지원합니다.

- NVIDIA Quantum InfiniBand 플랫폼

관련 리소스

- GTC 세션: 전문가와 소통하세요: 전문가 렌더링 및 가상화

- GTC 세션: 전문가와 소통하기: GPU 성능 분석 및 최적화

- GTC 세션: 2023년 봄 NVIDIA Omniverse 사용자 그룹

- SDK: GeForce Now 개발자 도구

- SDK: 비디오 코덱

- 웨비나: 화상 회의 도구에 대한 NVIDIA 가상 GPU의 영향