조 단위 매개변수 모델에 대해 흥미로운 점은 오늘날 많은 사용 사례가 있으며, 아래과 같은 작업의 용량이 증가할 수 있다는 점이며 최근 관심이 커지고 있습니다:

- 번역, 질문 답변, 추상화, 유창성과 같은 자연어 처리 작업.

- 장기적인 맥락을 파악하고 대화할 수 있는 능력

- 언어, 시각, 음성을 결합한 멀티모달 응용 기능

- 스토리텔링, 시 창작, 코드 생성과 같은 창의적인 응용 기능

- 단백질 폴딩 예측 및 신약 개발과 같은 과학적 응용 기능

- 일관된 개인성을 구현하고 사용자 컨텍스트를 파악하여 개인화할 수 있는 기능.

이점은 크지만 거대한 모델을 훈련하고 배포하는 데는 계산 비용이 많이 들고 리소스 집약적일 수 있습니다. 실시간 추론을 제공하도록 설계된 계산 효율적이고 비용 효율적이며 에너지 효율적인 시스템은 광범위한 배포에 매우 중요합니다. 새로운 NVIDIA GB200 NVL72는 이러한 작업에 적합한 시스템 중 하나입니다.

이를 설명하기 위해 전문가 혼합(MoE) 모델을 예로 들어보겠습니다. 이 모델은 여러 전문가(expert)에게 계산 부담을 분산하고 모델 병렬 처리 및 파이프라인 병렬 처리를 사용하여 수천 개의 GPU에 걸쳐 훈련합니다. 그 결과, 시스템의 효율성이 향상됩니다.

새로운 수준의 병렬 컴퓨팅, 고속 메모리, 고성능 통신을 통해 GPU 클러스터는 이러한 기술적 과제를 해결할 수 있습니다. 이 목표를 달성하는 NVIDIA GB200 NVL72 랙 스케일 아키텍처는 아래 글에서 자세히 설명합니다.

엑사스케일 AI 슈퍼컴퓨터를 위한 랙 스케일 설계

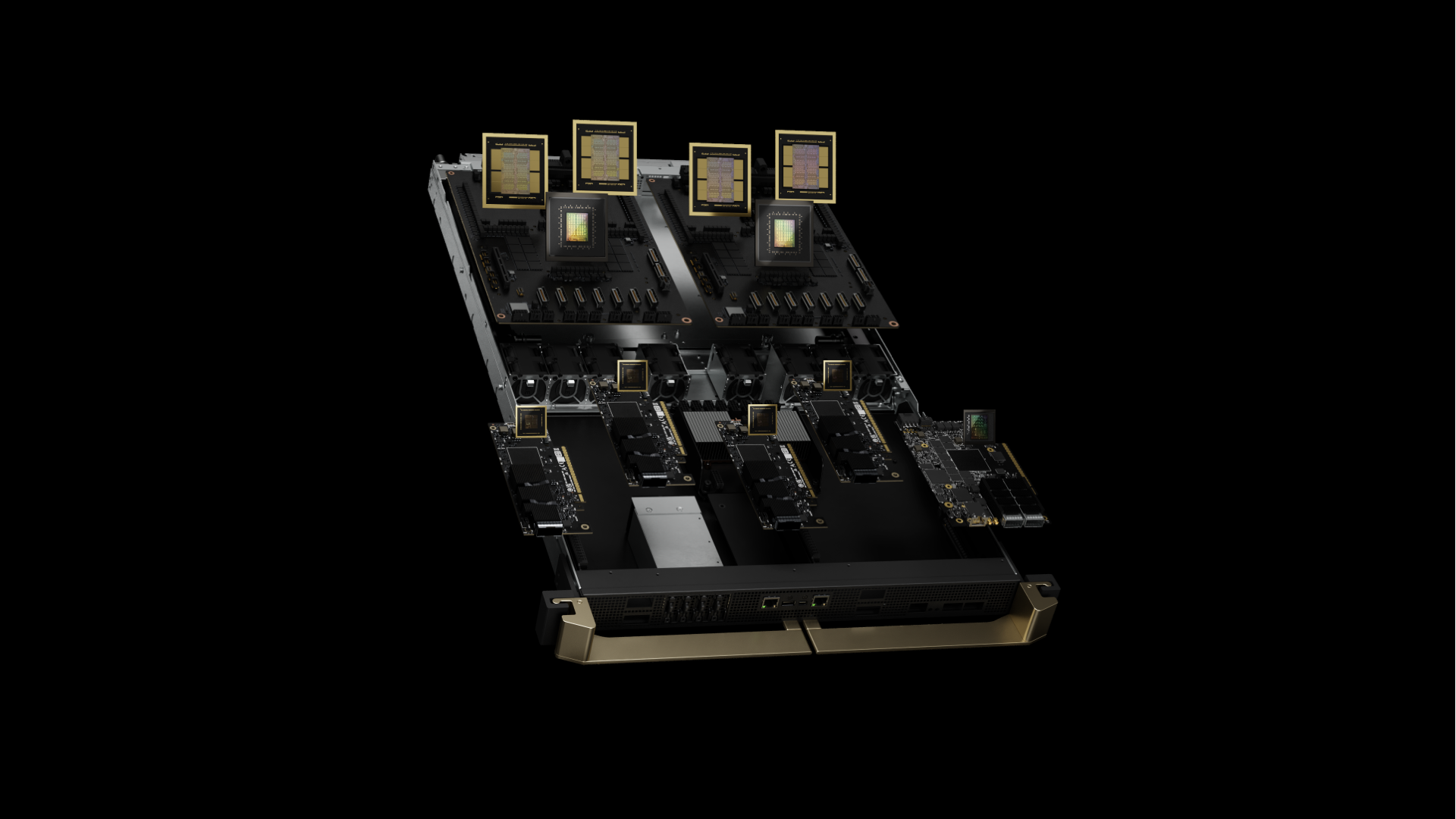

GB200 NVL72의 핵심은 NVIDIA GB200 Grace Blackwell 슈퍼칩입니다. 이 칩은 900GB/s의 양방향 대역폭을 제공하는 NVLink-C2C(Chip-to-Chip) 인터페이스를 통해 두 개의 고성능 NVIDIA Blackwell Tensor 코어 GPU와 NVIDIA Grace CPU를 연결합니다. 애플리케이션은 NVLink-C2C를 통해 통합 메모리 공간에 일관적으로 액세스할 수 있습니다. 따라서 프로그래밍이 간소화되고 1조 개 매개변수 LLM, 멀티모달 작업을 위한 트랜스포머 모델, 대규모 시뮬레이션용 모델, 3D 데이터를 위한 생성 모델 등의 대용량 메모리 요구 사항을 지원합니다.

GB200 컴퓨팅 트레이는 새로운 NVIDIA MGX 설계를 기반으로 합니다. 여기에는 2개의 Grace CPU와 4개의 Blackwell GPU가 포함되어 있습니다. GB200에는 액체 냉각을 위한 냉각판과 연결부, 고속 네트워킹을 위한 PCIe 6세대 지원, NVLink 케이블 카트리지용 NVLink 커넥터가 있습니다. GB200 컴퓨팅 트레이는 80페타플롭의 AI 성능과 1.7TB의 빠른 메모리를 제공합니다.

가장 큰 문제를 효율적으로 병렬 처리하려면 충분한 수의 획기적인 Blackwell GPU가 필요하므로 높은 대역폭과 낮은 지연 시간으로 통신하고 지속적으로 빠르게 움직여야 합니다.

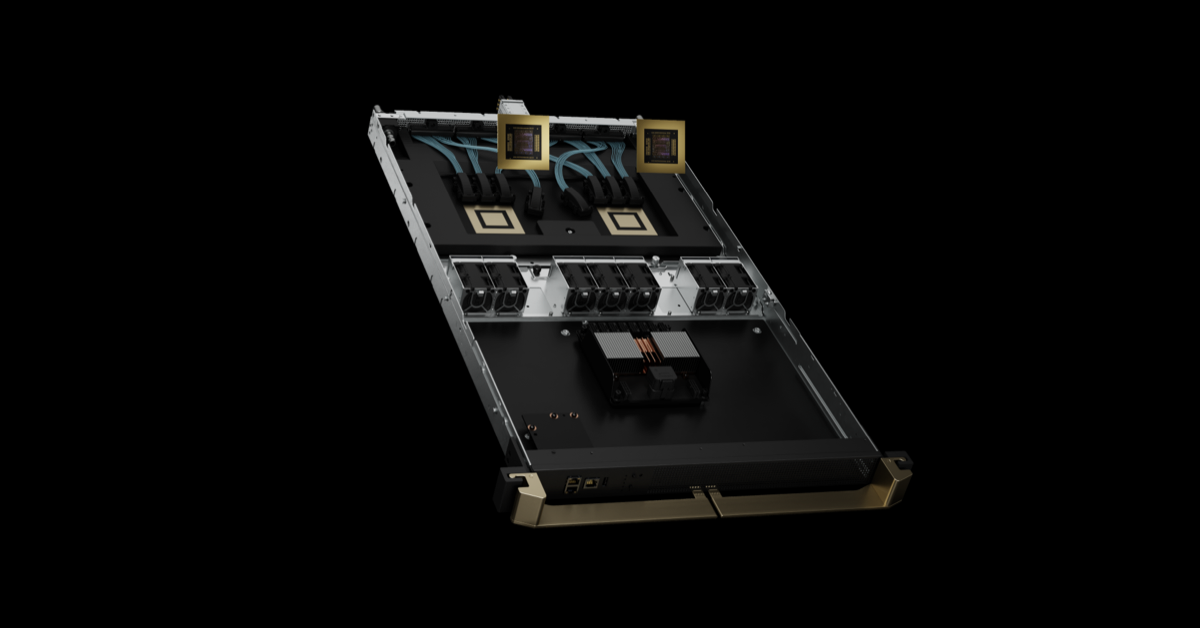

GB200 NVL72 랙 스케일 시스템은 9개의 NVLink Switch 트레이와 GPU와 스위치를 상호 연결하는 케이블 카트리지가 있는 NVIDIA NVLink Switch 시스템을 사용하여 18개의 컴퓨팅 노드에서 병렬 모델 효율성을 높입니다.

NVIDIA GB200 NVL36 및 NVL72

GB200은 NVLink 도메인에서 36개 및 72개의 GPU를 지원합니다. 각 랙은 MGX 레퍼런스 디자인 및 NVLink Switch 시스템을 기반으로 18개의 컴퓨팅 노드를 호스팅합니다. 하나의 랙에 36개의 GPU와 18개의 단일 GB200 컴퓨팅 노드가 있는 GB200 NVL36 구성으로 제공됩니다. GB200 NVL72는 하나의 랙에 72개의 GPU와 18개의 듀얼 GB200 컴퓨팅 노드로 구성되거나 2개의 랙에 72개의 GPU와 18개의 싱글 GB200 컴퓨팅 노드로 구성됩니다.

GB200 NVL72는 구리 케이블 카트리지를 사용하여 GPU를 조밀하게 패킹하고 상호 연결하여 작동을 간소화합니다. 또한 액체 냉각 시스템 설계를 사용하여 비용과 에너지 소비를 25배 낮춥니다.

5세대 NVLink 및 NVLink Switch 시스템

NVIDIA GB200 NVL72는 총 대역폭 1 PB/s 이상과 240TB의 고속 메모리로 단일 NVLink 도메인에서 최대 576개의 GPU를 연결하는 5세대 NVLink를 도입했습니다. 각 NVLink Switch 트레이는 100GB에서 144개의 NVLink 포트를 제공하므로 9개의 스위치가 72개의 Blackwell GPU에 있는 18개의 NVLink 포트 각각을 완전히 연결합니다.

GPU당 1.8TB/s의 혁신적인 양방향 처리량은 PCIe Gen5 대역폭의 14배 이상으로, 오늘날 가장 복잡한 대형 모델에 원활한 고속 통신을 제공합니다.

세대를 아우르는 NVLink

고속 저전력 SerDes를 위해 업계를 선도하는 NVIDIA의 혁신은 멀티 GPU 통신을 고속으로 가속화하는 NVLink의 도입을 시작으로 GPU 간 통신의 발전을 주도하고 있습니다. NVLink의 GPU 간 대역폭은 1.8TB/s로 PCIe 대역폭의 14배에 달합니다. 5세대 NVLink는 2014년에 도입된 1세대 160GB/s보다 12배 빠른 속도입니다. NVLink GPU 간 통신은 AI 및 HPC에서 멀티 GPU 성능을 확장하는 데 중요한 역할을 해왔습니다.

NVLink 도메인 크기의 기하급수적인 확장과 함께 GPU 대역폭의 발전은 2014년부터 576 Blackwell GPU NVLink 도메인의 총 대역폭을 1 PB/s로 900배 향상시켰습니다.

사용 사례 및 성능 결과

GB200 NVL72의 컴퓨팅 및 통신 성능은 전례 없는 수준으로, AI 및 HPC의 거대한 과제를 현실적인 범위 내에서 해결할 수 있게 해줍니다.

AI 트레이닝

GB200에는 FP8 정밀도를 갖춘 더 빨라진 2세대 트랜스포머 엔진이 포함되어 있습니다. GPT-MoE-1.8T와 같은 거대 언어 모델에 대해 32k GB200 NVL72로 4배 빠른 훈련 성능을 제공하므로 동일한 수의 NVIDIA H100 GPU와 비교하여 4배 더 빠른 성능을 제공합니다.

AI 추론

GB200은 LLM 추론 워크로드를 가속화하는 2세대 Transformer 엔진과 최첨단 기능을 도입했습니다. 이전 H100 세대에 비해 1.8T 매개변수 GPT-MoE와 같은 리소스 집약적인 애플리케이션에 30배 빠른 속도를 제공합니다. 이러한 발전은 FP4 정밀도와 5세대 NVLink의 다양한 장점을 도입한 차세대 Tensor 코어를 통해 가능해졌습니다.

토큰 간 지연 시간 = 50밀리초, 실시간 첫 토큰 지연 시간 = 5,000밀리초, 입력 시퀀스 길이 = 32,768, 출력 시퀀스 길이 = 1,024 출력, 8x 8방향 HGX H100 공냉식: 400GB IB 네트워크 대 18GB200 슈퍼칩 수냉식: NVL36, GPU 성능 비교 기준 결과입니다. 예상 성능은 변경될 수 있습니다.

데이터 처리

빅 데이터 분석은 조직이 인사이트를 확보하고 더 나은 정보에 기반한 의사 결정을 내리는 데 도움이 됩니다. 조직은 지속적으로 대규모 데이터를 생성하고 병목 현상을 완화하고 스토리지 비용을 절감하기 위해 다양한 압축 기술에 의존하고 있습니다. 이러한 데이터 세트를 GPU에서 효율적으로 처리하기 위해 Blackwell 아키텍처는 기본적으로 압축된 데이터를 대규모로 압축 해제하고 분석 파이프라인을 엔드투엔드 방식으로 속도를 높일 수 있는 하드웨어 압축 해제 엔진을 도입했습니다. 압축 해제 엔진은 기본적으로 LZ4, Deflate 및 Snappy 압축 형식을 사용해 압축된 데이터의 압축 해제를 지원합니다.

압축 해제 엔진은 메모리를 사용하는 커널 작업의 속도를 높여줍니다. 최대 800GB/s의 성능을 제공하며, 쿼리 벤치마크에서 CPU(Sapphire Rapids)보다 18배, NVIDIA H100 Tensor 코어 GPU보다 6배 빠른 성능을 발휘하는 Grace Blackwell을 사용할 수 있습니다.

이 엔진은 8TB/s의 초고속 메모리 대역폭과 Grace CPU 고속 NVlink-칩 투 칩(C2C)을 통해 데이터베이스 쿼리의 전체 프로세스 속도를 높입니다. 그 결과 데이터 분석 및 데이터 과학 사용 사례 전반에서 최고 수준의 성능을 제공합니다. 이를 통해 조직은 비용을 절감하면서 신속하게 인사이트를 얻을 수 있습니다.

물리 기반 시뮬레이션

물리 기반 시뮬레이션은 여전히 제품 설계 및 개발의 주축을 이루고 있습니다. 비행기와 기차에서 교량, 실리콘 칩, 심지어 의약품에 이르기까지 시뮬레이션을 통해 제품을 테스트하고 개선하면 수십억 달러를 절약할 수 있습니다.

애플리케이션별 집적 회로는 전압과 전류를 식별하기 위한 아날로그 분석을 포함하여 길고 복잡한 워크플로우를 통해 거의 독점적으로 CPU에서 설계됩니다. Cadence SpectreX 시뮬레이터는 이러한 솔루션의 한 예입니다. 다음 그림은 SpectreX가 x86 CPU보다 GB200에서 13배 더 빠르게 실행되는 것을 보여줍니다.

Cadence SpectreX(Spice 시뮬레이터) | CPU: 16코어 AMD Milan 75F3 데이터 세트: KeithC Design TSMC N5 | GB200의 성능 예상치는 변경될 수 있습니다.

지난 2년 동안 업계에서는 GPU 가속 전산 유체 역학(CFD)을 핵심 도구로 점점 더 많이 사용하고 있습니다. 엔지니어와 장비 설계자는 이를 사용하여 설계의 동작을 연구하고 예측합니다. 대형 와류 시뮬레이터(LES)인 Cadence Fidelity는 x86 CPU보다 GB200에서 최대 22배 빠른 속도로 시뮬레이션을 실행합니다.

케이던스 충실도(LES CFD 솔버)| CPU: 16코어 AMD Milan 75F3 데이터세트: GearPump 2M 셀 | GB200의 성능 예상치는 변경될 수 있습니다.

GB200 NVL72에서 케이던스 피델리티의 가능성을 살펴볼 수 있기를 기대합니다. 병렬 확장성과 랙당 30TB의 메모리를 통해 이전에는 포착할 수 없었던 흐름의 디테일을 포착하는 것을 목표로 합니다.

요약

요약하자면, GB200 NVL72 랙 스케일 설계를 검토했으며, 특히 단일 NVIDIA NVLink 도메인을 통해 72개의 Blackwell GPU를 연결하는 고유한 기능에 대해 알아봤습니다. 이를 통해 기존 네트워크를 통해 확장할 때 발생하는 통신 오버헤드를 줄일 수 있습니다. 그 결과, 1.8T 파라미터 MoE LLM에 대한 실시간 추론이 가능해졌으며 해당 모델을 4배 더 빠르게 훈련할 수 있게 되었습니다.

130TB/s 컴퓨팅 패브릭에서 30TB의 통합 메모리와 함께 72개의 NVLink 연결 Blackwell GPU를 작동하면 단일 랙에서 엑사플롭 AI 슈퍼컴퓨터를 생성할 수 있습니다. 이것이 바로 NVIDIA GB200 NVL72입니다.

관련 리소스

- GTC 세션: LLM 추론 사이징: 엔드투엔드 추론 시스템 벤치마킹하기

- GTC 세션: DGX 클라우드 및 OCI GPU 인프라를 통한 하이브리드 트레이닝 및 추론 활성화(Oracle 제공)

- GTC 세션: 텍스트 생성을 위한 TensorRT-LLM으로 LLM 최적화 및 확장하기(제공: Oracle)

- NGC 컨테이너: NVIDIA K8s 개발자 LLM 오퍼레이터

- NGC 컨테이너: NVIDIA MLPerf 추론

- NGC 컨테이너: NVIDIA MLPerf 추론