NVIDIA와 OpenAI는 2016년 NVIDIA DGX 출시를 시작으로 AI의 한계를 넓혀왔습니다. 이번에는 OpenAI의 gpt-oss-20b와 gpt-oss-120b 공개로 그 협력이 이어집니다. NVIDIA는 이 두 개의 오픈 가중치 모델을 NVIDIA Blackwell 아키텍처에 최적화해, NVIDIA GB200 NVL72 시스템에서 최대 초당 150만 토큰(TPS) 성능을 제공합니다.

gpt-oss 모델은 텍스트 추론 LLM으로, 체인 오브 쏘트(chain-of-thought)와 툴 호출(tool-calling) 기능을 지원합니다. 인기 있는 Mixture of Experts(MoE) 아키텍처와 SwigGLU 활성화를 사용하며, Attention 레이어는 128k 컨텍스트를 RoPE로 처리하고 풀 컨텍스트와 128토큰 슬라이딩 윈도우를 번갈아 적용합니다. 모델은 FP4 정밀도로 제공돼 80GB 데이터센터 GPU 한 장에 적재 가능하며 Blackwell에서 네이티브 지원됩니다.

이 모델들은 NVIDIA H100 Tensor Core GPU에서 학습됐으며, gpt-oss-120b는 210만 시간 이상, gpt-oss-20b는 그보다 약 10배 적은 시간으로 학습되었습니다. NVIDIA는 Hugging Face Transformers, Ollama, vLLM 등 주요 오픈소스 프레임워크와 함께 TensorRT-LLM을 활용해 커널 최적화와 모델 개선을 진행했습니다. 이 글에서는 NVIDIA가 gpt-oss를 자사 소프트웨어 플랫폼에 어떻게 녹여내 개발자들의 요구를 충족하는지 다룹니다.

| Model name | Transformer Blocks | Total Parameters | Active Params per Token | # of Experts | Active Experts per Token | Input Context Length |

| gpt-oss-20b | 24 | 20B | 3.6B | 32 | 4 | 128K |

| gpt-oss-120b | 36 | 117B | 5.1B | 128 | 4 | 128K |

표 1. OpenAI gpt-oss-20b와 gpt-oss-120b 모델 사양 – 총 파라미터, 활성 파라미터, 전문가 수, 입력 컨텍스트 길이 포함

NVIDIA는 OpenAI와 커뮤니티와 함께 성능을 극대화하기 위해 다양한 기능을 추가했습니다.

- Blackwell에서 Attention prefill, Attention decode, MoE 저지연 처리를 위한 TensorRT-LLM Gen

- Blackwell 전용 CUTLASS MoE 커널

- Hopper에서 특수 Attention 처리를 위한 XQA 커널

- LLM용 FlashInfer 커널 서빙 라이브러리를 통한 최적화된 Attention 및 MoE 라우팅 커널

- TensorRT-LLM과 vLLM에서 모두 사용되는 OpenAI Triton 커널 MoE 지원

vLLM으로 배포

NVIDIA는 vLLM과 협력해 Hopper와 Blackwell 아키텍처에서 정확성을 검증하고 성능을 분석·최적화했습니다. 데이터센터 개발자는 FlashInfer LLM 서빙 커널 라이브러리를 통해 NVIDIA 최적화 커널을 사용할 수 있습니다.

vLLM은 Python 의존성 관리를 위해 uv 사용을 권장합니다. vLLM을 사용하면 OpenAI 호환 웹 서버를 바로 띄울 수 있으며, 아래 명령을 실행하면 모델이 자동으로 다운로드되고 서버가 시작됩니다. 자세한 내용은 문서와 vLLM Cookbook 가이드를 참고하세요.

uv run --with vllm vllm serve openai/gpt-oss-20bTensorRT-LLM으로 배포

이 최적화 내용은 NVIDIA/TensorRT-LLM GitHub 저장소에서 확인할 수 있으며, 개발자는 배포 가이드를 활용해 고성능 서버를 실행할 수 있습니다. 가이드에서는 Hugging Face에서 모델 체크포인트를 다운로드하고, 새로운 모델과 함께 Transformers 라이브러리를 사용하는 개발자 경험을 NVIDIA가 함께 개선했습니다. 이후 Docker 컨테이너와 함께 저지연 모드와 최대 처리량 모드 모두에 대한 성능 설정 방법을 제공합니다.

GB200 NVL72로 초당 100만 토큰 이상 처리

NVIDIA 엔지니어들은 OpenAI와 공동으로 작업하여, 새로운 gpt-oss-120b와 gpt-oss-20b 모델이 Day 0부터 NVIDIA Blackwell과 NVIDIA Hopper 플랫폼 전반에서 최적의 성능이 나오도록 설계했습니다.

출시 시점 초기 성능 측정에 따르면, GB200 NVL72 랙 스케일 시스템 한 대는 연산량이 많은 gpt-oss-120b 모델을 초당 150만 토큰, 약 5만 명 동시 사용자 규모로 서비스할 수 있습니다. Blackwell은 추론 성능을 높이는 다양한 아키텍처적 특징을 갖추고 있으며, 여기에는 FP4 Tensor Cores가 적용된 2세대 Transformer Engine, 5세대 NVIDIA NVLink와 NVIDIA NVLink Switch가 포함됩니다. 이를 통해 72개의 Blackwell GPU를 하나의 거대한 GPU처럼 동작하게 할 수 있습니다.

NVIDIA 플랫폼의 성능, 유연성, 빠른 혁신 속도 덕분에 개발자와 기업은 Day 0부터 최신 모델을 높은 처리량과 낮은 토큰당 비용으로 서비스할 수 있습니다.

NVIDIA Launchable에서 최적화된 모델을 경험하세요

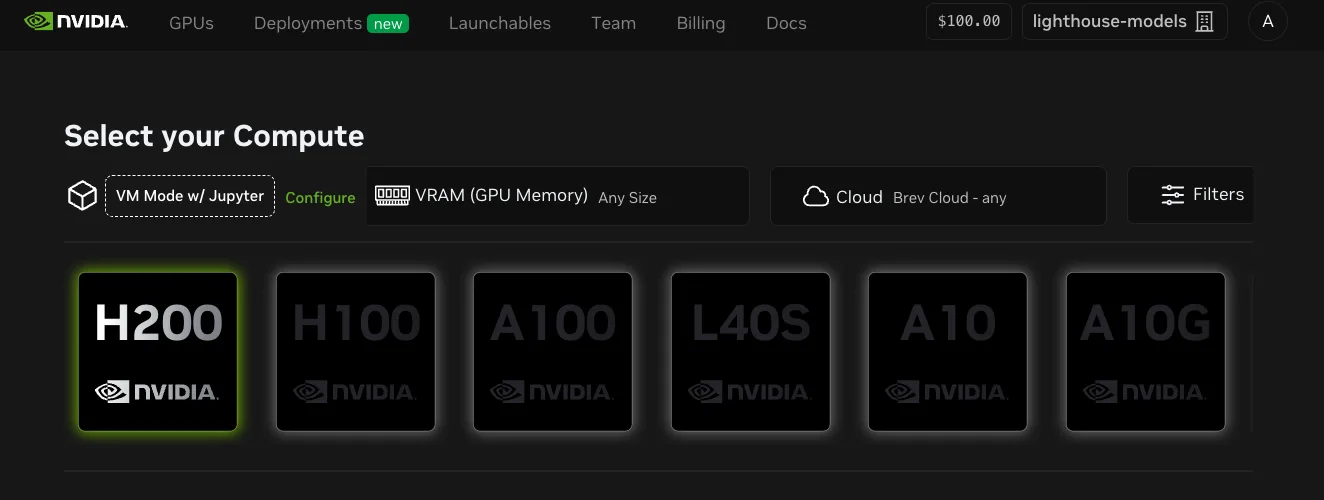

TensorRT-LLM은 OpenAI Cookbook의 JupyterLab 노트북에서 NVIDIA Launchable로 실행할 수 있으며, 여러 클라우드 GPU 옵션(H200, H100, A100 등)을 선택해 사전 구성된 환경에서 테스트할 수 있습니다.

NVIDIA Dynamo로 배포

Dynamo는 OpenAI gpt-oss 같은 최신 모델을 대규모 애플리케이션에 배포할 수 있도록 돕는 오픈소스 추론 서빙 플랫폼입니다. NVIDIA Dynamo와 TensorRT-LLM을 함께 사용해 gpt-oss-120b를 배포하면, 긴 입력 시퀀스(ISL) 처리에서 처리량을 줄이거나 GPU 예산을 늘리지 않고도 성능을 크게 향상할 수 있습니다. Blackwell에서 32k ISL 기준으로 인터랙션 성능이 4배 개선되며, 이는 Dynamo의 분산 서빙(disaggregated serving) 기법 덕분입니다. 이 기법은 추론의 여러 단계를 GPU별로 분리해 시스템 효율을 높입니다.

Dynamo는 주요 추론 백엔드와 연동되며, LLM-aware 라우팅, 탄력적 오토스케일링, 저지연 데이터 전송과 같은 기능을 제공합니다. 개발자는 이 가이드를 참고해 gpt-oss-120b 모델을 Dynamo로 배포할 수 있습니다.

로컬 NVIDIA GeForce RTX AI PC에서 실행

개발자는 AI를 로컬에서 실행해 더 빠른 반복 작업, 낮은 지연 시간, 더 높은 데이터 프라이버시를 확보할 수 있습니다. 두 모델 모두 NVIDIA RTX PRO GPU 기반의 프로 워크스테이션에서 실행 가능하며, gpt-oss-20b는 VRAM 16GB 이상의 GeForce RTX AI PC에서도 배포할 수 있습니다. 두 경우 모두 MXFP4 정밀도로 네이티브 실행됩니다. 개발자는 Ollama, Llama.cpp, Microsoft AI Foundry Local 같은 익숙한 앱과 SDK를 통해 모델을 체험할 수 있습니다. 시작하려면 RTX AI Garage를 확인하세요.

NVIDIA NIM으로 엔터프라이즈 환경 단순화

기업 개발자는 NVIDIA NIM Preview API와 NVIDIA API 카탈로그의 웹 플레이그라운드 환경을 통해 gpt-oss 모델을 무료로 체험할 수 있습니다. 모델은 NVIDIA NIM 마이크로서비스 형태로 제공돼, GPU 가속 인프라 어디서든 유연하게 배포할 수 있으며, 데이터 프라이버시와 엔터프라이즈급 보안을 보장합니다.

사전 패키징된 환경에 구애받지 않는, 최적화된 NIM 마이크로서비스 다운로드 및 배포:

gpt-oss 모델은 모든 레이어에 통합돼 NVIDIA 개발자 생태계 전반에서 제공되므로, 개발자는 자신에게 가장 적합한 솔루션을 선택해 사용할 수 있습니다. NVIDIA API Catalog UI에서 시작하거나, OpenAI Cookbook의 NVIDIA 개발자 가이드를 참고하세요.

관련 자료

- GTC 세션: LLM Inference Performance and Optimization on NVIDIA GB200 NVL72

- GTC 세션: Scaling Inference Using NIM Through a ServerLess NCP SaaS Platform

- GTC 세션: The Speed of Thought: Navigate LLM Inference Autoscaling for a Gen AI Application Toward Production

- NGC 컨테이너: NVIDIA MLPerf Inference

- SDK: TAO Toolkit