Posts by Ashraf Eassa

Data Center / Cloud

2023년 12월 15일

NVIDIA H100 Tensor 코어 GPU 및 NVIDIA TensorRT-LLM으로 최고의 추론 성능 달성하기

동급 최고의 AI 성능을 위해서는 효율적인 병렬 컴퓨팅 아키텍처, 생산적인 툴 스택, 고도로 최적화된 알고리즘이 필요합니다.

3 MIN READ

Data Center / Cloud

2023년 12월 6일

NVIDIA H200에서 거대 언어 모델 속도 향상을 제공하는 NVIDIA TensorRT-LLM

거대 언어 모델(LLM)은 지난 한 해 동안 급격한 성장을 거듭했습니다. 뛰어난 사용자 경험을 제공하기 위해서는 높은 컴퓨팅 처리량과 대량의…

3 MIN READ

Networking

2023년 7월 7일

새로운 MLPerf 추론 네트워크 디비전에서 NVIDIA InfiniBand 및 GPUDirect RDMA 기능을 선보입니다.

NVIDIA는 MLPerf 추론 v3.0에서 새롭게 도입된 네트워크 부문을 처음으로 제출했으며, 이는 이제 MLPerf 추론 데이터센터 제품군의…

5 MIN READ

Computer Vision / Video Analytics

2023년 6월 30일

NVIDIA H100 GPU로 MLPerf 트레이닝 기록 경신

빠르게 확장되고 있는 AI 기반 애플리케이션의 중심에는 강력한 AI 모델이 있습니다. 이러한 모델을 배포하려면 먼저 엄청난 양의 AI 컴퓨팅 성능이…

8 MIN READ

Networking

2023년 4월 19일

AI를 위한 풀스택 최적화를 통해 MLPerf 추론 v3.0에서 새로운 기록 수립

현재 가장 주목받는 컴퓨팅 애플리케이션은 복잡한 AI 모델을 학습하고 추론을 실행하는 데 의존하고 있으며, 종종 까다로운 실시간 배포 시나리오에서…

9 MIN READ

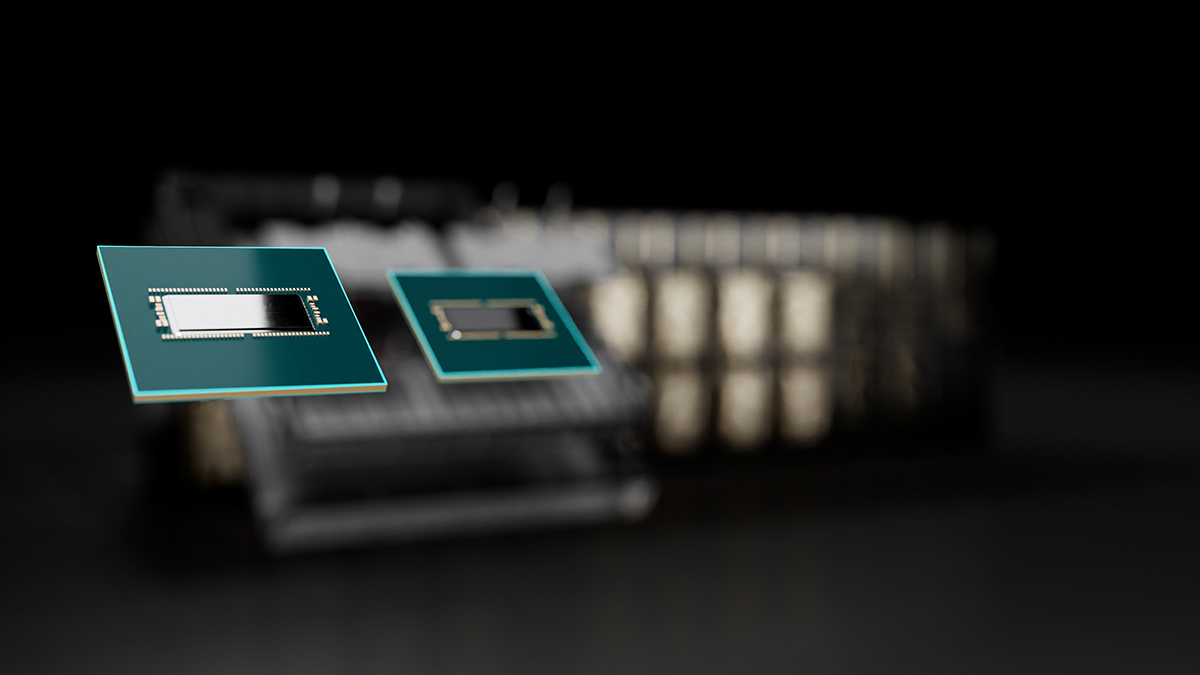

3세대 NVIDIA NVSwitch를 통한 멀티-GPU 인터커넥트 업그레이드

오늘날 AI 및 고성능 컴퓨팅(HPC)의 수요가 증가하면서 GPU 간 고속 통신과 함께 더욱 빠르고 확장 가능한 인터커넥트의 필요성도 함께 커지고…

8 MIN READ