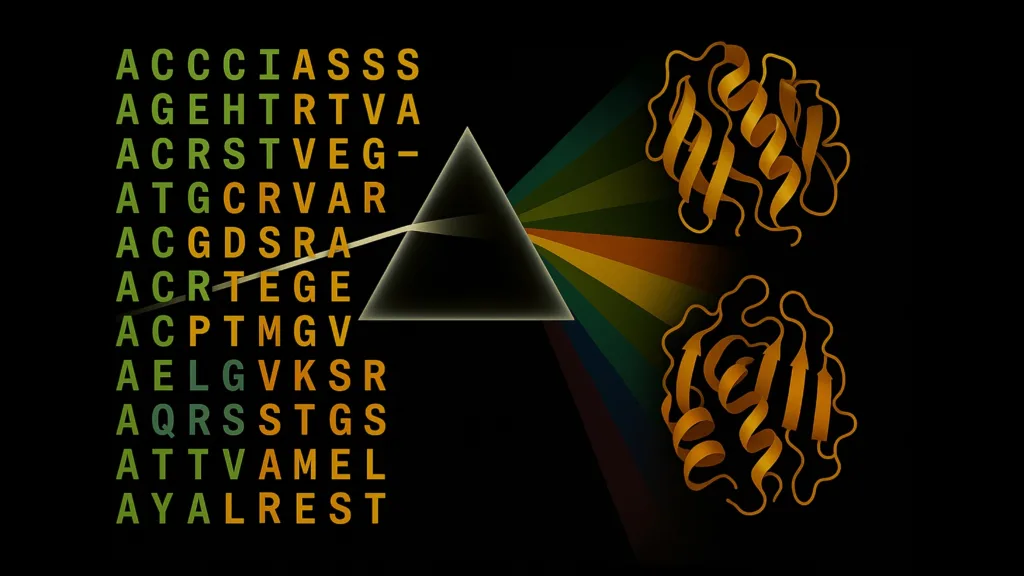

단백질 구조를 이해하기 위한 경쟁은 그 어느 때보다 중요해졌습니다. 신약 개발을 앞당기고 미래 팬데믹에 대비하기 위해서는, 단백질이 어떻게 접히는지를 예측하는 능력이 인류가 직면한 생물학적 난제를 해결할 열쇠가 됩니다. AlphaFold2의 등장 이후 단백질 구조 예측을 위한 AI 추론 수요는 급격히 증가하고 있습니다. 하지만 최적화되지 않은 도구들은 연구 시간 지연과 과도한 컴퓨팅 자원 사용으로 인해 수백만 달러의 손실을 초래할 수 있습니다.

NVIDIA RTX PRO 6000 Blackwell 서버 에디션 GPU는 이러한 문제를 근본적으로 해결합니다. AlphaFold2의 성과에도 불구하고, CPU에 의존한 다중 서열 정렬(MSA) 생성과 비효율적인 GPU 추론은 여전히 병목 요소로 남아 있었습니다. 이에 NVIDIA Digital Biology Research 랩은 기존 협업을 바탕으로, 정확도를 유지하면서도 OpenFold 기반 단백질 구조 추론 속도를 획기적으로 높이는 새로운 가속 기술을 개발하였습니다.

이번 포스트에서는 RTX PRO 6000 Blackwell Server Edition GPU를 활용해 대규모 단백질 분석을 수행하는 방법을 소개하고, 소프트웨어 플랫폼, 클라우드 서비스 제공업체, 연구 기관 등에서 단백질 구조 추론 성능을 비약적으로 향상시키는 방안을 살펴봅니다.

왜 단백질 구조 예측에서 속도와 확장성이 중요한가?

단백질 접힘은 계산 생물학에서 가장 높은 연산 성능을 요구하는 작업 중 하나입니다. 최신 신약 개발 파이프라인에서는 수천 개의 단백질 구조를 분석해야 하며, 동시에 효소 설계 프로젝트에서는 생물학적 기능을 최적화하기 위한 빠른 반복 작업이 필수적입니다. 농업 바이오테크 분야에서도 기후에 강한 작물을 개발하기 위해 방대한 단백질 라이브러리를 스크리닝해야 합니다.

이러한 계산 과제는 매우 방대해질 수 있습니다. 단일 단백질 구조 예측만 하더라도 메타게놈 수준의 MSA, 반복적인 정제 과정, 앙상블 계산이 포함되며, 일반적으로 수 시간 이상의 연산 시간이 소요됩니다. 이 작업을 전체 단백질체나 약물 표적 라이브러리 전체로 확장하면, CPU 기반 인프라에서는 현실적으로 감당하기 어려운 수준의 시간이 소요됩니다.

예를 들어, 다중 서열 정렬 도구를 직접 비교한 실험에서 MMseqs2-GPU는 단일 NVIDIA L40S GPU에서 128코어 CPU 기반 JackHMMER보다 177배 빠르게 정렬을 완료하였고, L40S 8개를 병렬로 활용할 경우 최대 720배까지 속도 향상을 기록하였습니다. 이러한 성능 향상은 GPU가 단백질 생물정보학 분야의 계산 병목 문제를 획기적으로 해소하고 있음을 보여줍니다.

NVIDIA는 어떻게 가장 빠른 단백질 구조 AI를 가능하게 했는가?

최근 공개된 cuEquivariance 및 Boltz-2 NIM 마이크로서비스 등의 기술을 기반으로, NVIDIA Digital Biology Research 랩은 RTX PRO 6000 Blackwell Server Edition과 NVIDIA TensorRT를 활용해 OpenFold에서 업계 표준 벤치마크 전반에 걸쳐 획기적인 성능 향상을 검증하였습니다.

새로운 명령어 세트와 TensorRT, MMseqs2-GPU, OpenFold를 RTX PRO 6000 Blackwell에서 결합하여 단백질 구조 예측에서 획기적인 성능을 구현하였습니다. 이 조합은 AlphaFold2보다 138배 이상, ColabFold보다 약 2.8배 빠르게 접힘(folding)을 수행하면서도 TM-score는 동일하게 유지합니다.

먼저, RTX PRO 6000 Blackwell에서 MMseqs2-GPU를 활용하여 추론 속도를 비약적으로 향상시켰습니다. 이 구성은 듀얼 소켓 AMD 7742 CPU에서 실행한 JackHMMER와 HHBlits보다 약 190배 빠르게 동작합니다. 여기에 OpenFold에 특화된 TensorRT 최적화를 적용해 추론 속도는 기존 OpenFold 대비 2.3배 향상되었습니다. 이러한 벤치마크는 CASP14의 20개 단백질 타깃을 기준으로 검증되었으며, RTX PRO 6000 Blackwell이 단백질 구조 예측 전체 파이프라인에 걸쳐 혁신적인 솔루션임을 입증합니다.

메모리 병목을 제거하다

또한, RTX PRO 6000 Blackwell은 96GB의 고대역폭 메모리(1.6TB/s)를 탑재해 대형 MSA와 전체 단백질 앙상블을 GPU 상에서 처리할 수 있습니다. 이를 통해 전체 추론 워크플로우가 GPU에 상주할 수 있어 메모리 병목을 제거합니다. Multi-Instance GPU(MIG) 기능을 통해 하나의 RTX PRO 6000 Blackwell을 최대 4개의 GPU처럼 사용할 수 있으며, 이 각각이 NVIDIA L4 Tensor Core GPU보다 높은 성능을 제공합니다. 이를 통해 여러 사용자 또는 워크플로우가 서버를 공유하더라도 속도나 정확도 저하 없이 작업을 수행할 수 있습니다.

다음은 RTX PRO 6000의 성능을 활용해 빠르게 단백질 구조를 예측하는 전체 예시입니다. 첫 번째 단계는 OpenFold2 NIM을 로컬 머신에 배포하는 것입니다.

# See https://build.nvidia.com/openfold/openfold2/deploy for

# instructions to configure your docker login, NGC API Key, and

# environment for running the OpenFold NIM on your local system.

# Run this in a shell, providing the username below and your NGC API Key

$ docker login nvcr.io

Username: $oauthtoken

Password: <PASTE_API_KEY_HERE>

export NGC_API_KEY=<your personal NGC key>

# Configure local NIM cache directory so the NIM model download can be reused

export LOCAL_NIM_CACHE=~/.cache/nim

mkdir -p "$LOCAL_NIM_CACHE"

sudo chmod 0777 -R "$LOCAL_NIM_CACHE"

# Then launch the NIM container, in this case using GPU device ID 0.

docker run -it \

--runtime=nvidia \

--gpus='"device=0"' \

-p 8000:8000 \

-e NGC_API_KEY \

-v "$LOCAL_NIM_CACHE":/opt/nim/.cache \

nvcr.io/nim/openfold/openfold2:latest

# It can take some time to download all model assets on the initial run.

# You can check the status using the built-in health check. This will

# return {"status": "ready"} when the NIM endpoint is ready for inference.

curl http://localhost:8000/v1/health/ready

NIM을 로컬에 배포한 후에는, 추론 요청을 구성하고 로컬 엔드포인트를 통해 단백질 구조 예측을 수행할 수 있습니다.

#!/usr/bin/env python3

import requests

import os

import json

from pathlib import Path

# ----------------------------

# parameters

# ----------------------------

output_file = Path("output1.json")

selected_models = [1, 2]

# SARS-CoV-2 proteome example

# Spike protein (1273 residues) — critical for vaccine development

sequence = (

"MFVFLVLLPLVSSQCVNLTTRTQLPPAYTNSFTRGVYYPDKVFRSSVLHSTQDLFLPFFSNVTWFHAIHVSGTNGTKRFDNPVLPFNDGVYFAST

EKSNIIRGWIFGTTLDSKTQSLLIVNNATNVVIKVCEFQFCNDPFLGVYYHKNNKSWMESEFRVYSSANNCTFEYVSQPFLMDLEGKQGNFKNL

REFVFKNIDGYFKIYSKHTPINLVRDLPQGFSALEPLVDLPIGINITRFQTLLALHRSYLTPGDSSSGWTAGAAAYYVGYLQPRTFLLKYNENGTITDAVD

CALDPLSETKCTLKSFTVEKGIYQTSNFRVQPTESIVRFPNITNLCPFGEVFNATRFASVYAWNRKRISNCVADYSVLYNSASFSTFKCYGVSPTKLNDLC

FTNVYADSFVIRGDEVRQIAPGQTGKIADYNYKLPDDFTGCVIAWNSNNLDSKVGGNYNYLYRLFRKSNLKPFERDISTEIYQAGSTPCNGVEGFNCY

FPLQSYGFQPTNGVGYQPYRVVVLSFELLHAPATVCGPKKSTNLVKNKCVNFNFNGLTGTGVLTESNKKFLPFQQFGRDIADTTDAVRDPQTLEILDITP

CSFGGVSVITPGTNTSNQVAVLYQDVNCTEVPVAIHADQLTPTWRVYSTGSNVFQTRAGCLIGAEHVNNSYECDIPIGAGICASYQTQTNSPRRARS

VASQSIIAYTMSLGAENSVAYSNNSIAIPTNFTISVTTEILPVSMTKTSVDCTMYICGDSTECSNLLLQYGSFCTQLNRALTGIAVEQDKNTQEVFAQV

KQIYKTPPIKDFGGFNFSQILPDPSKPSKRSFIEDLLFNKVTLADAGFIKQYGDCLGDIAARDLICAQKFNGLTVLPPLLTDEMIAQYTSALLAGTITSGWT

FGAGAALQIPFAMQMAYRFNGIGVTQNVLYENQKLIANQFNSAIGKIQDSLSSTASALGKLQDVVNQNAQALNTLVKQLSSNFGAISSVLNDILSRLD

KVEAEVQIDRLITGRLQSLQTYVTQQLIRAAEIRASANLAATKMSECVLGQSKRVDFCGKGYHLMSFPQSAPHGVVFLHVTYVPAQEKNFTTAPAICHD

GKAHFPREGVFVSNGTHWFVTQRNFYEPQIITTDNTFVSGNCDVVIGIVNNTVYDPLQPELDSFKEELDKYFKNHTSPDVDLGDISGINASVVNIQK

EIDRLNEVAKNLNESLIDLQELGKYEQYIKWPWYIWLGFIAGLIAIVMVTIMLCCMTSCCSCLKGCCSCGSCCKFDEDDSEPVLKGVKLHYT"

)

data = {

"sequence": sequence,

"selected_models": [1, 2],

"relax_prediction": False,

}

print(data)

# ---------------------------------------------------------

# Submit

# ---------------------------------------------------------

url = "http://localhost:8000/biology/openfold/openfold2/predict-structure-from-msa-and-template"

print("Making request...")

response = requests.post(url=url, json=data)

# ---------------------------------------------------------

# View response

# ---------------------------------------------------------

if response.status_code == 200:

output_file.write_text(response.text)

print(f"Response output to file: {output_file}")

else:

print(f"Unexpected HTTP status: {response.status_code}")

print(f"Response: {response.text}")

Protein AI 워크플로우 가속화 시작하기

과거에는 AlphaFold2를 실행하기 위해 이기종 고성능 컴퓨팅 노드가 필요했지만, RTX PRO 6000 Blackwell에서 cuEquivariance, TensorRT, MMseqs2-GPU 등의 모듈형 가속 컴포넌트를 활용하면 단일 서버에서도 세계 최고 수준의 속도로 단백질 접힘 예측을 수행할 수 있습니다. 이를 통해 단백질체(proteome) 규모의 구조 예측도 어느 실험실이나 소프트웨어 플랫폼에서 접근 가능해졌으며, 지금까지 중 가장 빠른 예측 시간을 실현할 수 있습니다.

신약 개발용 소프트웨어 플랫폼을 개발하든, 농업 바이오 기술 솔루션을 구축하든, 팬데믹 대비 연구를 수행하든, RTX PRO 6000 Blackwell의 압도적인 성능은 계산 생물학 워크플로우에 혁신을 가져올 것입니다. RTX PRO 6000 Blackwell Server Edition은 글로벌 시스템 제조업체의 NVIDIA RTX PRO 서버와 주요 클라우드 서비스 제공업체의 클라우드 인스턴스를 통해 오늘 바로 사용할 수 있습니다.

시작할 준비가 되셨나요? NVIDIA RTX PRO 6000 Blackwell 서버 에디션을 제공하는 파트너를 찾아, 전례 없는 속도와 규모의 단백질 접힘 예측을 직접 경험해 보십시오.

감사의 말

이번 연구에 기여한 NVIDIA, University of Oxford, 서울대학교의 연구진 여러분께 감사드립니다. Christian Dallago, Alejandro Chacon, Kieran Didi, Prashant Sohani, Fabian Berressem, Alexander Nesterovskiy, Robert Ohannessian, Mohamed Elbalkini, Jonathan Cogan, Ania Kukushkina, Anthony Costa, Arash Vahdat, Bertil Schmidt, Milot Mirdita, Martin Steinegger.