LLMs

2024 年 4 月 26 日

NeMo Retriever を使って Embedding モデルを簡単デプロイ

NeMo Retriever に含まれている NeMo Retriever Embedding Microservice を使用して Embedding モデルを簡単にデプロイする方法を解説します。

3 MIN READ

2024 年 3 月 20 日

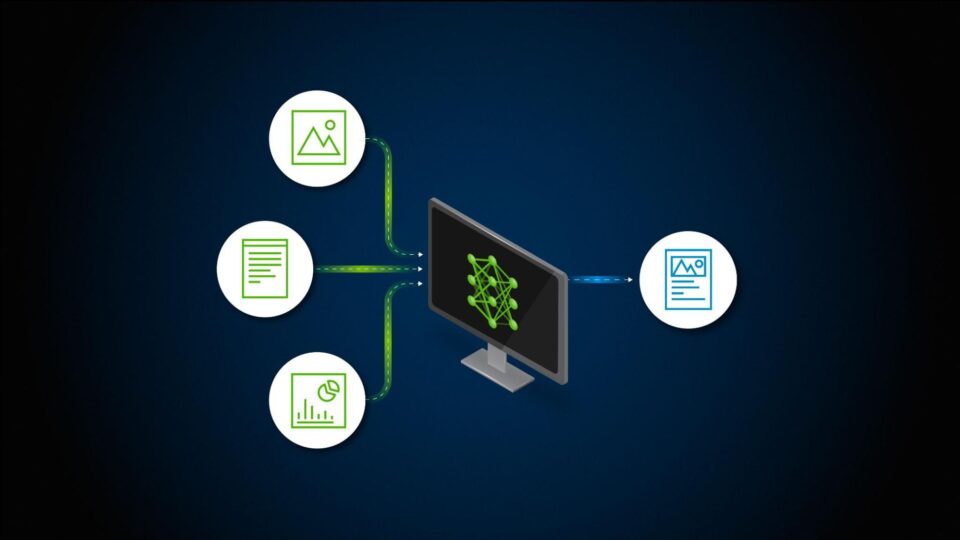

マルチモーダル検索拡張生成 (RAG) の簡単な紹介

マルチモダリティ (複数の種類のデータ) を扱う上での課題と、マルチモーダル RAG パイプラインを構築するためのアプローチについてご紹介します。

3 MIN READ

2024 年 3 月 14 日

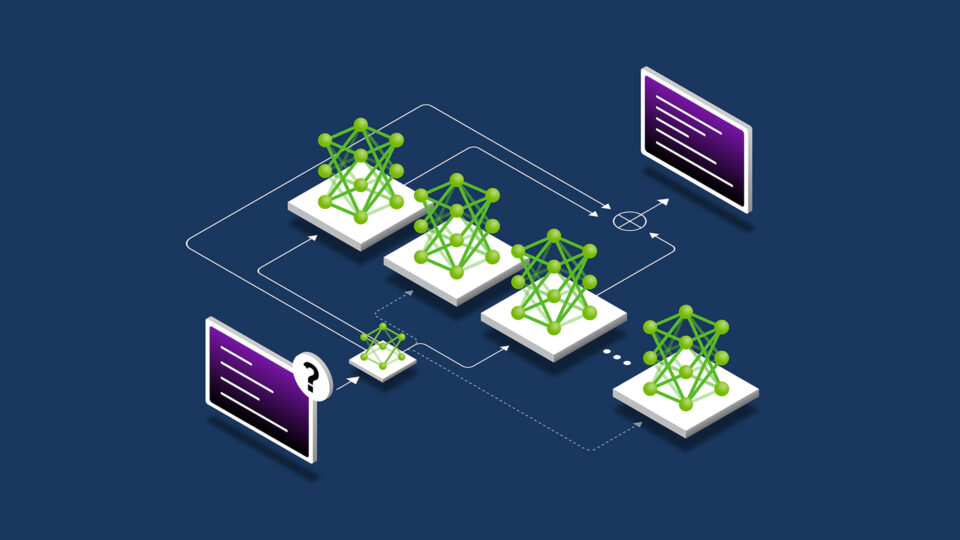

LLM アーキテクチャにおける Mixture of Experts の適用

Mixture of Experts (MoE) 大規模言語モデル (LLM) アーキテクチャは、GPT-4 などの商用の LLM と…

4 MIN READ

2023 年 11 月 17 日

LLM テクニックの習得: 推論の最適化

LLM 推論における最も差し迫った課題と、いくつかの実用的な解決策について説明します。

6 MIN READ

2023 年 11 月 16 日

LLM テクニックの習得: トレーニング

Transformer ネットワークを使用して構築された LLM の背後にある基本原則を、モデル アーキテクチャ、アテンション メカニズム、埋め込み手法、基盤モデルのトレーニング戦略にわたり説明します。

3 MIN READ

2023 年 11 月 15 日

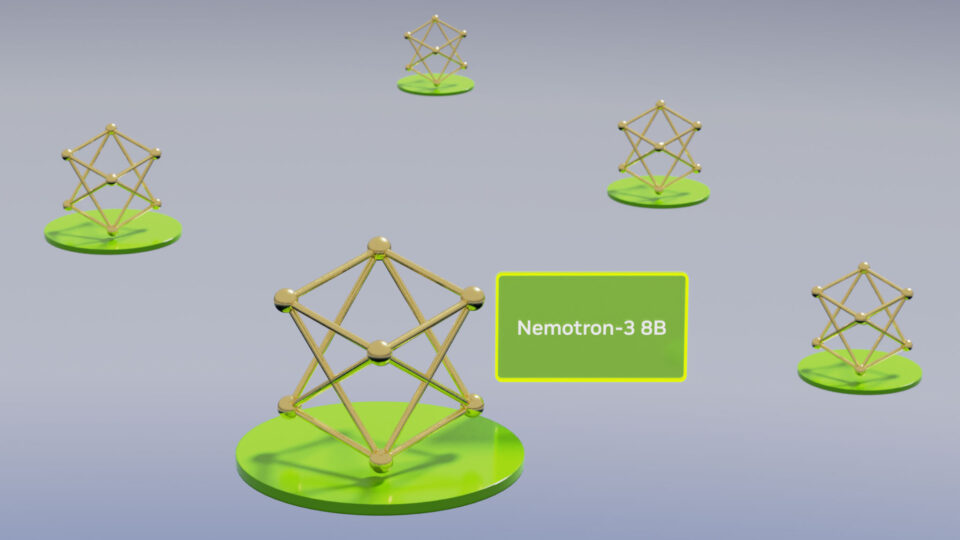

NVIDIA AI Foundation モデル: 本番利用可能な LLM を使用して、企業向けのカスタムチャットボットとコパイロットを構築

大規模言語モデル (LLM) は自然言語理解、AI、機械学習における高度な機能を実現し、データ サイエンスに革命をもたらしています。

3 MIN READ

2023 年 11 月 7 日

企業ソリューション向け大規模言語モデル (LLM) を始める

大規模言語モデル (LLM: Large :Language Models) とは、数千億のパラメーターを持つインターネット規模のデータセットで学習されるディープラーニングのアルゴリズムです。

3 MIN READ

2023 年 10 月 19 日

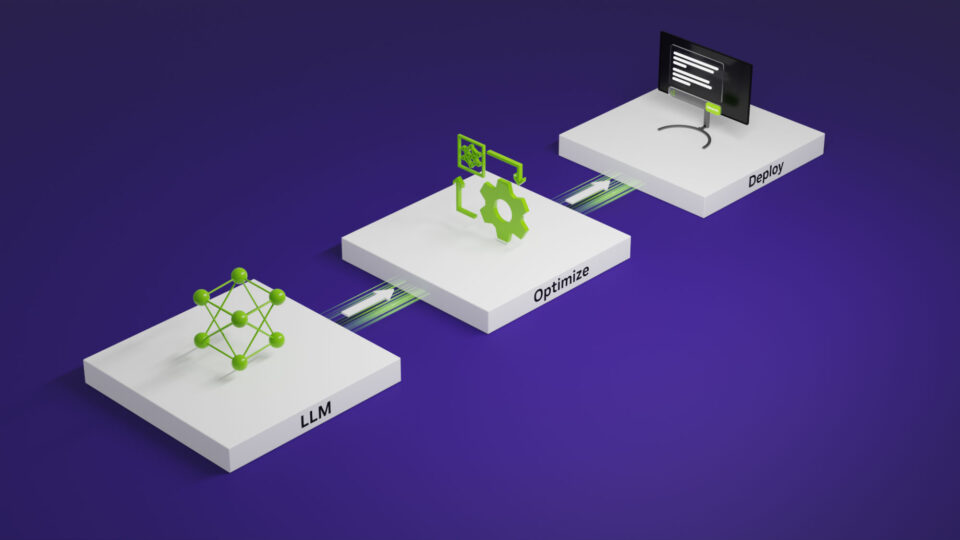

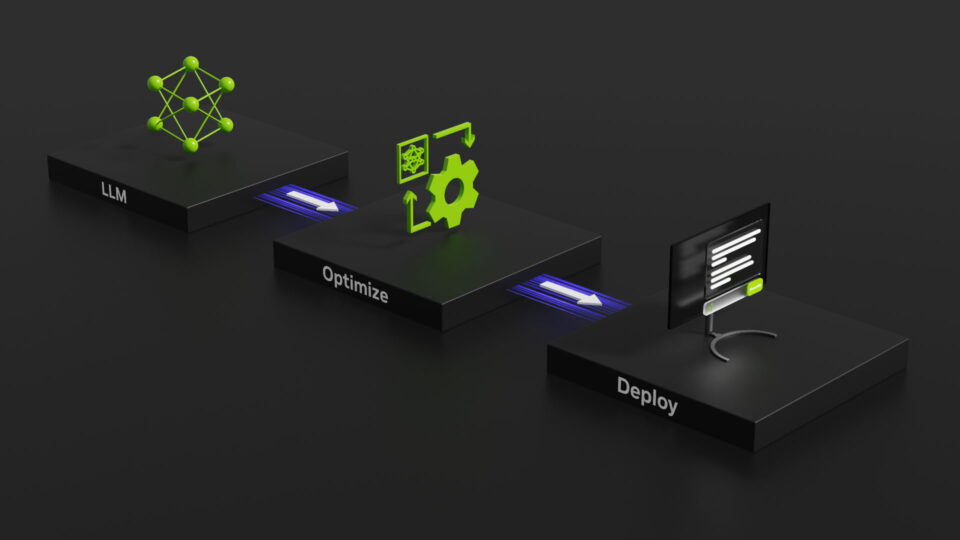

NVIDIA TensorRT-LLM で大規模言語モデルの推論を最適化

NVIDIA は、NVIDIA GPU 上の最新の LLMの推論性能を高速化および最適化する TensorRT-LLM の一般提供を発表しました。

3 MIN READ