从物理信息神经网络( PINN )到神经算子,开发人员长期以来一直在寻求通过实时传感器数据流构建实时数字双胞胎的能力,这种双胞胎具有真实形式的渲染、强健的可视化以及与现实世界中的物理系统的同步。 Modulus 的最新发布让我们更接近这个现实。

Modulus 22.03, 用于开发基于物理的机器学习模型的前沿框架,为开发人员提供了关键功能,如新颖的物理知识和数据驱动的人工智能架构,以及与 Omniverse ( OV )平台的集成。

本次发布朝着使用 Modulus OV 扩展为工程师和研究人员构建精确模拟和交互式可视化功能迈出了重要一步。这种增强得到了新的人工智能体系结构的支持,这种体系结构可以使用神经算子从数据中学习。在这个最新版本的模中添加了其他增强功能,以便于对湍流等问题进行精确建模,以及改进训练收敛性的功能。

有关这些新功能的详细信息,请参阅 Modulus 22.03 此处详述的注释 .

Omniverse 集成

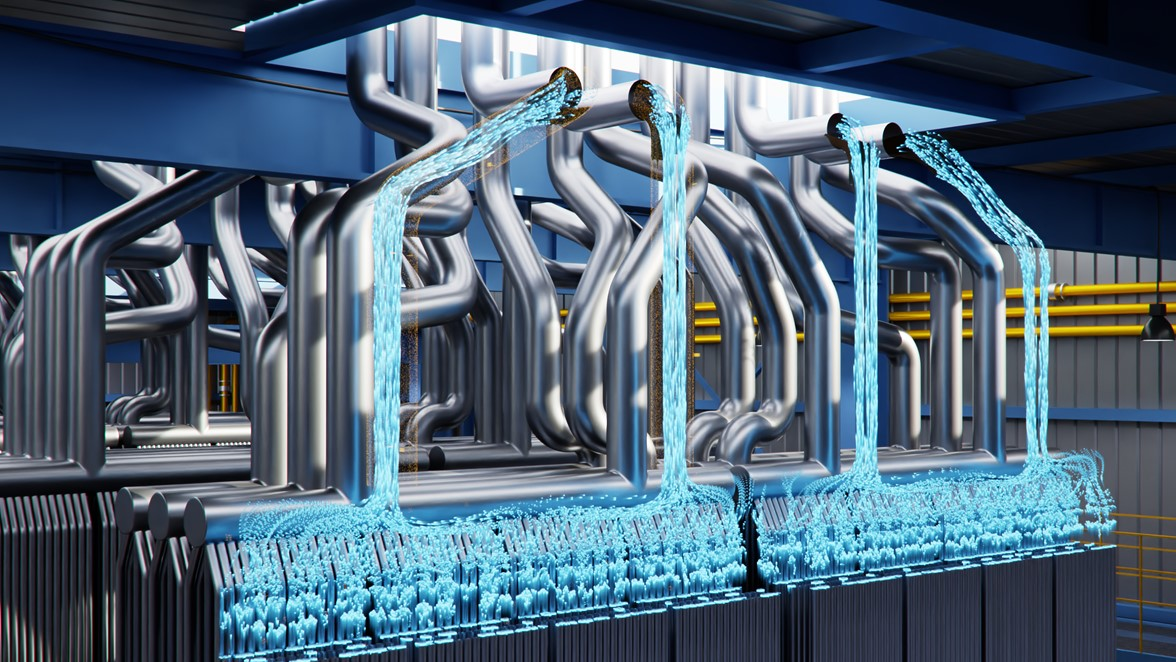

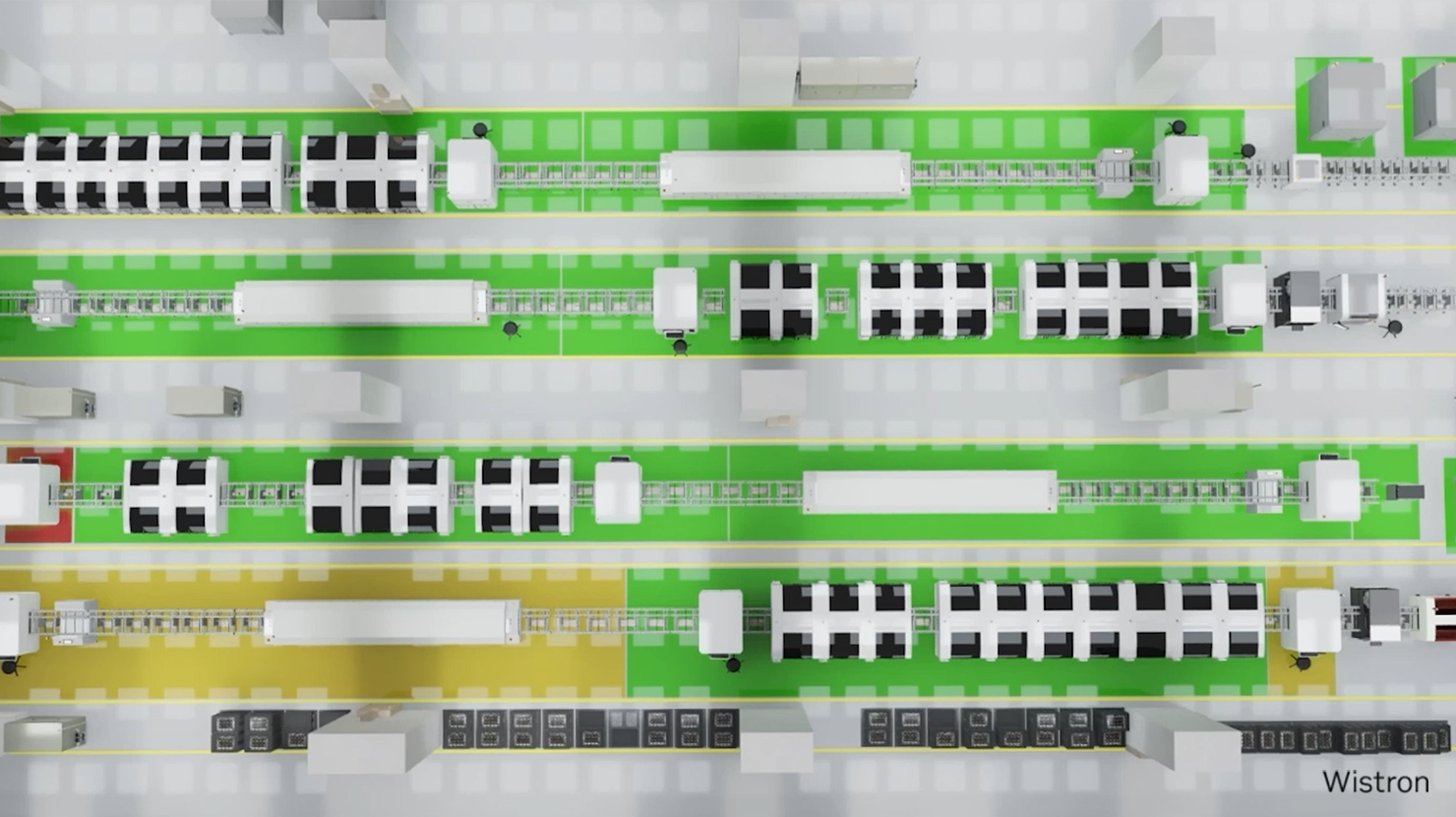

在 OV 集成中,训练和推理工作流基于 Python API ,生成的训练模型输出作为场景引入 OV ,使用此扩展。

该扩展可以将模训练模型的输出导入到常见场景(如流线和 iso 曲面)的可视化管道中。它还提供了一个界面,允许交互探索设计变量和参数,以推断新的系统行为。通过利用 Omniverse 中的这个扩展,您可以在数字孪生的上下文中可视化模拟行为。

新的网络架构

Modulus 现在支持神经运算符,如 FNO 、 AFNO PINO 和 DeepONet 架构。这使得数据驱动的物理机器学习模型能够用于有大量地面真实数据可供训练的用例。

- FNO: 受物理启发的神经网络模型,使用光谱空间中的全局卷积作为归纳偏差,用于训练物理系统的神经网络模型。它结合了重要的空间和时间相关性,这些相关性强烈地控制着许多可以用偏微分方程( PDE )描述的物理系统的动力学。

- AFNO: 一种自适应 FNO ,通过在操作员学习和标记混合之间建立联系,将自我注意力扩展到视觉转换器中的高分辨率图像。 AFNO 基于 FNO ,允许帧令牌混合作为连续的全局卷积,而不依赖于输入分辨率。由此产生的模型高度并行,具有准线性复杂度,序列大小具有线性记忆。

- PINO: PINO 是 FNO 的明确物理信息版本。 PINO 结合了操作学习和功能优化框架。在算子学习阶段, PINO 通过参数化 PDE 族的多个实例学习解算子。在测试时间优化阶段, PINO 优化 PDE 查询实例的预训练运算符 ansatz 。在 PINO tutorial 中了解更多信息。

- DeepONet: DeepOne 体系结构由两个子网络组成,一个子网络用于编码输入函数,另一个子网络用于编码位置,然后合并以计算输出。结果表明,与全连通网络相比,深网通过引入感应偏差来减少泛化误差。在 DeepONet Tutorial 中了解更多信息。

Modulus 支持这些不同的体系结构,使我们的用户生态系统能够选择适合其用例的正确方法。

更多关键增强功能

- 两个方程( 2-eqn .)湍流模型 : 支持两方程湍流( k-e 和 k-w )模型,用于模拟充分发展的湍流。文档中包含了使用墙函数的通道情况( 1D 和 2D )的参考应用程序。它展示了两种墙功能(标准和流槽剥落)。在 2-eqn tutorial 中了解更多信息。

- 损失平衡的新算法: 为了提高收敛性,引入了三种新的损耗平衡算法,即梯度范数、随机回溯的相对损耗平衡(ReLoBRaLo)和软适应。这些算法根据不同损失的相对训练率动态调整损失权重。

此外,还加入了神经切线核( NTK )分析。 NTK 是一种神经网络分析工具,用于指示每个组件的收敛速度。它将为不同损失条件下的权重提供一个可解释的选择。通过对损失的均方误差进行分组,可以实时计算 NTK 。 - 支持新的优化器: Modulus 现在支持 30 多个优化器,包括内置的 PyTorch 优化器和 火炬优化器库。 包括对 AdaHessian 的支持, AdaHessian 是一个二阶随机优化器,它近似于 Hessian 对角线的指数移动平均值,用于梯度向量的自适应预处理。

NVIDIA Modulus 现在可通过 NVIDIA 开发者专区免费下载。