推理因其灵活性而成为边缘计算的杀手级应用。今天,边缘推理(也称为边缘 AI)解决了各个行业的问题:防止盗窃、发现疾病和减少农田中除草剂的使用。但对许多人来说,管理分布式边缘服务器的复杂性可能会侵蚀业务价值。

边缘人工智能数据中心在一个位置上没有 10000 台服务器。它在 10000 个位置有一个或多个服务器,通常位于没有物理安全或训练有素的 It 人员的位置。因此,边缘人工智能服务器必须安全、有弹性,并且易于大规模管理。

这就是为什么组织正在转向云本地技术来管理其边缘 AI 数据中心。

什么是云本机?

定义 Cloud Native 就像一个关于蒙着眼睛描述大象的笑话。你是在摸象牙、鼻子还是尾巴?

- 对于 IT 管理员来说,云本机意味着以代码形式管理基础设施。

- 软件开发人员使用云本地工具和技术来编写可移植应用程序。

- IT 主管们拥抱云文化以降低成本并提高效率。

结合这些观点, Cloud Native 是一种现代的软件开发方法,它使用抽象和自动化来支持可扩展性、可移植性和快速交付。

容器化微服务是云本地应用程序的有效标准。Kubernetes是容器编排的市场领先平台。它使用 de Clara 动态 API 支持大规模自动化。

Cloud native 诞生于公共云,但它正在企业中迅速传播。 Gartner 预测,容器编排市场将增长到到 2024 年为 9 . 44 亿美元。

云计算基础( CNCF )为生态系统提供供应商中立的治理。 CNCF 策划并支持开源、云本地软件项目。 Containerd 、 Prometheus 和 Kubernetes 是 CNCF 维护的热门项目。

为什么边缘 AI 使用云计算?

云本机与边缘计算有何关联?为大规模公共云构建的工具能否使具有一个或两个节点的边缘位置受益?

简而言之,答案是肯定的。云本机架构提供的不仅仅是巨大的可扩展性。它还提供性能、恢复力和易管理性,这些都是 edge AI 的关键功能。

性能

在过去 15 年中,企业倾向于使用虚拟机( VM )将应用程序整合到更少的服务器上。但是虚拟化开销会降低应用程序性能。

边缘 AI 偏爱容器。在边缘,性能是王者。自动驾驶汽车必须在“看到”行人时猛踩刹车。容器以全裸金属性能运行。而且许多容器可以共享同一台服务器,从而整合应用程序,而无需虚拟化带来的性能开销。

Kubernetes 还可以通过优化工作负载布局来提高边缘 AI 性能。 CPU 管理策略为特定工作负载隔离 CPU。这减少了上下文切换和缓存未命中。设备插件框架将加速器(如 GPU 或 FPGA )暴露在吊舱中。拓扑管理器将 CPU 、内存和加速器资源沿 NUMA 域对齐,从而减少昂贵的跨 NUMA 流量。

业务和管理

边缘人工智能数据中心 MIG ht 跨越数百个位置。云原生工具支持公共云的大规模可扩展性,管理员可以使用相同的工具来管理边缘 AI 数据中心。

第一天的操作包括初始部署和测试。 Kubernetes 具有足够的灵活性,能够在第一天就支持不同的体系结构。

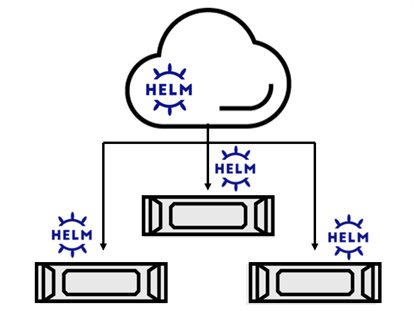

在一个极端,整个 edge 数据中心是一个 Kubernetes 集群。此体系结构需要在集中式 API 端点和远程工作者之间进行可靠通信。 API 端点通常是基于云的。

在另一个极端,每个边缘节点都是一个独立的集群,并维护自己的控制平面和应用程序。这种体系结构适用于间歇性或不可靠的集中式通信。

Kubernetes 还支持集群联合。联邦集群共享单一的应用程序配置源,但在其他方面是独立的。联合适用于松散耦合的边缘站点。例如,医院系统可以联合起来共享患者数据。

部署第一天之后,边缘数据中心管理将转移到第二天操作。更新、升级和监视是第二天的操作。自动化和远程第二天操作对于缺乏本地支持人员的边缘位置的稳定性和安全性至关重要。

云本机生态系统包括许多用于集中观察的流行工具。Prometheus是一个开源的监视和警报工具包。Grafana是一个开源的可观察性工具,可以在图形仪表板中显示数据。

软件生命周期管理也是第二天操作的一个重要方面。修补 VM 映像需要长时间的测试。容器与其依赖项捆绑在一起,并通过稳定的接口与内核交互。这使 CI / CD 和其他支持边缘快速变化的云本机实践成为可能。

应用弹性

弹性是指应用程序克服问题的能力。这是 cloud native 让 edge AI 受益的另一个领域。

云本地应用程序通常通过扩展提供恢复能力。同一应用程序的多个克隆在负载平衡器后面运行,当克隆失败时,服务将继续。

这种方法在应用程序跨越两个或多个节点的边缘 AI 部署中效果良好。但许多边缘人工智能数据中心每个位置只有一个节点。

Kubernetes 还支持单节点上的应用程序恢复能力。容器重启策略自动重新启动故障吊舱, Kubelet 可以使用活性探针检测需要重新启动的非故障条件。

edge AI 基础设施软件也应该具有弹性。Kubernetes 算子模式将基础设施管理置于自动驾驶状态,自动执行人工通常执行的任务。例如,在边缘节点上检测到内核升级的 Kubernetes 操作符将自动将节点的驱动程序重新编译为新的内核版本。

挑战

Cloud native 提供了弹性和性能,同时简化了操作。这些是边缘 AI 的关键考虑因素。然而,仍有一些领域必须继续发展云计算。

超低延迟边缘应用程序需要更好地了解底层硬件。例如,确定 CPU 中哪个内核的延迟最低。容器编排平台还希望改进多租户的工作负载隔离。云原生边缘 AI 的好处和挑战只是我们在即将到来的虚拟 GTC 人工智能会议十一月会议上探讨的边缘计算主题之一。今天注册,请务必查看探索云本机边缘 AI课程以及我们的其他边缘计算主题。