人工智能的快速发展正在推高数据集的规模,以及网络的规模和复杂性。支持人工智能的应用程序,如电子商务产品推荐、基于语音的助手和呼叫中心自动化,需要数十到数百个经过培训的人工智能模型。推理服务帮助基础设施管理人员部署、管理和扩展这些模型,并在生产中保证实时服务质量( QoS )。此外,基础架构经理希望提供和管理用于部署这些 AI 模型的正确计算基础架构,最大限度地利用计算资源,灵活地放大或缩小规模,以优化部署的运营成本。将人工智能投入生产既是一项推理服务,也是一项基础设施管理挑战。

NVIDIA 与谷歌云合作,将 CPU 和 GPU 通用推理服务平台 NVIDIA Triton Inference Server的功能与谷歌 Kubernetes 引擎( GKE )相结合,使企业更容易将人工智能投入生产。NVIDIA Triton Inference Server 是一个托管环境,用于在安全的谷歌基础设施中部署、扩展和管理容器化人工智能应用程序。

使用 NVIDIA Triton 推理服务器在谷歌云上的 CPU 和 GPU 上提供推理服务

在企业应用程序中操作 AI 模型带来了许多挑战——为在多个框架中培训的模型提供服务,处理不同类型的推理查询类型,并构建一个能够跨 CPU 和 GPU 等多个部署平台进行优化的服务解决方案。

Triton 推理服务器通过提供一个单一的标准化推理平台来解决这些挑战,该平台可以从任何基于 TensorFlow 、TensorRT、 PyTorch 、 ONNX 运行时、 OpenVINO 或自定义 C ++/ Python 框架的本地存储或谷歌云的托管存储在任何基于 GPU 或 CPU 的基础设施上部署经过培训的 AI 模型。

在 GKE 集群上一键部署 NVIDIA Triton 推理服务器

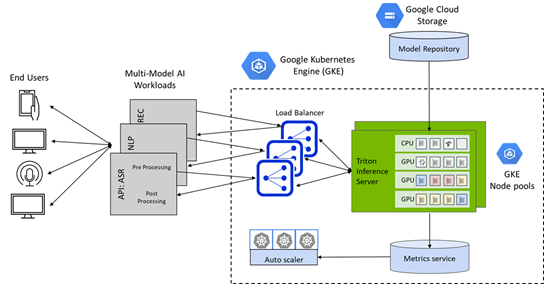

Google Kubernetes Engine ( GKE )上的 Triton 为部署在 CPU 和 GPU 上的 AI 模型提供了通用推理服务平台,并结合了 Kubernetes 群集管理、负载平衡和基于需求的自动缩放计算的方便性。

使用谷歌市场上新的一键式 Triton GKE 推理服务器应用程序,可以将 Triton 无缝部署为 Google Kubernetes Engine ( GKE )管理的集群上的容器化微服务。

GKE 的 Triton 推理服务器应用程序是一个 helm chart 部署程序,可自动安装和配置 Triton ,以便在具有 NVIDIA GPU 节点池的 GKE 集群上使用,包括 NVIDIA A100 Tensor Core GPU s 和 NVIDIA T4 Tensor Core GPU s ,并利用谷歌云上的 Istio 进行流量进入和负载平衡。它还包括一个水平 pod autoscaler ( HPA ),它依赖堆栈驱动程序自定义度量适配器来监控 GPU 占空比,并根据推理查询和 SLA 要求自动缩放 GKE 集群中的 GPU 节点。

要了解有关 Google Kubernetes Engine ( GKE )中一键式 Triton 推理服务器的更多信息,请查看此谷歌云和 NVIDIA 的深度博客,了解解决方案如何扩展以满足严格的延迟预算,并优化 AI 部署的运营成本。

您还可以在 8 月 25 日注册参加“使用 NVIDIA NGC 和谷歌云构建计算机视觉服务”网络研讨会,学习如何通过结合 NGC 目录中的 NVIDIA GPU – 优化预训练模型和转移学习工具包( TLT )以及 GKE 的 Triton 推理服务器应用程序,在谷歌云上构建端到端的计算机视觉服务。