随着大语言模型(LLM)规模的不断扩大,其智能水平也显著提升,领先开发者推出的开放模型已具备数千亿参数。与此同时,当前先进模型普遍具备推理能力,能够在输出最终结果前生成大量中间推理令牌。模型规模的扩大与推理过程中对更多令牌的使用,这两大趋势共同推动了对计算性能大幅提升的需求。

要实现生产工作负载的卓越性能,需依托涵盖芯片、系统与软件的先进技术堆栈,并持续构建基于该堆栈的庞大开发者生态系统。

MLPerf Inference v5.1 是 MLPerf 推理行业标准基准测试的最新版本。该基准测试每年举办两次,涵盖多项人工智能推理性能测试,并持续引入新模型与新场景以保持时效性。本轮测试的主要特点包括:

- DeepSeek-R1 – 由 DeepSeek 开发的热门模型,包含 6710 亿个参数的混合专家 (MoE) 推理模型。在服务器场景中,优先令牌时间 (TTFT) 值为 2 秒,目标值为 12.5 个令牌/ 秒/ 用户 (TPS/ 用户) 。所有 TPS/ 用户目标均为第 99 百分位,这意味着 99% 的 token 达到或超过该 TPS/ 用户速度。

- Llama 3.1 405B – MLPerf Inference v5.1 为最大的 Llama 3.1 系列模型添加了一个新的交互式场景,与现有的服务器场景相比,为每个用户提供了更快的 12.5 TPS 和 4.5 秒的 TTFT 要求。

- Llama 3.1 8B – Llama 3.1 系列模型的 80 亿参数成员,具有离线、服务器 ( 2 秒 TTFT,10 TPS/ 用户) 和交互式 ( 0.5 秒 TTFT,33 TPS/ 用户) 场景。这将取代前几轮中使用的 GPT-J 基准测试。

- Whisper – 是一种热门语音识别模型,最近在 HuggingFace 上一个月内下载量接近 500 万次。这将取代之前版本的 MLPerf 推理基准测试套件中采用的 RNN-T。

在本轮测试中,NVIDIA 采用了今年3月发布的全新 Blackwell Ultra 架构,并提交了首批测试结果。距离 Blackwell 架构首次在 MLPerf Inference v5.0 的可用类别中亮相仅过去六个月,便已创下新的推理性能纪录。此外,NVIDIA 平台在本轮新增的所有基准测试(包括 DeepSeek-R1、Llama 3.1 405B、Llama 3.1 8B 和 Whisper)中均实现了性能突破,并在其余所有 MLPerf 推理基准测试中持续保持单 GPU 的领先性能表现。

| MLPerf 推理记录基准测试 | |||

| 每个加速器 | 离线 | 服务器 | Interactive |

| DeepSeek-R1 | 5,842 tokens/ 秒/ GPU | 2,907 tokens/ 秒/ GPU | ** |

| Llama 3.1 405B | 224 tokens/ 秒/ GPU | 170 tokens/ 秒/ GPU | 138 tokens/ 秒/ GPU |

| Llama 2 70B 99.9% | 12,934 tokens/ 秒/ GPU | 12,701 tokens/ 秒/ GPU | 7,856 tokens/ 秒/ GPU |

| Llama 2 70B 99% | 13,015 tokens/ 秒/ GPU | 12,701 tokens/ 秒/ GPU | 7,856 tokens/ 秒/ GPU |

| Llama 3.1 8B | 18,370 tokens/ 秒/ GPU | 16,099 tokens/ 秒/ GPU | 15,284 tokens/ 秒/ GPU |

| Stable Diffusion XL | 4.07 samples/ 秒/ GPU | 3.59 queries/ 秒/ GPU | ** |

| Mixtral 8x7B | 16,099 tokens/ 秒/ GPU | 16,131 tokens/ 秒/ GPU | ** |

| DLRMv2 99% | 87,228 samples/ 秒/ GPU | 80,515 samples/ 秒/ GPU | ** |

| DLRMv2 99.9% | 48,666 samples/ 秒/ GPU | 46,259 queries/ 秒/ GPU | ** |

| Whisper | 5,667 tokens/ 秒/ GPU | ** | ** |

| R-GAT | 81,404 samples/ 秒/ GPU | ** | ** |

| Retinanet | 1,875 samples/ 秒/ GPU | 1,801 queries/ 秒/ GPU | ** |

MLPerf Inference v5.0 和 v5.1,封闭分区。结果于 2025 年 9 月 9 日从 www.mlcommons.org 检索到。NVIDIA 平台结果来自以下条目:5.0-0072、5.1-0007、5.1 – 0053、5.1 – 0079、5.1 – 0028、5.1 – 0062、5.1 – 0086、5.1 – 0073、5.1 – 0008、5.1 – 00705.1 – 0046、5.1 – 0009、5.1 – 0060、5.1 – 0072。5.1-0071、5.1 – 0069 通过将总吞吐量除以报告的芯片数量来推导每个芯片的性能。每芯片性能不是 MLPerf 推理 v5.0 或 v5.1 的主要指标。MLPerf 名称和徽标均为 MLCommons 协会在美国和其他国家 地区的注册商标和未注册商标。保留所有权利。严禁未经授权使用。有关更多信息,请参阅 www.mlcommons.org。

NVIDIA 在所有 DeepSeek-R1 和 Llama 模型的提交中,广泛采用基于 Blackwell 和 Blackwell Ultra 架构的 NVFP4 技术 以实现加速。

在本文中,我们将深入探讨这些性能表现及其背后所依赖的全栈技术实现。

Blackwell Ultra 在首次亮相的 MLPerf 中创下推理记录

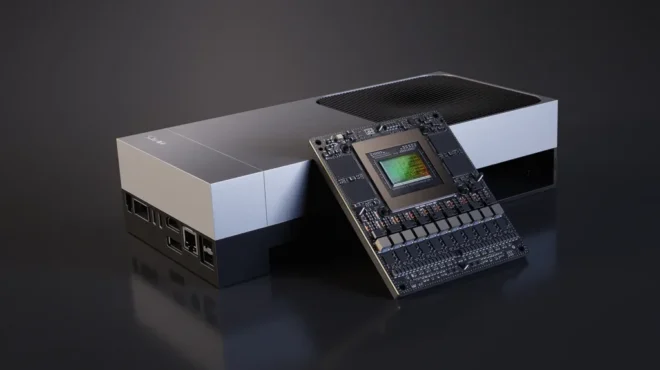

在本轮测试中,NVIDIA 采用基于 Blackwell Ultra 架构 的 GB300 NVL72 机架级系统,提交了可用类别的测试结果,这也是 MLPerf 首次迎来基于该架构的成果。Blackwell Ultra 架构建立在 NVIDIA Blackwell 架构的多项技术进步基础之上,并实现了若干关键性增强。

- NVFP4 AI 计算峰值提升 1.5 倍

- 注意力层计算性能提高 2 倍

- HBM3e 容量提高 1.5 倍

与 GB200 NVL72 的提交结果相比,GB300 NVL72 可将每颗 GPU 的性能提升高达 45%,为全新的 DeepSeek-R1 基准树立了行业标杆。相较基于 Hopper 架构系统测得的未经验证结果,Blackwell Ultra 能将每颗 GPU 的吞吐量提升约 5 倍,显著增强 AI 工厂的整体处理能力,并大幅降低每个令牌的生成成本。

| DeepSeek-R1 性能 | ||

| 架构 | 离线 | 服务器 |

| Hopper | 1253 个 token/ 秒/ GPU | 556 个 token/ 秒/ GPU |

| Blackwell Ultra | 5842 个 token/ 秒/ GPU | 2907 个 token/ 秒/ GPU |

| Blackwell Ultra Advantage | 4.7x | 5.2x |

MLPerf Inference v5.1,已关闭。Blackwell Ultra 结果基于条目 5.1-0072 中的结果。Hopper 结果未经 MLCommons 协会验证。每个 GPU 的性能并不是 MLPerf 推理 v5.1 的主要指标,其计算方法是将报告的吞吐量除以报告的加速器数量。经验证的结果于 2025 年 9 月 9 日从 www.mlcommons.org 检索到。MLPerf 名称和徽标均为 MLCommons 协会在美国和其他国家 地区的注册商标和非注册商标。保留所有权利。严禁未经授权使用。有关更多信息,请参阅 www.mlcommons.org。

这些成果得益于 Blackwell Ultra 出色的架构设计,以及 NVIDIA 高度优化且通用的推理堆栈。以下是支持在 DeepSeek-R1 上实现 NVIDIA Blackwell Ultra 提交的关键技术:

广泛使用 NVFP4

基础 DeepSeek-R1 模型的权重以 FP8 精度存储。通过采用 NVIDIA 开发并集成在 NVIDIA TensorRT Model Optimizer 库中的量化方法,大部分 DeepSeek-R1 权重被成功量化为 NVFP4 格式。NVFP4 是由 NVIDIA 推出的 4 位浮点格式,可由 Blackwell 及 Blackwell Ultra 架构的 Tensor Core 提供硬件加速支持。该优化方案不仅缩小了模型体积,还能够利用 Blackwell 架构中具备更高吞吐能力的 NVFP4 计算单元,以及 Blackwell Ultra 架构进一步提升的计算性能,同时满足基准测试对准确性的严格要求。

FP8 键值缓存

在基础 DeepSeek-R1 模型中,键值(KV)缓存以 BF16 数据格式存储。通过结合使用 TensorRT Model Optimizer 和 TensorRT-LLM 推理库,KV 缓存被进一步量化为 FP8 精度,有效降低了内存占用,同时显著提升了推理性能。

新的并行技术

DeepSeek-R1 模型的独特架构使得传统的多 GPU 执行方法,如张量并行和流水线并行,难以充分发挥其性能潜力。在 NVIDIA 提交的 DeepSeek-R1 方案中,模型的 MoE 部分采用了专家并行,而注意力机制则采用数据并行。这一设计需要对 MoE 和注意力计算内核进行重构,同时开发新的通信内核,以支持高效的收集与分发操作。

借助这种新型并行技术,合理分配上下文查询任务以平衡各 GPU 的负载变得尤为关键,其核心目标在于提升整体吞吐量并降低首个令牌的延迟。为此,我们提出了注意力数据并行平衡(Attention Data Parallelism Balance,简称 ADP Balance)——一种智能调度上下文查询的技术,旨在优化上述两项指标。该技术可确保每个 GPU 高效运行,避免性能瓶颈,从而为所有用户提供快速且响应灵敏的体验。如需了解详细技术细节,欢迎访问我们的 TensorRT-LLM GitHub 页面。

CUDA 图形

在仅解码的推理过程中,NVIDIA 采用 CUDA 图技术 来记录并回放 GPU 运算,通过单个 CPU 操作即可触发已记录的计算流程。这种方法有效降低了 CPU 开销,从而显著提升了性能。

在 Llama 3.1 405B Interactive 上提供 Blackwell 性能的解服务

与服务器场景相比,新增的 Llama 3.1 405B 基准测试交互式场景对 TTFT 和每用户 TPS 提出了更严格的要求,输出令牌速率提升超过 2 倍,TTFT 速度提升达 1.3 倍。要在这一更具挑战性的新基准测试场景中实现优异性能,需依托 NVIDIA Blackwell 平台及 NVIDIA 推理软件堆栈中的多项先进技术。

为了以交互式 token 速率服务 Llama 3.1 405B 等超大规模模型,可在多个 GPU 上对模型进行分片,从而实现更高的聚合计算能力,优化吞吐量并满足延迟需求。为应对大型模型在多 GPU 推理过程中产生的巨大通信压力,NVIDIA Blackwell 和 Blackwell Ultra 平台均支持通过 NVLink 架构,在 72 个 GPU 之间实现高达 1,800 GB/s 的多对多通信速率,总体通信带宽可达 130 TB/s。

为在满足各项要求的同时实现更高吞吐量,NVIDIA 在基于该基准测试提交的 GB200 NVL72 机架级系统中采用了分解式服务架构。与在 DGX B200 系统上使用动态批处理的传统聚合服务相比,该方案显著提升了每颗 GPU 的吞吐性能,增幅接近 1.5 倍;相较于在 DGX H200 系统上测得的飞行中批处理结果,整体性能提升超过 5 倍。

Hopper 结果来自 5.1-0075 条目中提交的 8-GPU HGX H200 结果。Blackwell 基准测试数据来自条目 5.1-0069,使用配备 8 个 GPU 的 DGX B200。Blackwell 的解服务使用 GB200 NVL72 和 72 个 GPU (条目 5.1-0071) 。性能按每个 GPU 计算,计算方法是将报告的总吞吐量除以加速器数量。每个 GPU 的性能并不是 MLPerf 推理的主要指标。MLPerf 名称和徽标均为 MLCommons 协会在美国和其他国家 地区的注册商标和非注册商标。保留所有权利。严禁未经授权使用。有关更多信息,请参阅 www.mlcommons.org。

传统的 LLM 部署通常将推理的两个主要阶段——上下文处理和文本生成——部署在同一 GPU 或节点上。然而,这两个阶段具有显著不同的特性:上下文处理阶段具有令牌级并行性且计算密集,而生成阶段则是自回归的,对延迟高度敏感。此外,二者遵循不同的服务级别指标:上下文阶段关注首令牌延迟(TTFT),生成阶段则更注重令牌间延迟(ITL),因而需要采用不同的模型并行策略。将这两个阶段合并在同一资源上运行,往往会导致资源利用效率低下,尤其是在处理长输入序列时更为明显。

将服务在不同 GPU 或节点间拆分,分别处理上下文解析与内容生成,使各阶段可独立优化。该方法支持多种并行技术,并实现灵活的 GPU 资源分配,从而提升整体系统效率。

NVIDIA Dynamo 推理框架还支持解耦服务。除了服务解耦外,Dynamo 的最新版本还具备多种推理部署功能,例如基于 SLA 的自动扩缩容、实时 LLM 可观测性指标以及容错能力。点击此处了解详情。

要点

NVIDIA 在各类 AI 模型和应用场景中持续展现出卓越的推理性能,在新增及现有基准测试中均取得了优异表现。基于 Blackwell Ultra GPU 架构的 GB300 NVL72 机架级系统首次提交成果,距离上一次提交基于 Blackwell 架构的 GB200 NVL72 类别仅过去六个月,推理能力便实现了显著提升。

此外,通过使用解耦服务的 Llama 3.1 405B 进行交互式提交的作品,展示了先进服务技术如何显著提升推理吞吐量。

要重现本博客中的出色结果,请访问此处的 MLPerf Inference v5.1 GitHub 代码库 这里。

为进一歩提升推理性能,NVIDIA 推出了 Rubin CPX,这是一款专为加速长上下文处理设计的处理器。如需了解 Rubin CPX 的更多技术细节,请参阅相关技术博客。