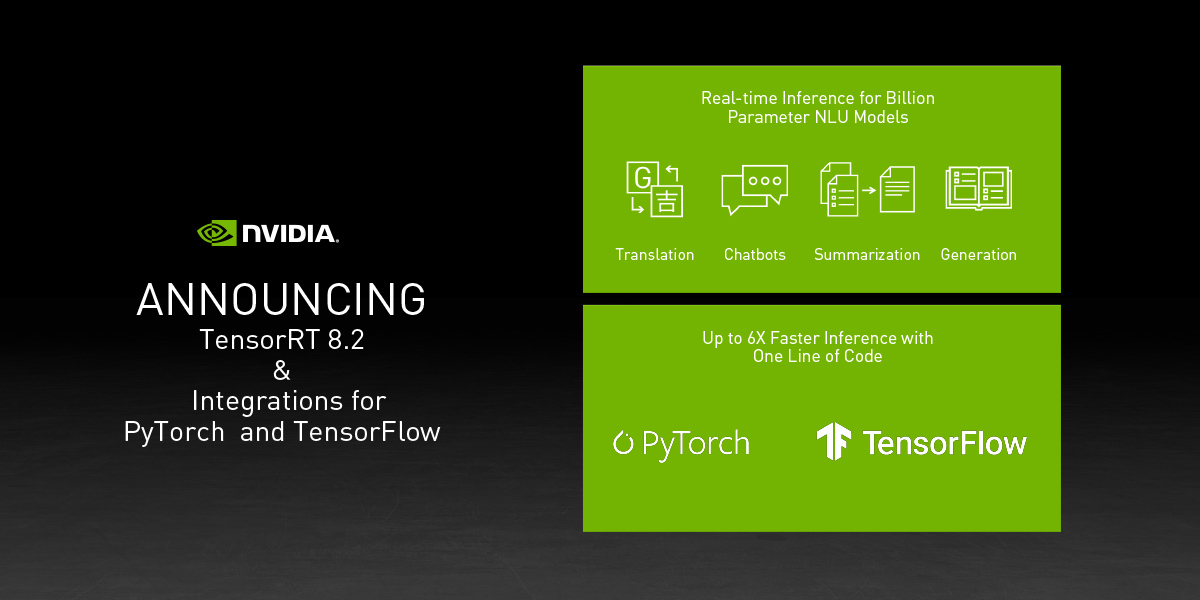

今天, NVIDIA 发布了 TensorRT 8.2 ,对十亿参数 NLU 模型进行了优化。其中包括 T5 和 GPT-2 ,用于翻译和文本生成,使实时运行 NLU 应用程序成为可能。

TensorRT 是一款高性能的深度学习推理优化器和运行时,为人工智能应用程序提供低延迟、高吞吐量推理。 TensorRT 用于医疗、汽车、制造、互联网/电信服务、金融服务和能源等多个行业。

PyTorch 和 TensorFlow 是拥有数百万用户的最流行的深度学习框架。新的 TensorRT 框架集成现在在 PyTorch 和 TensorFlow 中提供了一个简单的 API ,并提供了强大的 FP16 和 INT8 优化,从而将推理速度提高了 6 倍。

亮点包括

- TensorRT 8.2:T5 和 GPT-2 的优化运行实时翻译和摘要,与 CPU 相比,性能提高了 21 倍。

- TensorRT 8.2 :适用于使用 Windows 的开发人员的简单 Python API 。

- Torch TensorRT:PyTorch 的集成与 GPU 上的框架内推理相比,仅需一行代码即可提供高达 6 倍的性能。

- TensorFlow TensorRT:TensorFlow 与 TensorRT 的集成提供了比使用一行代码在 GPU 上进行框架内推理快 6 倍的性能。

资源

- Torch- TensorRT 今天在 NGC catalog 的 PyTorch 容器中提供。

- TensorFlow- TensorRT 目前可从 NGC catalog 的 TensorFlow 容器中获得。

- TensorRT 免费提供给 NVIDIA 开发程序 的成员。

- 在 TensorRT 产品页面了解更多信息。

了解更多

- GTC 课程 A31336 :使用 TensorRT 在生产中加速深度学习推理

- GTC 会话 A31107 :使用 TensorRT 加速 PyTorch 推理

- 使用 Torch TensorRT ,在 GPU 上 PyTorch 的推理速度提高了 6 倍

- 入门: Torch-TensorRT , TensorFlow-TensorRT

- 基于 TensorRT 的 T5 和 GPT-2 实时推理

- 笔记本: 用 TensorRT 进行 T5 翻译

- 笔记本: 用 TensorRT 生成 GPT-2 文本