未知环境中的无碰撞运动生成是机器人应用的核心构建块。产生这样的运动具有挑战性。运动发生器必须足够快以实现实时性能,并且足够可靠以实现实际部署。

已经提出了许多解决这些挑战的方法,从使用本地控制器到全球规划者。然而,当环境未知且动态时,这些传统的运动规划解决方案无法克服缺点。它们还需要复杂的视觉处理程序,如 SLAM ,通过聚合来自多个视点的相机观察来生成障碍物表示。当对象移动和环境改变时,这些表示最终需要昂贵的更新。

运动策略网络( M π Nets ),发音为“ M Pi Nets ”,是 NVIDIA 机器人研究团队开发的一种新的端到端神经策略。 M π Nets 通过使用来自单个静态相机的连续数据流实时生成无碰撞、平滑的运动。该技术能够克服传统运动规划的挑战,并且足够灵活,可以在未知环境中应用。

我们将于 12 月 18 日在新西兰的 Conference on Robot Learning (CoRL) 2022 上展示这项工作。

大规模合成数据生成

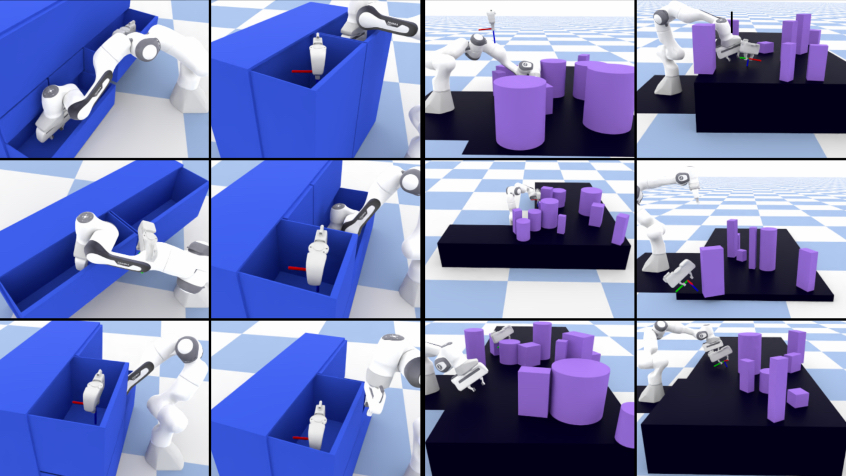

为了训练 M π Nets 神经策略,我们首先需要创建用于学习和基准测试的大规模数据集。我们转向了综合生成大量机器人轨迹和相机点云数据的模拟。

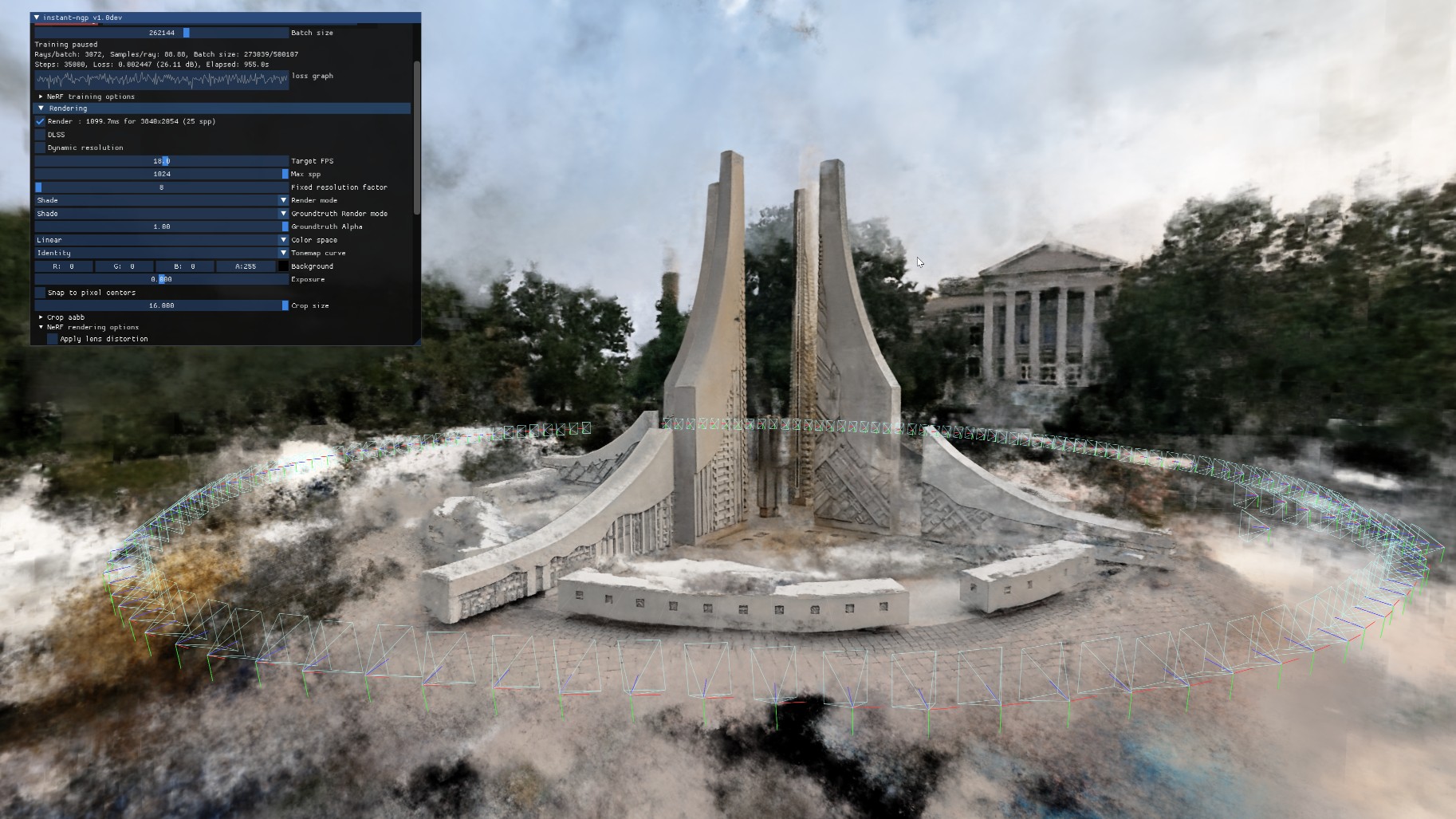

专家轨迹是使用运动规划器生成的,该运动规划器在考虑机器人的物理和几何约束的同时,围绕复杂障碍物创建一致的运动。它由 NVIDIA Omniverse 的 geometric fabrics 管道、 AIT *全局规划器和基于样条的时间重采样组成。

M π网训练了 300 多万条专家轨迹,并在 50 万个模拟环境中绘制了 7 亿个点云。在大规模数据上训练神经策略对于推广到现实世界中的未知环境至关重要。

用于运动规划的端到端体系结构

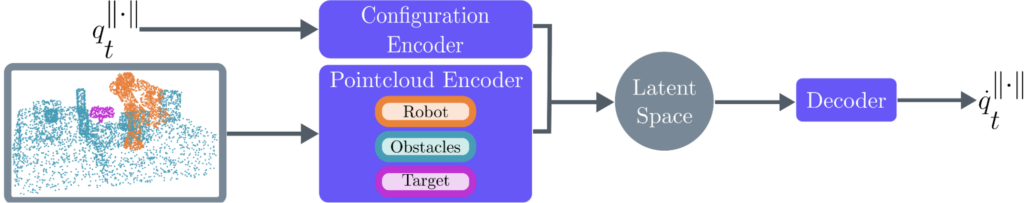

一种端到端的神经网络策略, M π Nets 将摄像机点云观测直接映射到机器人关节位置。该策略联合编码了三个输入:场景的单视点云摄像机观察、机器人的当前状态配置以及用户命令机器人实现的期望目标姿态。

它输出关节位置以实现指定的目标姿势,然后在机器人的低级控制器上执行。

输入点云自动标记为三类:机器人、障碍物和机器人的指定目标姿态。目标姿势表示为机器人抓取器的点云。

Sim2Real 传输到真实世界

M π Nets 很好地推广到具有单个静态深度相机的真实机器人系统。由于点云观测(相对于 RGB 图像)中的低域差距,该策略直接转移到真实世界而不需要真实数据。

如图 3 所示,它可以进入密闭空间,而不会与盘子和杯子等障碍物发生碰撞,这是人类空间中常见的场景。凭借其端到端的策略架构, M π Nets 还可以在以 9Hz 运行的闭环真实机器人系统中执行,并对动态场景立即做出反应,如图 3 所示。

快速、全局并避免局部最优

M π Nets 解决方案的时间比最先进的基于采样的规划器短得多。尽管不需要冲突检查器,但找到解决方案的可能性比 MPNets 高 46% 。 M π网不太可能陷入充满挑战的环境,例如密闭空间,因为它是从长期的全球规划信息中学习的。

在图 4 中, STORM 和几何织物都被卡在第一个抽屉中,因为它们无法确定如何缩回并进入第二个抽屉。两者都没有达到最终的目标姿势。

MπNets入门

当在模拟场景的大数据集上训练时, M π Nets 比传统的规划器更快,比其他本地控制器更成功,即使在动态和部分观察的场景中,也能很好地转移到真实的机器人系统。

为了帮助您开始使用 M π网,我们的论文发表在 Arxiv 上,源代码可在 Motion Policy Networks GitHub 上获得。您还可以加载我们预先训练的重量,并使用 ROS RViz 用户界面进行游戏。

在 12 月 15 日 CoRL 期间的 Benchmarking workshop 上,在机器人基准测试的背景下了解更多关于神经运动规划的信息。