Posts by Maggie Zhang

对话式人工智能/自然语言处理

2023年 1月 12日

使用 Kubernetes 自动缩放 NVIDIA Riva 部署,用于生产中的语音 AI

语音 AI 应用,从呼叫中心到虚拟助理,严重依赖 自动语音识别 ( ASR )和文本转语音( TTS )。

4 MIN READ

数据中心/云端/边缘

2022年 8月 30日

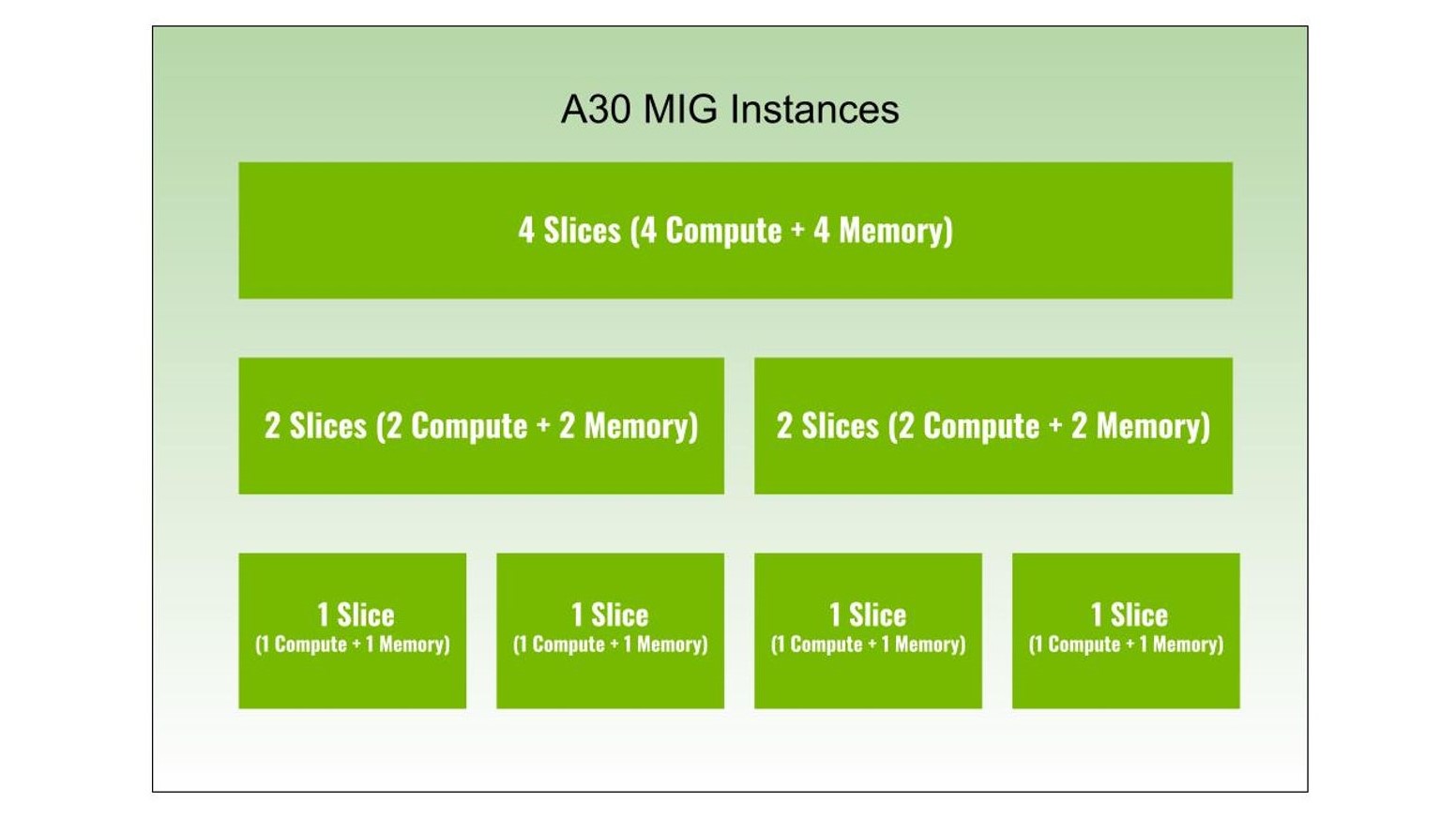

分割 NVIDIA A30 GPU 并征服多个工作负载

多实例 GPU ( MIG )是 NVIDIA H100 , A100 和 A30 张量核 GPU ,因为它可以将 GPU 划分为多个实例。

4 MIN READ

计算机视觉/视频分析

2022年 5月 11日

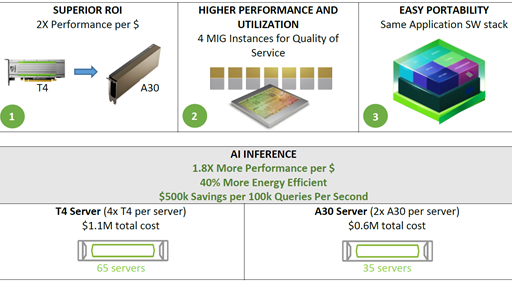

使用 NVIDIA A30 GPU 加速人工智能推理工作负载

NVIDIA A30 GPU 基于最新的 NVIDIA Ampere 体系结构,可加速各种工作负载,如大规模人工智能推理、

2 MIN READ

人工智能/深度学习

2021年 8月 25日

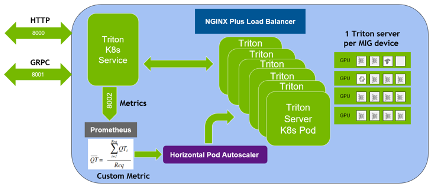

使用 MIG 和 Kubernetes 大规模部署 MIG Triton

NVIDIA Triton 推理服务器是一款开源人工智能模型服务软件,可简化在生产中大规模部署经过培训的人工智能模型。

8 MIN READ

人工智能/深度学习

2019年 9月 10日

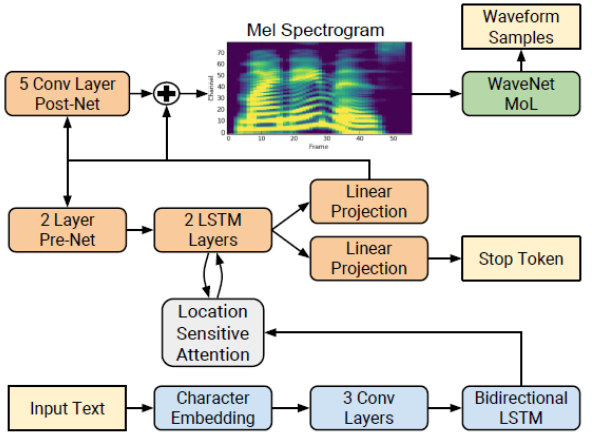

从文本实时生成自然语音

这篇文章,旨在为具有深入学习专业水平的开发人员准备,将帮助您生成一个准备生产、人工智能、文本到语音的模型。 几十年来,将文本实时转换为高质量、

4 MIN READ