NVIDIA A30 GPU 基于最新的 NVIDIA Ampere 体系结构,可加速各种工作负载,如大规模人工智能推理、企业培训和数据中心主流服务器的 HPC 应用程序。 A30 PCIe 卡将第三代 Tensor 内核与大容量 HBM2 内存( 24 GB )和快速 GPU 内存带宽( 933 GB / s )组合在一个低功耗外壳中(最大 165 W )。

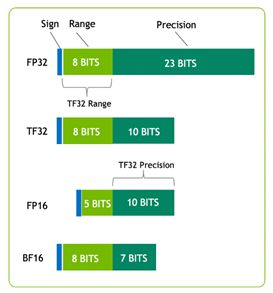

A30 支持广泛的数学精度:

- 双精度( FP64 )

- 单精度( FP32 )

- 半精度( FP16 )

- 脑浮 16 ( BF16 )

- 整数( INT8 )

它还支持 Tensor Float 32 ( TF32 )和 Tensor Core FP64 等创新技术,提供了一个单一的加速器来加速每个工作负载。

图 1 显示了 TF32 ,其范围为 FP32 ,精度为 FP16 。 TF32 是 PyTorch 、 TensorFlow 和 MXNet 中的默认选项,因此在上一代 NVIDIA Volta 架构中实现加速不需要更改代码。

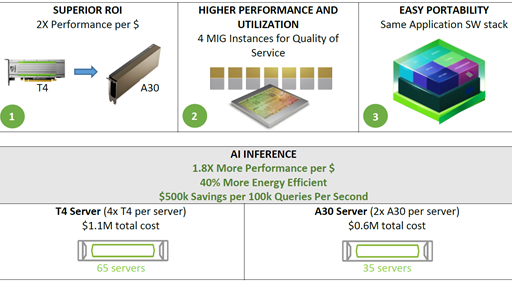

A30 的另一个重要特点是多实例 GPU ( MIG )能力。 MIG 可以最大限度地提高从大到小工作负载的 GPU 利用率,并确保服务质量( QoS )。单个 A30 最多可以被划分为四个 MIG 实例,以同时运行四个应用程序,每个应用程序都与自己的流式多处理器( SMs )、内存、二级缓存、 DRAM 带宽和解码器完全隔离。有关更多信息,请参阅 支持的 MIG 配置文件 .

对于互连, A30 支持 PCIe Gen4 ( 64 GB / s )和高速第三代 NVLink (最大 200 GB / s )。每个 A30 都可以支持一个 NVLink 桥接器与一个相邻的 A30 卡连接。只要服务器中存在一对相邻的 A30 卡,这对卡就应该通过跨越两个 PCIe 插槽的 NVLink 桥接器连接,以获得最佳桥接性能和平衡的桥接拓扑。

| | NVIDIA T4 | NVIDIA A30 |

| Design | Small Footprint Data Center & Edge Inference | AI Inference & Mainstream Compute |

| Form Factor | x16 PCIe Gen3 1 slot LP |

x16 PCIe Gen4 2 Slot FHFL 1 NVLink bridge |

| Memory | 16GB GDDR6 | 24GB HBM2 |

| Memory Bandwidth | 320 GB/s | 933 GB/s |

| Multi-Instance GPU | Up to 4 | |

| Media Acceleration | 1 Video Encoder 2 Video Decoder | 1 JPEG Decoder 4 Video Decoder |

| Fast FP64 | No | Yes |

| Ray Tracing | Yes | No |

| Power | 70W | 165W |

除了表 1 中总结的硬件优势外, A30 可以实现比 T4 GPU 更高的每美元性能。 A30 还支持端到端软件堆栈解决方案:

- 图书馆

- GPU 加速了 PyTorch 、 TensorFlow 和 MXNet 等深度学习框架

- 优化的深度学习模型

- 可从 NGC 和[2000]以上的容器中获得

性能分析

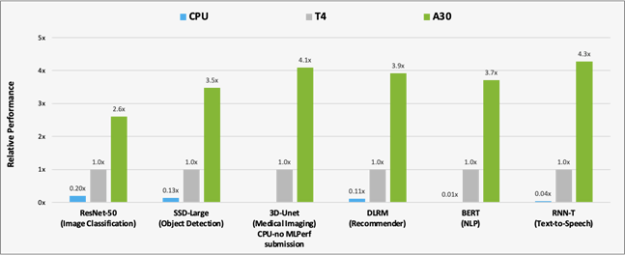

为了分析 A30 相对于 T4 和 CPU 的性能改进,我们使用以下数据集对 MLPerf 推断 v1.1 . 中的六个模型进行了基准测试:

- ResNet-50v1 。 5 ( ImageNet )

- SSD 大尺寸 ResNet-34 ( COCO )

- 3D Unet (布拉茨 2019 )

- DLRM ( 1TB 点击日志,离线场景)

- BERT (第 1.1 版,第 384 小节)

- RNN-T (图书馆语言)

MLPerf 基准测试套件 涵盖了广泛的推理用例,从图像分类和对象检测到推荐,以及自然语言处理( NLP )。

图 2 显示了 A30 与 T4 和 BERT 在人工智能推理工作负载上的性能比较结果。对于 CPU 推断, A30 比 CPU 快约 300 倍。

与T4相比,A30在使用这六种机型进行推理时提供了大约3-4倍的性能加速比。性能加速是由于30个较大的内存大小。这使得模型的批量更大,内存带宽更快(几乎是3倍T4),可以在更短的时间内将数据发送到计算核心。

CPU:8380H (不在 3D Unet 上提交)

除了人工智能推理之外, A30 还可以快速预训练人工智能模型,例如 BERT 大型 TF32 ,以及使用 FP64 张量核加速 HPC 应用。带有 TF32 的 A30 Tensor Cores 的性能比 T4 高出 10 倍,无需对代码进行任何更改。它们还提供了自动混合精度的额外 2 倍提升,使吞吐量增加了 20 倍。

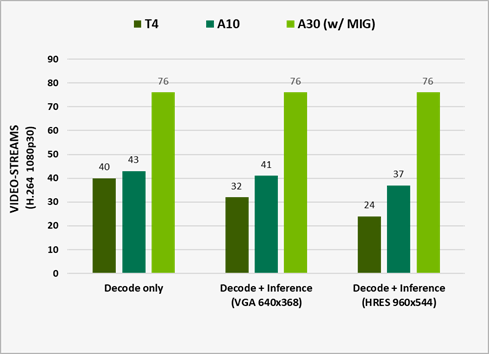

硬件解码器

在构建视频分析或视频处理管道时,必须考虑以下几个操作:

- 计算模型或预处理步骤的需求。 这取决于 Tensor 内核、 GPU DRAM 和其他硬件组件,它们可以加速模型或帧预处理内核。

- 传输前的视频流编码。 这样做是为了最小化网络上所需的带宽。为了加快这一工作量,请使用 NVIDIA 硬件解码器。

使用 DeepStream 5.1 测试性能。它代表了 e2e 在视频捕获和解码、预处理、批处理、推理和后处理方面的性能。已关闭输出渲染以获得最佳性能,运行 ResNet10 、 ResNet18 和 ResNet50 网络以推断 H.264 1080p30 视频流。

A30 旨在通过提供四个视频解码器、一个 JPEG 解码器和一个光流解码器来加速智能视频分析( IVA )。

要使用这些解码器和计算资源来分析视频,请使用 NVIDIA DeepStream SDK ,它为基于人工智能的多传感器处理、视频、音频和图像理解提供了一个完整的流分析工具包。有关更多信息,请参阅 TAO 工具包与 DeepStream 的集成 或者 使用 NVIDIA DeepStream 构建实时编校应用程序,第 1 部分:培训 。

接下来呢?

A30 代表了数据中心最强大的端到端人工智能和 HPC 平台,使研究人员、工程师和数据科学家能够交付真实世界的结果,并将解决方案大规模部署到生产中。有关更多信息,请参阅 NVIDIA A30 Tensor Core GPU 数据表 和 NVIDIA A30 GPU 加速器产品简介 .