‘NVIDIA AI 개발자 밋업 – TensorRT/Triton Inference Server’는 4월 21일 오후 2시부터 4시까지 온라인으로 진행됩니다. 이번 밋업에서는 쉽고 빠른 딥 러닝 추론 가속화 솔루션 적용 노하우를 소개합니다.

NVIDIA GPU로 학습한 딥 러닝 모델을 실제 추론을 위해 양산에 적용하기 위해서는 어떤 점들이 고려되어야 할까요? .predict(), .forward() 함수를 활용하여 심플하게 적용하는 방법부터 인프라에 맞는 고유한 요구 사항을 바탕으로 추론 적용, 최적화에 이르기까지 이어지는 NVIDIA의 독특한 해결 방법을 제안합니다.

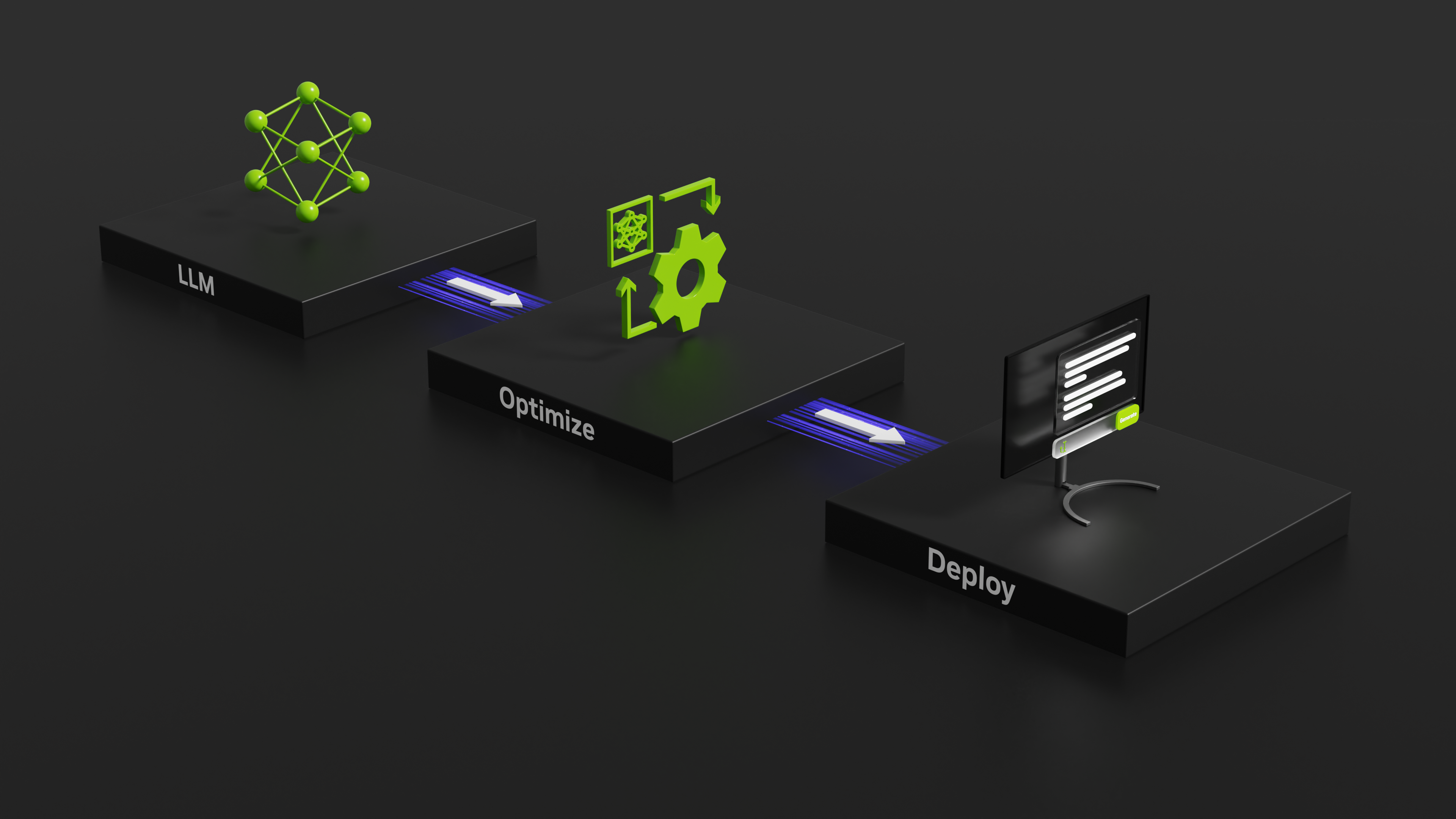

이번 밋업에서는 NVIDIA 추론 워크플로우를 단계별로 살펴봅니다. 딥 러닝 모델 최적화를 위한 TensorRT와 확장 가능하고 유연한 추론 서빙을 위한 NVIDIA Triton Inference Server에 대한 최신 업데이트, 핸즈온 데모 세션을 통해 쉽고 빠른 딥 러닝 애플리케이션 프로덕션 통합 방법도 배울 수 있습니다.

발표는 NVIDIA 솔루션 아키텍트 이진호 대리와 Developer Relations 매니저 서완석 상무가 맡습니다.

더불어 NVIDIA 전문가들에게 궁금한 점을 물어보고 답변을 들을 수 있는 질의응답 시간과 참가자들을 위한 이벤트도 진행됩니다. 온라인으로 진행되는 본 행사의 등록은 여기에서 접수할 수 있습니다. 참가자 전원에게 별도로 온라인 참가 링크를 이메일과 문자로 안내드립니다.

연사 소개

서완석 상무

NVIDIA의 개발자 생태계 특히 스타트업, 독립 소프트웨어 공급업체, 고등 교육 기관 및 정부 연구 센터 등의 구축을 담당하는 Developer Relations 시니어 매니저입니다. 삼성 전자(Samsung Electronics)/루슨트 테크놀로지스(Lucent Technologies)에서 시스템 엔지니어로, 자일링스(Xilinx)에서 FAE(field application engineer)로 근무했습니다. 연세대학교에서 전자공학 석사 및 학사 학위를 취득했습니다.

이진호 대리

NVIDIA의 솔루션 아키텍트로, 성균관대학교에서 인공지능 분야의 이공계 석사 학위를 취득했습니다. 현재 NVIDIA 생태계와 GPU 설계를 활용하는 다양한 사업을 지원하고 있습니다

Platform& SDK

TensorRT

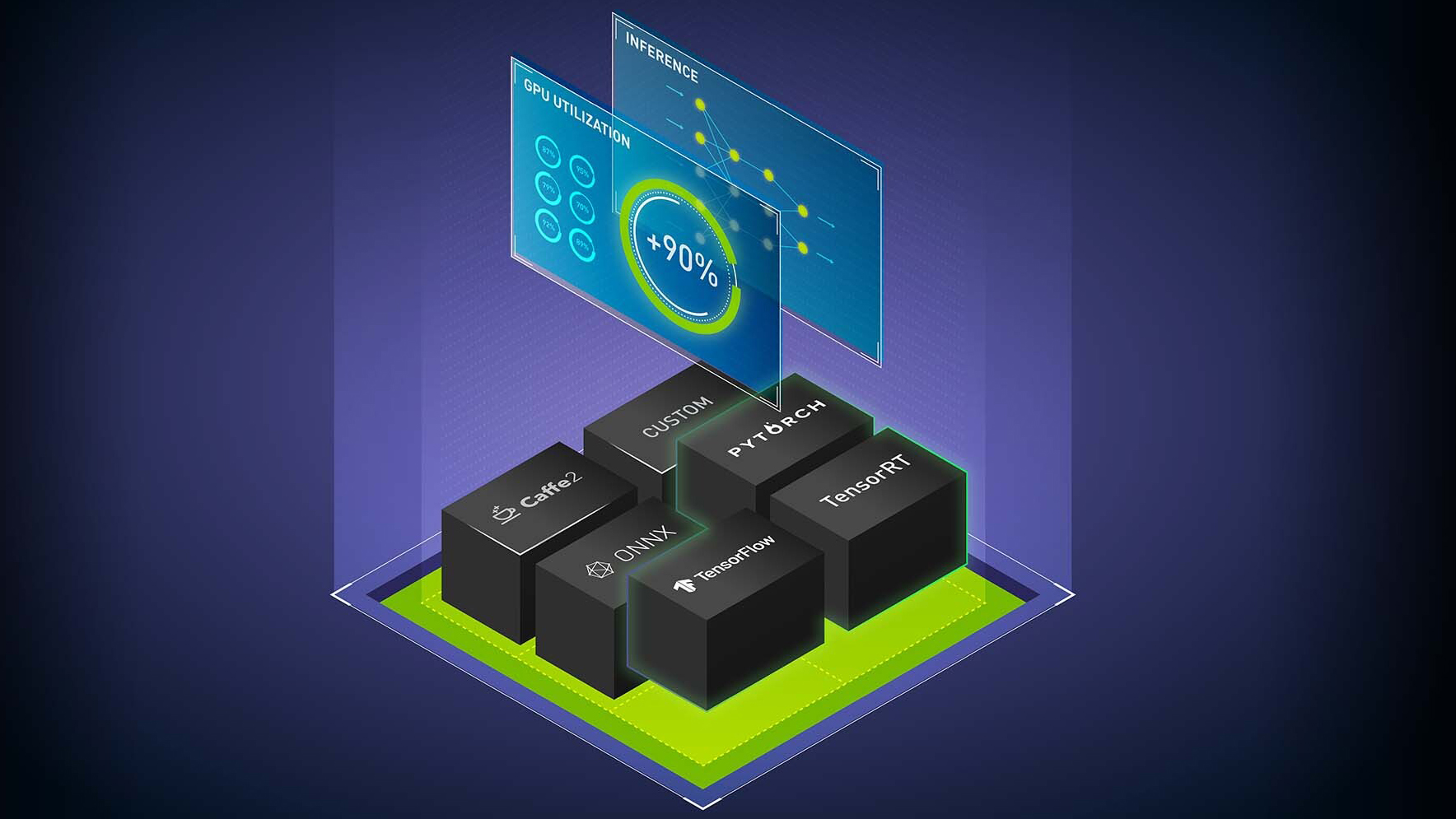

AI 추론은 최신 애플리케이션 트렌드를 주도하고 있으며 빠르고 쉬운 추론 구축에 대한 수요도 그 어느 때보다 높아졌습니다. 하지만 추론은 실시간, 경쟁적인 제약 조건, 빠른 업데이트를 요구하기 때문에 복잡합니다. 모든 프레임워크에서 각 타깃 플랫폼에 최적화를 도와주는 NVIDIA TensorRT를 소개합니다. 컴파일러와 런타임으로 지연 시간이 중요한 애플리케이션의 처리량(throughput)을 최대화하며 CNN, RNN과 트랜스포머를 포함한 모든 네트워크를 최적화합니다. 또한 TensorRT는 세계에서 가장 발전한 추론 SDK로 25,000개 이상의 고객이 클라우드에서 엣지에 이르기까지 다양한 산업에 걸쳐 활용하고 있습니다.

Triton Inference Server

NVIDIA Triton Inference Server(Triton)는 성능을 극대화하고 규모에 맞게 모델 배포를 단순화하는 오픈 소스 추론 서비스 소프트웨어입니다. 추론 서빙(inference serving)은 프로덕션 활동에 해당하며 여러 생태계의 소프트웨어나 툴과 통합이 필요할 수 있습니다. Triton은 클라우드, 데이터센터, 엣지의 GPU/CPU 기반 인프라에서 사용자 지정 CUDA와 파이썬 백엔드를 사용하여 다중 프레임워크(TensorRT, TensorFlow, ONNX, PyTorch 등)를 지원합니다. Triton은 컴퓨터 비전, 자연어 처리, 금융 서비스 등을 위한 애플리케이션 일체의 프로덕션에서 대⋅소규모 고객사가 모두 사용할 수 있는 모델들을 제공합니다.