GTC 2022 において、NVIDIA は、開発者がリアルタイム音声 AI アプリケーションを構築したり、高性能なレコメンダーを大規模に作成したり、あらゆるアプリケーションで推論を最適化したりするための、NVIDIA AI ソフトウェア一式の主要なアップデートを発表しました。CEO Jensen Huang による基調講演を視聴して、NVIDIA の最新の進化をご確認ください。(※基調講演の動画は日本語字幕がご利用いただけます。)

NVIDIA Riva 2.0 の発表

本日、NVIDIA は Riva 2.0 の一般提供開始を発表しました。Riva は、リアルタイム アプリケーションのためのモデル、ツール、完全に最適化された音声認識およびテキスト読み上げのパイプラインを提供する、高速化されたスピーチ AI SDK です。

ハイライトは以下の通りです。

- 世界最高水準の 7 か国語自動音声認識。

- 人間のような高品質な音声を生成する、ニューラルベースのテキスト読み上げ。

- TAO Toolkit と NeMo による専門分野のカスタマイズ

- クラウド、オンプレミス、組み込みプラットフォームでの動作に対応。

NVIDIA はまた、大規模な展開を行う企業が NVIDIA の音声のエキスパートにアクセス可能な Riva Enterprise を発表しました。企業は、LaunchPad ですぐに実行可能なインフラで、ガイド付きのラボを使用して Riva を試すことができます。

こちらの GTC セッションをカレンダーに追加して、詳細をご覧ください。

NVIDIA Merlin 1.0 Hyperscale ML、CPU/GPU 上のディープラーニング レコメンダーシステムを発表

本日、NVIDIA は、データの前処理から特徴量の変換、トレーニング、最適化、展開まで、レコメンダー ワークフローを加速するために設計されたエンドツーエンド フレームワークの NVIDIA Merlin 1.0 を発表しました。この最新リリースの NVIDIA Merlin により、データ サイエンティストや機械学習エンジニアは、より少ないコードでより速くスケーリングすることができます。新機能は、特徴やモデルを素早く反復し、特徴変換、情報検索、ランキング モデルを備えた完全に訓練されたレコメンダー パイプラインを推論マイクロサービスとして展開することができます。

ハイライトは以下の通りです。

- Merlin Models は、データ サイエンティストが 50 行以下のコードでレコメンダー モデルを学習/展開するための新しいライブラリです。

- Merlin Systems は、機械学習エンジニアがレコメンダー パイプラインをアンサンブルされた Triton マイクロサービスとして簡単にデプロイするための新しいライブラリです。

- 大規模なマルチ GPU、マルチノード推論、計算量の少ないワークロードをサポートします。

最新版の詳細については、 NVIDIA Merlin をダウンロードしてお試しください。

こちらの GTC セッションをカレンダーに追加して、詳細をご覧ください。

- NVIDIA Merlin による迅速かつ容易なレコメンダー システムの構築と展開 (NVIDIA)

- 15 億以上のユーザー規模のリアルタイム ディープラーニング レコメンデーション推論のスケールアップ (ShareChat)

- ライフサービス のシナリオにおける GPU の大規模レコメンデーション システム (Meituan)

- Merlin Models を使った簡単なレコメンダー システムの構築 (NVIDIA)

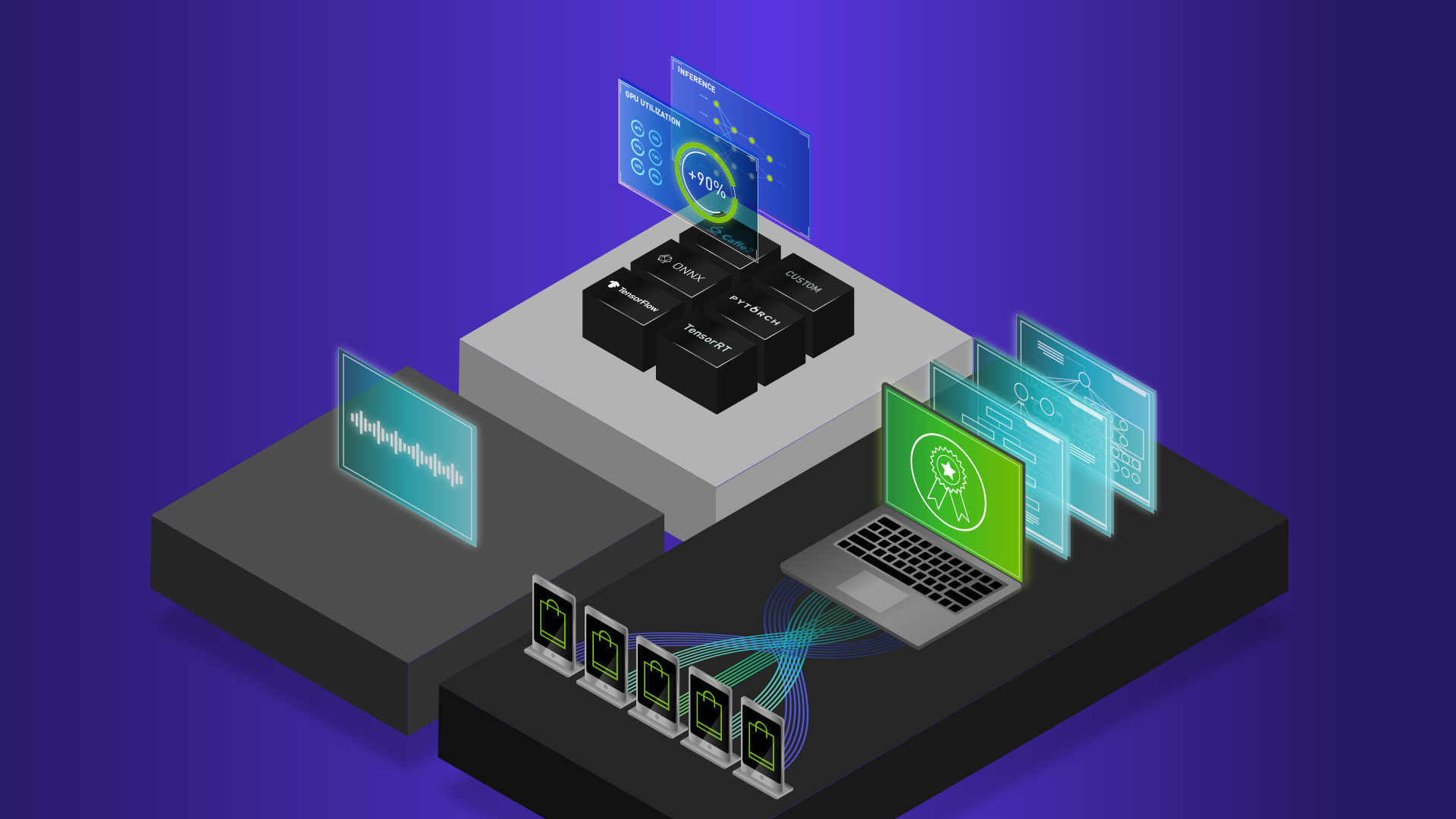

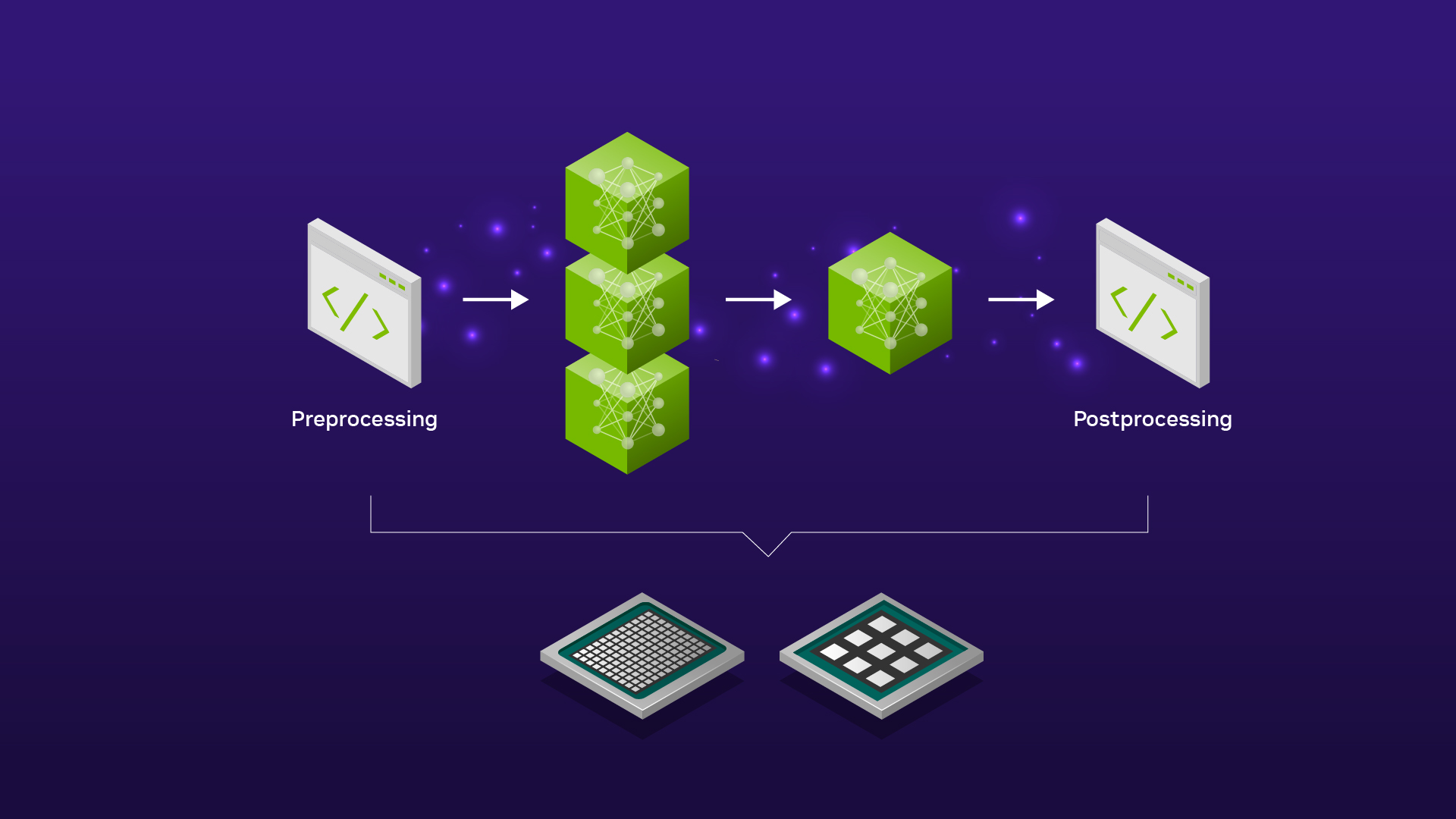

NVIDIA Triton の新機能の発表

本日、NVIDIA は NVIDIA Triton の新たな主要アップデートを発表しました。Triton は、稼働しているあらゆるアプリケーションに高速でスケーラブルな AI をもたらす、オープンソースの推論を提供するソフトウェアです。

ハイライトは以下の通りです。

- Triton FIL バックエンド: シャープレイ値によるモデルの説明可能性と CPU 最適化による性能向上。

- Kubernetes 上の Triton インスタンス群のセットアップと管理を簡素化/自動化する Triton Management Service を提供します。アルファ版のリリースは 3 月末を予定しています。

- Triton Model Navigator は、Triton で学習したモデルを本番環境に展開するための準備を自動化するためのツールです。

- エッジ展開のための Fleet Command の統合。

- AWS Inferentia での推論をサポートし、MLFlow プラグインで MLFlow モデルのデプロイを可能にします。

- Triton 環境を構築することなく、NVIDIA LaunchPad ですぐに短期間のアクセスで Triton の利用を始めることができます。

Triton は NGC カタログ から、ダウンロードでき、GitHub でコードやドキュメントにアクセスできます。

こちらの GTC セッションをカレンダーに追加して、詳細をご覧ください。

- オープンソースの NVIDIA Triton で CPU と GPU 上の複数のフレームワーク、多様なモデルに対応した高速、スケーラブル、かつ標準化された AI 推論の展開

- Model Analyzer を用いた Azure ML Triton モデルの最適な展開

NVIDIA NeMo Megatron の新しいアップデートの発表

本日、NVIDIA は、大規模言語モデル (LLM) の学習用フレームワークの NVIDIA NeMo Megatron の最新版を発表しました。これにより研究機関や企業はあらゆる LLM の最速学習を実現することができます。また、最新の並列化技術、データ前処理スクリプト、学習収束を確実にするためのレシピも含まれています。

ハイライトは以下の通りです。

- お客様のニーズやインフラの制約に基づき、自動的にレシピを作成するハイパー パラメーター チューニング ツール。

- T5 モデル、mT5 モデルの参考レシピ。

- Azure のクラウド対応。

- データの前処理スクリプトを分散させ、エンドツーエンドの学習時間を短縮。

こちらをクリックして、早期アクセスを申請してください。

こちらの GTC セッションをカレンダーに追加して、詳細をご覧ください。

- 大規模ローカライズ言語モデルの構築: データ準備から学習、本番への展開まで

- 最先端の大規模言語モデルのトレーニングにかかる膨大なコストを回避する方法

- Connect with the Experts: 対話型 AI: Riva によるアプリケーション構築と、Nemo-Megatron を使用したで数十億ものパラメーター言語モデルの訓練

NVIDIA Maxine の新機能の発表

本日、NVIDIA は、AI でオーディオおよびビデオ コミュニケーションを刷新する GPU アクセラレーション SDK 群である NVIDIA Maxine の最新バージョンを発表し、標準的なマイクとカメラをクリアなオンライン コミュニケーションのために昇華させました。Maxineは、カスタマイズ可能なエンドツーエンドのディープラーニング パイプラインに組み込むことができる最先端のリアルタイム AI オーディオ、ビデオ、および AR (拡張現実) 機能を提供します。

ハイライトは以下の通りです。

- オーディオ スーパー レゾリューション: オーディオ入力ストリームを 8kHz から 16kHz、16kHz から 48kHz のサンプリング レートにアップサンプリングすることで、リアルタイムのオーディオ品質を向上させます。

- アコースティック エコー キャンセレーション: 入力音声からリアルタイムに音響機器のエコーを除去し、音響ペアの不一致やダブルトークを解消します。AI ベースの技術により、従来のデジタル信号処理よりも効果的なキャンセレーションを実現します。

- ノイズの除去: 最新の AI モデルにより、話者の自然な声を維持したまま、一般的なバックグラウンド ノイズを除去します。

- ルーム エコー キャンセレーション: 最新の AI モデルにより音声の残響を除去し、話者の声を明瞭に再現します。

こちらの GTC セッションをカレンダーに追加して、詳細をご覧ください。

- Zoom Video が Kubernetes クラスターで分散型モデル トレーニングを利用する方法

- Avaya のリアルタイム クラウド メディア プロセッシング コアが Maxine で超低遅延を維持する方法

- プロジェクト スターライン: 高臨場感のテレプレゼンス システム

- 体当たりで勝負! 仮想環境での簡単な人材追跡

GTC にご登録して、GPU アクセラレーションによる AI 技術の最新情報を学びましょう。

翻訳に関する免責事項

この記事は、「Major Updates to NVIDIA AI Software Advancing Speech, Recommenders, Inference, and More Announced at NVIDIA GTC 2022」の抄訳で、お客様の利便性のために機械翻訳によって翻訳されたものです。NVIDIA では、翻訳の正確さを期すために注意払っておりますが、翻訳の正確性については保証いたしません。翻訳された記事の内容の正確性に関して疑問が生じた場合は、原典である英語の記事を参照してください。