乐高爱好者抓挠他们的头,阅读组装说明,可能很快有助于复杂的建设,感谢一个新的 学习 来自斯坦福大学、麻省理工学院和 Autodesk 。研究人员设计了一个深度学习框架,将 2D 手册翻译成机器可以理解的步骤,以构建 3D 乐高套件。这项工作可以推动专注于制造机器的研究,帮助人们组装物体。

“乐高手册提供了一个独立的环境,展示了人类的一项核心技能:在指导下学习完成任务。利用视觉场景解析和程序合成的最新进展,我们旨在构建具有类似技能的机器,从乐高开始,最终以现实世界场景为目标,”该研究资深作者吴家军说,斯坦福大学计算机科学助理教授。

研究人员表示,用人工智能翻译 2D 手册面临两大挑战。首先, AI 必须基于 2D 手动图像在每个装配步骤中学习和理解 3D 形状之间的对应关系。这包括考虑工件的方向和对齐。

它还必须能够对砖块进行分类,并在半组装模型中推断出砖块的三维姿态。作为乐高积木制作过程的一部分,小部件被组合成更大的部件,如吉他的头部、颈部和身体。当这些较大的部分组合在一起时,将创建一个完整的项目。这增加了难度,因为机器必须解析出所有的乐高积木,甚至是那些可能不可见的积木,如乐高钉和反积木。

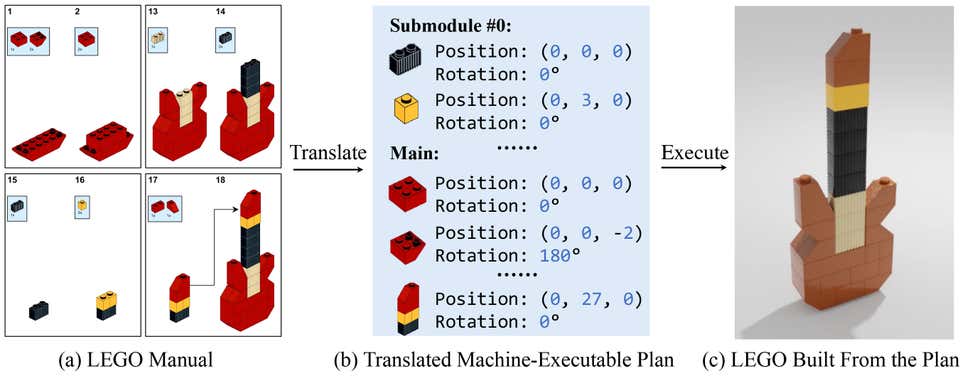

该团队致力于创建一个模型,该模型可以将 2D 手册转化为机器可执行计划,以构建定义的对象。虽然目前有两种执行此任务的方法:基于搜索的方法和基于学习的方法,但都存在局限性。

基于搜索的方法寻找工件和手动图像的可能三维姿态,寻找正确的姿态。该方法计算量大,速度慢,但精度高。

基于学习的模型依赖于神经网络来预测部件的 3D 姿态。它们速度快,但精度不高,尤其是在使用看不见的 3D 形状时。

为了解决这一局限性,研究人员开发了手册到可执行计划网络 ( MEPNet ) ,根据研究,它使用深度学习和 计算机视觉 集成“神经 2D 关键点检测模块和 2D-3D 投影算法”

根据一系列预测,在每一步,模型都会阅读手册,定位要添加的零件,并推导出 3D 定位。在模型预测了每一块和每一步的姿势后,它可以从头开始解析手册,创建一个机器人可以遵循的建筑计划来建造乐高对象。

研究人员在研究中写道:“对于每个步骤,输入包括 1 )一组在之前的步骤中构建的原始砖块和零件,以 3D 表示; 2 )一个显示组件应如何连接的目标 2D 图像。预期输出是该步骤中涉及的所有组件的(相对)姿态。”。

他们从一个包含 72 种砖块的乐高工具包中创建了第一个合成训练数据,并使用了来自 LPub3D ,一个用于“创建乐高风格的数字建筑说明”的开源应用程序

研究人员总共生成了 8000 份培训手册,其中 10 套用于验证, 20 套用于测试。每个数据集中有大约 200 个单独的步骤,约占培训中的 200000 个单独步骤。

他们在研究中写道:“我们在综合生成的数据集上对 MEPNet 进行全面监控,在该数据集中,我们有基本真相关键点、掩码和旋转信息。”。 MEPNet 模型在四个点上训练 5 天 NVIDIA Titan RTX GPU 由 NVIDIA 图灵架构提供支持。

他们还在 Minecraft house 数据集上测试了该模型,该数据集具有与乐高类似的构建风格。

通过将 MEPNet 与现有模型进行比较,研究人员发现,它在现实世界的乐高积木、合成手册和 Minecraft 示例中的表现优于其他模型。

MEPNet 在姿势估计方面更准确,甚至在识别不可见片段的构建方面也更好。研究人员还发现,该模型能够将从合成手册中获得的知识应用于现实世界的乐高手册。

虽然还需要制造一个能够执行计划的机器人,但研究人员将这项工作视为一个起点。

“我们的长期目标是制造能够帮助人类构造和组装复杂物体的机器。我们正在考虑将我们的方法扩展到其他组装领域,如宜家家具,”斯坦福大学计算机科学博士生王若成( Ruocheng Wang )说。

这个 lego_release 代码在 GitHub 上可用。

阅读研究报告 将视觉乐高手册转化为机器可执行计划 .

查看研究 项目页面 .