数年前、創業者/ CEO のジェンスン フアン (Jensen Huang) は、世界初の NVIDIA DGX AI システムを OpenAI に直接提供しました。そして今、OpenAI の ChatGPT は世界を席巻しています。ChatGPT によって人工知能 (AI) のメリットや機能が浮き彫りとなり、規模に関わらずあらゆる業界や企業において、 AI がどのように活用できるかが明らかになっています。

さて、ChatGPT をホストしてサポートするのに必要なテクノロジやインフラストラクチャについて、よく考えたことはあるでしょうか?

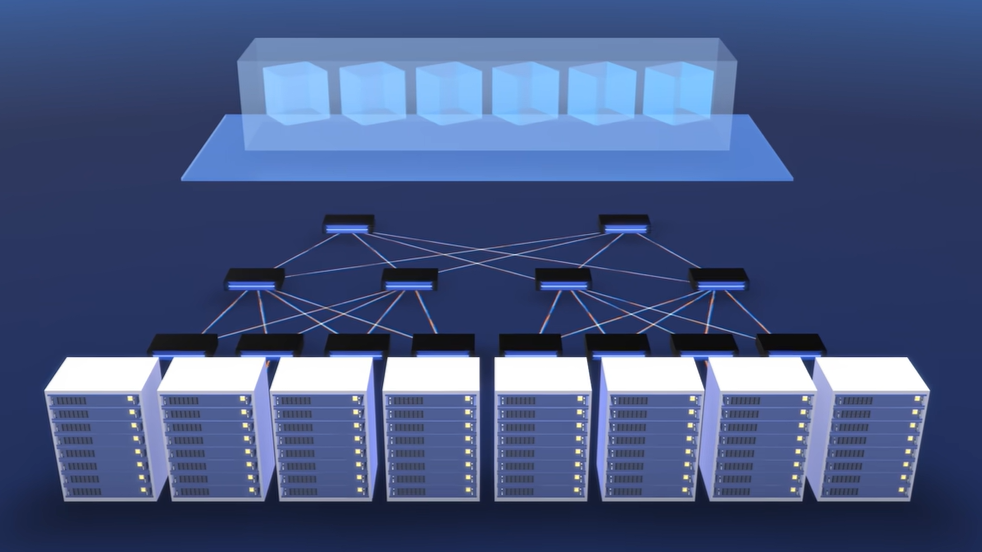

このビデオでは、Microsoft Azure の CTO であるマーク ルシノビッチ (Mark Russinovich) 氏が、 AI 専用スーパーコンピューターを支えるインフラストラクチャの背後にあるテクノロジ スタックについて説明しています。このインフラストラクチャは、ChatGPT やその他の大規模言語モデル (LLM) をどのような規模でもホストできるように、NVIDIA と Microsoft Azure が OpenAI と協力して開発したものです。

主なポイント

- データの並列処理アプローチにより、NVIDIA H100 Tensor コア GPU を使用した推論のパフォーマンスが 30 倍、モデル トレーニングのパフォーマンスが 4 倍向上しました。

- より高度な LLM の処理要求を満たすために、VM は NVIDIA Quantum-2 InfiniBand ネットワーキングを使用して拡張されました。

- 大規模なトレーニングでは、サーバーの障害やネットワークのフラップは避けられません。マイクロソフトの Project Forge は、ジョブを迅速に再開して、グローバルで高い稼働率を維持するために、透過的なチェックポイント機能を導入しました。

- 低ランク適応 (LoRA) のファインチューニングにより、10 億パラメーター モデルを大規模に処理する際の GPU 使用量とチェックポイントのサイズが小さくなります。

- Wayve をはじめとする業界の先駆者は、計算集約型のワークロードに AI スーパーコンピューター インフラストラクチャを活用しています。

- 今後、 NVIDIA H100 GPU を活用したコンフィデンシャル コンピューティングが Azure 上でサポートされます。これにより、機密データの安全性を確保し、使用中の有用な AI モデルを保護、AI の安全なマルチパーティ コラボレーションのユース ケースが実現します。

まとめ

数千億のパラメーターを使用して AI モデルをトレーニングする場合に鍵となるのが、効率性の高いデータ センター インフラストラクチャです。これにより、スループットが向上しサーバー障害が大幅に削減できるだけでなく、マルチ GPU クラスターを活用したコンピューティング集約型のワークロードが実現します。

データ センター インフラストラクチャを最適化して大規模なモデルを確実に展開する方法について、詳しくは以下の資料を参照してください。

- NVIDIA AI プラットフォーム: コンピューティングやソフトウェアから AI モデルやサービスに至るまで、フルスタックのイノベーションにより AI 開発を楽に実現します。

- 最新のデータ センター: NVIDIA AI をすばやく導入するために IT リーダーがデータ センターをどのように拡張、管理しているか、余すところなくご覧いただけます。

- H100 Tensor コア GPU: テクノロジの革新が集結し、LLM を前世代と比べて 30 倍高速化します。

- NVIDIA NeMo: 企業のお客様が LLM を構築、カスタマイズ、展開して生成 AI アプリケーションを強化できるようにします。

- NVIDIA Quantum InfiniBand プラットフォーム

関連資料

- GTC セッション: Connect with the Experts: Professional Rendering and Virtualization (2023 年春)

- GTC セッション: Connect with the Experts: GPU Performance Analysis and Optimization (2023 年春)

- GTC セッション: NVIDIA Omniverse User Group Spring 2023 (2023 年春)

- SDK: GeForce Now DevTools

- SDK: Video Codec

- ウェビナー: Impact of NVIDIA Virtual GPU on Video Conference Tools