リアルタイムに高精度の推論を行うことは、特に視界の悪い環境では困難な作業です。NVIDIA Jetson 組込みプラットフォームを使用して、最近終了した DARPA (国防高等研究計画局) の Subterranean (SubT) チャレンジのチームは、高精度と高スループットの両方で対象の物体を検出することに成功しました。この記事では、システム コンテストの最終行程でチームが直面した結果、システム、および課題についてご紹介します。

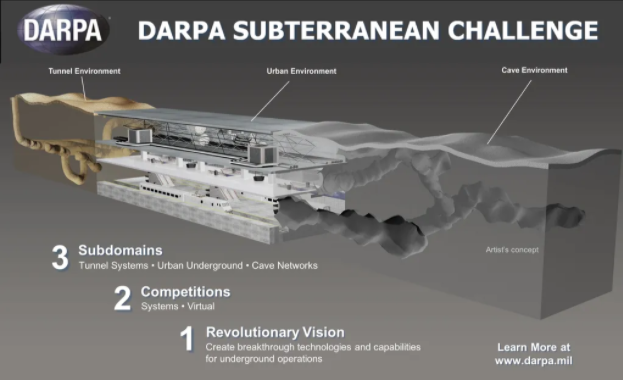

SubT チャレンジは、DARPA が主催および運営する国際的なロボット コンテストです。視界不良、危険の存在、未知の地図、不十分な通信インフラなど、さまざまな課題がある環境において、マッピング、ナビゲート、および探索を行うためのロボットの新しいアプローチを開発することが研究者に求められます。

このチャレンジは、トンネル サーキット、アーバン サーキット、ケイブ サーキット (COVID-19 により中止) の 3 つの予選サーキットと、最後に総合チャレンジ コースで構成されています。各サーキットと決勝大会は、さまざまな地形を持つ異なる環境で行われます。大会主催者によると、この大会は 3 年間かけて段階的に開催され、最終大会は 2021 年 9 月に米国ケンタッキー州ルイビルで開催されました。

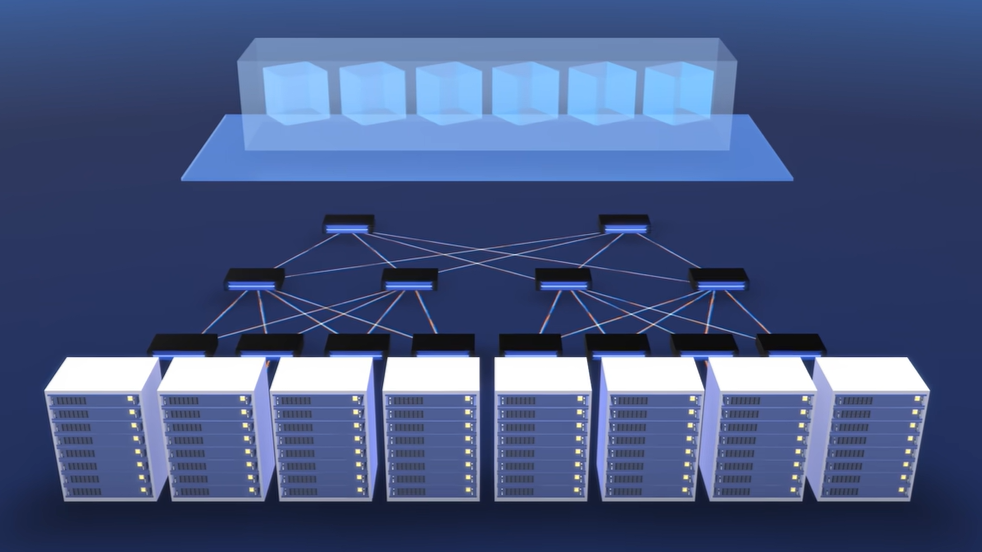

SubT チャレンジの参加者は、ハードウェアとソフトウェアの両方のニーズに対して、NVIDIA の技術を活用しました。各チームは、デスクトップ/サーバー GPU を使用してモデルを学習し、NVIDIA Jetson 組込みプラットフォームを使ってロボットに搭載して、優勝チームを決定するための主要基準である人工物や対象の物体をリアルタイム検出しました。また、7 チーム中 5 チームが Jetson プラットフォームを使用してリアルタイムに物体検出を行いました。

SubT チャレンジ

SubT チャレンジは、捜索救助活動や災害対応で第一応答者が直面する現実的なシナリオから着想を得ています。

このコンペティションを通じて開発された最先端の手法は、未知の地下環境を探索する際に、捜索救助隊員や第一応答者が犠牲となるリスクを軽減するのに役立つことでしょう。さらに、自律型ロボットは隊員が環境を探索して生存者や関心のある物体を見つけたり、人間にとって危険な場所にアクセスしたりするのを支援します。

技術的な課題

この大会では、未知の地形や不整地など、ロボットによっては容易に操作できないような地形への対応など、さまざまな技術的課題が盛り込まれています。

このような環境では、中央司令部と通信するためのインフラがないのが普通です。知覚の観点からは、このような環境では、ロボットが人工物や興味のある物体を見つけなければならないため、視界が悪くなることが予想されます。

各チームは、新しいセンサー フュージョン手法の開発、対象物の位置を特定し検出するためのさまざまな機能を持つ新しいロボット プラットフォームの開発、または既存のロボット プラットフォームの改良によって、これらの課題に取り組むことを課されたのです。

Team CERBERUS

Team CERBERUS (CollaborativE walking and flying RoBots for autonomous ExploRation in Underground Settings) は、世界中の複数の大学や産業機関が参加する共同コンソーシアムです。

同チームは、「ANYmal」と呼ばれる 4 足歩行ロボット 4 台、サイズや積載量が可変の主に自社製のドローン 5 台、ローバー ロボット「Super Mega Bot」で競技会に参加しました。決勝大会では、4 台の ANYmal と Super Mega Bot で探査と人工物検出を行うことになりました。

各 ANYmal ロボットは、2 台の CPU 搭載コンピューターと NVIDIA Jetson AGX Xavier を搭載していました。ローバー ロボットには、NVIDIA GTX 1070 GPU が搭載されました。

CERBERUS チームは、物体検出に You Only Look Once (YOLO) モデルを改良したものを使用しました。このモデルは、2 つの NVIDIA RTX 3090 GPU を用いて、4 万ものラベル付き画像でトレーニングされました。

学習済みモデルは TensorRT でさらに最適化され、 Jetson に展開されリアルタイム推論が行われました。Jetson AGX Xavier は、20Hz のコレクティブ レートで推論を実行することができました。決勝戦では、CERBERUS チームが、環境中に存在する 40 の人工物のうち 23 を最初に検出し、1 位を獲得しました。

また、CERBERUS チームは、地形の標高マッピングと 4 脚ロボット ANYmal の運動方針コントローラーのトレーニングに GPU を使用しました。標高マッピングは Jetson AGX Xavier を使用してリアルタイムに行われました。また、ANYmal ロボットの不整地に対する運動方針の学習は、デスクトップ GPU を用いてオフラインで行われました。

Team Co-STAR

南カリフォルニアにある NASA の Jet Propulsion Laboratory (JPL) の研究者と他の大学や産業界の協力者が率いるチーム Collaborative SubTerranean Autonomous Robots (Co-STAR) は、複雑な地下都市環境の探査に焦点を当てた 2020 年のコンテストで優勝しました。

また、人工環境と自然環境が混在する 2021 年大会に出場し、5 位に入賞することに成功しました。Co-STAR チームは、4 台の Spot、4 台の Husky ロボット、2 台のドローンで大会に参加しました。

最終的には、予想外のハードウェア トラブルにより、Spot 1 台と Husky 3 台での走行となりました。各ロボットには、CPU ベースのコンピューターと NVIDIA Jetson AGX Xavier が 1 台ずつ搭載されました。

Co-STAR チームは、物体検出に RGB 画像と熱画像を使用しました。YOLO v5 の中型モデルを使って、高解像度画像を処理し、リアルタイムで推論を行いました。チームは、撮影した RGB 画像と熱画像に対して推論を行うために、2 つの異なるモデルをトレーニングしました。

画像ベースのモデルは約 54,000 フレーム、熱画像モデルは約 2,400 枚のラベル付き画像でトレーニングしました。Co-STAR チームは、カスタマイズしたデータセットでモデルをトレーニングするために、COCO データセットで事前にトレーニングした YOLO v5 モデルを使用し、NVIDIA Transfer Learning Toolkit (通称: TAO Toolkit) を使って転送学習を実行しました。

モデルのトレーニングには、オンプレミスの NVIDIA A100 GPU 2 基と、V100 GPU 8 基で構成される AWS インスタンスが使用されました。Jetson AGX Xavier にモデルを展開する前に、チームは TensorRT を使用してモデルを刈り込みました。

この設定により、5 台の RealSense カメラから受信した RGB 画像と、1 台のサーモグラフィから受信した画像で、28Hz で推論を行うことができました。最終的に、ロボットは指定されたエリアに存在する 13 の人工物をすべて検出することができました。展開先で予期せぬハードウェアの問題が発生し、展開が遅れたため、探査時間が制限されました。

NVIDIA Jetson プラットフォームと NVIDIA GPU ハードウェアを搭載し、DARPA SubT イベントに参加したチームは、リアルタイム推論用のモデルを効果的にトレーニングし、地下環境における正確な物体検出という難題に対処することに成功しました。

翻訳に関する免責事項

この記事は、「NVIDIA Jetson-based Robots Excel in DARPA Underground Competition」の抄訳で、お客様の利便性のために機械翻訳によって翻訳されたものです。NVIDIA では、翻訳の正確さを期すために注意払っておりますが、翻訳の正確性については保証いたしません。翻訳された記事の内容の正確性に関して疑問が生じた場合は、原典である英語の記事を参照してください。