InstaDeep、ミュンヘン工科大学 (TUM) および NVIDIA のコラボレーションにより、ゲノミクス用の複数のスーパーコンピューティング規模の基盤モデルが開発されました。本モデルは、プロモーターやエンハンサー部位の予測など、多数の予測タスクで最先端のパフォーマンスを発揮します。

研究者の共同チームは、ゲノミクスでトレーニングされた大規模言語モデル (LLM) が、多数のゲノムタスクにわたって汎化することを示しました。以前のアプローチでは専門のモデルが必要でした。1 月 9 日~ 12 日に開催された第 41 回 JP モルガン ヘルスケア カンファレンスにおいて、NVIDIA ヘルスケア担当バイス プレジデント、キンバリー パウエル (Kimberly Powell) が招待講演を行い、本研究について紹介しました。

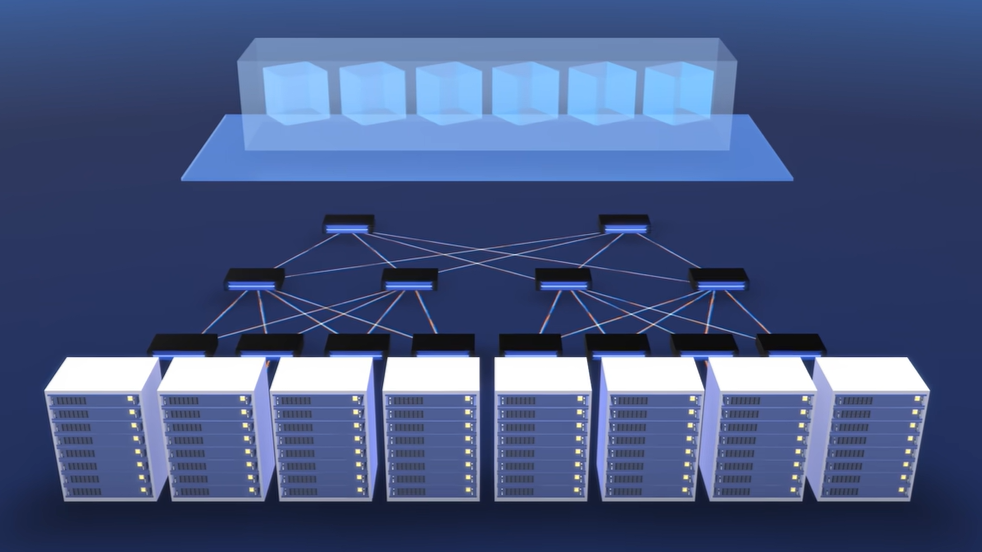

チームは、NVIDIA が立ち上げたスーパーコンピューター Cambridge-1 を使用し、5 億から 25 億までのパラメーターを持つさまざまな大規模言語モデル (LLM) のトレーニングを行いました。ゲノム データセットの多様なコレクションでモデルをトレーニングすることで、ダウンストリームのタスク パフォーマンスにおけるモデル スケールとデータの多様性の役割を調査しました。

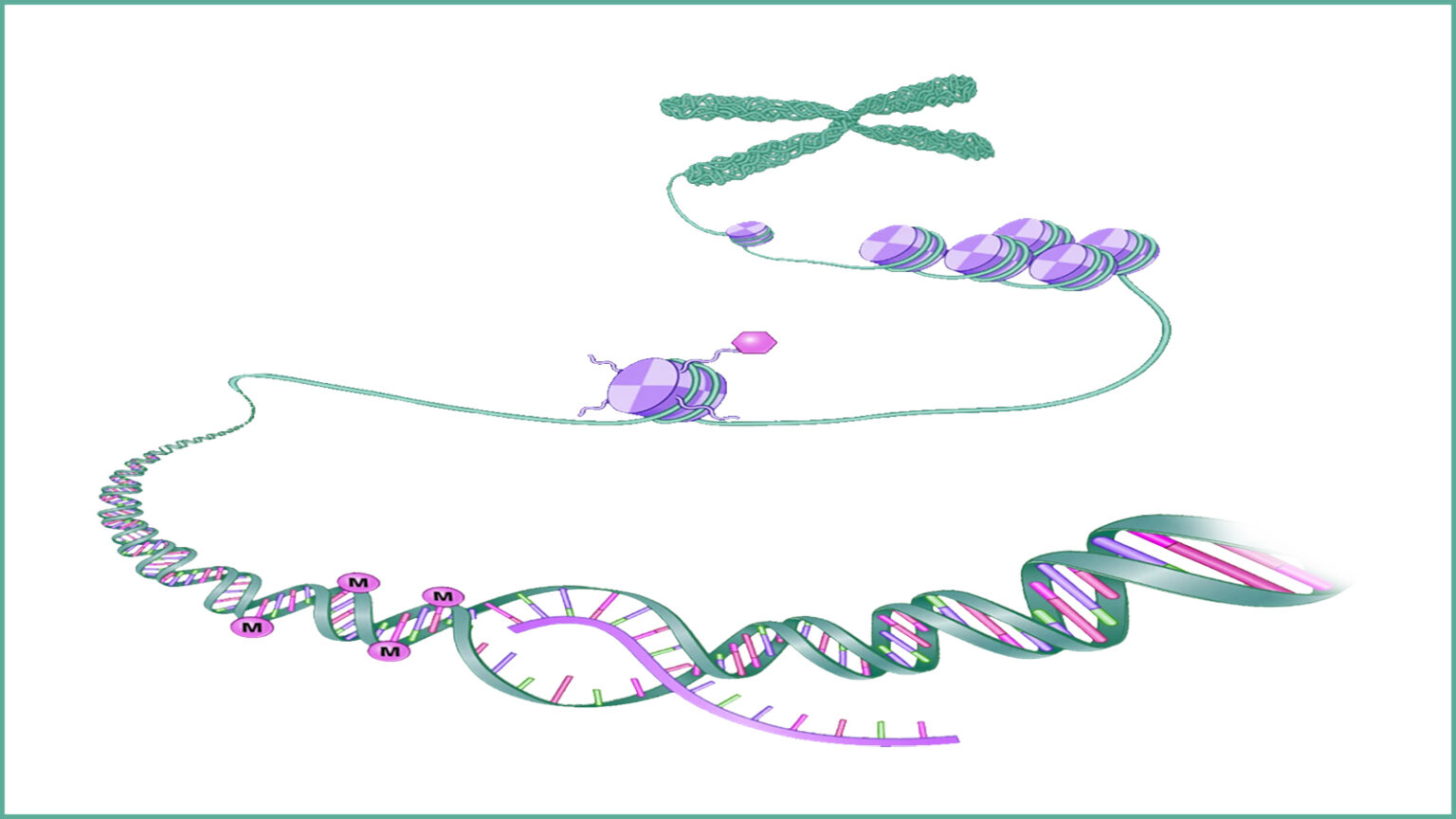

分類タスクには、エンハンサーおよびプロモーター配列と転写因子結合部位の予測が含まれていました。これらのタスクは、DNA がどのように RNA やタンパク質に変換されるか、そのダイナミクスを理解するのに役立ち、新しい臨床応用の道を開くものです。

研究で特定された各タスクにおいて、パフォーマンスはモデルの規模とデータセットの多様性に応じて単調に増加しました。専門化された最先端のモデル ベースラインと比較すると、複数種のデータセットでトレーニングされた最大の 25 億パラメータの LLM は、18 タスク中 15 タスクで同等またはそれ以上のパフォーマンスを達成しました。

これらの結果は、パラメーター効率のファインチューニングを活用することによって達成されました。ただし、単純な浅いパーセプトロン (MLP) またはロジスティック回帰と共に、Transformer モデルのさまざまなレイヤーから抽出された事前トレーニング済みの埋め込みに依拠するだけでも、11 のタスクで同等またはそれ以上のパフォーマンスを達成するのに十分でした。

各モデルのチェックポイントと各タスクのすべてのレイヤーにこのプロービング戦略を適用して、120 万の MLP モデルがトレーニングされました。この研究では、ダウンストリームのタスク パフォーマンスにおける異なるレイヤーの役割など、トレーニングと LLM の使用のさまざまな側面に関する詳細な分析が提供されました。

モデル スケールを固定した場合の配列多様性の直接比較では、モデル スケールの増加と同様に、重要な改善が示されました。例えば、ヒトのリファレンス ゲノムのみでトレーニングされた 5 億パラメーター モデルは、1000 ゲノム データセットでトレーニングされた同じモデルよりもパフォーマンスが劣っていました。

同様に、1000 ゲノム データセットでトレーニングされた 25 億パラメーター モデルは、どの 5 億パラメーター モデルよりも優れたパフォーマンスを示しました。ダウンストリームのパフォーマンスがヒトゲノムのみに関するタスクで測定された場合でも、カスタムの複数種のデータセットでトレーニングされた同じモデルほどパフォーマンスは高くありませんでした。

研究者は、すべての埋め込みが同じように作成されたわけではないことを観察しました。一般的な方法では、ダウンストリームの予測に LLM の最後のレイヤーを使用することが推奨されていますが、中間層がダウンストリームのタスクで著しく高いパフォーマンスを持つ表現を生成したことは興味深いものでした。

InstaDeep の CEO、カリム ベギル (Karim Beguir) 氏は以下のように話しています。「これらは、タスク全体で真に汎化なゲノミクスの基礎モデルを開発することの実現可能性を明確に示した最初の結果であると、我々は信じています。多くの点で、これらの結果は、自然言語処理における適応可能な基盤モデルの開発において過去数年間に見られたものを反映しており、これが創薬や人間の健康における困難な問題に適用されるのはとてつもなく素晴らしいことです」

Cambridge-1 は、プロジェクトの成功に不可欠であり、本プロジェクトでは、ゲノム内の長距離相互作用を捉えるために必要な受容野を備えた大規模モデルをトレーニングするためのハイパフォーマンス コンピューティング インフラストラクチャが不可欠でした。

研究者は、複数のアテンション機構、モデル スケール、トークナイザー スキームなど、さまざまなアプローチを試しました。彼らは最終的に、16 台の NVIDIA DGX A100 ノード (128 基の A100 80GB GPU) でトレーニングされた 25 億パラメーターのスパース アテンション モデルを使用して、タスク全体で公開されている最高のパフォーマンスを達成しました。今後の研究では、チームは、モデルを直接ファインチューンすることにより、ダウンストリームのタスク パフォーマンスのさらなる改善を検討することを計画しており、ゲノミクスに適用される大規模な言語モデルのアーキテクチャの革新に関するコラボレーションを継続します。InstaDeep は、Cambridge-1 を利用する最初の NVIDIA Inception メンバーの 1 社でした。