尽管当今的机器人在受控环境中表现出色,但在应对现实世界任务所需的不可预测性、灵活性和细微交互方面仍面临挑战,例如组装精密组件或以接近人类的精度操作日常物体。

机器人学习正成为弥合实验室演示与现实世界部署之间差距的关键推动力。然而,传统方法面临着根本性的局限性:

- 传统模拟器无法捕捉到现代机器人系统的全部复杂性

- 人类的演示难以跨不同的机器人具身进行转换

- 人类认为理所当然的视觉和触觉的复杂协调对于机器来说仍然难以实现

本期 NVIDIA 机器人研发摘要 (R²D²) 探讨了 NVIDIA Research 在 CoRL 2025 上展示的三项突破性神经创新,这些创新正在重塑机器人的学习与适应方式:

- NeRD (神经机器人动力学):通过学习到的动力学模型增强仿真,这些模型在实现现实世界微调的同时泛化各种任务。

- Dexplore:将动作捕捉的演示视为自适应指导,解锁人类水平的灵活性。

- VT-Refine:结合视觉和触觉感知,通过新颖的从真实到仿真的训练来掌握精确的手动装配任务。

这些进步共同为开发者提供了推动研究所需的技术、库和工作流。

通过神经模拟来教授机器人

仿真在机器人开发工作流程中发挥着关键作用。机器人可以在仿真环境中学习如何稳健地执行任务,因为在训练过程中可以对质量、摩擦力等参数和属性进行随机化。然而,传统模拟器难以准确捕捉现代机器人的复杂性,这些机器人通常具有高自由度和复杂的机械结构。神经模型有助于应对这一挑战,因其能够高效预测复杂的动力学行为,并适应真实世界的数据。

例如,NeRD 是一种用于学习动力学模型的方法,可预测特定机器人(或关节刚体系统)在接触约束下的未来状态。它能够替代分析模拟器中的低层动力学与接触求解器,从而构建一种混合仿真预测框架。

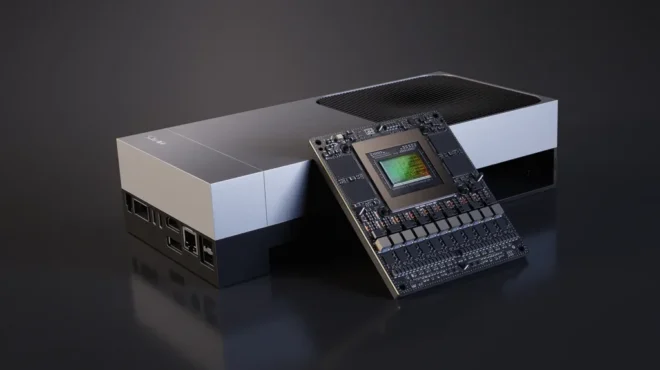

NeRD 采用以机器人为中心的状态表示,实现了空间不变性,从而提升了训练效率和数据效率,并显著增强了泛化能力。NeRD 可轻松集成到现有的刚体仿真框架中,已通过与 NVIDIA Warp 的集成得到验证,并将在未来成为 Newton 物理引擎 中的众多求解器之一。

为了训练给定机器人的 NeRD 模型,我们将收集 10 万个随机轨迹(每个轨迹包含 100 个时间步长)作为训练数据。NeRD 采用 GPT-2 Transformer 的轻量级实现进行建模,并针对六个不同的机器人系统分别训练模型。

NeRD 模型展现出在数千个时间步长中良好的稳定性和准确性。在对 ANYmal 四足机器人进行 1000 步的策略评估中,其在累积奖励估计方面表现出很高的精度,误差低于 0.1%。该方法还支持零样本的仿真到现实迁移,例如在集成 NeRD 的模拟器中训练的 Franka 机械臂到达策略,可直接部署至真实环境。此外,NeRD 还可利用真实数据进行微调,进一步缩小仿真与现实之间的差异。

NeRD 等神经模型将加速机器人研究,使开发者能够精确模拟复杂的全身训练及经典仿真技术。

从人类运动中学习灵巧技能

实现机器人手达到人类水平的灵活性一直是一项重大挑战。人手在运动学复杂性、顺应性以及丰富的触觉感知方面展现出卓越的综合能力。相比之下,机器人手通常自由度较低、驱动能力有限,且感知与控制能力受到制约,这使得机器人难以有效地从人类操作中学习灵巧的技能。

手动物体动作捕捉 (MoCap) 存储库提供了丰富的接触性人类演示,但难以直接用于机器人的策略学习。现有的工作流程包含三个主要组件:重定向、追踪和残差校正,这些环节容易累积误差。

这项研究提出了参考范围探索(RSE),一种统一的单回路优化方法。该方法融合了重定向与跟踪功能,能够直接从运动捕捉(MoCap)数据中训练出可扩展的机器人控制策略。演示不再被视为“严格”的事实,而是作为柔性指导信号使用。

这保留了演示的意图,并使机器人能够自主发现与其化身兼容的动作。

工作流的第二部分是基于视觉的生成式控制策略,而蒸馏则是一种基于状态的模仿控制策略。这使得机器人手能够利用来自单视图深度图像的部分观测信息来操作物体,并实现用户定义的稀疏目标。

在训练过程中,该策略的目标是让机器人的手遵循给定的轨迹,以执行多种物体操作技能,例如抓取香蕉、手机、杯子和双筒望远镜。该模型由编码器、先前网络和解码器策略组成。在推理阶段,系统会省略编码器,并直接从先前学习的内容中对隐嵌入进行采样,从而生成一种生成式控制策略,仅通过部分观测即可实现高效的、面向目标的灵巧操作。

借助 Inspire 指针,该方法的成功率提升了近 20%。它在 Inspire 和 Allegro 机器人手上表现 consistently 优于各项基准方法。基于状态的策略通过其在未见场景中模仿人类演示及泛化能力进行评估,而基于视觉的策略框架则通过模拟环境中的表现以及成功迁移至现实世界操作的能力进行验证。

视觉与触觉相结合,实现精确的手动装配

人类擅长操作和手动装配任务,因为在这些过程中他们高度依赖视觉和触觉反馈。以双手连接插头和插座组件为例:首先,人们可以通过视觉直观地识别并抓取所需部件;随后,在装配过程中,触觉反馈起着至关重要的作用,因为仅依靠视觉反馈(尤其是在存在遮挡的情况下)会使任务变得极为困难。

采用扩散策略的行为克隆很有用,但在现实世界中,演示数据有限,且数据采集接口的触觉反馈也较为有限。

为解决这一数据问题,VT-Refine 开发了一种新颖的“真实到仿真”框架,该框架融合了仿真、视觉与触觉信息,可有效应对手动组装任务中的挑战(图 4)。其主要步骤简要概述如下:

- 收集少量的真实演示 (例如 30 集) ,以预训练手动视觉 – 触觉扩散策略。

- 使用强化学习 (RL) 在并行模拟环境的数字孪生中微调此策略。

- 将此策略部署回现实世界。

触觉感知输入仿真基于 TacSL, 一个与 Isaac Lab 集成的、基于 GPU 加速的触觉仿真工具。借助 GPU 的高效计算能力,仿真过程能够更精确地近似触觉传感器的柔顺性行为,从而提升仿真到现实的可迁移性,并支持可扩展的训练。训练过程中所使用的观测信息包括:

- 以自我为中心的摄像头捕获的点云

- 触觉传感器反馈的点云表示

- 臂和机械手的关节位置

然后,使用收集的数据对扩散策略进行预训练。为了在仿真环境中实现大规模训练,我们结合视觉和触觉传感器构建了场景的数字孪生。通过人类示范进行的预训练提供了一个强有力的先验,能够在无需复杂奖励工程的情况下有效引导强化学习的探索过程。

RL 微调策略通过引入必要的探索,显著提升了高精度装配任务的性能。该策略将纯视觉版本在现实世界中的成功率提高了约 20%,将视觉-触觉版本的成功率提升了约 40%。尽管仿真到实际迁移的成功率略有下降,幅度约为 5–10%,但相较于在仿真中采用 RL 微调可将成功率提高 30% 以上的情况,这一下降可忽略不计。

这项工作首次成功地将基于大规模模拟的双手动视觉触觉策略的强化学习从仿真迁移到现实。

总结

机器人学习的进步正在改变机器人获取复杂技能并将其从仿真迁移到现实世界的方式。NeRD 支持更精确的动态预测,RSE 简化了从人类演示中学习灵巧操作的过程,VT-Refine 则融合视觉与触觉以实现稳健的手动装配。这些方法共同展示了可扩展的数据驱动学习如何逐步缩小机器人与人类能力之间的差距。

请查看以下资源以获取更多信息,并于 CoRL and Humanoids,9 月 27 日至 10 月 2 日在韩国首尔举行的大会上,了解 NVIDIA 各项研究成果的展示:

本文是我们 NVIDIA 机器人研发摘要 (R2D2) 的一部分,旨在帮助开发者深入了解 NVIDIA Research 在物理 AI 与机器人应用领域的最新突破。

深入了解将于 CoRL 和 Humanoids 大会上展示的研究成果,于 9 月 27 日至 10 月 2 日在韩国首尔举行。

此外,您还可以参加 2025 BEHAVIOR 挑战赛,这是一项用于评估机器人推理、运动与操作能力的基准测试,包含 50 项家庭任务以及 10,000 次远程操作演示。

通过订阅时事通讯并关注 NVIDIA Robotics 的 YouTube、Discord 和 NVIDIA 开发者论坛,及时获取最新资讯。如需开启您的机器人开发之旅,请注册免费的 NVIDIA 机器人开发基础课程。

致谢

感谢 Arsalan Mousavian、Balakumar Sundaralingam、Binghao Huang、Dieter Fox、Eric Heiden、Iretiayo Akinola、Jie Xu、Liang-Yan Gui、Liuyu Bian、Miles Macklin、Rowland O’Flaherty、Sirui Xu、Wei Yang、Xiaolong Wang、Yashraj Narang、Yunzhu Li、Yu-Wei Chao 和 Yu-Xiong Wang,感谢他们对本博文中提及的研究工作所做出的贡献。