机器人技术正经历一场变革,逐步脱离专用机器时代,迈入通用机器人时代。这一转变意味着机器人不再局限于单一用途、功能固定的形态,而是向更具备适应性的机器人演进,以在不同环境中执行多样化任务。受人类认知模式启发,具备适应性的机器人能够将快速反应能力与高阶推理规划能力相结合,以更高效地学习与适应环境。

这一模式为机器人在不同行业的灵活应用打开了大门,不仅降低了成本,其实际应用范围也远超专用机器人的能力边界。NVIDIA 在 2025 年 GTC 大会上正式推出 NVIDIA Isaac GR00T 平台,为这场变革奠定了基础。该平台整合了机器人基础模型、合成数据工作流、仿真环境与运行时计算机,为通用机器人发展提供全方位支撑。

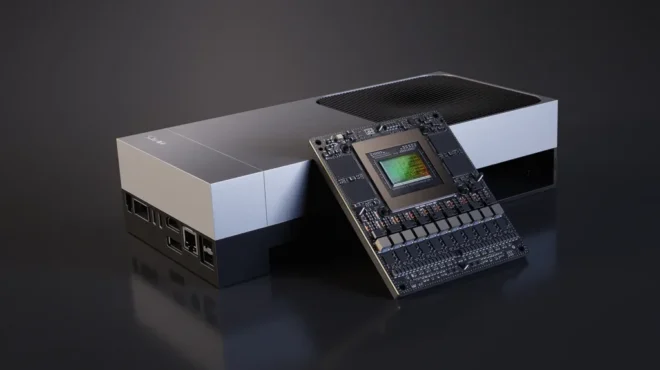

今天,我们兴奋地宣布 NVIDIA Jetson AGX Thor 开发者套件与 NVIDIA Jetson T5000 模组正式公开发售。这将为全球开发者赋能,助力打造物理 AI 的未来。借助 Jetson Thor,机器人无需为每项新任务重新编程。Jetson Thor 是面向物理 AI 的卓越平台,这一机器人计算机可支持生成式推理,同时具备多模态、多传感器处理能力。将 Jetson Thor 集成至下一代机器人中,能为基础模型提速,使其在物体操作、导航、执行复杂指令等挑战性任务中具备更高的灵活性。

打造通用人形机器人需具备哪些条件?

打造一款典型的通用人形机器人,需构建四个核心层级:

- 硬件抽象层:整合所有关键传感与驱动模态,使机器人能够感知环境并与物理世界进行实体交互。

- 实时控制框架层:对机器人运动进行精准、低延迟控制。机器人想要实现安全运行以及迅速响应,最大限度降低延迟至关重要。

- 感知与规划层:为机器人赋予环境理解、抓取与运动规划、移动、物体识别及定位能力,使其能与周边环境有效交互。与实时控制层不同,该层级可允许稍长的处理时间,以确保决策的周全性与准确性。

- 高阶推理层:支撑场景理解、复杂任务规划、自然语言交互等高级功能。在此层级中,为实现更深层次的推理与更强的适应性,稍长的处理时间是可接受的。

图 1. 打造人形机器人需整合一系列硬件与软件组件

NVIDIA Jetson Thor 为什么是物理 AI 与人形机器人的卓越平台?

NVIDIA Jetson AGX Thor 开发者套件具备无可比拟的性能与可扩展性。该套件使用 NVIDIA Blackwell 架构 GPU,具备 128 GB 内存,AI 计算性能最高可达 2070 FP4 TFLOPS,可轻松运行最新的生成式 AI 模型,所有这些都在 130 瓦的功率范围内实现。与 NVIDIA Jetson AGX Orin 相比,其 AI 计算性能提高至 7.5 倍,能效提高至 3.5 倍。

借助全新的 Blackwell 多实例 GPU(MIG)与性能强劲的 14 核 Arm Neoverse-V3AE CPU,Jetson Thor 能为低延迟、实时性应用提速。此外,该平台还集成了一整套加速器,包括第三代 Programmable Vision Accelerator(PVA)、双编码器与解码器、光流加速器等。

在高速传感器融合方面,开发者套件提供丰富的输入输出(I/O)接口选项,包括 1 个支持 4 路 25GbE 的 QSFP 插槽、1 个有线 Multi-GbE RJ45 接口、多个 USB 端口及其他连接接口。同时,其设计可与现有人形机器人平台无缝集成,支持便捷的有线连接,能够快速启动原型开发。

Transformer 引擎与 FP4 支持

Jetson Thor 基于 NVIDIA Blackwell 架构打造,引入原生 FP4 量化技术,并搭配下一代 Transformer 引擎,该引擎可在 FP4 与 FP8 精度之间动态切换,以实现最优性能。通过将 4 位权重、激活值与更高内存带宽相结合,Jetson Thor 能同时加速生成式 AI 工作负载中的预填充与解码过程。

多实例 GPU(MIG)

Jetson Thor 引入 MIG 技术,可将单块 GPU 划分为多个相互隔离的实例,每个实例拥有专属资源。这一技术能为关键工作负载预留计算资源,同时并行运行对时间敏感度较低的任务,确保性能的可预测性,对于需兼顾多重关键任务的机器人应用而言,这一特性尤为重要。

表 1 与表 2 分别展示了 Jetson T5000 模组及 NVIDIA Jetson AGX Thor 开发者套件载板的核心特性与接口规格。

| NVIDIA Jetson T5000 | NVIDIA Jetson T4000* | |

| AI 性能 | 2070 TFLOPS (Sparse FP4) 1035 TFLOPS (Dense FP4 | Sparse FP8 | Sparse INT8) 517 TFLOPs (Dense FP8 | Sparse FP16) | 1200 TFLOPS (Sparse FP4) 600 TFLOPS (Dense FP4 | Sparse FP8 | Sparse INT8) 300 TFLOPS (Dense FP8 | Sparse FP16) |

| GPU | 2560 核 NVIDIA Blackwell 架构 GPU,包括 96 个第五代 Tensor Core 支持 MIG,含 10 个 TPC | 1536 核 NVIDIA Blackwell 架构 GPU,包括 64 个第五代 Tensor Core 支持 MIG,含 6 个 TPC |

| CPU | 14 核 Arm Neoverse-V3AE 64 位 CPU | 12 核 Arm Neoverse-V3AE 64 位 CPU |

| 内存 | 128 GB 256 位 LPDDR5X,内存带宽 273 GB/s | 64 GB 256 位 LPDDR5X,内存带宽 273 GB/s |

| 频率 | 1.57 GHz max GPU 2.6 GHz max CPU | 1.57 GHz max GPU 2.6 GHz max CPU |

| 存储 | 支持通过 PCIe 接口连接 NVMe 支持通过 USB3.2 接口连接 SSD | 支持通过 PCIe 接口连接 NVMe 支持通过 USB3.2 接口连接 SSD |

| 视觉加速器 | PVA v3.0 | PVA v3.0 |

| 视频编码 | 最高支持 6 路 4Kp60(H.265/H.264) | 最高支持 6 路 4Kp60(H.265/H.264)* |

| 视频解码 | 最高支持 4 路 8Kp30(H.265) 最高支持 4 路 4Kp60(H.264) | 最高支持 4 路 8Kp30(H.265)*最高支持 4 路 4Kp60(H.264)* |

| 摄像头 | 通过 HSB 接口支持最多 20 路摄像头 通过 16 通道 MIPI CSI-2 接口支持最多 6 路摄像头 通过虚拟通道支持最多 32 路摄像头 支持 C-PHY 2.1(10.25 Gbps)、D-PHY 2.1(40 Gbps) | 通过 HSB 接口支持最多 20 路摄像头 通过 16 通道 MIPI CSI-2 接口支持最多 6 路摄像头 通过虚拟通道支持最多 32 路摄像头 支持 C-PHY 2.1(10.25 Gbps)、D-PHY 2.1(40 Gbps) |

| 显示 | 4 路共享 HDMI2.1 接口 VESA DisplayPort 1.4a(HBR2、MST) | 4 路共享 HDMI2.1 接口 VESA DisplayPort 1.4a(HBR2、MST) |

| 功耗 | 40W – 130W | 40W – 70W |

表 1. NVIDIA Jetson AGX Thor 开发者套件模组规格

注:带*的参数为初步数据,可能存在变动

| NVIDIA Jetson AGX Thor 开发者套件规格参数 | |

| 集成式 NVIDIA Jetson 模组 | NVIDIA Jetson T5000 模组 |

| 存储 | 在 M.2 Key M 插槽上集成 1TB NVMe |

| 摄像头 | 通过 QSFP 插槽连接 HSB 摄像头 USB 摄像头 |

| PCIe | 支持 x4 PCIe Gen5 的 M.2 Key M 插槽(搭载 1TB NVMe) 支持 x1 PCIe Gen5 的 M.2 Key E 插槽(搭载 Wi-Fi 6E 和蓝牙模组) |

| USB | 2 个 USB Type-A 3.2 Gen2 接口 2 个 USB Type-C 3.1 Gen1 接口 1 个 USB Type-C 接口(仅用于调试) |

| 网络 | 1 个 5GBe RJ45 接口 1 个 QSFP28 接口(支持 4 路 25GbE) |

| Wi-Fi | 802.11ax Wi-Fi 6E |

| 显示 | 1 个 HDMI 2.0b 接口 1 个 DisplayPort 1.4a 接口 |

| 其他 I/O | 2 个 13-pin CAN header 2 个 6-pin Automation header 2 个 5-pin JTAG Connector 1 个 4-pin Fan Connector(12V、PWM) 2 个 5-pin Audio Panel header 2-pin RTC 备用电池 Connector Microfit Power Jack Power、Force Recovery 和 Reset buttons |

| 机械尺寸 | 243.19 mm x 112.40 mm x 56.88 mm (高度含支撑脚、载板、模组与散热解决方案) |

表 2. NVIDIA Jetson AGX Thor 开发者套件载板规格

图 2. NVIDIA Jetson Thor 模组的组件构成

Jetson Thor 如何为边缘端生成式 AI 提速?

Jetson AGX Thor 是全新的机器人计算机,其架构从底层重新设计,专为驱动下一代人形机器人打造。该平台支持各类生成式 AI 模型,既包括 NVIDIA Isaac GR00T N1.5 这类视觉语言动作模型(VLA),也涵盖所有主流大型语言模型(LLM)与视觉语言模型(VLM)。

为提供无缝的云端到边缘端衔接体验,Jetson Thor 可运行 NVIDIA 面向物理 AI 应用的 AI 软件栈,包括面向机器人的 NVIDIA Isaac、面向视觉 AI 智能体的 NVIDIA Metropolis,以及面向传感器处理的 NVIDIA Holoscan。开发者还可以借助视频搜索与总结(VSS)的 NVIDIA 代理式 AI 工作流等,在边缘端构建 AI 智能体。

图 3. Jetson Thor 支持各类 AI 框架与生成式 AI 模型

为什么生成式推理与多模态传感器处理对物理 AI 至关重要?

生成式推理模型对于需要仿真可能的动作序列、预测结果、基于语言或视觉线索推理、灵活生成高阶规划或低阶运动策略的机器人平台至关重要。这些模型能让机器人系统在真实场景中具备更高灵活性、更强适应性,以及接近人类水平的稳健推理能力。

NVIDIA Jetson Thor 在生成式推理领域实现了巨大飞跃,与 Jetson Orin 相比,其推理速度提升最高达 5 倍。借助 FP4 精度优化与推测解码技术,开发者还能在 Jetson Thor 上进一步实现 2 倍的性能提升。

图 4. 在生成式推理方面,Jetson Thor 速度较 Jetson Orin 最高提升至 5 倍

Jetson Thor 还能无缝处理多个生成式 AI 模型与大量多模态传感器输入,实现实时响应。图 5 通过 Qwen2.5-VL-3B VLM 与 Llama 3.2 3B LLM 两款模型展示了这一能力,测试中两款模型需同时处理 16 个并发请求。结果显示,两款模型的“首 token 生成时间(Time to First Token,TTFT)”均远低于 200 毫秒,“输出 token 生成时间(Time per Output Token,TPOT)”均远低于 50 毫秒——而这两项指标正是衡量系统响应速度的核心标准。

图 5. Jetson Thor 在处理多个生成式 AI 模型与大量多模态传感器输入时,仍能保持实时响应

Jetson Thor 不仅支持 Blackwell 架构原生 FP4 精度,还能启用推测解码等高级技术。在推测解码技术中,先由小型草稿模型生成候选 tokens,再由大型模型验证 tokens 的有效性。这种方式在保证生成准确性的同时,能加速生成式 AI 推理过程,最终实现更快、更高质量的输出。

图 4 显示了在采用 FP4 量化与基于 Eagle 的推测解码技术后,Qwen2.5-VL-7B 模型在 Jetson Thor 上的推理速度较采用 W4A16(4 位权重、16 位激活值)配置的 Jetson Orin,最高提升至 3.5 倍。

此外,如表 3 所示,在 LLM、VLM、VLA 等各类生成式 AI 模型上,Jetson Thor 的加速性能均实现突破,较 Jetson Orin 提升最高至 5 倍。

| 模型类型 | 模型 | Jetson AGX Thor (output tokens/sec) | Jetson AGX Orin (output tokens/sec) | 性能提升倍数 |

| LLM | ||||

| Llama | Llama 3.1 8B | 150.8 | 112.33 | 1.34 |

| Llama 3.3 70B | 12.64 | 7.38 | 1.71 | |

| Qwen | Qwen3-30B-A3B | 226.42 | 76.69 | 2.95 |

| Qwen3-32B | 79.1 | 16.84 | 4.70 | |

| DeepSeek | DeepSeek-R1-Distill-Qwen-7B | 304.76 | 180.41 | 1.69 |

| DeepSeek-R1-Distill-Qwen-32B | 82.63 | 16.96 | 4.87 | |

| VLM | ||||

| Qwen | Qwen2.5-VL-3B | 356.86 | 216 | 1.65 |

| Qwen2.5-VL-7B | 252 | 154.02 | 1.64 | |

| Llama | Llama 3.2 11B Vision | 69.63 | 44.22 | 1.57 |

| VLA | ||||

| GR00T | GR00T N1 | 46.7 | 18.5 | 2.52 |

| GR00T N1.5 | 41.5 | 15.2 | 2.74 | |

表 3. Jetson Thor 与 Jetson AGX Orin 的基准测试对比

基准测试配置说明:序列长度 2048,输出序列长度 128;最大并发数 8;LLM 与 VLM 模型基于 VLLM 框架运行,VLA 模型基于 TensorRT 框架运行;Jetson AGX Thor 与 Jetson AGX Orin 均采用 MAXN 功耗模式。

Jetson 软件如何为边缘端 AI 提速?

Jetson 软件通过提供一套高度集成的全栈软件平台,为边缘端 AI 性能提速。该平台针对机器人、医疗、物流、自主系统等领域的实时、高吞吐量应用进行优化,可满足多样化场景需求。

Jetson 软件以 JetPack 7 为核心驱动,搭载 Linux 6.8 内核、Ubuntu 24.04 LTS 操作系统及最新 NVIDIA AI 栈,能够实现低延迟、确定性的高阶生成式 AI 模型运行,为物理 AI 应用提供支撑。它融合了硬件加速计算与系统级优化能力,能够让人形机器人、自主机器、工业自动化系统等复杂系统具备响应能力及智能行为。

凭借集成式 Holoscan Sensor Bridge、MIG 支持以及 Preemptable Realtime Kernel 等特性,Jetson 软件显著提升了高速传感器融合、运动规划等任务的性能与效率。在 Jetson AI Lab 及广泛生态系统的支持下,Jetson 软件大幅缩短了边缘 AI 与机器人应用的性能达标时间(time-to-performance)。

Jetson Thor 平台支持全新的 Cosmos Reason——这是一款面向物理 AI 与机器人的开源、可定制、70 亿参数推理型 VLM。

图 7. Jetson 软件栈

采用 SBSA 架构设计的 JetPack 7

借助 JetPack 7,Jetson 软件实现了与服务器基础系统架构(Server Base System Architecture,SBSA)的对齐,使 Jetson Thor 的设计达到 Arm 服务器设计的行业标准。SBSA 对标准化的关键硬件与固件接口,能提供更完善的操作系统支持、更简便的软件迁移能力,以及更顺畅的企业级集成体验。在此基础上,Jetson Thor 可以支持在所有 Arm 目标平台上统一安装 CUDA 13.0,不仅简化了开发流程、减少了版本碎片化问题,还确保了从服务器级系统到 Jetson Thor 平台的体验一致性。

NVIDIA Isaac 如何端到端加速机器人开发?

NVIDIA Isaac 是开源的机器人平台,包含一系列 CUDA 加速库、框架与 AI 模型,可用于开发自主移动机器人、机械臂、人形机器人等各类机器人产品。现代机器人需要一个由控制、视觉与语言模型构成的高级“大脑”,能够通过实时处理多模态数据,实现从感知到动作的无缝衔接。

Jetson Thor 专为运行 Isaac GR00T N1.5 这类高负载模型而设计,能为人形机器人提供实时人机交互、空间感知与稳健的环境感知能力。Isaac 平台与 Jetson Thor 协同配合,可实现在边缘部署具备可扩展性的多模态 AI,为工业与科研领域的机器人技术创新提速。

图 8. NVIDIA Isaac GR00T 端到端加速机器人开发

如何借助 VSS 从边缘摄像头中获取有价值的信息?

NVIDIA Metropolis 中用于视频搜索与总结的(VSS)NVIDIA Blueprint,为开发者提供了构建和部署视频分析 AI 智能体的工具。这类 AI 智能体可通过分析实时摄像头流,实现情境化实时警报、视频总结与智能问答功能。

VSS 正为多领域视觉智能体应用提供支撑:在制造业中用于视觉检测与工人安全监测;在体育赛事直播中用于提升粉丝互动体验与运动员数据分析;在道路事件处理中则可缩短应急响应时间。

图 9. VSS 应用场景包括制造业视觉检测、工人安全监测,以及缩短道路事件应急响应时间

Jetson Thor 上的 Holoscan 如何用于实时传感器处理?

NVIDIA Holoscan 是一款 AI 传感器处理平台,提供软件定义的实时 AI 所需的全栈加速基础设施。它可以简化企业级硬件上边缘 AI 的部署流程并提升可扩展性,为实时 AI 应用提供高性能边缘解决方案。

在 Jetson Thor 上运行 Holoscan,可对并发 AI 工作流进行安全分区与隔离——这一特性能为关键任务应用提升确定性及容错能力,并提供数据防泄漏保护。如此一来,开发者可在不影响安全性的前提下持续推进 AI 创新,使得 Holoscan 成为受监管领域内实时动作控制的可信操作层。

现代机器人依赖各类传感器实现智能运行,包括摄像头、IMU、执行器等,每一种传感器对机器人的正常工作都至关重要。借助 NVIDIA Holoscan Sensor Bridge,无论任何传感器类型,都能通过以太网将所有传感器无缝连接至 NVIDIA Jetson 平台。Jetson Thor 支持全新的以太网摄像头技术,可将传感器数据直接传输至 GPU 内存,大幅降低延迟并减少 CPU 占用率。这种方式用简洁的软件定义 API 替代了传统驱动的复杂逻辑,使实时边缘 AI 应用(无论是机器人、工业自动化系统还是先进医疗系统)能够实现精准同步与稳健扩展。

助力缩短产品上市时间的全方位生态系统

Jetson 生态系统包括超过 1,000 个合作伙伴,为帮助开发者更快地将解决方案推向市场,不同类型的合作伙伴可以提供针对性的支持服务,为开发流程的各个阶段提供必要的支持。

| 合作伙伴类型 | 服务 |

| 独立软件供应商(ISV) | 应用软件 |

| 云服务提供商(CSP)及软件工具 | 平台操作系统、设备管理、AI 模型定制与迁移服务 |

| 平台软件及 AI 服务 | 平台操作系统、系统软件 |

| 硬件合作伙伴(OEM / ODM、系统集成商、设计公司等) | 载板、COTS、定制化系统、一站式设计服务、连接模块 |

| 传感器 | 摄像头(MIPI / GMSL、以太网接口、USB)、激光雷达、IMU、音频设备、以及 ISP 调试服务 |

| 分销商 | Jetson 模组与开发者套件 |

表 4. Jetson 生态系统包含超过 1,000 个合作伙伴

图 10. NVIDIA 合作伙伴提供灵活的合作模式,开发者可根据自身设计需求选择特定组件与服务

即刻开始,使用 NVIDIA Jetson Thor 开发物理 AI

将 Jetson AGX Thor 开发者套件集成至现有机器人,即可加速软件开发。开发者无需等待完整的系统集成,即可开始创建并测试应用。

视频 1. 了解如何使用 NVIDIA Jetson AGX Thor 开发者套件

加入全球超 200 万开发者的行列,开启下一代物理 AI 项目的开发。Jetson AGX Thor 开发者套件(售价为 3,499 美元)以及 Jetson T5000 量产级模组,已经可以通过 NVIDIA 全球授权分销商购买。

开始使用 NVIDIA Jetson AGX Thor 开发者套件,下载最新的 JetPack 7。

通过 Jetson 下载中心以及生态系统合作伙伴,获得全面的文档、支持资源和工具。如果有任何问题或者需要帮助,请通过 NVIDIA 开发者论坛与行业专家级其他开发者联系。