电信行业正快速向AI原生无线接入网(AI-RAN)和以AI为核心的6G方向演进。分布式用户面功能(dUPF)通过去中心化的数据包处理与路由,将计算能力推向网络边缘,实现超低延迟和高吞吐量,同时支持分布式AI工作负载的无缝集成。dUPF正逐步成为移动网络发展的关键组件,并融入基础AI基础设施之中。

本文探讨了dUPF在电信边缘实现代理式AI应用的架构优势,并提供了基于NVIDIA DOCA Flow构建的dUPF用户平面应用程序的参考实现,以充分利用硬件加速的数据包转发与处理能力。演示重点展示了NVIDIA加速计算平台如何实现高效能、低延迟的用户平面操作,凸显了dUPF 在 6G AI原生无线网络计划(AI-WIN)全栈架构中的关键作用。

什么是 dUPF?

dUPF 是 3GPP 5G 核心网络中的一项功能,依据 3GPP 5G 核心架构第 6.2.5 节以及 3GPP 5G 移动边缘计算(MEC)架构第 4.2 节的定义,负责在分布式位置执行用户平面数据包的处理。dUPF 将用户数据处理能力下沉至更靠近用户和无线接入节点的位置。相比传统 UPF 可能因回传路径较长而引入较高延迟,dUPF 在网络边缘进行流量处理,能够通过面向 AI 应用的本地数据网络(AI-DN)实现 AI 流量的实时处理与本地分流,如图 1 所示。

dUPF 在以 AI 为中心的 6G 网络中如何实现高效协同与智能运行?

6G 旨在将电信运营商转型为关键的 AI 基础设施,通过托管 AI 工厂 并以 AI 网格的形式分发 AI 推理能力。dUPF 是实现 6G 分布式边缘代理式 AI 与本地分流(LBO)的核心组成部分。

视频搜索与摘要(VSS)、XR、游戏和工业自动化等新一代应用对网络边缘的实时自主智能提出了迫切需求,而传统集中式无线核心架构难以满足这一要求。

这种接近性带来了以下优势:

- 超低延迟: 为任务关键型 6G 应用提供即时响应能力。

- 高效数据处理: 在数据源头进行本地化处理,有效降低延迟并优化网络资源利用。

- 增强数据隐私与安全性: 通过本地处理减少敏感数据的传输,降低暴露风险,提升系统可信度。

- 面向弹性 AI 的去中心化计算: 分布式部署 AI 工作负载,构建强健、灵活的基础设施,避免单点故障。

dUPF 在 NVIDIA 加速的边缘基础设施上具备哪些优势?

NVIDIA AI Aerial 平台是一套集加速计算硬件、软件与服务于一体的综合平台,旨在支持无线网络的设计、仿真与部署。将 dUPF 部署在 AI Aerial 边缘基础设施上,可带来显著优势。

- 超低延迟:延迟可低至 25 微秒,实现零丢包,显著提升边缘 AI 推理的用户体验。

- 降低成本:通过分布式处理与资源利用优化,减少回传需求和运营开销,从而有效降低总体运输成本。

- 能效提升: 支持 NVIDIA DOCA Flow 的硬件加速技术,降低 CPU 占用率,释放共享硬件上的计算核心,为 AI 应用提供更高能效。

- 新的收入模式:赋能 AI 原生服务与应用,支持对实时边缘数据处理有高要求的创新业务场景。

- 增强的网络性能:提升 AI 与无线接入网(RAN)流量的可扩展性,实现更优的抖动控制与确定性网络行为。

dUPF 的核心价值主张与 6G AI-WIN 计划高度契合,使其成为该计划全栈架构中不可或缺的组成部分。该计划联合了 T-Mobile、MITRE、思科、ODC 以及 Booz Allen Hamilton,共同致力于基于 NVIDIA AI Aerial 技术打造 6G AI 原生网络堆栈。

dUPF 用例

dUPF 的主要应用场景包括:

超低延迟应用程序:通过在边缘侧部署 dUPF 功能,可实现数据的本地化处理与路由,有效避免回传带来的延迟。这一特性在以下场景中尤为关键:

- AR/VR 与 AI 智能体的实时交互

- V2X:智能汽车与机器人通信

- 远程手术及实时工业自动化

边缘 AI 与数据密集型工作负载: 通过将 dUPF 与 AI 原生平台(如 NVIDIA Grace Hopper)集成,可支持分布式 AI RAN、代理式 AI 和本地化自主控制等应用,实现高效的实时边缘推理。

图3展示了VSS数据处理与提取的工作流程,其中摄像头视频流与部署的dUPF在边缘侧协同处理,实现本地分流。通过将推理任务下沉至边缘服务器,运营商能够提供低延迟的服务,同时大幅降低骨干网络的数据负载。

dUPF用户平面参考实现

dUPF 用户平面的参考实现基于图 3 所示的分解架构,该架构包含两个关键组件:dUPF-UP 和 dUPF-CP。

dUPF-UP: 该组件负责利用 DOCA Flow API 加速用户面数据包处理,实现基本的 UPF 用户面功能。

- 数据包检测规则(PDR)

- QoS 执行规则(QER)

- 使用情况报告规则(URR)

- 转发操作规则(FAR)

dUPF-CP: 通过 3GPP N4 接口与 SMF 进行通信,同时通过 CNI 的内部消息传递接口(gRPC)与 dUPF-UP 交互,以支持用户面数据包的处理。

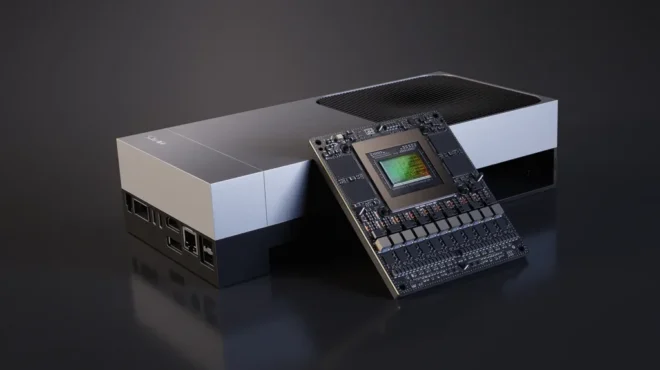

dUPF-UP 部署于搭载 NVIDIA Grace CPU 与 NVIDIA BF3 DPU 的 NVIDIA 加速 Supermicro 1U Grace Hopper MGX 服务器平台。在边缘侧,AI-DN 流量由 dUPF-UP 进行处理,而其他用户流量(如互联网流量)则通过传输网络转发至集中式 UPF。

dUPF-UP 加速架构及其数据流

NVIDIA Grace CPU 超级芯片与 NVIDIA BlueField-3(BF3)SuperNIC 是实现 RAN 与 dUPF-UP 共同托管的关键硬件。图 5 展示了 dUPF-UP 的数据包处理流程。

Grace CPU 超级芯片搭载 72 个 Arm Neoverse V2 核心,通过 NVIDIA 可扩展一致性架构 (SCF) 实现高达 3.2 TB/s 的带宽,显著提升了 dUPF 用户平面的数据包处理性能与能效。BF3 SuperNIC 则借助 DOCA Flow 流水线,加速 dUPF 数据平面的各项功能。

- 数据包分类(基于5元组、DSCP/VLAN、GTP TEID/QFI)

- GTP封装与解封装

- 流量测量(AMBR/MBR)

- 使用统计与配额管理(基于URR的使用率)

- 数据转发(支持直接转发的快速路径,以及处理异常数据包的慢速路径)

- 主机CPU处理镜像(例如用于合法监听)

使用 DOCA Flow 实现 dUPF-UP 的参考方案

dUPF-UP 参考实现通过 DOCA Flow 加速 AI 流量的 LBO,利用基于 IP 子网的服务数据流(SDF)进行分类,有效简化了 AI-DN 的部署流程。主要优化体现在以下几个方面:

- 利用 IP 子网 SDF 实现边缘 AI 应用的区分

- 通过 MTU 对齐避免 IP 分片与重组

- 基于数据包检测规则(PDR)的保障机制,简化 QoS 实现与计费

dUPF-UP DOCA Flow 流水线专为 N3 和 N6 接口设计,旨在优化数据处理效率与传输性能。

N3 接口 DOCA Flow 工作流设计优化

上行链路在 N3 接口上的工作流包含如图 5 所示的管道:

- GTP 解封装: 执行 GTP 报文头的解封装操作

- 计数器: 统计接收到的数据包,用于生成 URR 报告

- 策略器 QoS 流 MBR: 在 QoS 流级别执行 MBR 的 QER 控制

- 策略器 QoS 会话 MBR: 在会话级别执行 MBR 的 QER 控制

- 计数器: 在 QER 处理后对数据包进行计数,用于生成 URR 报告

- FAR(DSCP 标记): 执行 DSCP 标记及其他 FAR 相关处理

- 转发: 将数据包转发至 N6 接口

N6 接口 DOCA Flow 工作流的设计

N6 接口的下行链路工作流包含如图 7 所示的管道结构。

- GTP 解封装: 执行 GTP 报文头的解封装处理

- 计数器: 对接收的数据包进行统计,用于生成 URR 报告

- QoS Flow 策略执行(MBR 控制): 根据 QoS Flow 级别的最大比特率(MBR)执行 QER 相关操作

- QoS 会话策略执行(MBR 控制): 针对会话级别的最大比特率(MBR)执行 QER 相关操作

- 计数器: 在 QER 测量完成后对数据包进行计数,以支持 URR 报告生成

- GTP 封装: 执行 GTP 报文头的封装处理

- FAR 处理(DSCP 标记): 执行 DSCP 标记及其他 FAR 相关处理

- 数据转发: 将数据包转发至 N6 接口

如需详细了解如何对 Counter、Policer、GTP Encap、GTP Decap、FAR 和 Forward 管道进行编程,请参考 DOCA Flow 程序设计指南以及 DOCA Flow 示例应用指南。

dUPF-UP 示例实现的实验室验证

在 Supermicro 1U Grace Hopper MGX 系统服务器上对 dUPF-UP 进行了测试,使用了两个专用 CPU 核心(core-0 和 core-1)。其中,core-0 负责运行控制程序,用于 AI-DN 会话的建立;core-1 则在轮询模式驱动(PMD)下处理慢路径中的异常数据包。dUPF-CP 模拟器以每秒 1000 个会话的速率,成功启动了 6 万个 UE 会话。会话建立完成后,用户面数据包通过 TRex 流量生成器经由两条 100G 链路发送。

观察结果如下:

- 在控制程序中,Core-0 的 CPU 占用率平均为 7%。

- 由于采用 PMD 轮询模式,Core-1 的 CPU 使用率达到 100%,但并未接收到异常数据包,因为所有用户面数据包均由 BF3 处理。

- BF3 网卡通过硬件加速处理全部用户面数据包,实现了 100 Gbps 的吞吐量,并确保零丢包。

实验室性能测试概要

基于性能实验室测试,Grace 和 BF3 平台上的 dUPF-UP 示例实现在 100G 链路下达到了 100 Gbps 的吞吐量,实现线速转发且无丢包。该结果展示了采用基于 IP 子网 SDF 的工作流设计,能够对 AI 流量的用户面数据包处理实现全面的硬件加速。值得注意的是,这一性能仅通过两个 Grace CPU 核心即可达成。实验室测试中所展现的功能完整性和性能表现,充分验证了 dUPF-UP 在 AI Aerial 平台上的技术价值与应用潜力。

采用 dUPF 生态系统

思科采用由 NVIDIA AI Aerial 平台和 NVIDIA DOCA 框架驱动的 dUPF 架构,作为面向 6G 与 AI 融合网络的核心基础。结合具备 AI 准备能力的数据中心架构,电信运营商能够部署高性能、高能效的 dUPF,同时将安全、内嵌且深度集成的 AI 推理能力延伸至网络边缘,从而为视频流分析(VSS)、代理式 AI、扩展现实(XR)以及低延迟的 AI 驱动服务等应用创造广阔发展空间。

思科移动业务产品负责人达林·考夫曼表示:“通过软件定义的DPU与GPU加速的边缘基础设施,能够高效部署无线RAN、核心网及AI应用,助力服务提供商提升用户体验并开拓新的盈利空间。思科与NVIDIA正携手打造智能化、安全且节能的边缘网络,为下一代无线连接提供强大支持。”

启动 AI 原生网络的构建与部署

dUPF 是以 6G AI 为核心的网络中的关键组件。通过在 NVIDIA AI Aerial 平台上战略性地部署高性能、超低延迟且高能效的 dUPF 加速能力,并在网络边缘集成 AI 推理,运营商能够开启全新服务模式。这不仅可显著降低运营支出,还能确保网络基础设施具备足够的灵活性与可扩展性,以应对 6G 时代 AI 驱动应用的多样化与高增长需求。

如需了解如何开始使用,以及获取有关 DOCA Flow 硬件加速和在 AI Aerial 上部署 dUPF 的优势的详细信息,请联系 telco@nvidia.com。