TensorRT

2025년 10월 10일

NVIDIA Blackwell, SemiAnalysis InferenceMAX™ v1 벤치마크에서 놀라운 기록을 세우다

SemiAnalysis가 최근 발표한 InferenceMAX™ v1은 추론 하드웨어 성능을 평가하기 위한 포괄적인 방법론을 제공하는 새로운 오픈…

7 MIN READ

2025년 9월 19일

AI 추론 지연 시간을 줄이기 위한 Speculative Decoding 소개

거대 언어 모델(LLM)로 텍스트를 생성할 때는 구조적인 한계로 인해 성능을 제대로 끌어내기 어려운 경우가 많습니다. GPU는 뛰어난 연산 성능을…

7 MIN READ

2025년 8월 8일

Ditto in Action: Torch-TensorRT로 손쉽게 LLM 추론 가속하기

Direct Torch to TensorRT-LLM Optimizer, 줄여서 Ditto는 Transformer 모델을 TensorRT 엔진으로…

5 MIN READ

2025년 8월 8일

LLM 추론 벤치마크: TensorRT-LLM을 활용한 성능 튜닝

이 글은 TensorRT-LLM으로 LLM 추론 성능을 벤치마킹하고 최적화하는 방법을 소개하는 시리즈의 세 번째 편입니다.

6 MIN READ

2025년 5월 28일

NVIDIA Blackwell 플랫폼 DeepSeek-R1 추론 성능에서 세계 기록 달성

NVIDIA는 NVIDIA GTC 2025에서 DeepSeek-R1 추론 성능 세계 기록을 발표했습니다.

9 MIN READ

2025년 5월 15일

NVIDIA 풀스택 솔루션을 통한 AI 추론 성능 최적화

2025년 3월 18일부로 NVIDIA Triton Inference Server는 이제 NVIDIA Dynamo로 명칭이 변경되었습니다.

5 MIN READ

2025년 4월 25일

NVIDIA NIM을 사용한 게임용 에이전트 LLM 및 VLM 추론 벤치마킹

런던대학교 유니버시티칼리지(UCL)의 DARK(Dark, Acting, and Reasoning with Knowledge) 연구실은 NVIDIA…

4 MIN READ

2025년 3월 12일

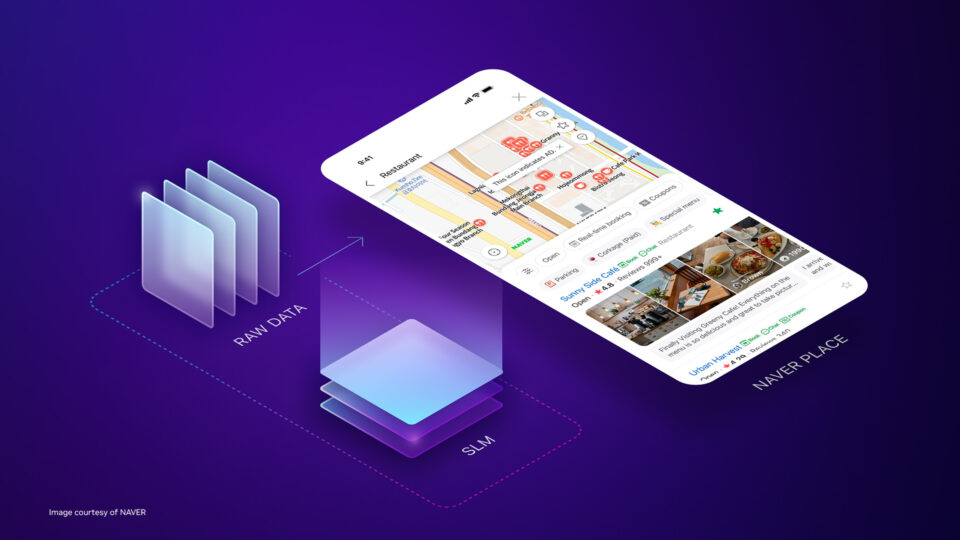

Spotlight: NVIDIA TensorRT-LLM을 활용한 NAVER Place의 SLM Vertical Service 운영 최적화

NAVER Place에서는 Place 영역에 특화된 SLM Vertical Service를 운영하여 플레이스 프로덕트 전반(플레이스, 지도…

7 MIN READ

2024년 12월 13일

NVIDIA TensorRT-LLM, 인플라이트 배치로 인코더-디코더 모델 가속화

NVIDIA는 최근 NVIDIA TensorRT-LLM이 인코더-디코더 모델 아키텍처를 가속화한다고 발표했습니다.

3 MIN READ

2024년 11월 15일

NVSwitch와 TensorRT-LLM 멀티샷으로 3배 빠른 AllReduce 구현

사용자 수가 수백 명에서 수십만 명까지 변동하고 각 요청의 입력 시퀀스 길이가 다른 프로덕션 환경에서 생성형 AI 워크로드를 배포하는 데는 여러…

3 MIN READ

2024년 9월 25일

엣지에서 클라우드로 가속화된 Llama 3.2 배포하기

오픈 소스 Meta Llama 모델 컬렉션을 확장한 Llama 3.2 컬렉션에는 비전 언어 모델(VLM), 소규모 언어 모델(SLM)…

4 MIN READ

2024년 8월 30일

NVLink Switch가 탑재된 NVIDIA HGX H200의 Medusa로 최대 1.9배 향상된 Llama 3.1 성능

거대 언어 모델(LLM)의 크기와 복잡성이 계속 증가함에 따라, 실시간 생성형 AI 애플리케이션이 요구하는 짧은 지연 시간과 높은 처리량을 제공하기…

3 MIN READ

2024년 8월 23일

LLM 추론 크기 조정 및 성능 최적화를 위한 실용적인 전략

챗봇, 콘텐츠 제작 등 다양한 애플리케이션에서 거대 언어 모델(LLM)의 사용이 증가함에 따라 추론 시스템을 확장하고 최적화하는 과정을 이해하여…

1 MIN READ

2024년 6월 24일

Windows RTX PC용 NVIDIA RTX AI 툴킷으로 AI 기반 앱 개발 간소화

NVIDIA는 오늘 Windows 애플리케이션 개발자가 Windows 애플리케이션용 AI 모델을 맞춤화, 최적화 및 배포할 수 있는 도구 및…

5 MIN READ

2024년 5월 31일

Gipi, NVIDIA TensortRT-LLM 및 AI 파운데이션 모델을 사용한 개인 맞춤형 학습

12억 명 이상의 사람들이 적극적으로 새로운 언어를 배우고 있으며, 5억 명 이상의 학습자가 Duolingo와 같은 디지털 학습 플랫폼에서 학습하고…

4 MIN READ

2024년 5월 29일

업그레이드된 NVIDIA TensorRT 10.0의 사용성, 성능, AI 모델 지원

NVIDIA는 오늘 고성능 딥 러닝 추론을 위한 API 에코시스템인 NVIDIA TensorRT의 최신 릴리스를 발표했습니다.

4 MIN READ