Inference Performance

2026년 2월 20일

NVIDIA TensorRT-LLM AutoDeploy를 통한 추론 최적화 자동화

NVIDIA TensorRT-LLM은 개발자가 거대 언어 모델(LLM)을 위한 고성능 추론 엔진을 구축하도록 지원합니다.

6 MIN READ

2026년 2월 3일

NVIDIA TensorRT Edge-LLM을 활용한 오토모티브 및 로보틱스용 LLM/VLM 추론 가속화

거대 언어 모델(LLM)과 멀티모달 추론 시스템이 데이터 센터의 경계를 넘어 빠르게 확장되고 있습니다. 오토모티브 및 로보틱스 개발자들 사이에서는…

4 MIN READ

2025년 12월 12일

AI 모델 추론을 가속화하는 핵심 최적화 기법 5가지

AI 모델이 점점 더 대형화되고 아키텍처가 복잡해지면서, 연구자들과 엔지니어들은 AI 시스템을 실제 환경에 적용하기 위한 성능 최적화 및 비용 절감…

5 MIN READ

2025년 11월 5일

쿠버네티스에서 복잡한 AI 추론을 NVIDIA Grove로 간소화하기

최근 몇 년간 AI 추론은 단일 모델, 단일 파드 형태의 단순한 배포 방식에서 벗어나, 여러 구성 요소로 이뤄진 복잡한 시스템으로 진화하고 있습니다.

6 MIN READ

2025년 10월 10일

NVIDIA Blackwell, SemiAnalysis InferenceMAX™ v1 벤치마크에서 놀라운 기록을 세우다

SemiAnalysis가 최근 발표한 InferenceMAX™ v1은 추론 하드웨어 성능을 평가하기 위한 포괄적인 방법론을 제공하는 새로운 오픈…

7 MIN READ

2025년 9월 25일

NVIDIA Rubin CPX, 100만 토큰 이상 컨텍스트 워크로드의 추론 성능과 효율을 가속하다

AI에서 추론은 이제 가장 복잡한 과제에 당면한 영역이 되었습니다. 최신 모델은 에이전틱 AI로 진화하며, 다단계 추론과 지속적인 메모리…

3 MIN READ

2025년 9월 25일

NVFP4, 16비트 정밀도와 4비트 성능으로 학습 가속

최근 몇 년간 AI 워크로드는 폭발적으로 증가했습니다. 이는 거대 언어 모델(LLM)의 배포는 물론, 사전 학습과 후속 학습 과정에서 점점 더 많은…

6 MIN READ

2025년 9월 24일

Dynamo 0.4, 4배 더 빠른 성능과 SLO 기반 오토스케일링, 실시간 가시성 제공

최근 몇 주간 OpenAI의 gpt-oss와 Moonshot AI의 Kimi K2를 비롯한 새로운 오픈소스 모델들이 등장하면서 거대 언어…

6 MIN READ

2025년 9월 19일

AI 추론 지연 시간을 줄이기 위한 Speculative Decoding 소개

거대 언어 모델(LLM)로 텍스트를 생성할 때는 구조적인 한계로 인해 성능을 제대로 끌어내기 어려운 경우가 많습니다. GPU는 뛰어난 연산 성능을…

7 MIN READ

2025년 9월 10일

NVIDIA RTX PRO 6000 Blackwell Server Edition으로 단백질 구조 추론 100배 이상 가속

단백질 구조를 이해하기 위한 경쟁은 그 어느 때보다 중요해졌습니다. 신약 개발을 앞당기고 미래 팬데믹에 대비하기 위해서는…

4 MIN READ

2025년 8월 8일

Ditto in Action: Torch-TensorRT로 손쉽게 LLM 추론 가속하기

Direct Torch to TensorRT-LLM Optimizer, 줄여서 Ditto는 Transformer 모델을 TensorRT 엔진으로…

5 MIN READ

2025년 8월 8일

LLM 추론 벤치마크: TensorRT-LLM을 활용한 성능 튜닝

이 글은 TensorRT-LLM으로 LLM 추론 성능을 벤치마킹하고 최적화하는 방법을 소개하는 시리즈의 세 번째 편입니다.

6 MIN READ

2025년 8월 6일

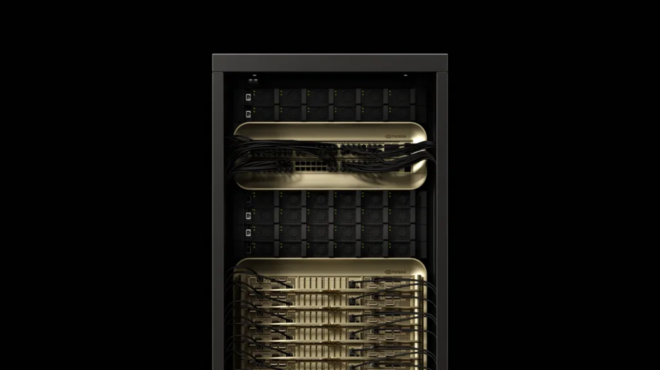

NVIDIA, GB200 NVL72로 OpenAI gpt-oss 모델을 클라우드부터 엣지까지 초당 150만 토큰 속도로 가속

NVIDIA와 OpenAI는 2016년 NVIDIA DGX 출시를 시작으로 AI의 한계를 넓혀왔습니다. 이번에는 OpenAI의 gpt-oss…

4 MIN READ

2025년 7월 25일

NVIDIA Llama Nemotron Super v1.5로 더 정확하고 효율적인 AI 에이전트를 만드세요

NVIDIA Nemotron 제품군은 NVIDIA의 오픈 합성 데이터셋, 고급 기술 및 도구를 활용해 생태계 내에서 가장 강력한 오픈 모델들을…

2 MIN READ

2025년 7월 16일

NCCL 2.27을 활용한 빠른 추론과 안정적인 학습 구현

AI 워크로드가 확장되면서 GPU 간 빠르고 안정적인 통신은 학습뿐 아니라 대규모 추론 환경에서도 필수 요소로 자리잡고 있습니다.

6 MIN READ

2025년 7월 9일

스마트하게 사고하고, 백과사전급 질문을 던지세요: 수백만 토큰 실시간 추론으로 32배 더 많은 사용자 지원

최신 AI 애플리케이션은 수억 개의 토큰을 처리하는 컨텍스트 윈도우와 수십억 개의 파라미터를 결합한 모델에 점점 더 의존하고 있습니다.

6 MIN READ