旧金山加利福尼亚大学的一项新研究让瘫痪的人通过将大脑信号翻译成计算机生成的文字来进行交流。这项研究发表在 新英格兰医学杂志 ,标志着为丧失说话能力的人恢复交流的一个重要里程碑。

“据我们所知,这是第一次成功地从瘫痪不能说话的人的大脑活动中直接解码完整单词的演示,”资深作者、加州大学旧金山分校神经外科主任琼和桑福德·威尔( Joan and Sanford Weill )在一份新闻稿中说它显示出通过利用大脑的自然语言机制来恢复交流的强大前景。”

一些有语音限制的人使用辅助设备——比如触摸屏、键盘或语音生成计算机来进行交流。然而,每年都有成千上万的人因为瘫痪或脑损伤而丧失了语言能力,使他们无法使用辅助技术。

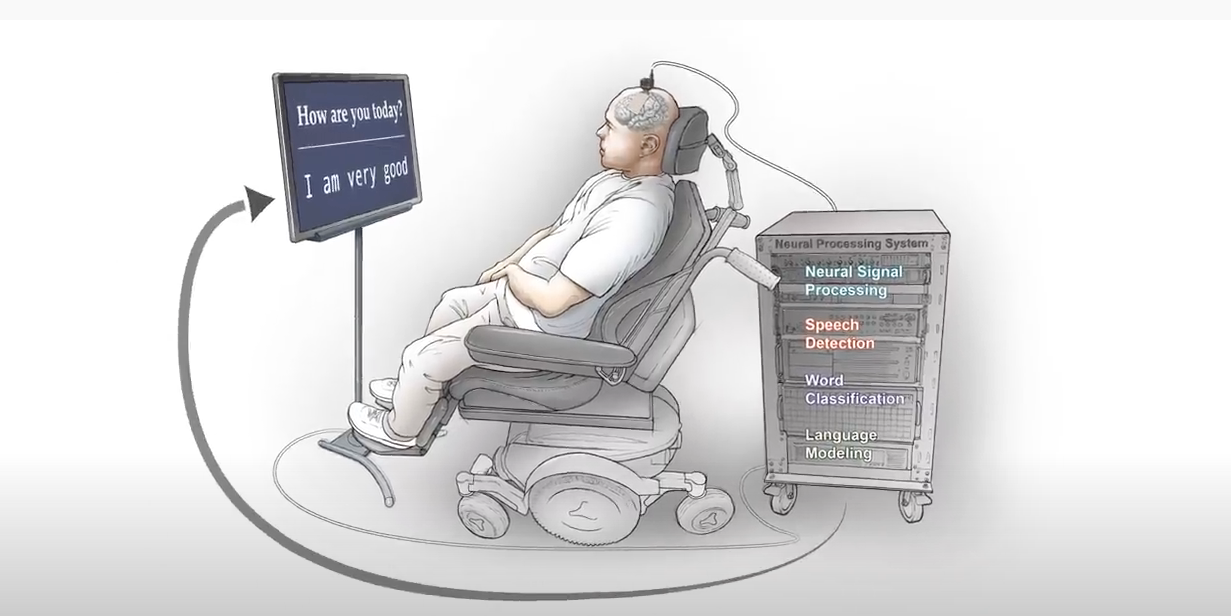

这名参与者在 2003 年失去了说话的能力,在一次车祸后因脑卒中瘫痪。研究人员不确定他的大脑是否保留了与语言有关的神经活动。为了追踪他的大脑信号,一个由 ele CTR 节点组成的神经假体被放置在大脑的左侧,跨越了几个已知的语音处理区域。

在大约四个月的时间里,研究小组进行了 50 次培训,参与者被要求说出单个单词、造句或回答显示屏上的问题。在对提示做出反应的同时, ele CTR ode 设备捕捉到了神经活动,并用定制软件将信息传输到计算机。

“我们的模型需要学习复杂的大脑活动模式和预期语言之间的映射。当参与者不能说话时,这就构成了一个重大的挑战。

为了解码他大脑活动的反应,研究小组建立了语音检测和单词分类模型。使用 cuDNN – 加速 TensorFlow 框架和 32 NVIDIA V100 张量核 GPU 研究人员对模型进行了训练、微调和评估。

“利用神经网络是获得我们所做的分类和检测性能的关键,我们的最终产品是大量实验的结果,”研究共同负责人肖恩·梅茨格( Sean Metzger )说因为我们的数据集是不断发展和增长的,能够适应我们使用的模型是至关重要的。 GPU 帮助我们进行更改、监控进度并了解数据集。”

该模型的准确率高达 93% ,中位数为 75% ,解码速度高达每分钟 18 次。

“我们希望达到 1000 个单词,最终达到所有单词。这只是一个起点。

这项研究建立在 以前的工作 由 Chang 和他的同事开发了一种解码和转换大脑信号的深度学习方法。与目前的研究不同,先前研究的参与者能够说话。