Low-Latency Inference

2026년 1월 23일

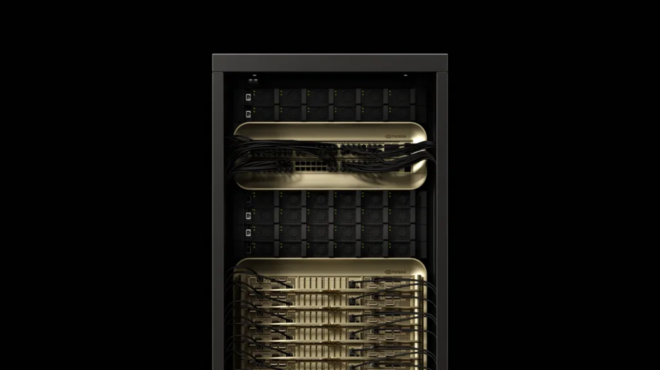

NVIDIA Blackwell 데이터 센터 GPU 기반 FLUX.2를 위한 NVFP4 추론 스케일링

2025년, NVIDIA는 Black Forest Labs(BFL)와 협력하여 FLUX.1 텍스트-이미지 모델 시리즈를 최적화했으며…

5 MIN READ

2025년 9월 19일

AI 추론 지연 시간을 줄이기 위한 Speculative Decoding 소개

거대 언어 모델(LLM)로 텍스트를 생성할 때는 구조적인 한계로 인해 성능을 제대로 끌어내기 어려운 경우가 많습니다. GPU는 뛰어난 연산 성능을…

7 MIN READ

2025년 7월 9일

스마트하게 사고하고, 백과사전급 질문을 던지세요: 수백만 토큰 실시간 추론으로 32배 더 많은 사용자 지원

최신 AI 애플리케이션은 수억 개의 토큰을 처리하는 컨텍스트 윈도우와 수십억 개의 파라미터를 결합한 모델에 점점 더 의존하고 있습니다.

6 MIN READ