教程

2025年 10月 15日

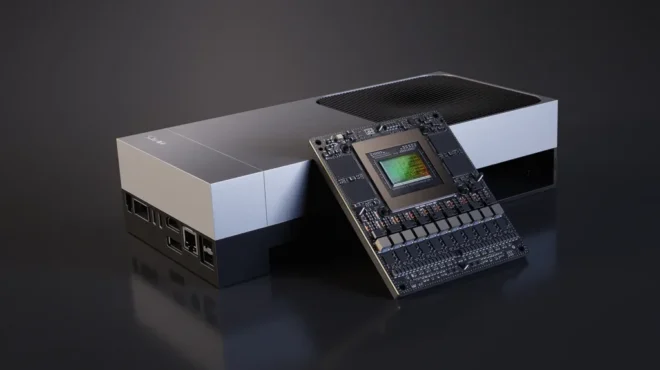

通过 NVIDIA Jetson AGX Thor 实现 7 倍生成式 AI 性能,解锁更快速、更智能的边缘模型

NVIDIA 软件生态系统的一大显著优势在于其持续优化的承诺。今年 8 月,NVIDIA 发布了 Jetson AGX Thor,

2 MIN READ

2025年 10月 14日

借助 NVIDIA Parabricks 提高变体识别准确性

NVIDIA Parabricks 是一款专为数据科学家和生物信息学家设计的可扩展基因组学软件套件,专注于基因数据的二级分析。

3 MIN READ

2025年 10月 10日

使用 NVIDIA Nemotron 构建日志分析多智能体自校正 RAG 系统

日志是现代系统的核心所在。然而,随着应用规模不断扩大,日志往往演变成一片冗长繁杂的文本海洋,充斥着重复与冗余信息,令人不堪重负。

2 MIN READ

2025年 10月 7日

使用 NVIDIA TensorRT Model Optimizer 剪枝和蒸 LLM

大语言模型(LLM)在自然语言处理(NLP)任务,如代码生成、推理和数学计算等方面,展现出卓越的性能,树立了新的标杆。然而,

3 MIN READ

2025年 10月 2日

NVIDIA AI Red 团队的实用 LLM 安全建议

近年来,NVIDIA AI 红队(AIRT)已对多款在投产前的支持 AI 的系统进行了潜在漏洞和安全风险评估。

1 MIN READ

2025年 9月 30日

id Software 在 DOOM:黑暗时代中采用神经渲染和路径追踪技术的揭秘

《毁灭战士:黑暗时代》(DOOM: The Dark Ages)通过集成 RTX 神经渲染与路径追踪技术,

1 MIN READ

2025年 9月 29日

使用 OpenUSD 强化机器人开发的 3 种简单方法

随着对机器人技术需求的持续增长,人们对高精度物理仿真的需求也达到了前所未有的高度。通用场景描述(OpenUSD)正成为推动这一变革的关键力量,

2 MIN READ

2025年 9月 29日

利用 NVIDIA Run:ai 和 NVIDIA Dynamo 进行快速高效 LLM 推理的智能多节点调度

大语言模型的复杂性呈指数级增长,带来了诸多挑战,例如模型规模超出单个 GPU 的承载能力、对高吞吐量与低延迟工作负载的需求,

3 MIN READ

2025年 9月 29日

释放 GPU 性能:CUDA 中的全局内存访问

管理内存是编写 GPU 内核时影响性能的关键因素之一。本文将为您介绍全局内存及其对性能影响的重要知识。 CUDA 设备上存在多种类型的显存,

4 MIN READ

2025年 9月 25日

使用 CUDA-X 数据科学加速 GPU 模型训练的方法

在之前关于 AI 在制造和运营中应用的博文中,我们探讨了供应链所面临的独特数据挑战,并介绍了智能特征工程如何显著提升模型性能。

2 MIN READ

2025年 9月 25日

如何将计算机视觉工作流与生成式 AI 和推理集成

生成式 AI 为分析现有视频流开辟了全新可能。视频分析正从统计物体演进为将原始视频片段转化为实时理解,从而提供更具价值的可行见解。

3 MIN READ

2025年 9月 23日

使用 NVIDIA Nemotron 构建检索增强生成 (RAG) 智能体

与基于 LLM 的传统系统受限于其训练数据不同,检索增强生成 (RAG) 通过整合相关的外部信息来提升文本生成效果。

5 MIN READ

2025年 9月 23日

使用 NVIDIA TAO 6 和 NVIDIA DeepStream 8 构建实时视觉检测工作流

构建可靠的视觉检测流程以实现缺陷检测和质量控制并非易事。制造商和开发者常常面临诸多挑战,例如针对特定领域定制通用视觉 AI 模型、

3 MIN READ

2025年 9月 23日

如何使用 GPU 驱动的 Leiden 在 Python 中加速社区检测

社区检测算法通过识别网络中隐藏的关联实体组,在理解数据方面发挥着重要作用。社交网络分析、推荐系统、GraphRAG、

3 MIN READ

2025年 9月 18日

如何使用 NVIDIA Dynamo 减少 KV 缓存瓶颈

随着 AI 模型变得更大、更复杂,推理,即模型生成响应的过程,正成为一项重大挑战。像 GPT-OSS 和 DeepSeek-R1…

4 MIN READ

2025年 9月 18日

Kaggle 大师级玩家手册:7 种实战验证的表格数据建模技术

在数百场 Kaggle 比赛中,我们不断优化了这套 BLUEPRINT,无论面对的是数百万行数据、缺失值,还是与训练数据截然不同的测试集,

3 MIN READ